WEKA の AI 推論用拡張メモリは、GPU の効率を高め、レイテンシとコストを削減しながら、エンタープライズ ワークロード向けに AI モデルを拡張します。

WEKA は、NVIDIA AI データ プラットフォーム リファレンス デザインとの戦略的統合を発表しました。同社は、エージェント AI と複雑な推論モデル向けに特別にカスタマイズされた最適化されたインフラストラクチャを提供する重要な NVIDIA ストレージ認定を取得しました。この発表と並行して、WEKA は革新的な拡張メモリ グリッド機能と、エンタープライズ規模の AI ファクトリー展開向けの NVIDIA GB200 NVL72 および NVIDIA 認定システム ストレージを含む追加の NVIDIA クラウド パートナー (NCP) リファレンス アーキテクチャ認定を導入しました。

AIエージェントの加速

NVIDIA AI データ プラットフォームは、NVIDIA Blackwell アーキテクチャ、NVIDIA BlueField DPU、Spectrum-X ネットワーキング、NVIDIA AI Enterprise ソフトウェアをシームレスに統合し、エンタープライズ AI インフラストラクチャの大きな飛躍を表しています。この高度な NVIDIA インフラストラクチャを WEKA データ プラットフォームと組み合わせることで、企業は高性能 AI 推論ワークロード専用に設計された、非常にスケーラブルなストレージ基盤を導入できます。

この統合ソリューションは、エンタープライズ AI の高まる需要に直接対応し、AI クエリ エージェントに重要なビジネス インテリジェンスへのシームレスで高速なアクセスを提供し、推論パフォーマンスと推論精度を大幅に向上させます。WEKA のデータ プラットフォームにより、AI システムはデータを実用的なインテリジェンスに迅速に変換できるため、次世代の AI モデルに必要な高度な推論をサポートできます。

WEKA 拡張メモリグリッド

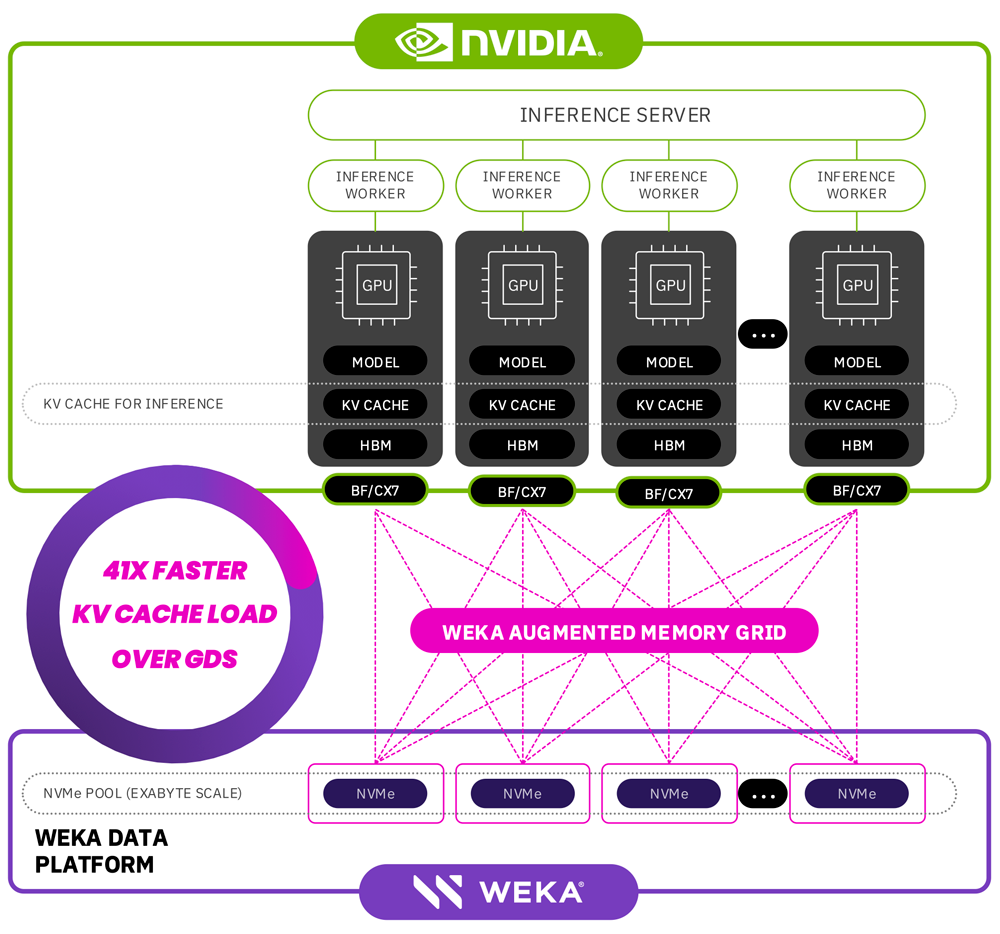

エージェント AI モデルは継続的に進化しており、より大きなコンテキスト ウィンドウ、膨大なパラメータ数、より重要なメモリ要件を管理できます。これらの進歩により、従来の GPU メモリ容量の限界が押し上げられ、AI 推論のボトルネックが生じることがよくあります。WEKA は、画期的な Augmented Memory Grid ソリューションでこれらの課題に対処します。このソリューションは、AI ワークロードに使用可能なメモリを拡張するイノベーションであり、現在の 1 テラバイトの制限をはるかに超えるペタバイト規模の増分を提供します。

WEKA の拡張メモリ グリッドは、WEKA のデータ プラットフォーム ソフトウェアと NVIDIA の高速コンピューティングおよびネットワーク テクノロジを組み合わせることで、AI 推論を大幅に強化します。この組み合わせにより、マイクロ秒単位のレイテンシでメモリに近い速度のアクセスが可能になり、トークン処理のパフォーマンスと全体的な AI 推論の効率が大幅に向上します。

WEKA の拡張メモリ グリッドの主な利点は次のとおりです。

-

レイテンシーを大幅に削減: 105,000 トークンを対象としたテストでは、WEKA の Augmented Memory Grid により、従来の再計算方法と比較して、最初のトークンまでの時間が 41 倍という驚異的な改善を達成しました。

-

最適化されたトークンスループット: WEKA のソリューションは、クラスター全体の推論ワークロードを効率的に処理し、全体的なコストを削減しながらトークンのスループットを高め、処理されるトークンあたりのコストをシステム全体で最大 24% 削減します。

こうしたパフォーマンスの向上は経済効率の向上に直接つながり、企業はモデル機能やインフラストラクチャのパフォーマンスを損なうことなく AI 主導のイノベーションを加速できるようになります。

WEKApod ナイトロ

WEKApod Nitro Data Platform アプライアンスは複数の NVIDIA 認定を取得しており、WEKA はエンタープライズ AI 向けの主要な高性能ストレージ プロバイダーとしての地位を確立しています。

-

NVIDIA クラウド パートナー (NCP) 認定: WEKApod Nitro は、HGX H200、B200、GB200 NVL72 を含む NVIDIA の NCP リファレンス アーキテクチャに認定された最初のストレージ ソリューションの 1,152 つです。これらのアプライアンスは、優れたパフォーマンス密度と電力効率を維持しながら、8U 構成で最大 XNUMX 個の GPU を備えた大規模な GPU クラスターをサポートすることで、サービス プロバイダーと開発者を支援します。

-

NVIDIA 認定システム ストレージ指定: WEKApod Nitro アプライアンスは、NVIDIA の新しいエンタープライズ ストレージ認定を取得しており、NVIDIA エンタープライズ リファレンス アーキテクチャおよびベスト プラクティスとの互換性が保証されています。この認定は、WEKA のデータ プラットフォームが、要求の厳しいエンタープライズ AI および HPC 展開に最適なストレージ パフォーマンス、効率、およびスケーラビリティを提供することを検証するものです。

WEKA の最高製品責任者である Nilesh Patel 氏は、NVIDIA とのこのパートナーシップがもたらす変革の可能性を強調しました。この開発を航空宇宙分野の躍進と比較し、Patel 氏は次のように述べています。「音速の壁を破ることで新たな境地が開かれたのと同じように、WEKA の拡張メモリ グリッドは AI メモリの壁を打ち破り、GPU メモリを劇的に拡張してトークンの効率を最適化します。このイノベーションは AI トークンの経済性を根本的に変革し、パフォーマンスを犠牲にすることなく、イノベーションの迅速化とコスト削減を実現します。」

NVIDIA のストレージ ネットワーキング テクノロジー担当副社長である Rob Davis 氏は、この統合の重要性についてさらに次のように強調しています。「エージェント AI と推論モデルを導入する企業には、これまでにない効率性と拡張性が求められます。NVIDIA と WEKA のテクノロジーを組み合わせることで、AI エージェントは推論中に比類のない速度と精度でデータにアクセスし、処理できるようになります。」

利用状況

- WEKA の NVIDIA Blackwell システム向け NCP リファレンス アーキテクチャは 3 月に利用可能になる予定です。

- WEKA Augmented Memory Grid 機能は、2025 年春に WEKA Data Platform のお客様に一般提供される予定です。

StorageReview と連携する

ニュースレター | YouTube |ポッドキャスト iTunes/Spotifyは | Instagram | Twitter | TikTok | RSSフィード