HPE actualiza su infraestructura de IA con servidores ProLiant, IA en nube privada, SDK Alletra y compatibilidad con OpsRamp para GPU RTX PRO 6000 Blackwell.

HPE ha implementado una serie de actualizaciones en su portafolio NVIDIA AI Computing by HPE. Estas mejoras están diseñadas para brindar un mejor soporte a todo el ciclo de vida del desarrollo de IA, desde la ingesta y el entrenamiento de datos hasta la inferencia en tiempo real y la gestión operativa. HPE se centra en el ciclo de vida completo de la IA dentro de la infraestructura empresarial. Sus últimas actualizaciones reflejan un énfasis en la flexibilidad, la escalabilidad y la preparación para desarrolladores, comenzando con las nuevas capacidades de HPE Private Cloud AI.

Las nuevas capacidades de inteligencia artificial en la nube privada de HPE buscan reducir la fricción entre desarrolladores

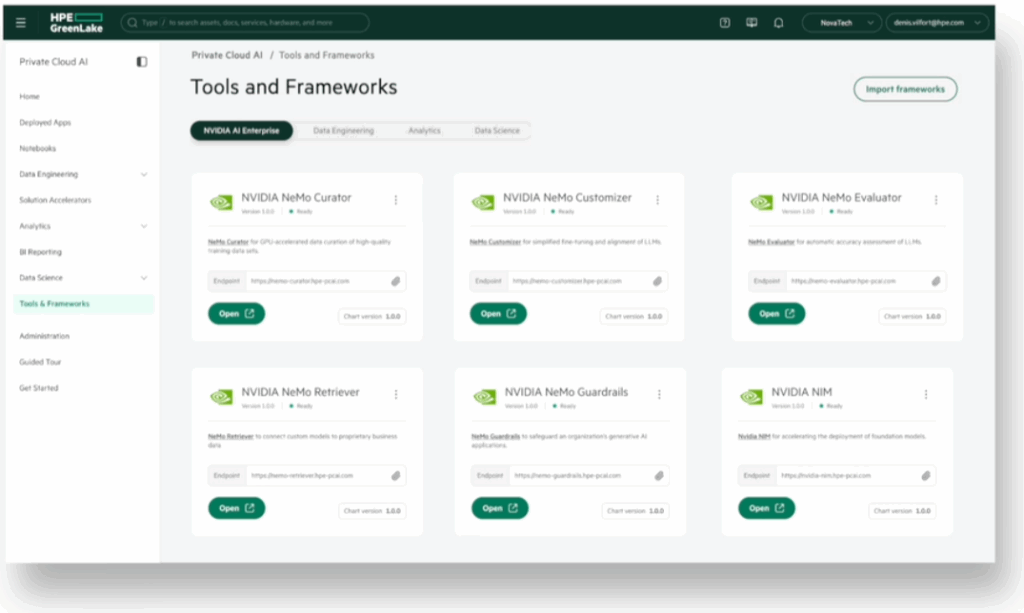

HPE Private Cloud AI, una solución integral desarrollada en colaboración con NVIDIA, recibe una actualización importante. La plataforma permite a las organizaciones ejecutar cargas de trabajo de IA generativa (GenAI) y agentes localmente o en entornos híbridos, y ahora es compatible con las actualizaciones del modelo de rama de funciones de NVIDIA AI Enterprise.

Esto significa que los desarrolladores pueden probar nuevos frameworks de IA, microservicios y SDK sin afectar la estabilidad de los modelos de producción, un enfoque similar al que se utiliza habitualmente en el desarrollo de software moderno. Ofrece un entorno más seguro para la experimentación, manteniendo la robustez necesaria para la IA a escala empresarial.

HPE Private Cloud AI también será compatible con el diseño validado de NVIDIA Enterprise AI Factory. Esta alineación ofrece a las organizaciones una ruta más clara para desarrollar soluciones de IA utilizando los diseños de referencia probados de NVIDIA, lo que facilita una escalabilidad fiable y consistente.

El nuevo SDK para Alletra Storage optimiza los flujos de trabajo de datos para Agentic AI

HPE también está lanzando un nuevo kit de desarrollo de software (SDK) para su sistema Alletra Storage MP X10000, diseñado para funcionar con la plataforma de datos de IA de NVIDIA. Este SDK facilita a las organizaciones la conexión de su infraestructura de datos a las herramientas de IA de NVIDIA.

El objetivo principal es ayudar a gestionar datos no estructurados (p. ej., documentos, imágenes o vídeos) que a menudo requieren limpieza y organización antes de su uso en proyectos de IA. El SDK permite tareas como etiquetar datos con información útil, organizarlos para búsquedas más rápidas y prepararlos para el entrenamiento e inferencia de modelos de IA.

También utiliza tecnología RDMA (Acceso directo a memoria remota) para acelerar las transferencias de datos entre el almacenamiento y las GPU, lo que ayuda a mejorar el rendimiento al manejar grandes cargas de trabajo de IA.

Además, el diseño modular del Alletra X10000 permite a las organizaciones escalar el almacenamiento y el rendimiento por separado, lo que les permite ajustar su configuración según las necesidades específicas del proyecto. Al combinar estas herramientas, HPE y NVIDIA buscan brindar a las organizaciones formas más eficientes de acceder y procesar datos, desde sistemas locales hasta entornos en la nube.

Los servidores HPE ocupan los primeros puestos en las pruebas de IA

El servidor ProLiant Compute DL380a Gen12 de HPE obtuvo recientemente las mejores clasificaciones en 10 pruebas de referencia MLPerf Inference: Datacenter v5.0. Estas pruebas evaluaron el rendimiento en diversos modelos de IA exigentes, como GPT-J para tareas de lenguaje, Llama2-70B para IA generativa a gran escala, ResNet50 para clasificación de imágenes y RetinaNet para detección de objetos. El excelente rendimiento en las pruebas de referencia refleja la configuración actual del servidor, que incluye GPU NVIDIA H100 NVL, H200 NVL y L40S de alto rendimiento.

HPE ProLiant Compute DL380a Gen12

Aprovechando ese impulso, HPE planea expandir las capacidades del servidor al ofrecer configuraciones con hasta 10 GPU NVIDIA RTX PRO 6000 Blackwell Server Edition, a partir del 4 de junio. Se espera que esta incorporación mejore aún más la idoneidad del servidor para aplicaciones de IA empresarial como inferencia multimodal, IA basada en simulación (a menudo llamada IA física), ajuste fino de modelos y flujos de trabajo avanzados de diseño o medios.

El DL380a Gen12 ofrece dos opciones de refrigeración para gestionar cargas de trabajo de alta demanda: refrigeración por aire tradicional y refrigeración líquida directa (DLC). La configuración DLC aprovecha la amplia experiencia de HPE en gestión térmica para mantener la estabilidad y el rendimiento del sistema durante operaciones sostenidas de alto consumo de recursos.

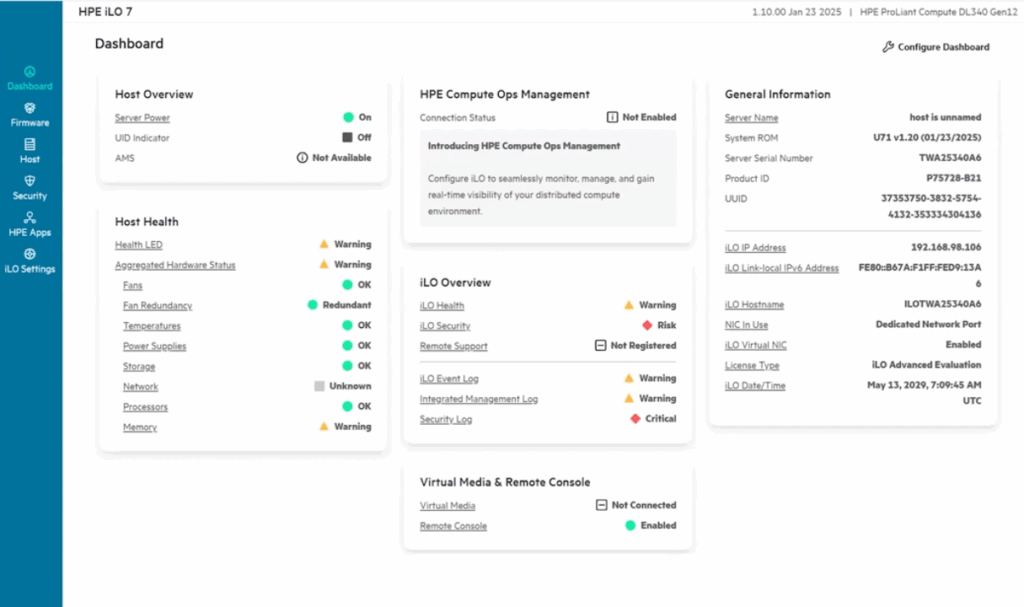

El servidor incluye el motor de gestión Integrated Lights Out (iLO) 7 de HPE, que incorpora protecciones de seguridad a nivel de hardware mediante la raíz de confianza de silicio. Es una de las primeras plataformas de servidor diseñadas con capacidad criptográfica poscuántica y cumple con el estándar FIPS 140-3 Nivel 3, una certificación avanzada de seguridad criptográfica.

En el ámbito de la gestión, HPE Compute Ops Management ofrece herramientas automatizadas del ciclo de vida que rastrean el estado del sistema, detectan posibles problemas de forma temprana y brindan información sobre el uso de energía a través de análisis impulsados por IA.

Además del DL380a, HPE también demostró la solidez de su línea de servidores. El ProLiant Compute DL384 Gen12, equipado con GPU NVIDIA GH200 NVL2 de doble socket, obtuvo el primer puesto en cuatro pruebas MLPerf v5.0, incluyendo modelos a gran escala como Llama2-70B y Mixtral-8x7B. Por su parte, el HPE Cray XD670, con 8 GPU NVIDIA H200 SXM, lideró 30 escenarios de referencia, abarcando grandes modelos de lenguaje y tareas de IA basadas en visión. Los sistemas HPE obtuvieron el primer puesto en más de 50 categorías de prueba, ofreciendo validación externa de las capacidades de su infraestructura de IA.

OpsRamp se expande para cubrir una nueva clase de GPU para la observabilidad de la infraestructura

En el ámbito operativo, HPE amplía el soporte de su software OpsRamp para gestionar entornos que utilizan las próximas GPU NVIDIA RTX PRO 6000 Blackwell. Esta expansión permite a los equipos de TI mantener la visibilidad de su infraestructura de IA, desde el uso de la GPU y las cargas térmicas hasta el uso de memoria y el consumo de energía.

El software aporta observabilidad integral a entornos de IA híbridos y permite a los equipos automatizar proactivamente las respuestas, optimizar la programación de tareas y gestionar la asignación de recursos según las tendencias históricas. Con la creciente inversión empresarial en IA, estas herramientas de observabilidad y optimización cobran importancia para ejecutar implementaciones de IA fiables y rentables.

Disponibilidad

Soporte de rama de funciones para NVIDIA AI Enterprise en HPE Private Cloud AI Se espera para el verano. SDK de HPE Alletra Storage MP X10000, incluido el soporte para el acceso directo a la memoria de la infraestructura acelerada por NVIDIA, también está previsto que esté disponible en el verano de 2025. Servidor HPE ProLiant Compute DL380a Gen12, configurado con GPU NVIDIA RTX PRO 6000 Blackwell Server Edition, estará disponible para pedidos a partir del 4 de junio de 2025. Software OpsRamp de HPE Estará disponible junto con el lanzamiento de RTX PRO 6000 para respaldar su gestión y optimización.

Con estas actualizaciones, ciertamente parece que HPE está tomando medidas para fortalecer aún más su cartera de infraestructura de IA, enfocándose en crear entornos escalables y manejables que puedan soportar la gama completa de cargas de trabajo de IA sin complicar demasiado las operaciones.

Interactuar con StorageReview

Boletín | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed