Como parte de los continuos avances de StorageReview tanto en el protocolo de prueba como en el desarrollo de laboratorio empresarial, estamos revisando las unidades flash de primera generación que hemos revisado anteriormente. Estas nuevas revisiones de los primeros dispositivos de almacenamiento flash PCIe nos dieron la oportunidad de refinar y recalibrar nuestro proceso de revisión empresarial antes de implementar nuevas revisiones de aceleradores de aplicaciones y tarjetas de almacenamiento PCIe de segunda generación. Hemos estado revisando nuestra metodología de prueba revisada durante los últimos meses con tarjetas de primera y segunda generación suministradas por líderes de la industria a medida que perfeccionamos los protocolos de prueba que son más relevantes para el comprador de almacenamiento empresarial. En esta revisión, estamos trabajando nuevamente con Fusion ioDrive Duo de 640 GB, esta vez usando pruebas más sofisticadas en Windows y Linux.

La forma en que el equipo de StorageReview evalúa el almacenamiento empresarial continúa evolucionando, gracias a los aportes continuos de los líderes de la industria y socios clave. Este enfoque colaborativo hace que los resultados de revisión como este sean aún más detallados y relevantes para la industria en general. Trabajar en estrecha colaboración con los fabricantes nos permite incorporar nuevas ideas de prueba a nuestras revisiones de forma continua y cubrir elementos que de otro modo podrían pasarse por alto. A continuación, los lectores encontrarán más de 70 gráficos dedicados a analizar el ioDrive Duo casi hasta el punto de la minucia; y esto ni siquiera incluye la nueva serie de puntos de referencia a nivel de aplicación que están en desarrollo. Si bien el detalle puede parecer abrumador para algunos, para otros que necesitan un equipo específico para resolver un problema de almacenamiento, estos detalles son fundamentales. La revisión completa se publica a continuación en una sola página, como siempre, para comodidad del lector.

Antes de sumergirse en el rendimiento de ioDrive, es importante resaltar algunas de las diferencias clave entre el almacenamiento flash de Fusion-io y un SSD típico. Flash en SSD (como implica correctamente el nombre de unidad de estado sólido) está oculto detrás de una interfaz SATA o SAS, ofuscando la NAND por razones de compatibilidad. Con el producto ioDrive, los usuarios básicamente obtienen acceso a un nivel de almacenamiento de memoria flash, que ofrece una latencia mucho más baja y un mejor rendimiento general que un SSD. Las razones de esto se reducen a la arquitectura y la forma en que ioDrive interactúa con el sistema host.

Donde un SSD PCIe empresarial a menudo tiene múltiples controladores de dispositivos de bloque y un chip adicional para RAID junto con múltiples dispositivos en una sola tarjeta, Fusion-io adopta un enfoque diferente de la vida. Fusion ioMemory interactúa con NAND Flash como un procesador interactuaría con la memoria del sistema, esto se hace usando una combinación del controlador NAND de Fusion-io (FPGA), que se comunica directamente a través de PCIe, y el controlador de Fusion-io o el software de capa de almacenamiento virtual instalado en el sistema host para traducir el dispositivo en un dispositivo de bloque tradicional. A través de la capa de almacenamiento virtual o VSL de Fusion-io, el software emula un dispositivo de bloque para compatibilidad, aunque recientemente Fusion-io ha lanzado un SDK que permite acceso nativo (sin pasar por la capa de bloqueo del kernel) dentro de algunas aplicaciones.

IoMemory tampoco es tradicional en el sentido de que consume recursos del sistema para que funcionen los controladores VSL, aprovechando la CPU del host y al mismo tiempo creando una huella en la memoria del sistema. Según Fusion-io, esta arquitectura se parece más a la arquitectura de RAM, de ahí el nombre ioMemory. Los beneficios incluyen búsquedas de ubicación de archivos más rápidas y, aunque ioMemory llega a la CPU, su uso es muy eficiente y, de hecho, impulsa el rendimiento al reducir la latencia transaccional. En términos de administración, otro beneficio central de la arquitectura es que, dado que Fusion-io usa un FPGA como controlador NAND, permite actualizaciones de software/firmware de muy bajo nivel que pueden corregir errores y mejorar el rendimiento. Esto contrasta con los controladores SSD estándar, donde los cambios fundamentales solo se pueden realizar mediante la fabricación de un nuevo controlador.

Fusion-io ioDrive Duo Especificaciones

- Celda de un solo nivel (SLC)

- 320 GB ioDrive Duo SLC

- Ancho de banda de lectura de 1.5 GB/s (64 kB)

- Ancho de banda de escritura de 1.5 GB/s (64 kB)

- 261,000 IOPS de lectura (512 bytes)

- 262,000 IOPS de escritura (512 bytes)

- Latencia de acceso 0.026 ms (512 bytes)

- 640 GB ioDrive Duo SLC

- Ancho de banda de lectura de 1.5 GB/s (64 kB)

- Ancho de banda de escritura de 1.5 GB/s (64 kB)

- 252,000 IOPS de lectura (512 bytes)

- 236,000 IOPS de escritura (512 bytes)

- Latencia de acceso 0.026 ms (512 bytes)

- 320 GB ioDrive Duo SLC

- Celda multinivel (MLC)

- MLC ioDrive Duo de 640 GB

- Ancho de banda de lectura de 1.5 GB/s (64 kB)

- Ancho de banda de escritura de 1.0 GB/s (64 kB)

- 196,000 IOPS de lectura (512 bytes)

- 285,000 IOPS de escritura (512 bytes)

- Latencia de acceso 0.029 ms (512 bytes)

- MLC ioDrive Duo de 1.28 TB

- Ancho de banda de lectura de 1.5 GB/s (64 kB)

- Ancho de banda de escritura de 1.1 GB/s (64 kB)

- 185,000 IOPS de lectura (512 bytes)

- 278,000 IOPS de escritura (512 bytes)

- Latencia de acceso 0.03 ms (512 bytes)

- MLC ioDrive Duo de 640 GB

- PCI Express 2.0x8

- Compatibilidad con SO

- Microsoft: Windows de 64 bits Microsoft XP/Vista/Win7/Server 2003/2008/2008 R2

- Linux: RHEL 5/6; LES 10/11; OEL 5/6; CentOS 5/6; Apretón de Debian; Fedora 15/16; openSUSE 12; Ubuntu 10/11

- UNIX: Solaris 10 U8/U9/U10 x64; OpenSolaris 2009.06x64; OSX 10.6/10.7, HP-UX* 11i

- Hipervisores: VMware ESX 4.0/4.1/ESXi 4.1/5.0, Windows 2008 R2 con Hyper-V, Hyper-V Server 2008 R2

- Temperatura de funcionamiento: 0-55 ° C

- Garantía de cinco años o resistencia máxima utilizada

- Versión de VSL revisada: 3.1.1

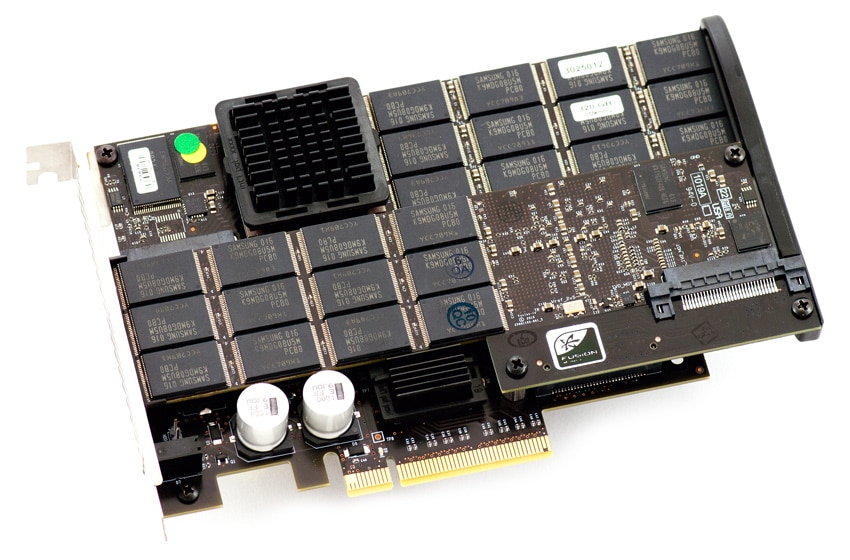

Diseño y construcción

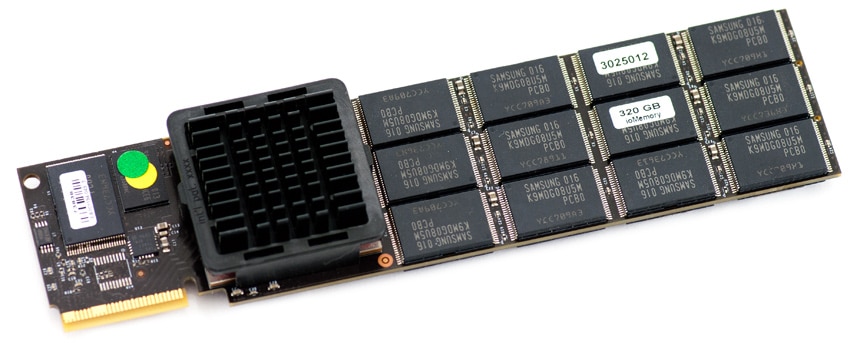

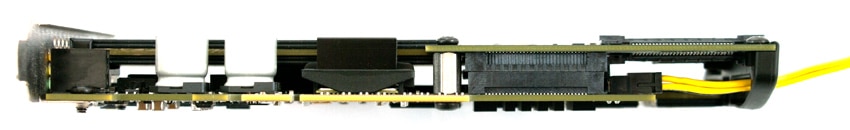

Fusion ioDrive Duo es una tarjeta PCI-Express x8 de altura completa y media longitud, con dos ioDimm individuales conectados a la placa de interfaz principal. Si bien la tarjeta PCI-Express es mecánicamente un dispositivo x8, en las plataformas Gen1 utiliza 8 carriles para el ancho de banda, mientras que en los sistemas PCIe Gen2 solo necesita 4 carriles. Cada tarjeta representa un dispositivo ioMemory único de 320 GB, que utiliza 4 carriles de la conexión PCIe. El diseño es muy compacto y limpio, e incluye un soporte resistente en la parte posterior de la tarjeta. Esto ayuda a fortalecer la tarjeta para que siga funcionando en condiciones de funcionamiento adversas y le da una apariencia agradable.

El corazón (o corazones) del ioDrive Duo basado en MLC son los dos ioDimms. Cada ioDimm idéntico representa un ioDrive, con su propio Xilinx Virtex-5 FPGA y un grupo de 400 GB de MLC NAND. El ioDrive Duo que revisamos usaba Samsung NAND, pero Fusion-io es independiente del fabricante. La NAND se divide en 25 chips de 16 GB de doble pila por dispositivo, con 320 GB utilizables con el formato original. Esa proporción sitúa los niveles de sobreaprovisionamiento de existencias en un 20 %, aproximadamente a la par con la mayoría de los dispositivos flash empresariales. Fusion-io también ofrece la capacidad de modificar los niveles de sobreaprovisionamiento para permitir la personalización y un mayor rendimiento al cambiar la capacidad del usuario por actividades en segundo plano.

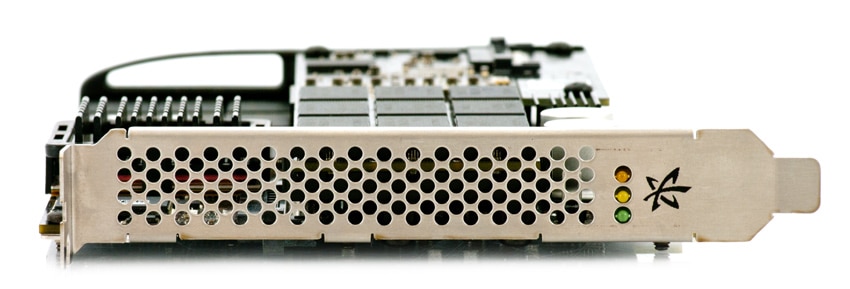

Desde el punto de vista de la funcionalidad, todos los ioDrive incluyen indicadores LED que muestran el estado de la unidad desde que se enciende hasta que se apaga. Dependiendo de los LED que estén activos, mostrará los siguientes modos de la tarjeta:

- Apagado

- Encendido (controlador no cargado, dispositivo no conectado)

- Encendido (controlador cargado, dispositivo no conectado)

- Actividad de escritura activa

- Actividad de lectura activa

- Baliza de ubicación

Para un enfoque más tradicional, el ioDrive Duo también incluye una conexión LED de actividad HDD estándar. Esta conexión permite una conexión a la luz de actividad HDD de montaje frontal de una carcasa de computadora al ioDrive Duo.

El ioDrive Duo se enfría pasivamente e incorpora tres disipadores de calor; diseñado para funcionar en un entorno de servidor de refrigeración forzada. Estos disipadores de calor enfrían un FPGA Xilinx Virtex-5 en cada ioDimm, así como un conmutador PCIe que conecta ambos dispositivos con la única ranura PCIe. Fusion-io enumera un flujo de aire recomendado de 300LFM, con una temperatura ambiente inferior a 55C. Para evitar daños, el ioDrive está diseñado para acelerar el rendimiento si alcanza una temperatura interna de 78 °C y se apaga a los 85 °C. Cabe señalar que estas tarjetas no están diseñadas para un entorno de estación de trabajo, ya que las estaciones de trabajo generalmente no ofrecen soporte de enfriamiento para complementos PCIe en configuraciones estándar. Para abordar esos mercados, Fusion-io anunció recientemente el ioFX, que es básicamente un solo ioDimm con refrigeración activa.

Otra diferencia entre los dispositivos Fusion "Duo" ioMemory y muchas de las soluciones PCIe de la competencia es que requieren más energía de la que generalmente admite una conexión x8 PCIe 2.0 para mantener un rendimiento completo. La especificación eléctrica PCIe 2.0 permite extraer 25 W de una conexión x8, que en condiciones de escritura intensas, los modelos de doble ioDimm como el ioDrive Duo pueden superar. Si bien se ajustarán a las especificaciones sin suministrar energía adicional, el rendimiento total de escritura será limitado. Para solucionar este problema, Fusion-io ofrece dos soluciones; uno requiere un adaptador de corriente externo, el otro permite que la tarjeta consuma más de 25 vatios en los sistemas que lo admiten. Para decidir qué opción tiene más sentido para una instalación, Fusion-io tiene una guía de configuración de servidor para la mayoría de los servidores de primer nivel que brinda instrucciones de configuración en el mejor de los casos.

Para proteger los datos del usuario, Fusion-io ofrece dos funciones clave. En primer lugar, los productos Fusion-io incluyen funciones de corte de energía que garantizan la integridad de los datos durante cortes de energía inesperados. Para fallas menos comunes, como fallas en la matriz NAND, una ventaja de la arquitectura NAND en los dispositivos Fusion-io de primera generación es su redundancia Flashback, lo que permite una sola falla NAND sin desactivar todo el dispositivo. Los modelos de segunda generación ofrecen Adaptive Flashback, que admite múltiples fallas de NAND.

Software

Fusion-io lidera el camino cuando se trata de ofrecer una amplia cartera de software intuitivo bien pulido, que pocos proveedores de almacenamiento se acercan a igualar, si es que ofrecen algún software. Listo para usar, Fusion-io ofrece utilidades para administrar completamente los dispositivos ioMemory en todos los principales sistemas operativos a través de GUI y aplicaciones de consola. Las funciones de administración abarcan todo, desde formas de administrar fácilmente el sobreaprovisionamiento para obtener rendimiento al intercambiar la capacidad del usuario, monitorear las estadísticas de la unidad e incluso transmitir datos en vivo sobre lo que está haciendo la tarjeta segundo por segundo. Ningún otro fabricante de almacenamiento PCIe se acerca a ofrecer este nivel de soporte de administración de unidades, y mucho menos con este nivel de facilidad de uso intuitivo.

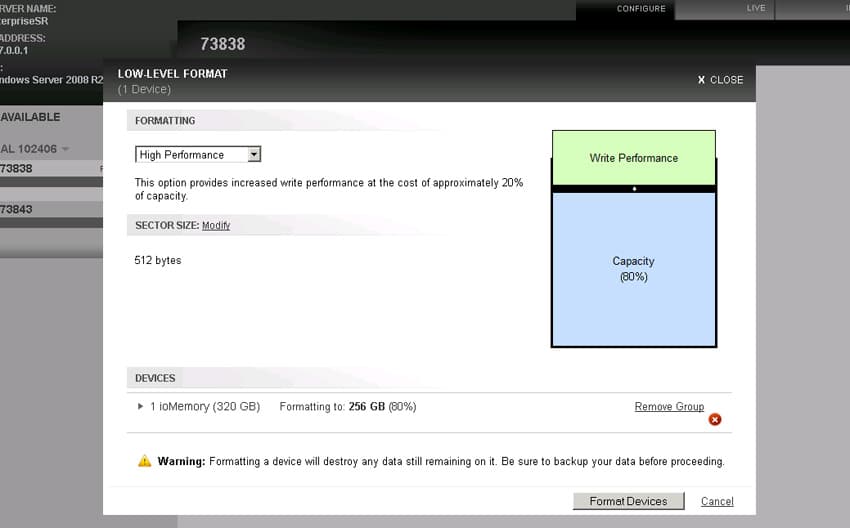

Formato de bajo nivel de ioSphere (sobreaprovisionamiento en modo de alto rendimiento)

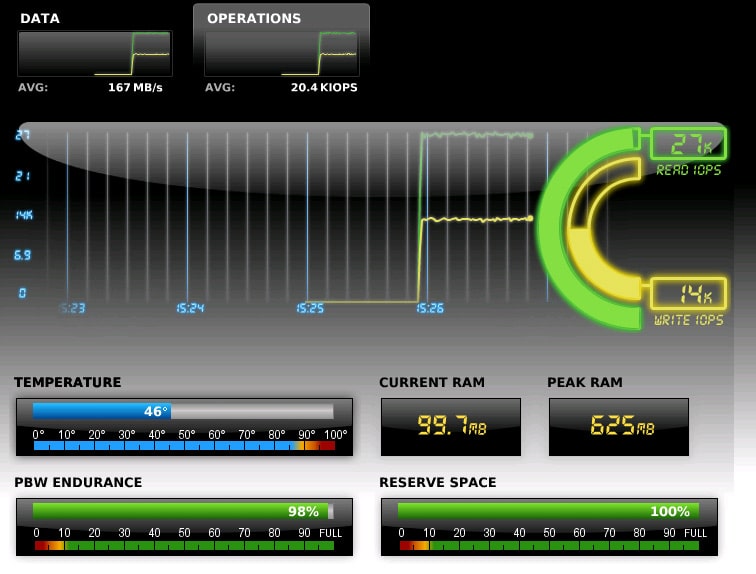

Una de las capacidades más interesantes del software ioSphere es la posibilidad de ver el tipo de actividad que afecta al dispositivo ioMemory. Esta información abarca desde el ancho de banda y la actividad de E/S hasta la temperatura actual del dispositivo, la resistencia restante del dispositivo o incluso los recursos del sistema utilizados por los controladores VSL.

Transmisión de rendimiento en vivo de ioSphere

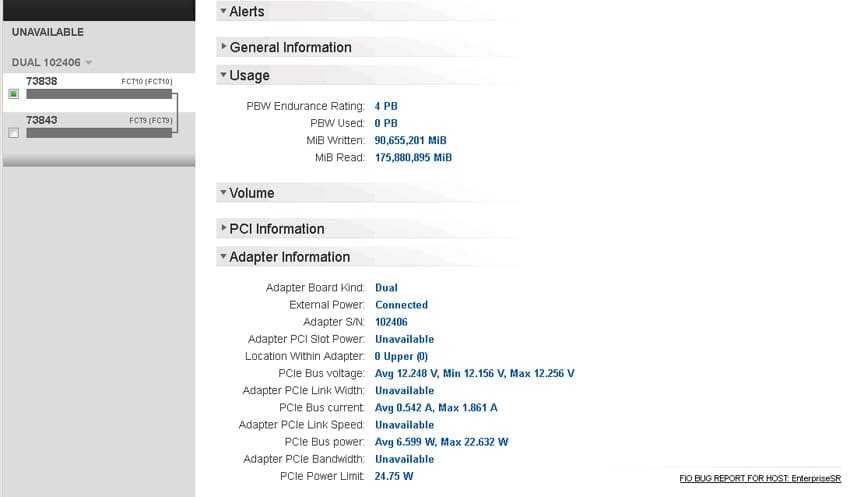

Para ver información más detallada, también hay una página que ofrece la impresión completa de las especificaciones del dispositivo ioMemory seleccionado actualmente. Esto puede ser cualquier cosa, desde la cantidad total de información transmitida hacia o desde el dispositivo hasta cuál es el consumo de energía actual a través del bus PCIe.

Información de uso de por vida de ioShpere

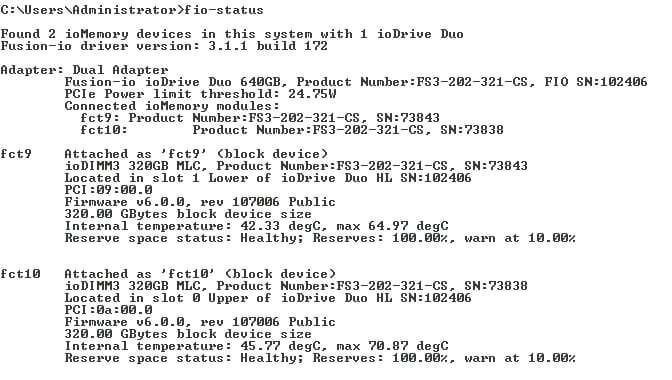

No importa si prefiere una GUI o una interfaz de consola para obtener su información o configurar su ioDrive Duo, Fusion-io también ofrece una línea completa de utilidades basadas en consola para manejar todo, desde sondear el estado de la unidad hasta formatear la unidad. Todas estas utilidades están configuradas para funcionar en múltiples sistemas operativos, por lo que no importa qué plataforma esté en uso; no necesita cargar un sistema operativo de repuesto para administrar un producto Fusion-io.

Estado de la línea de comandos de Fusion-io (básico)

Antecedentes de prueba y comparables

Cuando se trata de probar hardware empresarial, el entorno es tan importante como los procesos de prueba utilizados para evaluarlo. En StorageReview, ofrecemos el mismo hardware e infraestructura que se encuentran en muchos centros de datos a los que, en última instancia, estarían destinados los dispositivos que probamos. Esto incluye servidores empresariales, así como equipos de infraestructura adecuados, como redes, espacio en rack, acondicionamiento/supervisión de energía y hardware comparable de la misma clase para evaluar correctamente el rendimiento de un dispositivo. Ninguna de nuestras revisiones está pagada o controlada por el fabricante del equipo que estamos probando; con comparables relevantes seleccionados a nuestra discreción de los productos que tenemos en nuestro laboratorio.

Plataforma de prueba empresarial StorageReview:

Lenovo Think Server RD240

- 2 x Intel Xeon X5650 (2.66 GHz, caché de 12 MB)

- Windows Server 2008 Standard Edition R2 SP1 de 64 bits y CentOS 6.2 de 64 bits

- Conjunto de chips Intel 5500+ ICH10R

- Memoria: 8 GB (2 x 4 GB) 1333 Mhz DDR3 RDIMM registrados

Fusion-io ioDrive Duo de 640 GB

- Lanzamiento: 1S2009

- Tipo NAND: MLC

- Controlador: 2 x propietario

- Visibilidad del dispositivo: JBOD, software RAID según el sistema operativo

- Fusion-io VSL Windows: 3.1.1

- Fusion-io VSL Linux 3.1.1

300GB LSI WarpDrive SLP-300

- Lanzamiento: 1S2010

- Tipo NAND: SLC

- Controlador: 6 x LSI SandForce SF-1500 a través de LSI SAS2008 PCIe a SAS Bridge

- Visibilidad del dispositivo: hardware fijo RAID0

- Windows LSI: 2.10.43.00

- LSI Linus: Controlador nativo CentOS 6.2

1.6TB OCZ Z-Drive R4

- Lanzamiento: 2S2011

- Tipo NAND: MLC

- Controlador: 8 x LSI SandForce SF-2200 a través de OCZ VCA PCIe personalizado a SAS Bridge

- Visibilidad del dispositivo: hardware fijo RAID0

- Controlador de Windows OCZ: 1.3.6.17083

- Controlador Linux OCZ: 1.0.0.1480

Puntos de referencia sintéticos estándar

Dividimos la parte de prueba de IOMeter sintético estándar de esta revisión en dos partes. La primera son nuestras pruebas estándar de profundidad de cola baja, que se realizan a una profundidad de cola de 4 por trabajador (4 trabajadores en total repartidos entre dos gerentes). Las pruebas iniciales están más en línea con los entornos de un solo usuario, mientras que los rangos de profundidad de cola más altos en la segunda mitad se parecen más a lo que vería la tarjeta en un servidor con solicitudes de E/S acumuladas.

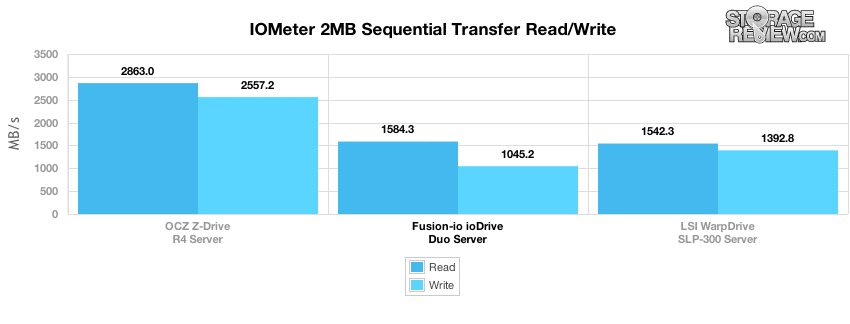

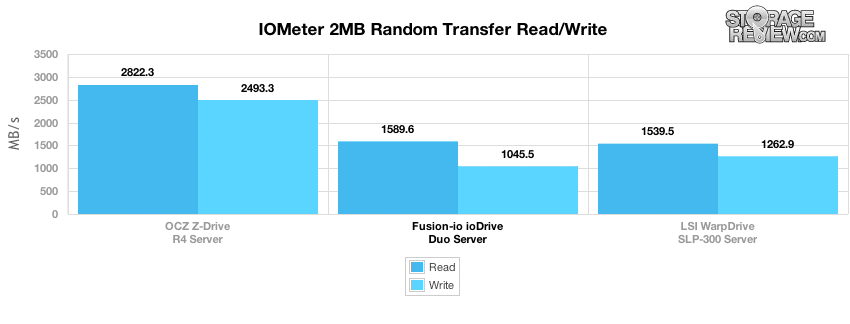

Nuestra primera prueba analiza las velocidades de lectura y escritura secuenciales en línea recta en una condición de ráfaga sostenida. Fusion-io enumera una velocidad de lectura de 1.5 GB/s y una velocidad de escritura de 1.0 GB/s en el ioDrive Duo basado en MLC de 640 GB.

Medimos el rendimiento de transferencia secuencial de 1,584 MB/s de lectura y 1,045 MB/s de escritura.

A continuación, analizamos las transferencias aleatorias de bloques grandes, con una transferencia de 2 MB en IOMeter.

Con una transferencia aleatoria de 2 MB, ioDrive Duo mantuvo una velocidad de lectura de 1,589 MB/s y una velocidad de escritura de 1046 MB/s.

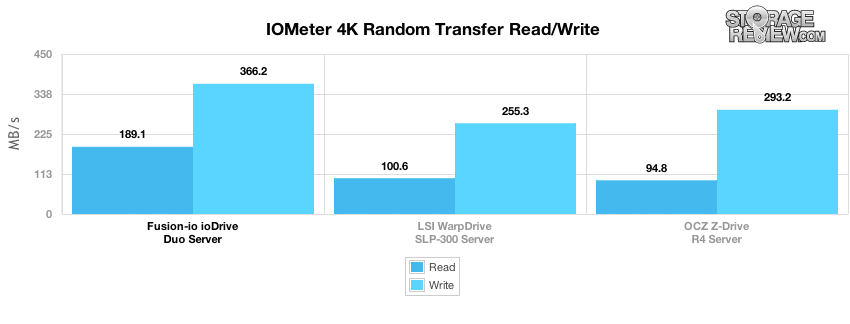

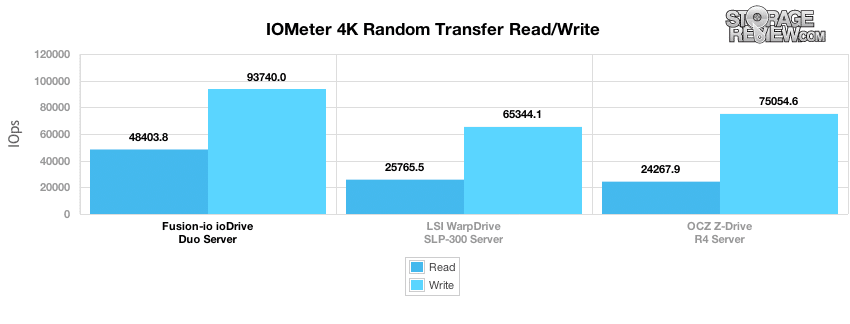

Nuestra próxima prueba analiza las velocidades de transferencia 4K aleatorias de profundidad de cola baja con cuatro trabajadores en total con una profundidad de cola de 1 cada uno.

Con una profundidad de cola baja, Fusion ioDrive Duo ofreció el rendimiento más alto, con velocidades de 189 MB/s de lectura y 366 MB/s de escritura, o 48,403 93,740 IOPS de lectura y XNUMX XNUMX IOPS de escritura.

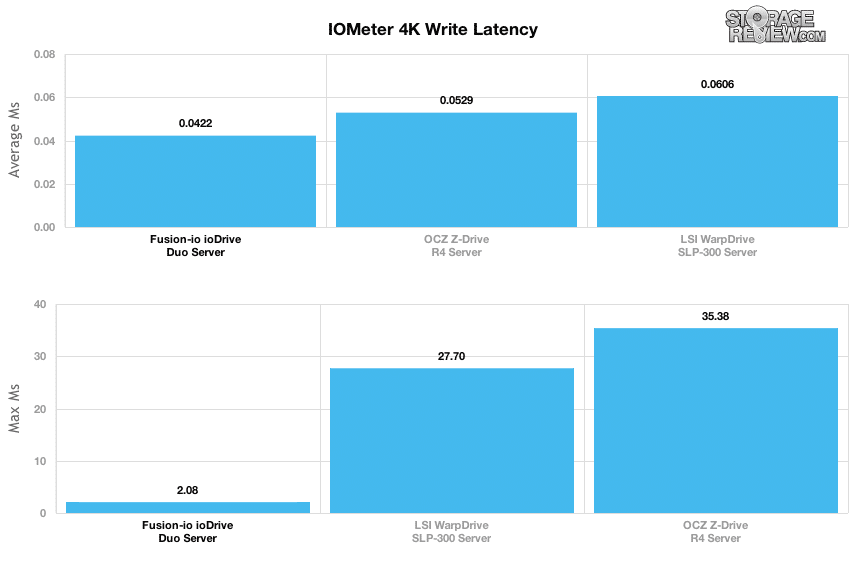

Dado que el rendimiento y la latencia van de la mano, observamos la latencia promedio y máxima durante nuestra prueba de transferencia aleatoria 4K de profundidad de cola baja. Fusion ioDrive Duo midió un tiempo de respuesta promedio de 0.0422 ms con una respuesta máxima de 2.08 ms.

La siguiente mitad de nuestros puntos de referencia sintéticos son pruebas mejoradas, que cubren el rendimiento desde los primeros niveles de profundidad de la cola hasta un máximo de 64 por trabajador (QD efectivo = 256) o 128 (QD efectivo = 512). Esta sección también incluye nuestras pruebas de perfil de servidor, que desde el principio están diseñadas para mostrar qué tan bien funcionan los productos empresariales bajo cargas de servidor mixtas exigentes.

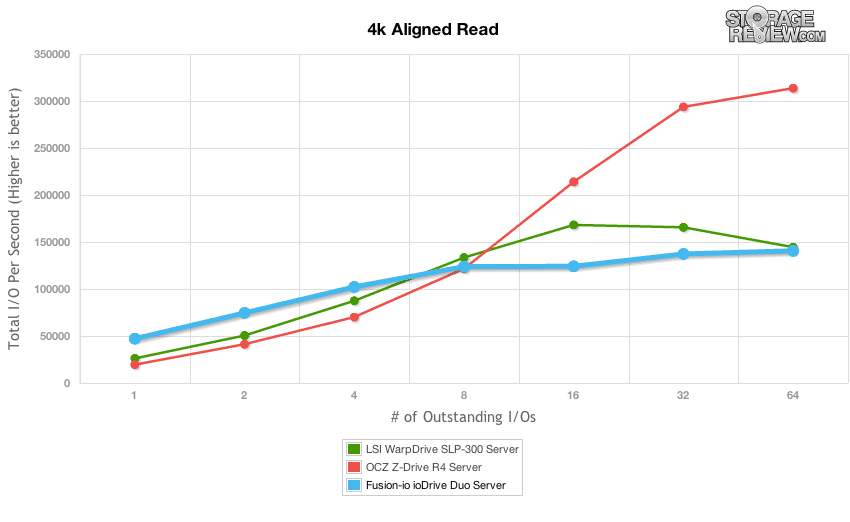

En cuanto al rendimiento de lectura aleatoria de 4K del ioDrive Duo, mantuvo casi el doble de la velocidad tanto del LSI WarpDrive como del OCZ Z-Drive R4 a una profundidad de cola de 1 y 2, y el líder se deslizó a una profundidad de cola de 4 antes de que fue superado por los dos modelos de la competencia. En esta prueba, el rendimiento superó los 140,000 64 IOPS leídos en una profundidad de cola de 120,000, aunque mantuvo velocidades superiores a 8 XNUMX IOPS desde una profundidad de cola de XNUMX y superior.

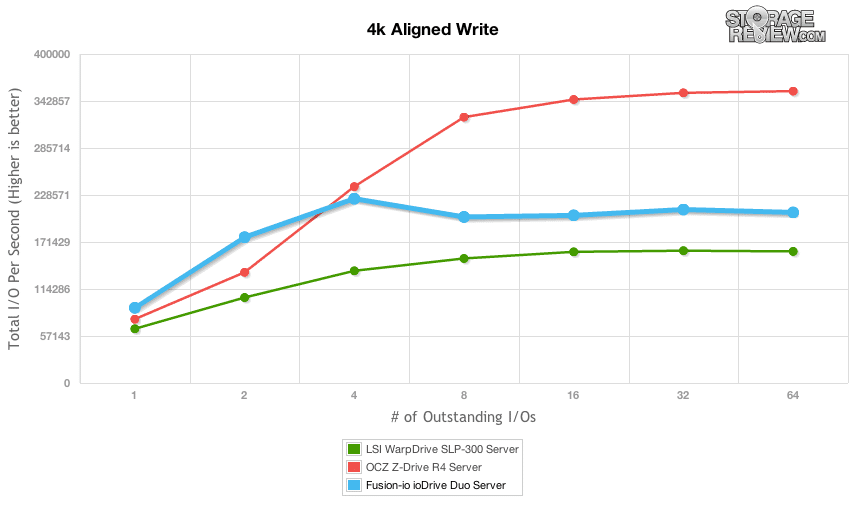

Al cambiar a una prueba de escritura aleatoria 4K aumentada, ioDrive Duo mostró un perfil de rendimiento similar, superando a los otros modelos de la competencia en colas de espera más bajas. En esta prueba, el rendimiento de ioDrive Duo alcanzó su punto máximo con una velocidad de escritura de 224,000 4 IOPS en una profundidad de cola de 201,000, estabilizándose entre 210,000 8 y 64 XNUMX IOPS entre una profundidad de cola de XNUMX a XNUMX.

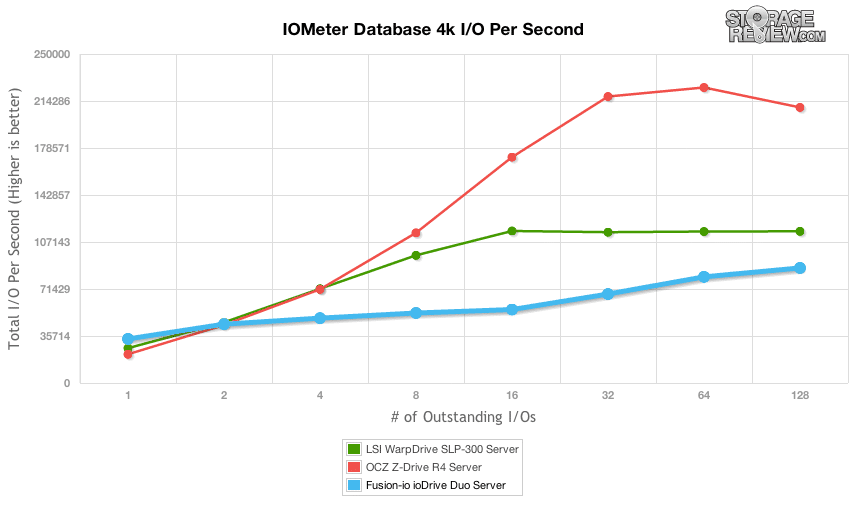

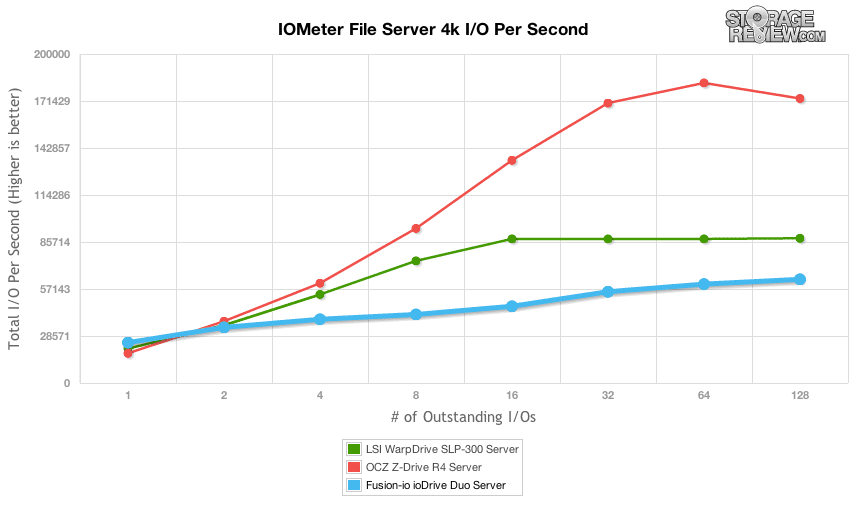

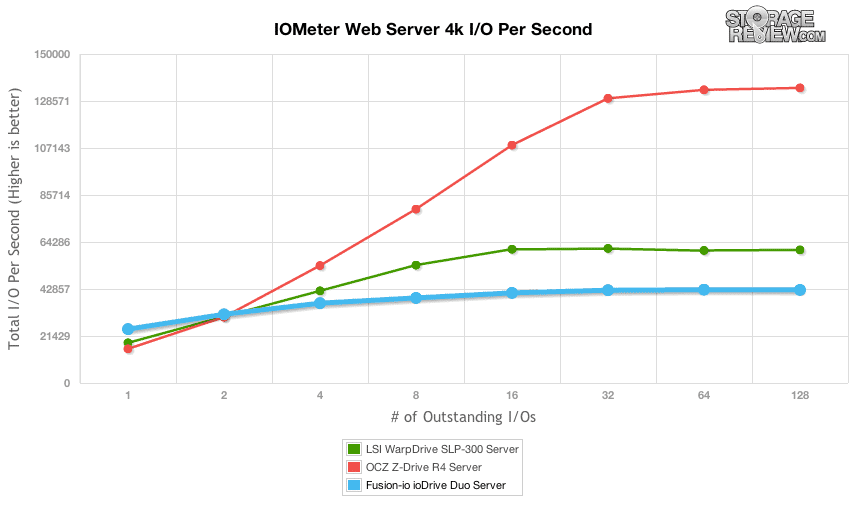

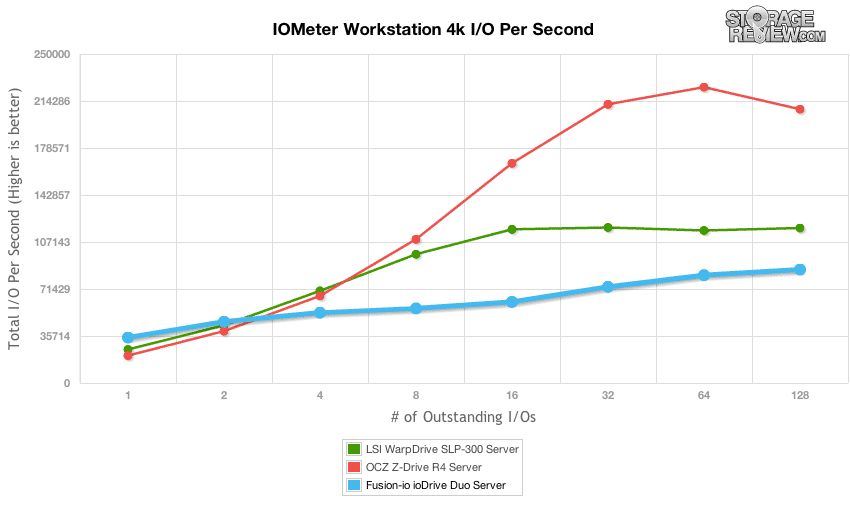

Nuestro último grupo de puntos de referencia sintéticos estándar analiza el rendimiento escalado utilizando nuestros perfiles de servidor en IOMeter. Estas pruebas miden el rendimiento desde una profundidad de cola baja hasta un máximo de 128 por trabajador (QD efectivo = 512). Esta sección está diseñada para mostrar qué tan bien funcionan los productos empresariales bajo diferentes cargas de trabajo mixtas exigentes en condiciones de ráfaga. En nuestras cargas de trabajo mixtas centradas en la empresa, ioDrive Duo lideró el paquete en una profundidad de cola de 1 y 2, con la excepción de la prueba del servidor de archivos, y luego se quedó atrás de las otras unidades en las profundidades de cola más altas.

Puntos de referencia empresariales del mundo real

Nuestro seguimiento empresarial cubre un entorno de servidor de correo de Microsoft Exchange. Capturamos la actividad de nuestro servidor de correo StorageReview durante un período de días. Este hardware de servidor consta de un Dell PowerEdge 2970 que ejecuta un entorno Windows Server 2003 R2 que funciona con tres discos duros SAS de 73 GB y 10k en RAID5 en el controlador integrado Dell Perc 5/I. El seguimiento consta de muchas solicitudes de transferencia pequeñas, con una fuerte carga de lectura del 95 % con un 5 % de tráfico de escritura.

Dado que algunos dispositivos PCIe requieren cargas más altas para alcanzar el máximo rendimiento, incluimos un perfil ligero y pesado para la reproducción de seguimiento. En esto, limitamos la profundidad efectiva de la cola a 8 en el perfil más débil y la aumentamos a 48 en el perfil Pesado.

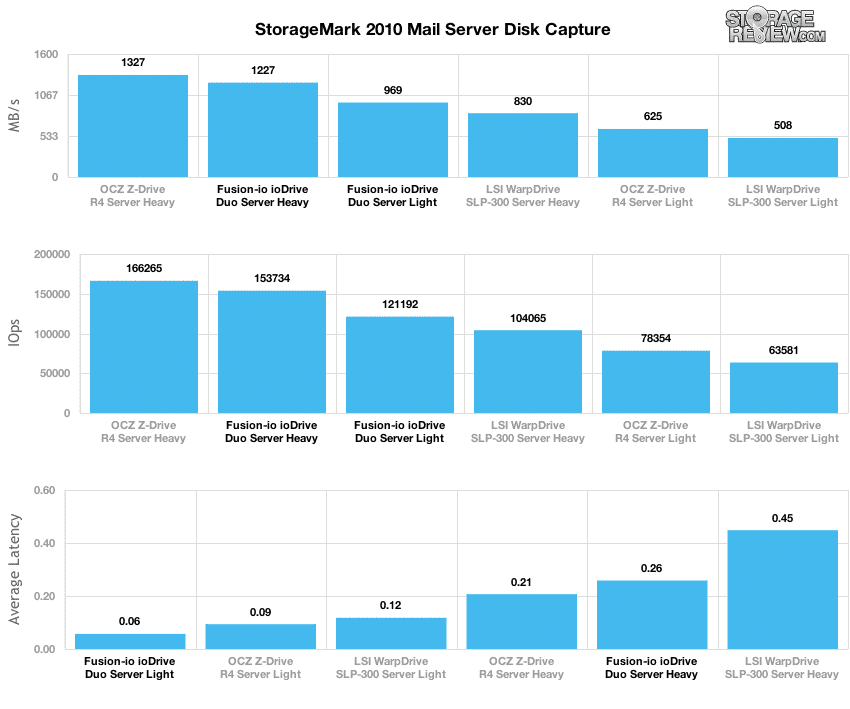

Con una profundidad de cola efectiva restringida a 8, lo que representa condiciones de actividad más livianas, ioDrive Duo ofreció las velocidades de transferencia más altas en nuestra prueba de reproducción de seguimiento del servidor de correo con una velocidad promedio de 969 MB/s. Esto se compara con el promedio de 508 MB/s del LSI WarpDrive o los 625 MB/s del OCZ Z-Drive R4 en las mismas condiciones. Ampliando la profundidad de cola permitida a 48, el Z-Drive R4 ocupó el primer lugar con una velocidad promedio de 1,327 MB/s, seguido por ioDrive Duo con una velocidad de 1,227 MB/s y el WarpDrive SLP-300 detrás. con una velocidad de 830 MB/s.

Una desventaja de aumentar la profundidad de la cola para aumentar las tasas de transferencia es que puede afectar los tiempos de respuesta a medida que aumentan las E/S pendientes. Con una carga ligera, el ioDrive Duo mantuvo su velocidad de transferencia de 969 MB/s con un tiempo de respuesta de 0.06 ms. Para que Z-Drive R4 lo superara con una velocidad de transferencia de 1,327 MB/s, su tiempo de respuesta aumentó 3.5 veces a 0.21 ms, mientras que WarpDrive tuvo una respuesta promedio de 0.45 ms para una velocidad de transferencia de 830 MB/s.

Análisis de carga de trabajo sintética empresarial (configuración de stock)

La forma en que vemos las soluciones de almacenamiento PCIe es más profunda que solo observar el rendimiento tradicional en ráfagas o en estado estable. Al observar el rendimiento promedio durante un largo período de tiempo, pierde de vista los detalles detrás del rendimiento del dispositivo durante todo ese período. Dado que el rendimiento de flash varía mucho a medida que pasa el tiempo, nuestro nuevo proceso de evaluación comparativa analiza el rendimiento en áreas que incluyen el rendimiento total, la latencia promedio, la latencia máxima y la desviación estándar durante toda la fase de preacondicionamiento de cada dispositivo. Con los productos empresariales de gama alta, la latencia suele ser más importante que el rendimiento. Por esta razón, hacemos todo lo posible para mostrar las características de rendimiento completo de cada dispositivo que ponemos a prueba. Laboratorio de pruebas empresarial.

También hemos agregado comparaciones de rendimiento para mostrar cómo funciona cada dispositivo con un conjunto de controladores diferente en los sistemas operativos Windows y Linux. Para Windows, usamos los controladores más recientes en el momento de la revisión original, y luego cada dispositivo se prueba en un entorno de Windows Server 64 R2008 de 2 bits. Para Linux, usamos el entorno CentOS 64 de 6.2 bits, que es compatible con cada Acelerador de aplicaciones Enterprise PCIe. Nuestro principal objetivo con esta prueba es mostrar cómo difiere el rendimiento del sistema operativo, ya que tener un sistema operativo que figura como compatible en una hoja de producto no siempre significa que el rendimiento en todos ellos sea igual.

Todos los dispositivos probados se someten a la misma política de prueba de principio a fin. Actualmente, para cada carga de trabajo individual, los dispositivos se borran de forma segura utilizando las herramientas proporcionadas por el proveedor, preacondicionados en estado estable con la carga de trabajo idéntica con la que se probará el dispositivo bajo una carga pesada de 16 subprocesos con una cola pendiente de 16 por subproceso, y luego se prueba en intervalos establecidos en múltiples perfiles de profundidad de subprocesos/colas para mostrar el rendimiento con un uso ligero y pesado. Para las pruebas con 100 % de actividad de lectura, el preacondicionamiento es con la misma carga de trabajo, aunque cambia a 100 % de escritura.

Pruebas de preacondicionamiento y de estado estacionario primario:

- Rendimiento (lectura+escritura de IOPS agregado)

- Latencia promedio (latencia de lectura y escritura promediadas juntas)

- Latencia máxima (máxima latencia de lectura o escritura)

- Desviación estándar de latencia (desviación estándar de lectura+escritura promediada)

En este momento, Enterprise Synthetic Workload Analysis incluye cuatro perfiles comunes, que pueden intentar reflejar la actividad del mundo real. Estos se eligieron para tener cierta similitud con nuestros puntos de referencia anteriores, así como un terreno común para compararlos con valores ampliamente publicados, como la velocidad máxima de lectura y escritura de 4K, así como 8K 70/30 comúnmente utilizados para unidades empresariales. También incluimos dos cargas de trabajo mixtas heredadas, incluido el servidor de archivos tradicional y el servidor web que ofrece una amplia combinación de tamaños de transferencia. Estos dos últimos se eliminarán gradualmente con los puntos de referencia de la aplicación en esas categorías a medida que se introduzcan en nuestro sitio y se reemplazarán con nuevas cargas de trabajo sintéticas.

- 4K

- 100 % de lectura o 100 % de escritura

- 100% 4K

- 8K 70/30

- 70% lectura, 30% escritura

- 100% 8K

- servidor de archivos

- 80% lectura, 20% escritura

- 10% 512b, 5% 1k, 5% 2k, 60% 4k, 2% 8k, 4% 16k, 4% 32k, 10% 64k

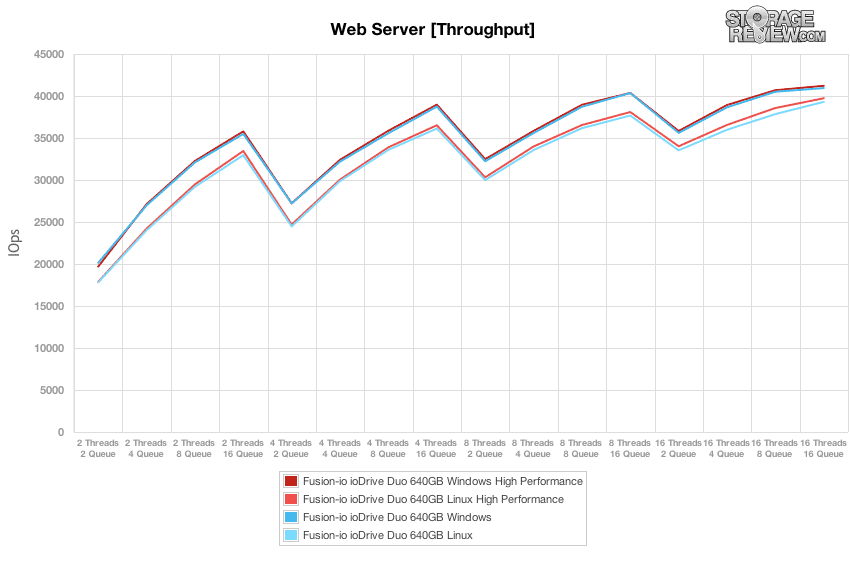

- Servidor Web

- 100% Leer

- 22% 512b, 15% 1k, 8% 2k, 23% 4k, 15% 8k, 2% 16k, 6% 32k, 7% 64k, 1% 128k, 1% 512k

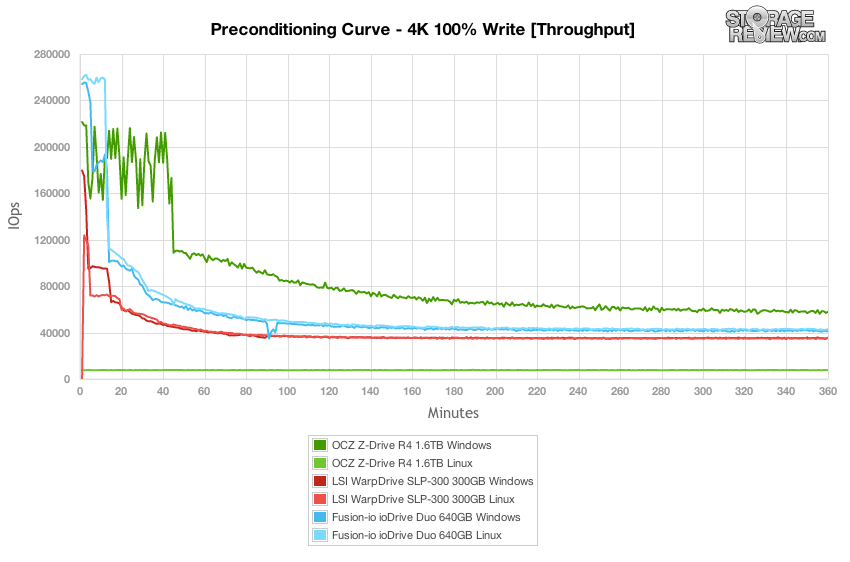

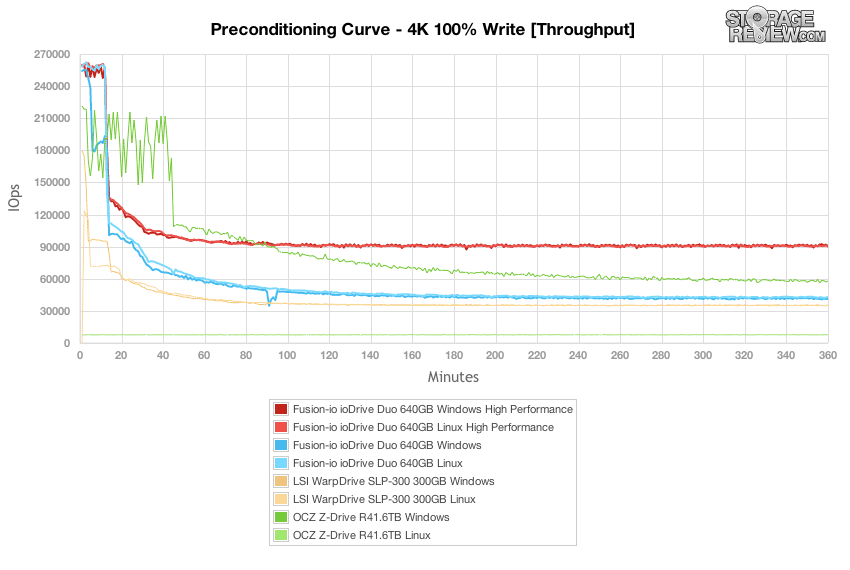

Al observar una actividad de escritura 100K del 4 % bajo una carga pesada de 16 subprocesos y 16 colas durante un período de 6 horas, descubrimos que Fusion ioDrive Duo ofrecía las velocidades de transferencia máximas más altas en nuestro Lenovo ThinkServer RD240. Esto fue cierto tanto para Windows Server 2008 R2 de 64 bits como para CentOS 6.2, que resultó tener una pequeña ventaja sobre el rendimiento de Windows. El siguiente en la línea fue el OCZ Z-Drive R1.6 de 4 TB, aunque solo en Windows. El controlador OCZ para CentOS 6.2 [1.0.0.1480] no respondía correctamente a solicitudes de mayor profundidad de cola, independientemente de la cantidad de subprocesos, y mantuvo una velocidad de aproximadamente 7,600 IOPS durante esta etapa de la prueba. El siguiente en la línea fue el LSI WarpDrive SLP-300, que ofreció un rendimiento muy similar tanto en Windows como en Linux.

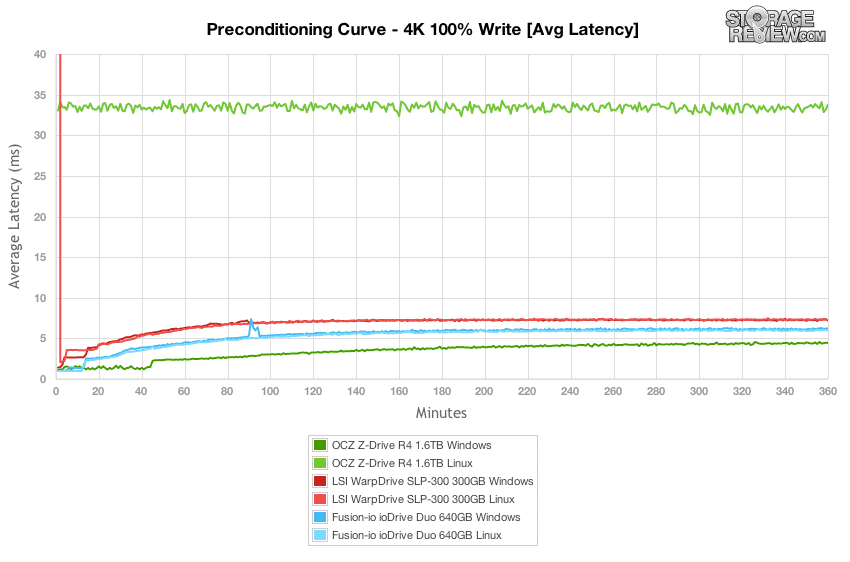

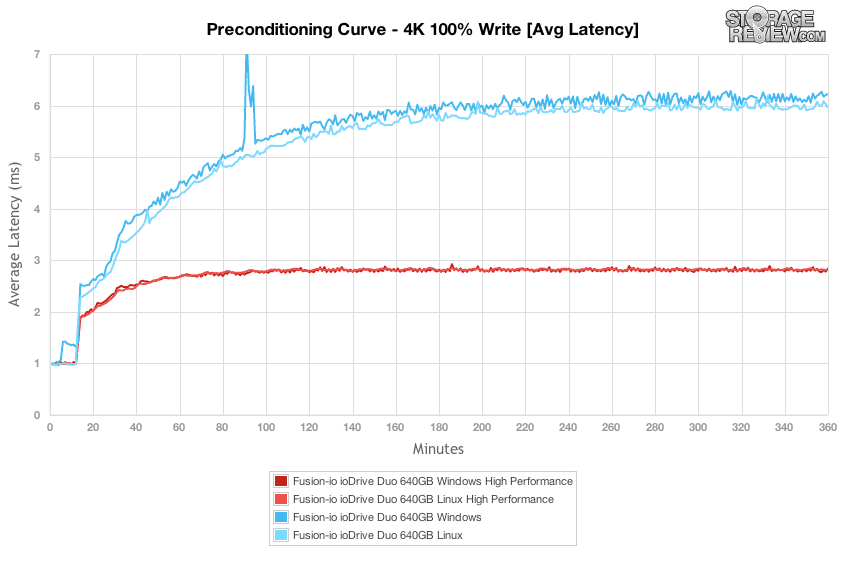

En cuanto a la latencia promedio durante la duración de nuestra prueba de preacondicionamiento de escritura 4K al 100 %, la unidad más rápida y más lenta fue la OCZ Z-Drive R4. En un entorno de Windows, con el controlador completamente funcional, la latencia promedio fue mucho más rápida que Fusion ioDrive Duo o LSI WarpDrive. En un entorno Linux con un rendimiento mediocre, fue exponencialmente más alto que los otros dispositivos de esta categoría.

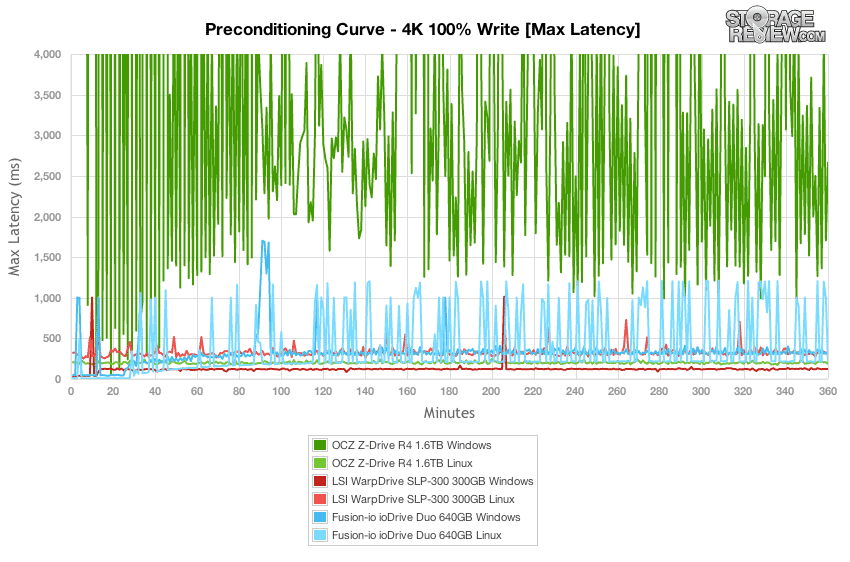

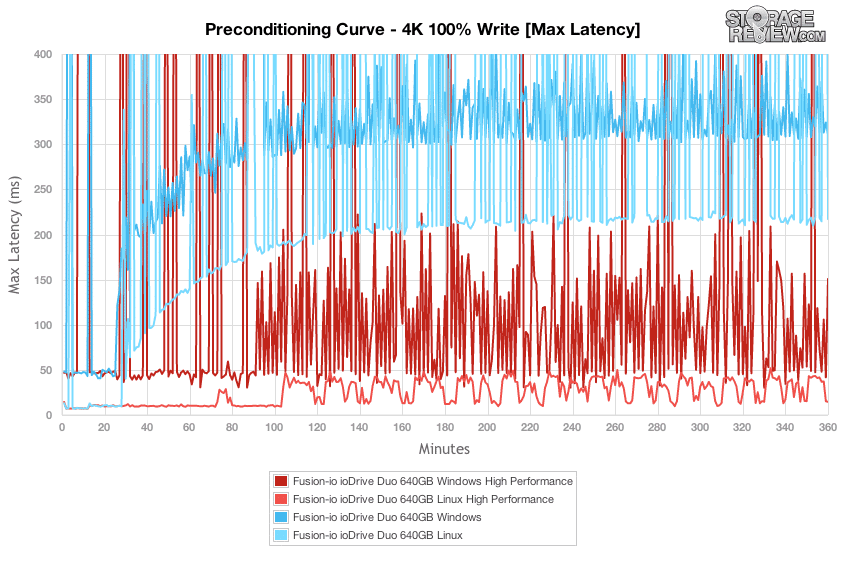

Al profundizar en la salida de latencia máxima por intervalo durante la prueba de preacondicionamiento de escritura 4K al 100 %, puede comenzar a ver qué tan grande es el controlador de impacto y la NAND entran en juego con un entorno de escritura pesada. El Fusion ioDrive Duo con MLC NAND se situó entre el LSI WarpDrive basado en SLC y el OCZ Z-Drive R4 basado en MLC en términos de picos de latencia máxima. Al comparar el rendimiento tanto en Windows como en Linux, vimos un resultado más uniforme en el entorno de Windows que en Linux, con muchos menos picos, aunque no más pequeños. El Z-Drive R4 basado en MLC en Windows tuvo grandes picos que aterrizaron muy por encima de la escala de nuestro gráfico, con un rendimiento de Linux bastante estable, aunque lejos de una gran tarea con el bajo rendimiento de IOPS. El LSI WarpDrive ofreció su mejor rendimiento en Windows, con una curva de latencia mucho más plana, aunque todavía vio un pico de más de 1,000 ms.

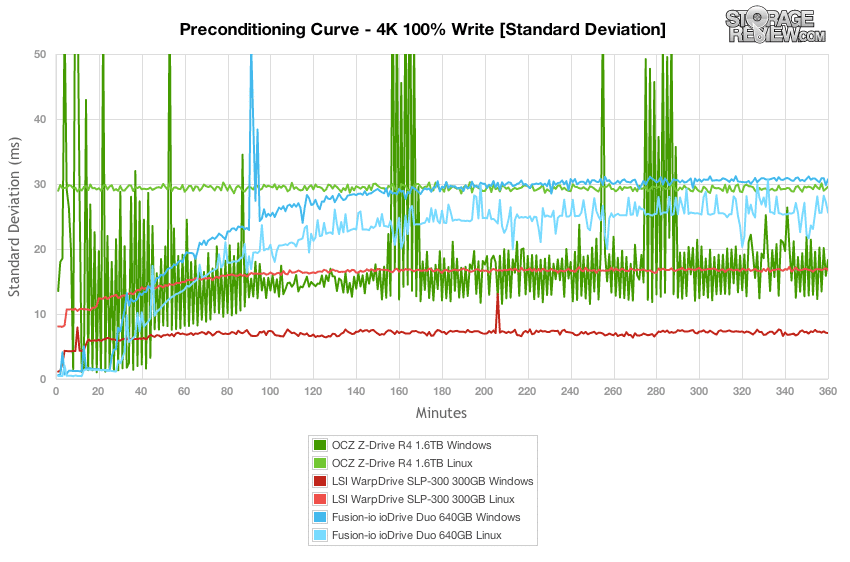

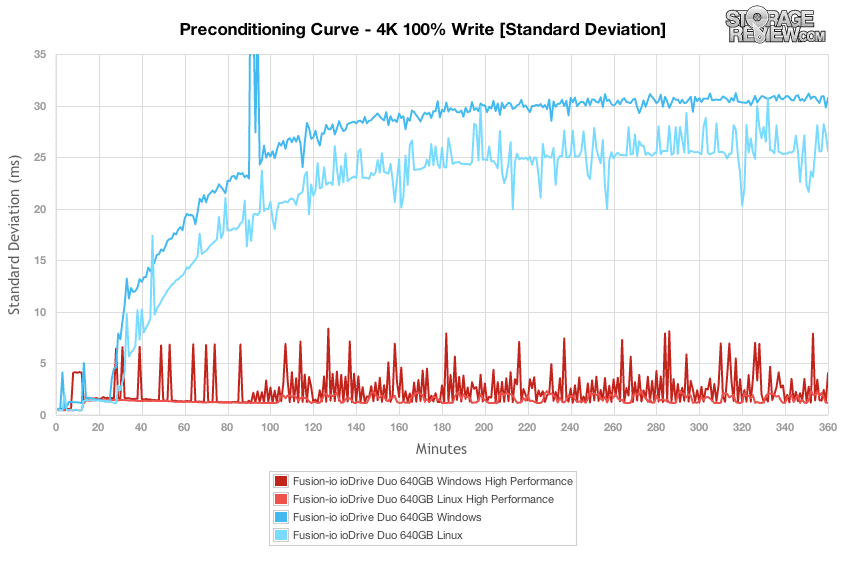

Al considerar el rendimiento de latencia máxima de un producto de almacenamiento en particular, el área que con frecuencia se pasa por alto es cuántos de los miles o millones de E/S tuvieron un valor de respuesta alto. Por eso es importante monitorear no solo la latencia máxima para ver los picos más altos, sino también observar la desviación estándar, que muestra la variación en la latencia. Incluso si una unidad tiene una latencia promedio bastante baja con todos los valores promediados, aún podría tener una cantidad bastante grande de E/S que podrían considerarse inaceptables según la aplicación que esté utilizando.

Con la configuración SLC NAND, LSI WarpDrive mantuvo una muy buena desviación estándar de latencia, y su fortaleza se mostró principalmente en un entorno de Windows. Fusion ioDrive Duo se acercó al rango superior de desviación estándar, aunque fue bastante consistente, como el patrón encontrado en WarpDrive. Comparando el rendimiento de su controlador, fue consistentemente más rápido en Linux en esta prueba en particular. El OCZ Z-Drive R4 tuvo una amplia gama de salida de latencia más alta durante la duración de nuestra prueba, aunque comenzó a equilibrarse a veces una vez que alcanzó el estado estable, aunque todavía tuvo períodos de tiempo con latencia alta nuevamente.

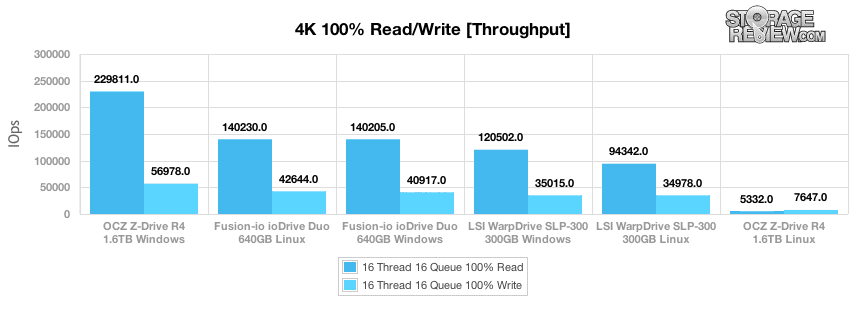

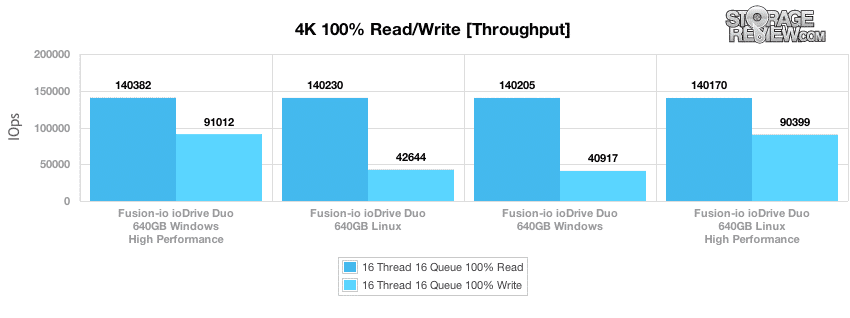

Después de que terminaron las pruebas de preacondicionamiento, comenzamos inmediatamente con nuestro muestreo de prueba principal. En estado estable, el dispositivo de almacenamiento PCIe con el mayor rendimiento en este grupo fue el OCZ Z-Drive R4 en Windows. Midió un pico de 229,811 56,978 IOPS de lectura y una velocidad de escritura de 140,230 42,644 IOPS. El siguiente en la línea fue el Fusion ioDrive Duo, que midió 300 4 IOPS de lectura y 120,502 35,015 IOPS de escritura. El rendimiento de Windows del ioDrive Duo quedó justo por debajo de eso, con una pequeña caída en el rendimiento de escritura. El LSI WarpDrive SLP-XNUMX ofreció su mayor velocidad de escritura XNUMXK en Windows, midiendo XNUMX XNUMX IOPS de lectura y XNUMX XNUMX IOPS de escritura.

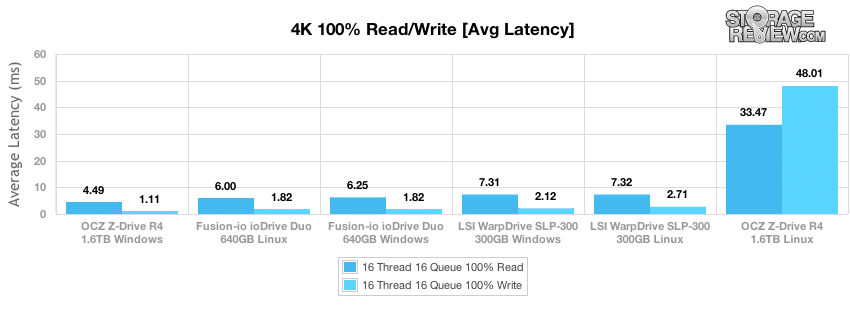

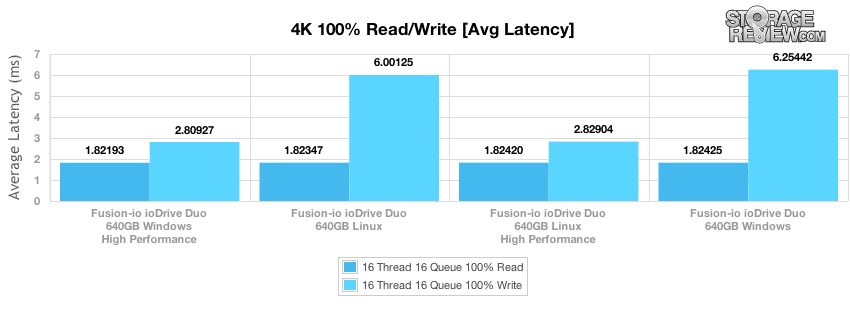

En la medición de estado estable de lectura 4K de alta carga y escritura 4K, el OCZ Z-Drive R4 con sus velocidades de rendimiento líderes en su clase en Windows ocupó el primer lugar, con una latencia promedio de 4.49 ms de lectura y 1.11 ms de escritura. El Fusion ioDrive Duo llegó a continuación con velocidades de lectura de 6.00 ms en Linux y 6.25 ms en Windows, y 1.82 ms de escritura en ambos sistemas operativos. Luego vino el WarpDrive con una velocidad de lectura de 7.31 ms en Windows y 7.32 ms de lectura en Linux, con velocidades de escritura de 2.12 ms en Windows y 2.71 ms en Linux.

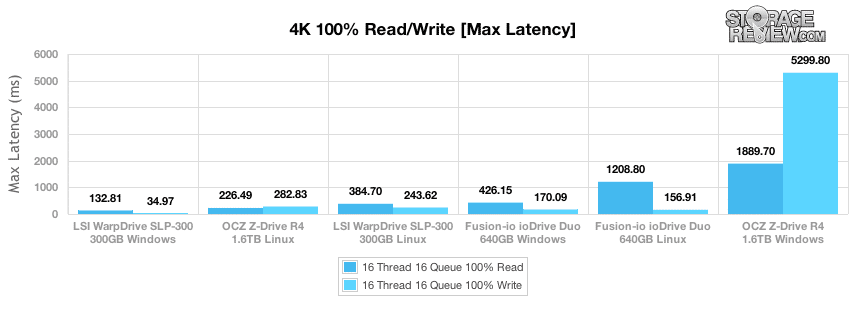

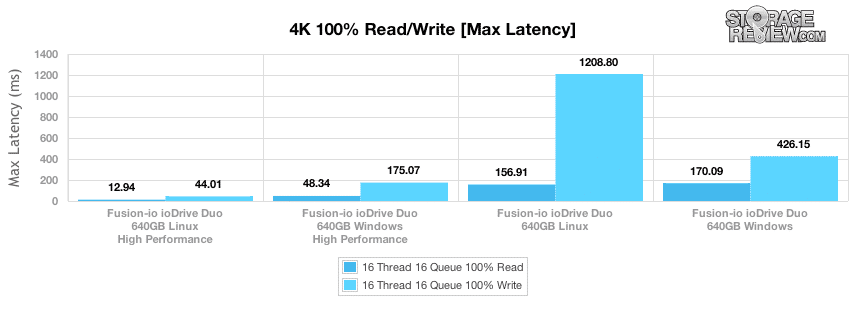

En cuanto a la latencia máxima durante el tiempo de muestreo de nuestra prueba de estado estable, LSI WarpDrive basado en SLC fue el más bajo o el mejor tanto en Windows como en Linux, seguido por Fusion ioDrive Duo en Windows primero con 426.15 ms de lectura máxima y 170.09 ms. escritura máxima, y luego en Linux con lectura máxima de 1,208 ms y escritura máxima de 156.91 ms. En Windows, el OCZ Z-Drive R4 tuvo los picos más altos, midiendo 1,889 ms de lectura y 5,299 ms de escritura en Windows.

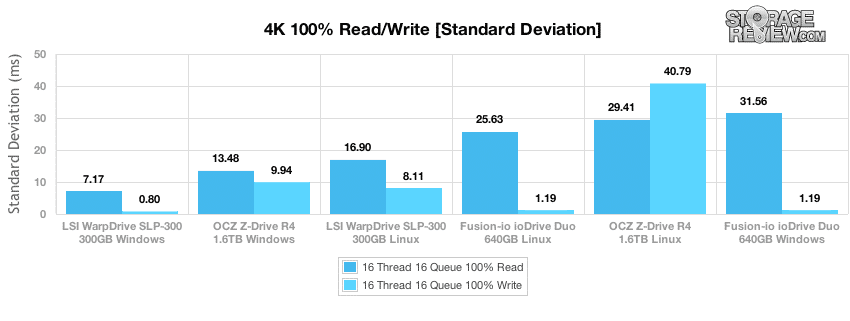

En cuanto a la desviación estándar durante el período de nuestra prueba de lectura y escritura 4K de estado estable, el acelerador de aplicaciones PCIe más consistente en nuestra prueba 4K para la actividad de lectura y escritura es el LSI WarpDrive en Windows. En la clasificación por rendimiento de escritura 4K consistente, el OCZ Z-Drive R4 en Windows viene a continuación, seguido por WarpDrive en Linux, seguido por ioDrive Duo en Linux, luego ioDrive Duo en Windows. Clasificación por velocidad de lectura constantemente rápida, el rendimiento de Windows y Linux del ioDrive Duo llegó después del WarpDrive basado en SLC, luego el WarpDrive en Linux, seguido por el Z-Drive R4 en Windows.

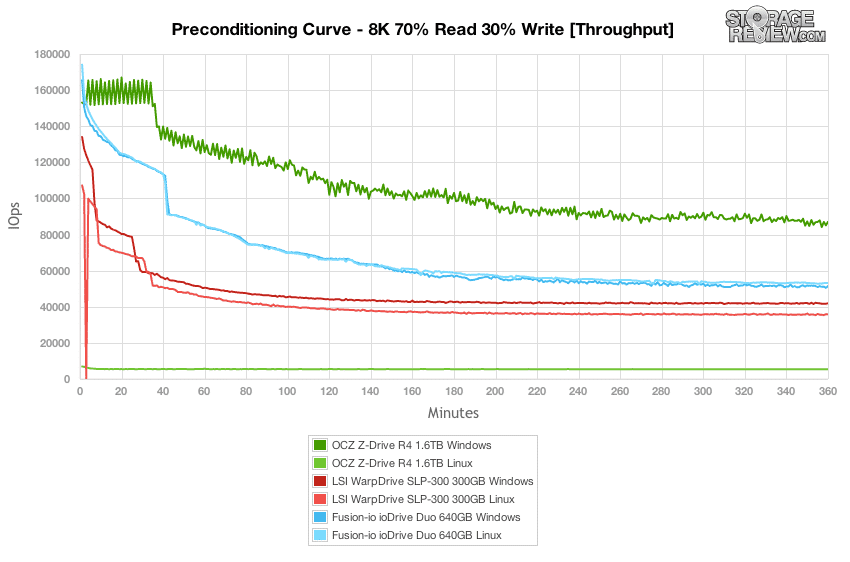

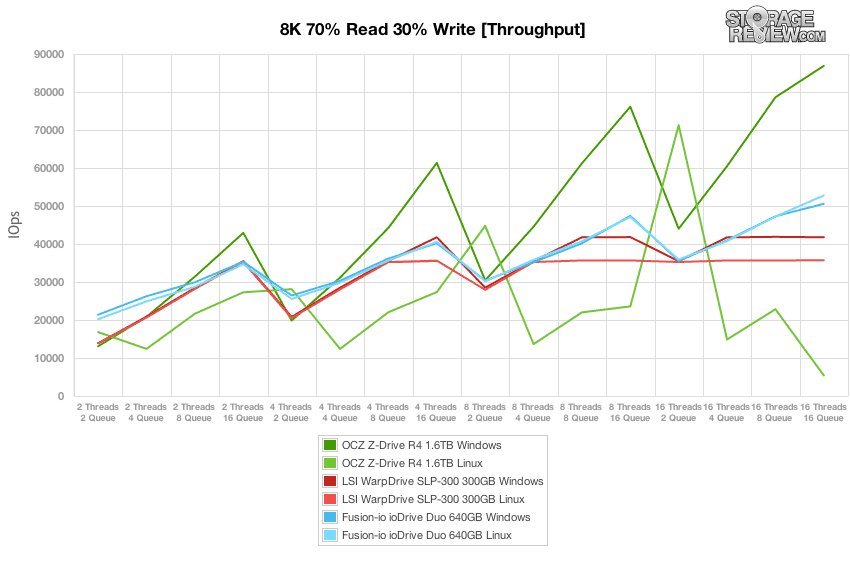

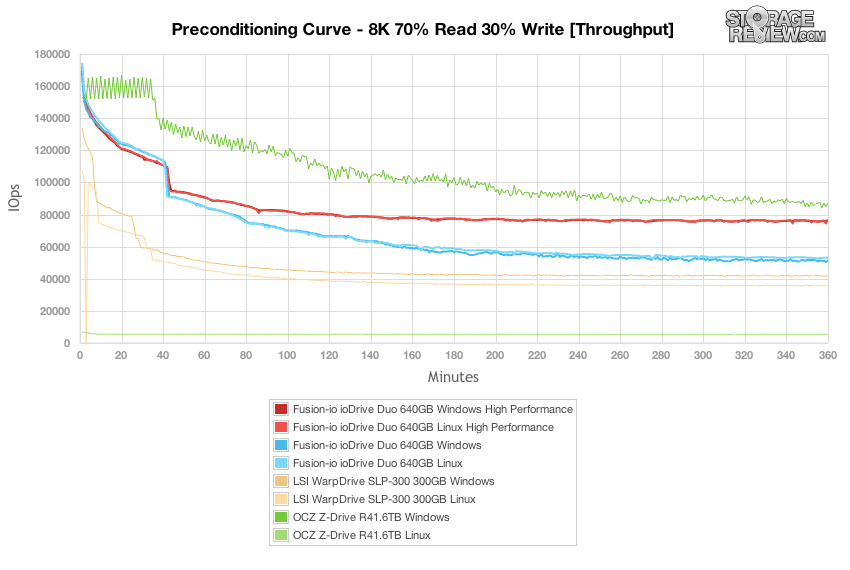

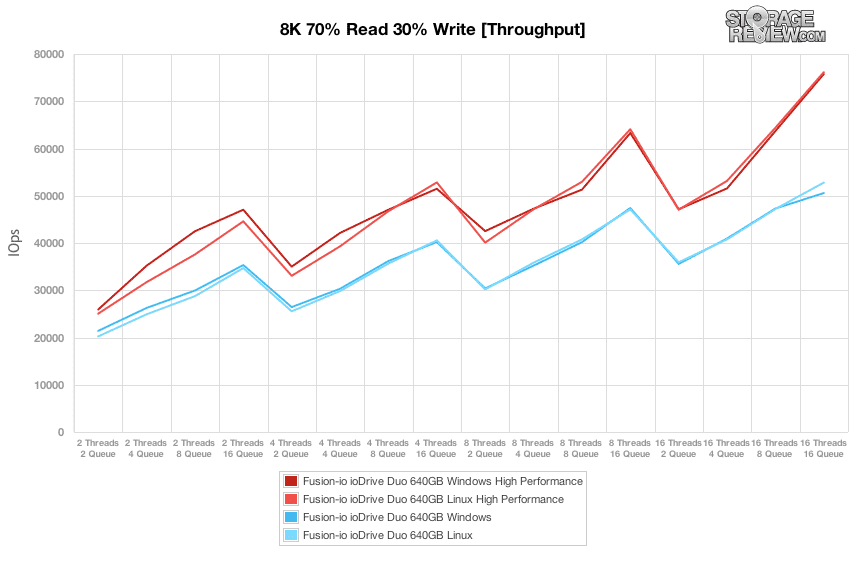

La siguiente prueba de preacondicionamiento funciona con una distribución de carga de trabajo de lectura/escritura más realista, en comparación con la actividad de escritura del 100 % en nuestra prueba 4K. Aquí, tenemos una combinación de 70 % de lectura y 30 % de escritura de transferencias de 8K. Al observar nuestra carga de trabajo mixta 8K 70/30 bajo una carga pesada de 16 subprocesos y 16 colas durante un período de 6 horas, descubrimos que Fusion ioDrive Duo aún ofrecía las velocidades de transferencia máximas más altas en nuestro Lenovo ThinkServer. Esto fue cierto tanto para Windows Server 2008 R2 de 64 bits como para el entorno CentOS 6.2, que resultó tener una ligera ventaja sobre el rendimiento de Windows. El siguiente en la línea fue el OCZ Z-Drive R1.6 de 4 TB, aunque solo en Windows. El siguiente en la línea fue el LSI WarpDrive SLP-300, que ofreció un mayor rendimiento en un entorno Windows.

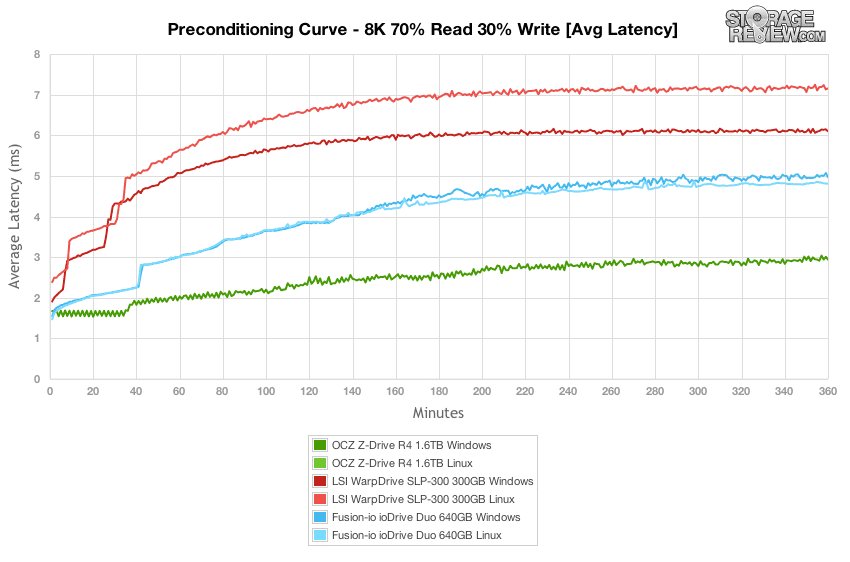

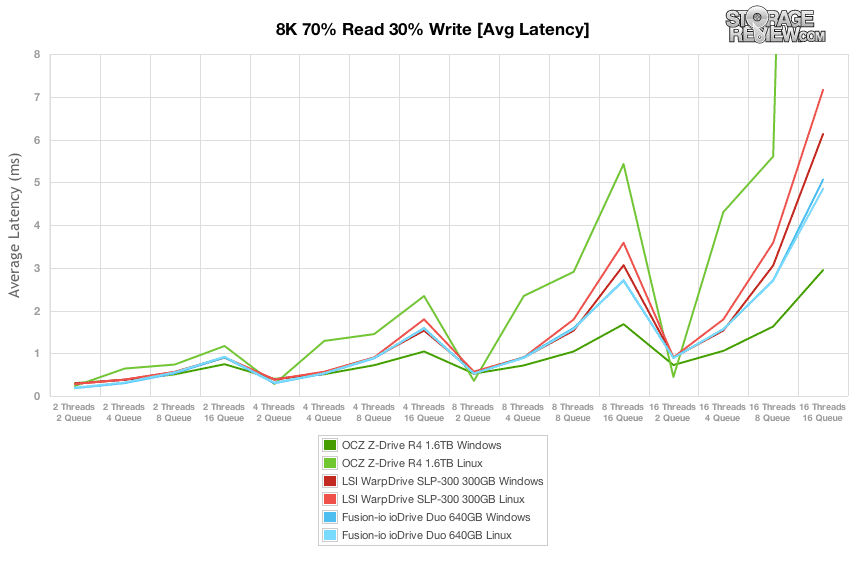

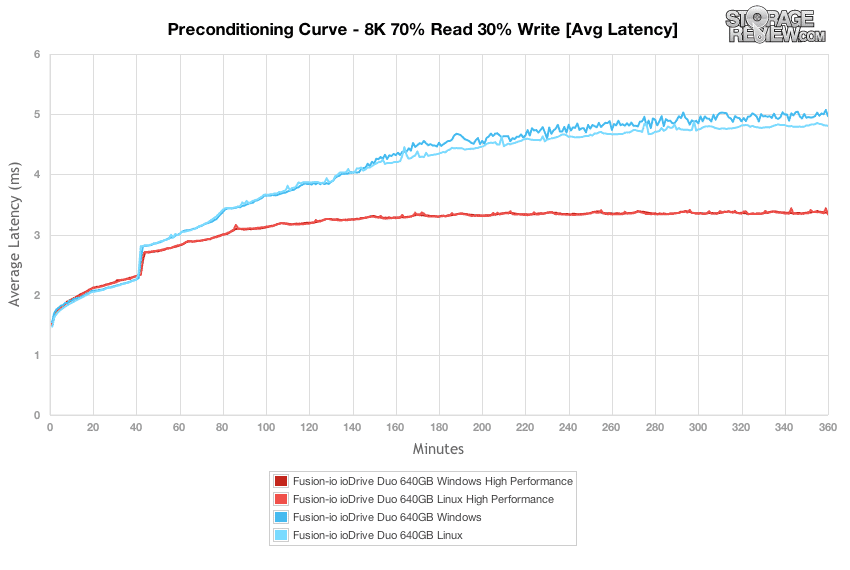

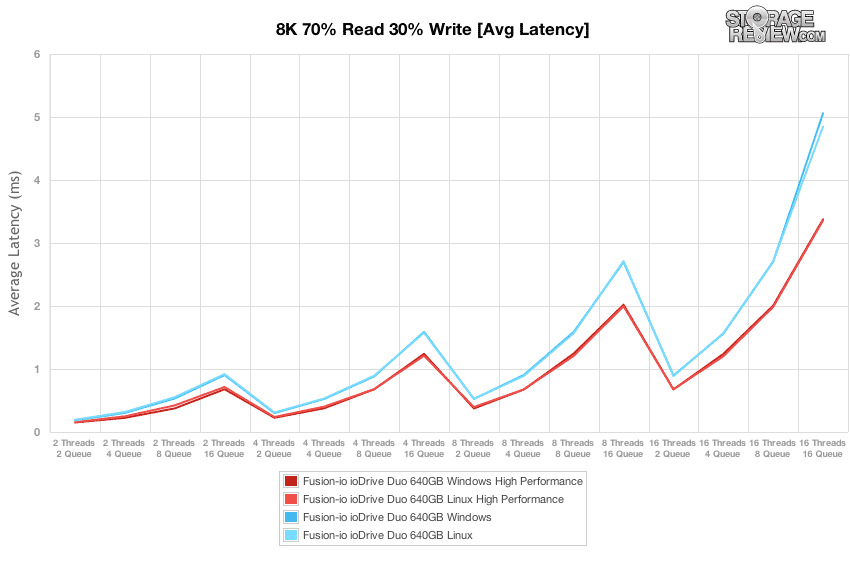

Cambiando a una mirada a la latencia promedio en nuestra prueba 8K 70/30, la diferencia entre los conjuntos de controladores se vuelve más pronunciada. Fusion ioDrive Duo tuvo el rendimiento más similar entre Linux y Windows, aunque la ventaja del conjunto de controladores de Linux se hizo más evidente a medida que la unidad alcanzaba el estado estable. El LSI WarpDrive mostró una diferencia significativa en la latencia promedio entre los conjuntos de controladores, y el controlador de Windows ofreció el rendimiento más alto. El OCZ Z-Drive R4 en Windows tuvo la latencia promedio más baja del grupo, lo que fue de la mano con el rendimiento más rápido. Sin embargo, el rendimiento de Linux estuvo nuevamente fuera de las listas con un promedio de 46 ms en Linux frente a 6 ms en Windows.

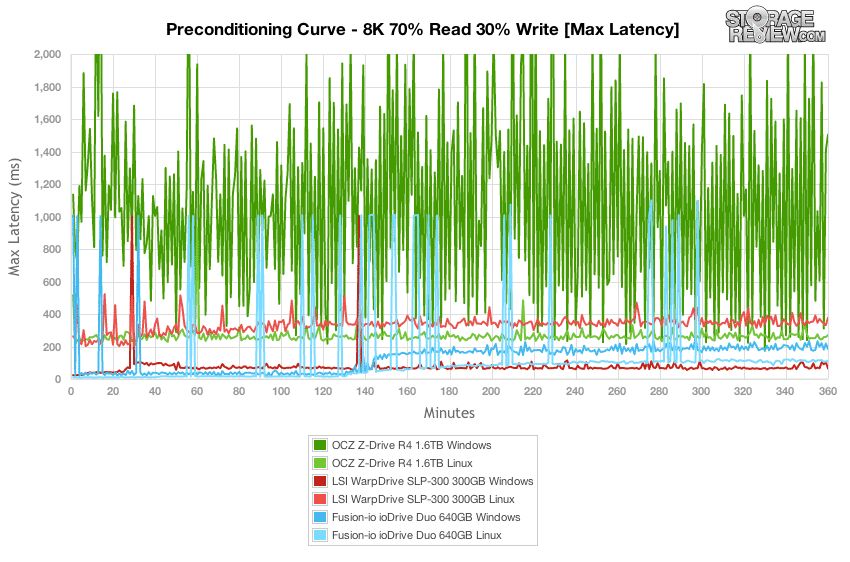

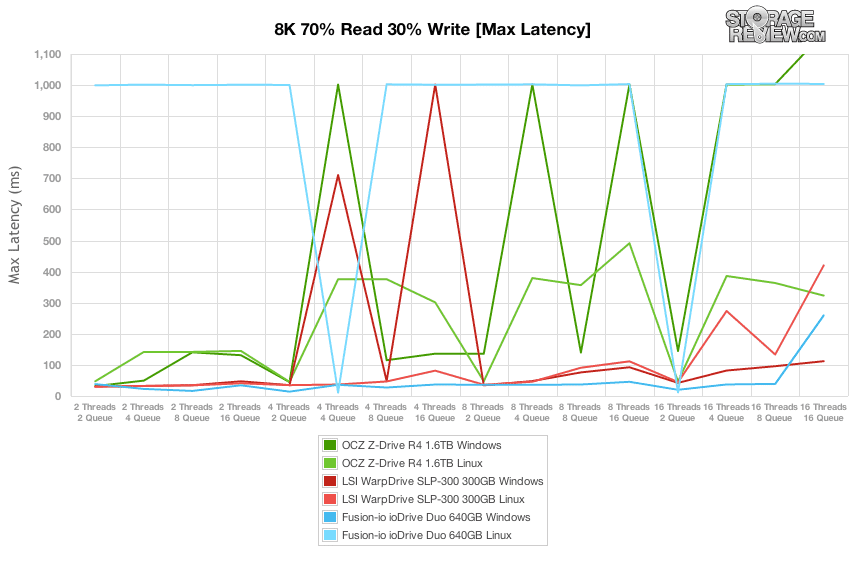

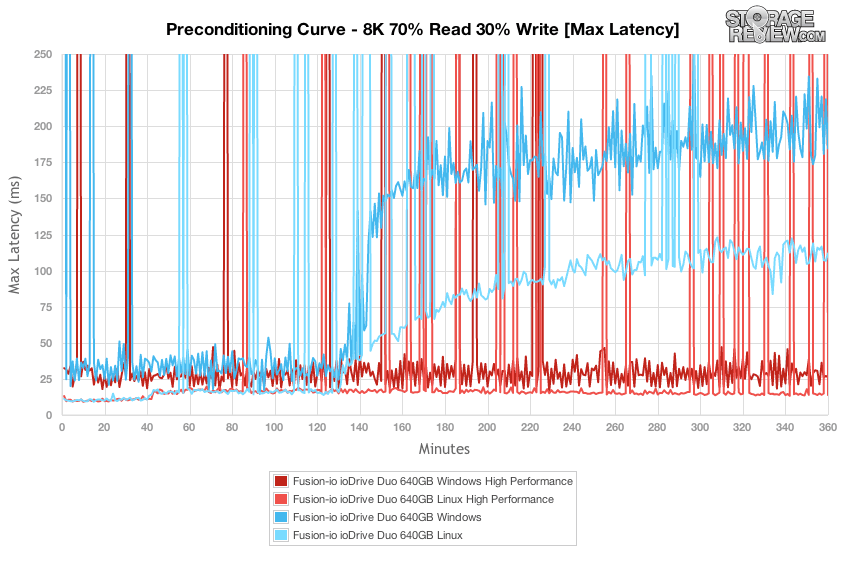

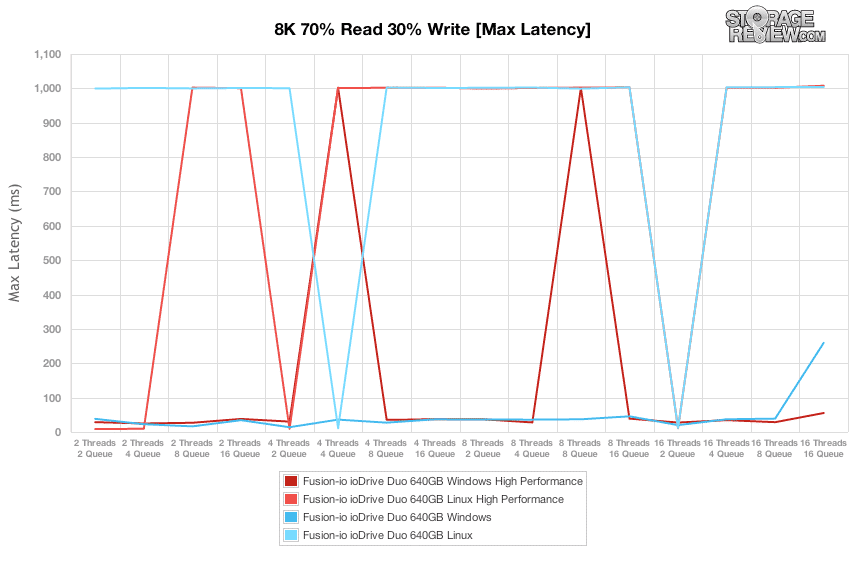

Al observar los tiempos de respuesta máximos de ioDrive Duo, WarpDrive y Z-Drive R4, muchas de las mismas características que vimos en nuestra prueba 4K se desarrollaron en nuestra carga de trabajo 8K 70/30 con una actividad de lectura incluida. En esta prueba, Fusion-io ioDrive Duo comenzó con la curva de latencia máxima más baja y luego comenzó a aumentar un poco después de dos horas cuando la unidad comenzó a pasar a un estado estable. En ese momento, estaba por encima de WarpDrive en Windows, que tenía la curva más baja de las unidades de este grupo. En cuanto a las diferencias de controlador entre ioDrive Duo en Windows y Linux, el controlador de Linux tuvo picos más altos, aunque hacia la segunda mitad de la prueba mantuvo una curva más baja (más rápida). El Z-Drive R4 en cambio en Windows tuvo picos más altos, aunque en su conjunto se calmó en comparación con su comportamiento en una carga de trabajo de escritura al 100%.

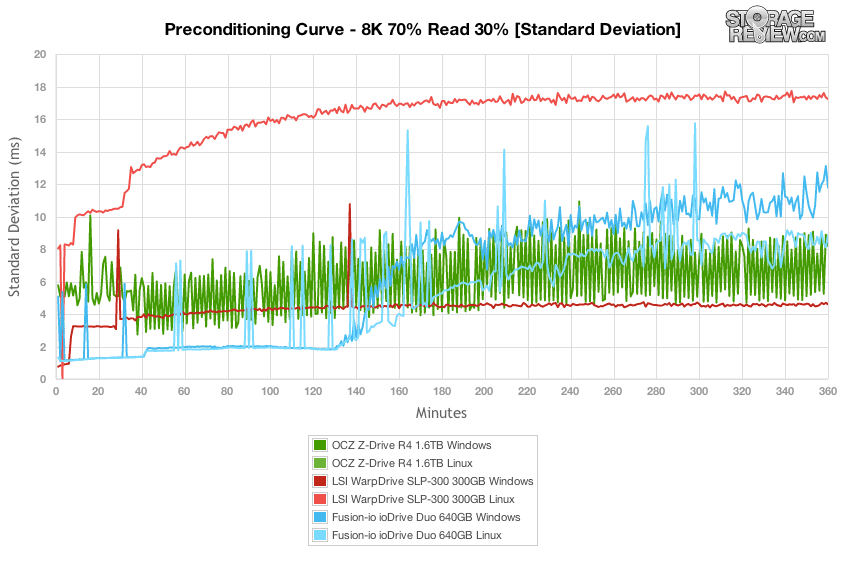

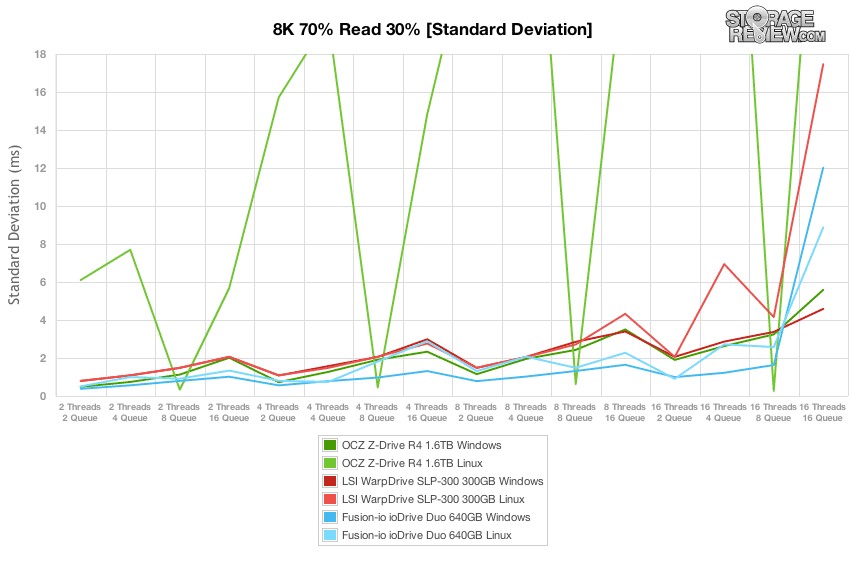

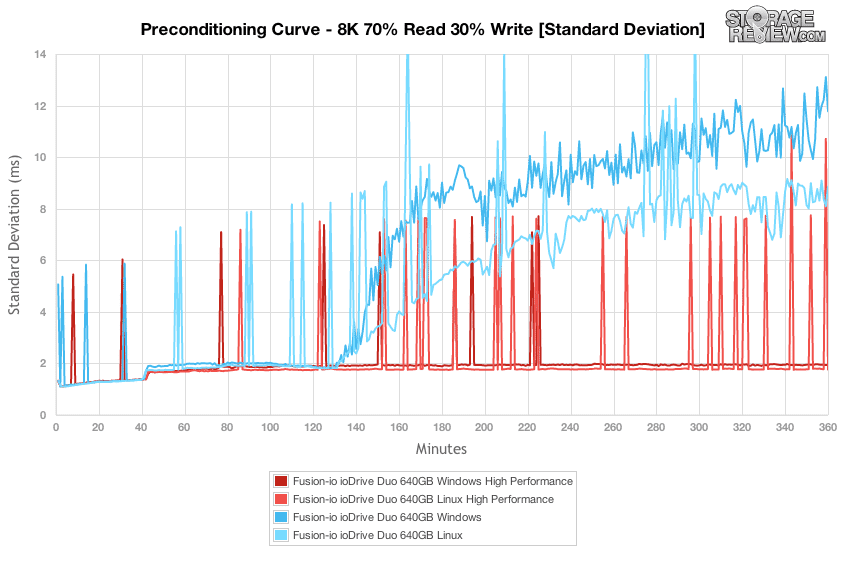

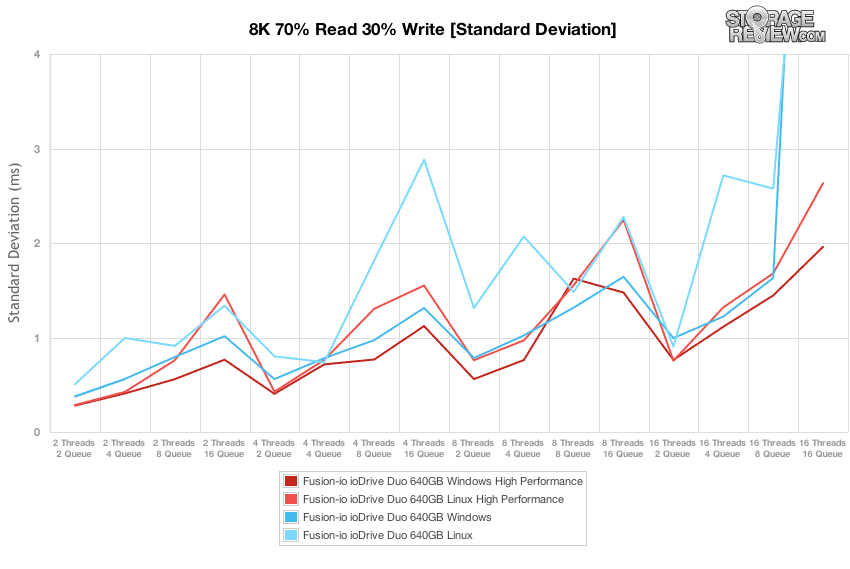

El perfil de desviación estándar en nuestra fase de preacondicionamiento de la carga de trabajo 8K 70/30 mostró diferencias interesantes entre las tarjetas en cuanto a cómo se desempeñaron durante la duración de las pruebas. Si bien WarpDrive siempre tuvo los tiempos de respuesta más rápidos en Windows, su rendimiento de latencia en Linux dejaba un poco que desear. El ioDrive Duo mostró su mejor cara en Linux, mientras que el OCZ Z-Drive R4 produjo un perfil de desviación estándar de latencia muy mejorado en esta prueba en comparación con la prueba 100K de escritura al 4 %.

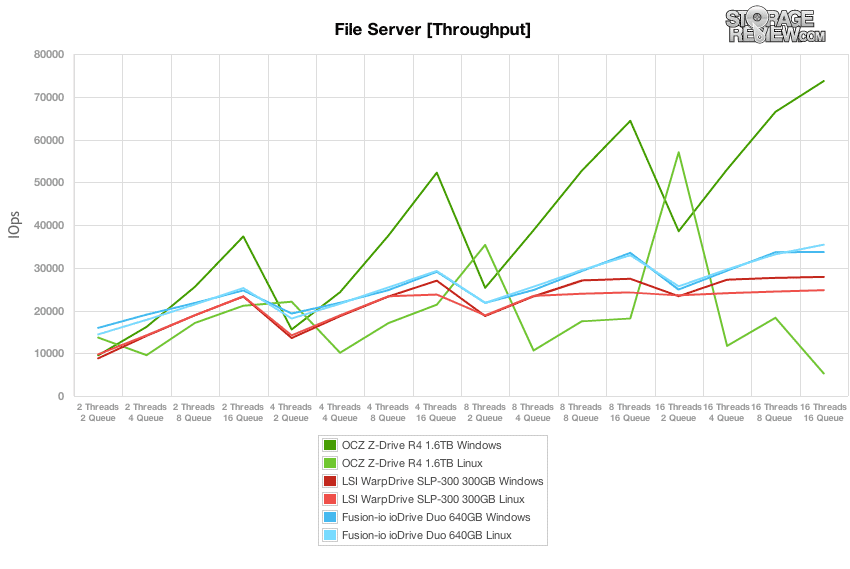

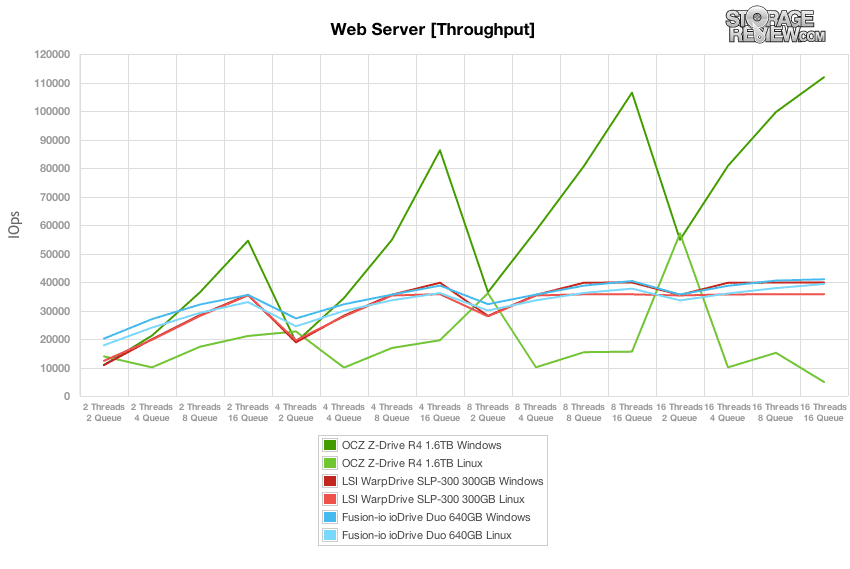

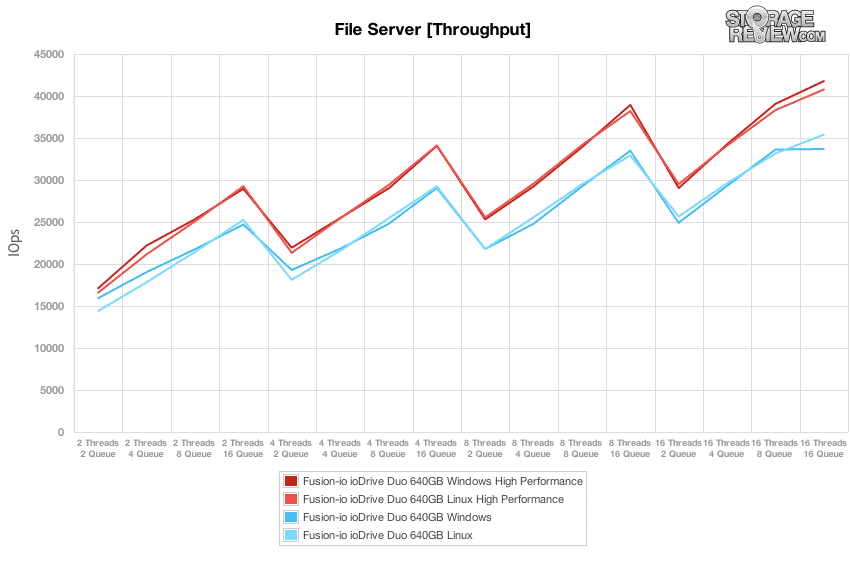

En comparación con la carga de trabajo máxima fija de 16 subprocesos y 16 colas que realizamos en la prueba de escritura 100 % 4K, nuestros perfiles de carga de trabajo mixtos escalan el rendimiento en una amplia gama de combinaciones de subprocesos/colas. En estas pruebas, ampliamos la intensidad de nuestra carga de trabajo desde 2 subprocesos y 2 colas hasta 16 subprocesos y 16 colas. De buenas a primeras, el perfil más extraño es el OCZ Z-Drive R4 que compara su rendimiento de Windows con su rendimiento de Linux. En los momentos en que es más rápido en Windows, es más lento en Linux con un problema de escala de profundidad de cola en el controlador que probamos. Con un subproceso y una profundidad de cola bajos, ioDrive Duo tuvo una sólida ventaja en rendimiento frente a WarpDrive y Z-Drive R4 con tecnología LSI SandForce. Sin embargo, a medida que aumentaba la profundidad de la cola, las otras tarjetas podían igualar o superar su rendimiento. Al comparar los entornos de controladores de Windows y Linux, ioDrive Duo ofreció casi la paridad en el rendimiento durante toda la carga de trabajo.

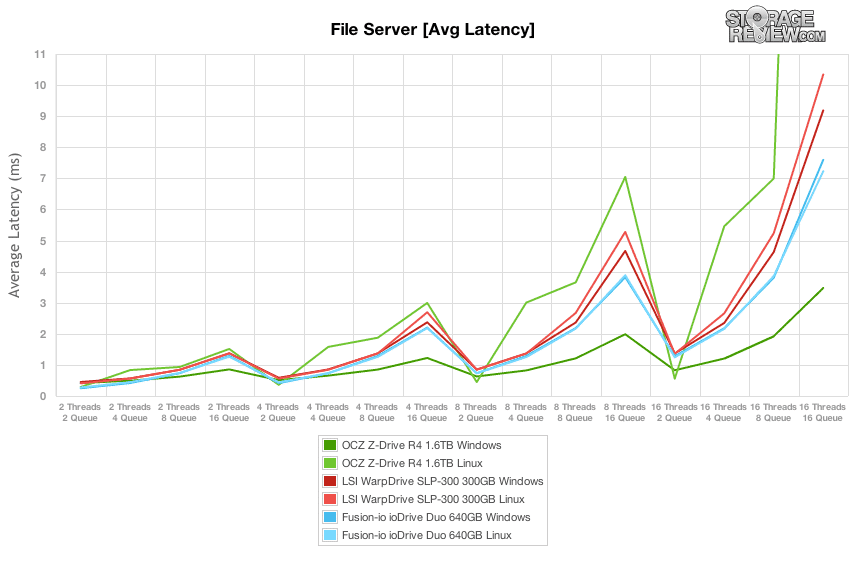

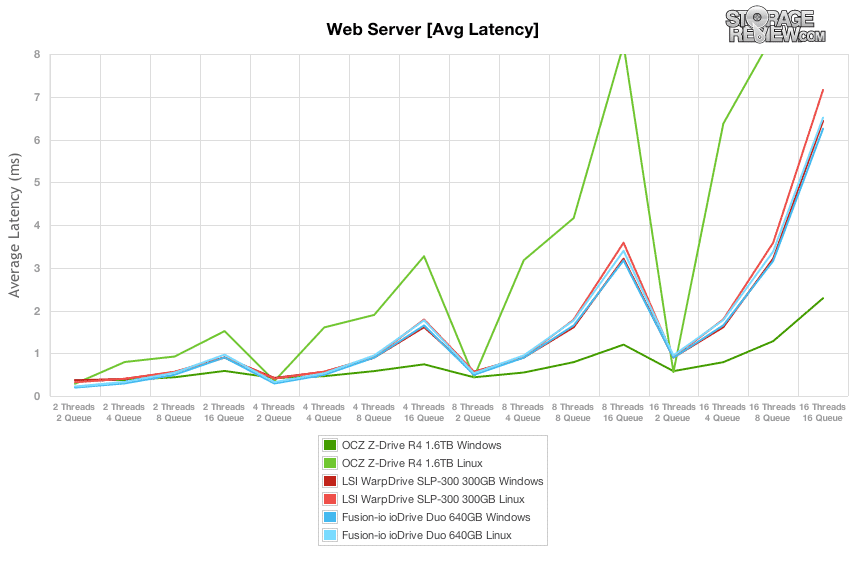

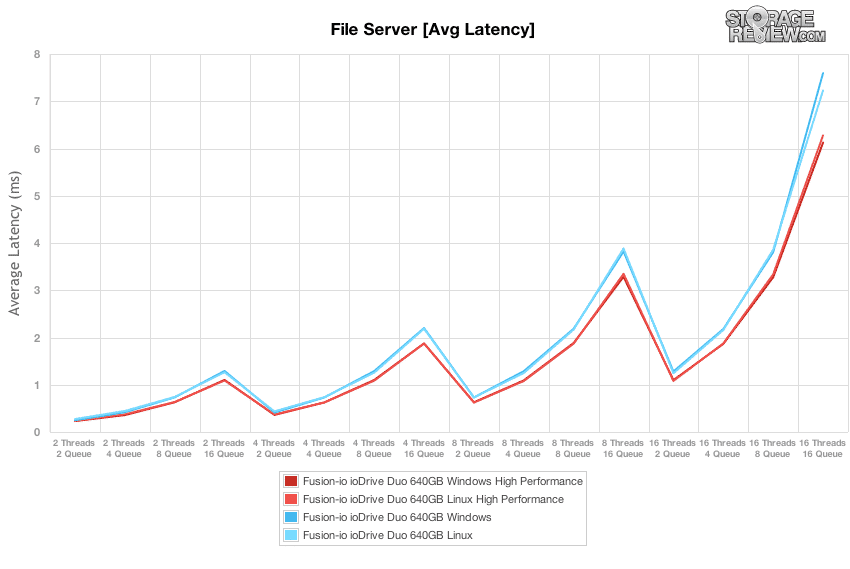

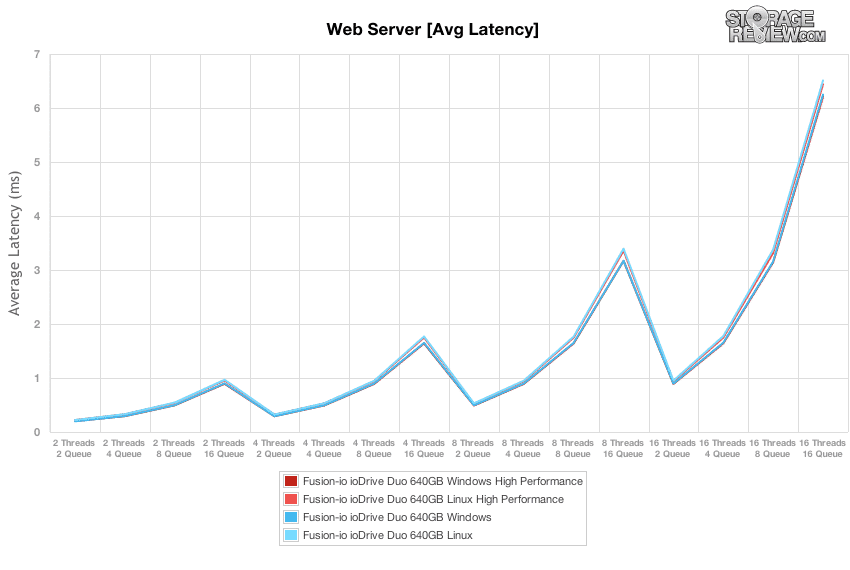

Al comparar la latencia de finalización promedio en la amplia gama de niveles variables de actividad de subprocesos y colas, WarpDrive mantuvo los tiempos de respuesta más bajos en la mayoría de los casos, hasta que Z-Drive R4 en Windows lo superó en cargas de mayor profundidad de cola. El ioDrive Duo ofreció un rendimiento casi idéntico tanto en Windows como en Linux, con solo una pequeña brecha en su nivel de salida más alto, lo que le dio la ventaja al conjunto de controladores de Linux.

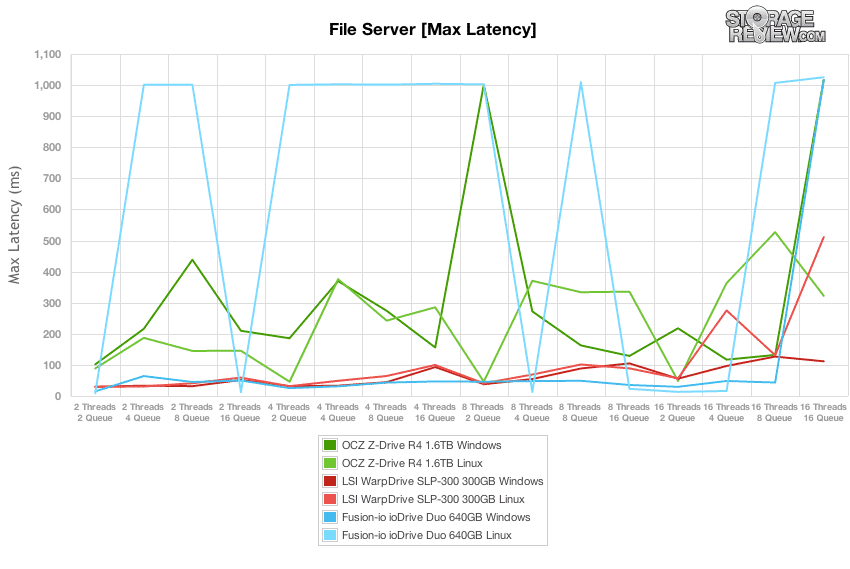

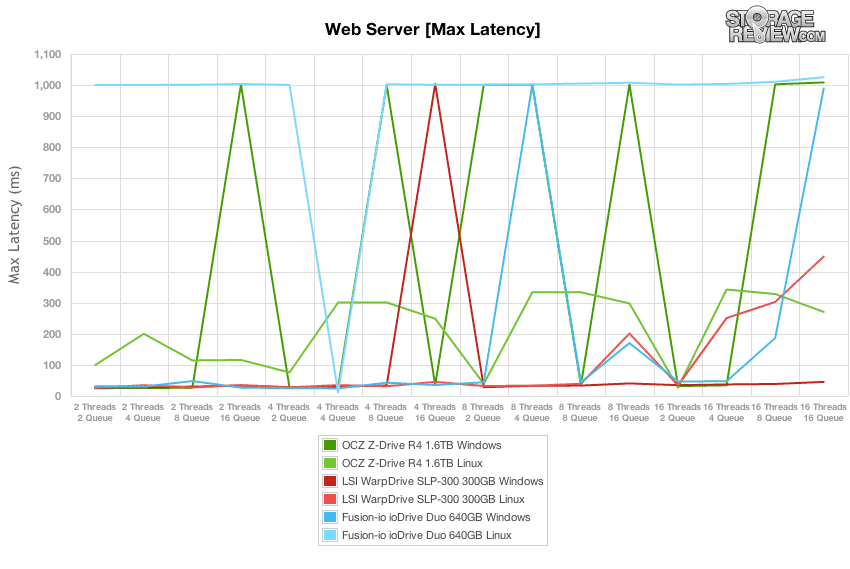

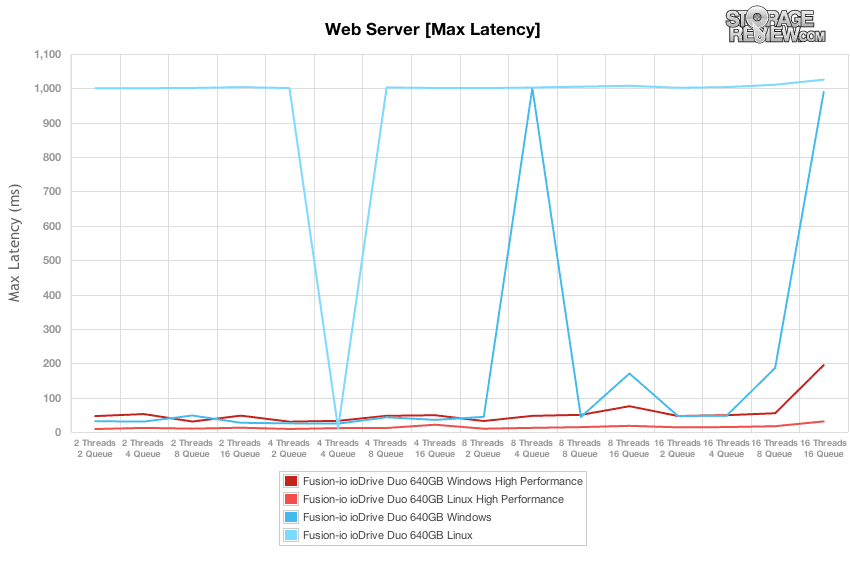

Fue interesante observar la latencia máxima en nuestra carga de trabajo 8K 70/30, ya que mostró que, incluso con un menor número de subprocesos y colas, las unidades seguían experimentando tiempos de respuesta máximos elevados. El ioDrive Duo en Linux experimentó picos constantes de 1,000 ms en la mayoría de las cargas de trabajo, mientras que el controlador de Windows fue mucho más tranquilo. En esta prueba en particular, ioDrive Duo en Windows obtuvo los tiempos de respuesta máximos más bajos hasta la carga 16T/16Q, con WarpDrive justo detrás.

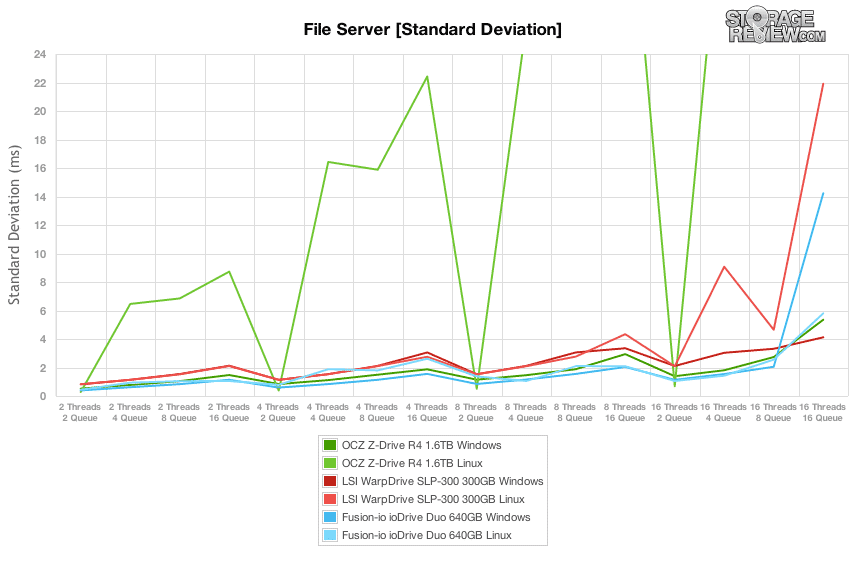

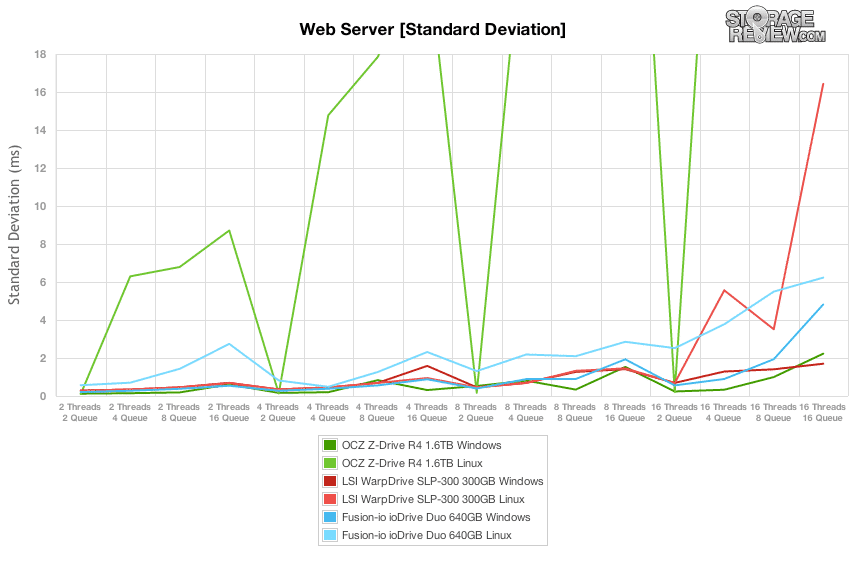

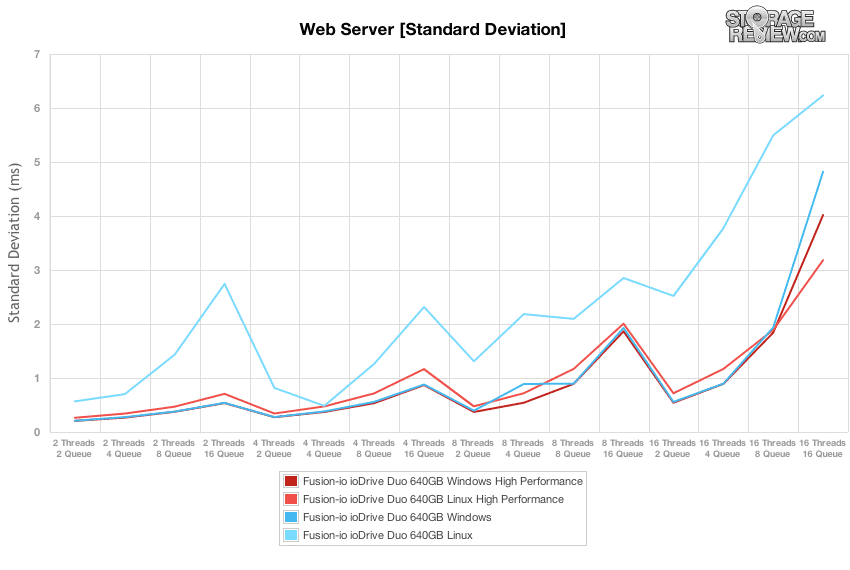

Si bien los picos altos ocasionales pueden parecer desalentadores, al observar el gráfico de latencia de desviación estándar, vimos un perfil de latencia mucho más moderado de todos los dispositivos, excepto el Z-Drive R4 en Linux. Hasta las cargas más altas, ioDrive Duo en Windows mantuvo la desviación estándar más baja, con el controlador de Linux siguiéndolo ligeramente, seguido por WarpDrive y luego Z-Drive R4 en Windows.

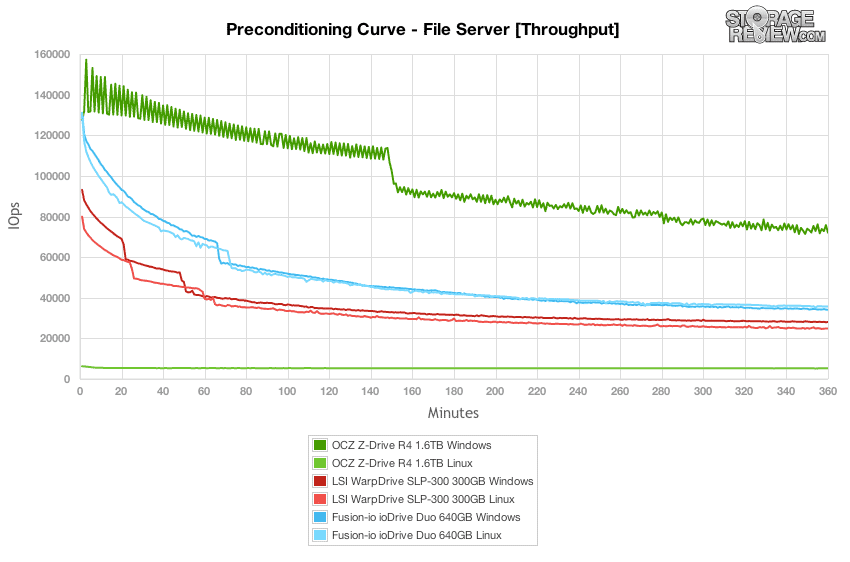

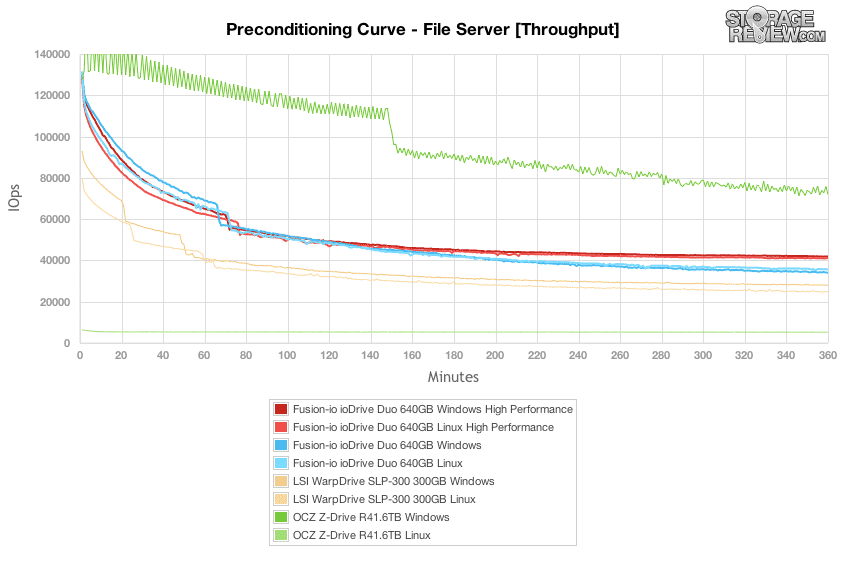

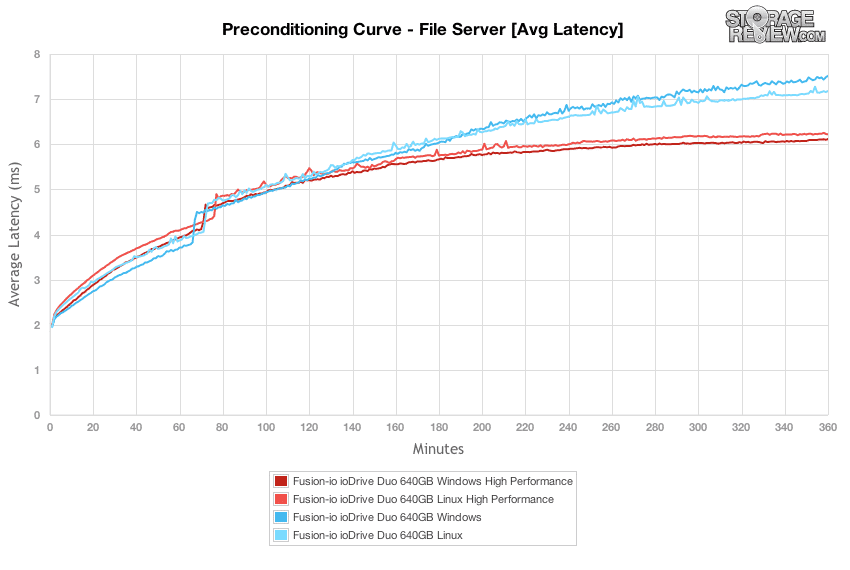

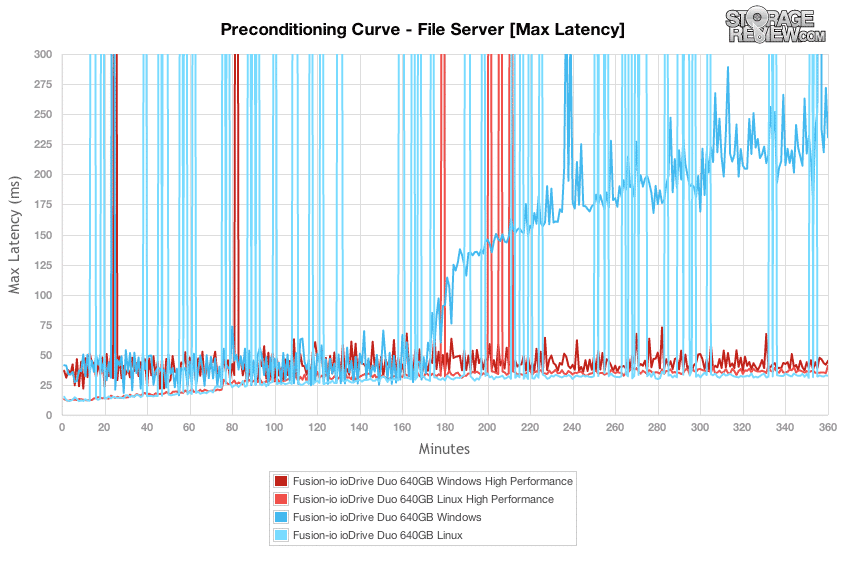

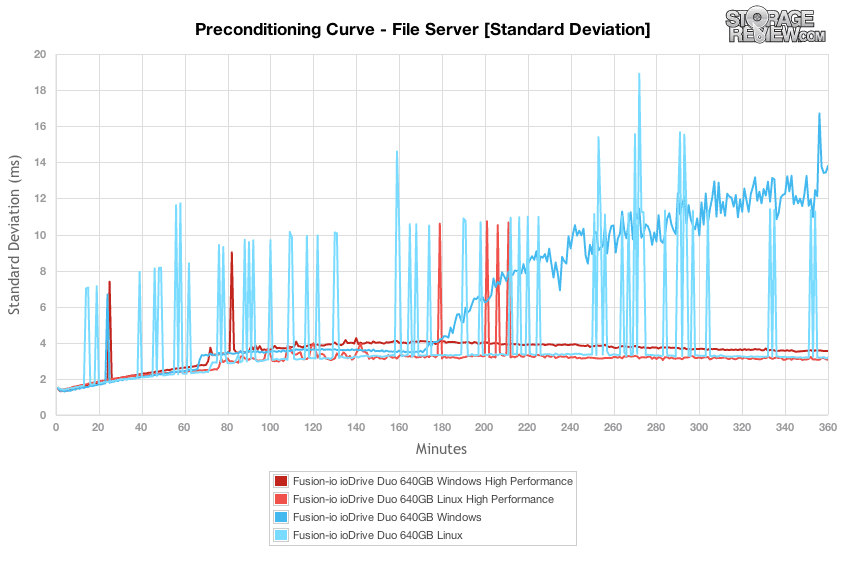

La carga de trabajo del servidor de archivos representa un espectro de tamaño de transferencia más grande que afecta a cada dispositivo en particular, por lo que en lugar de conformarse con una carga de trabajo estática de 4k u 8k, la unidad debe hacer frente a solicitudes que van desde 512b a 64K. En esta sección, Z-Drive R4 en Windows se destacó con el mayor rendimiento en ráfaga y estado estable, seguido por ioDrive Duo. En el modo de ráfaga, el ioDrive Duo en Windows ofrecía velocidades más altas y luego cambiaba con el rendimiento de Linux cuando la unidad entraba en estado estable. El WarpDrive llegó a continuación, con un rendimiento de Windows superior en los modos de ráfaga y de estado estable.

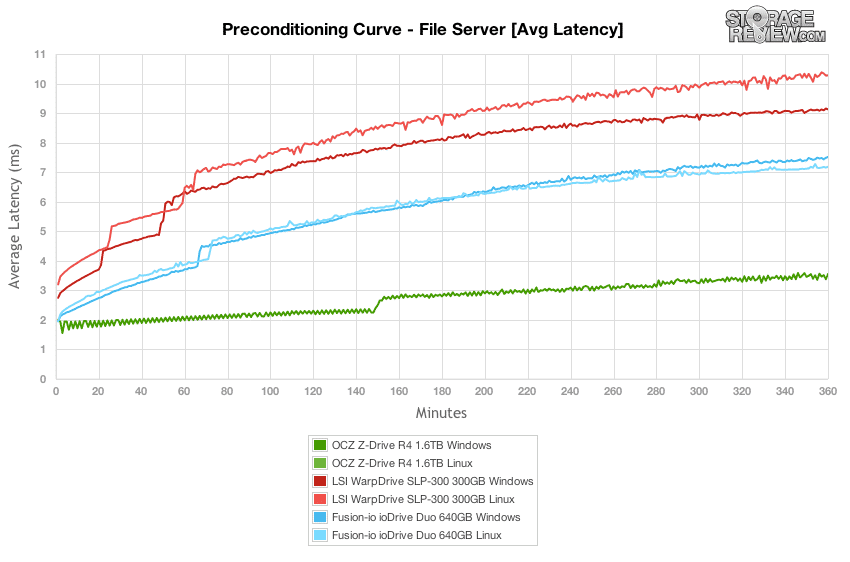

En cuanto a la latencia promedio en la prueba de preacondicionamiento del servidor de archivos, el Z-Drive R4 mantuvo una sólida ventaja sobre el ioDrive Duo y WarpDrive en Windows. ioDrive tuvo muy poca diferencia entre el rendimiento de Linux y Windows, mientras que WarpDrive mostró una brecha mayor entre los sistemas operativos.

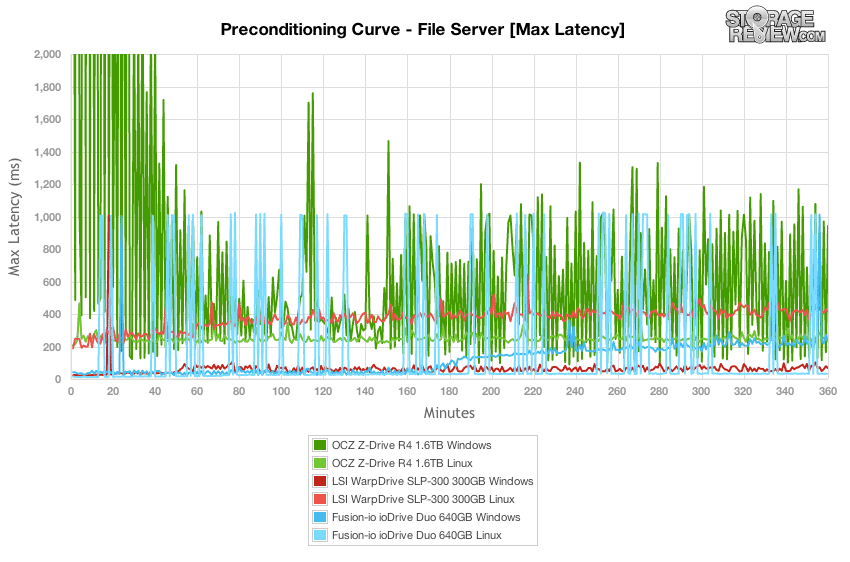

Al observar la latencia máxima durante la fase de preacondicionamiento de cada unidad, LSI WarpDrive mostró cierta debilidad con sus tiempos de respuesta máximos de Linux con un salto de casi 400 ms sobre sus tiempos de Windows. Los picos de respuesta de ioDrive Duo en Linux fueron más altos que en Windows, aunque durante la prueba, la mayoría de ellos fueron los más bajos de la prueba, mientras que el lado de Windows casi no tuvo picos de alta latencia, aunque flotó más alto en promedio. El OCZ Z-Drive R4 basado en MLC aleteó durante la mayor parte del proceso de preacondicionamiento del servidor de archivos, con algunos picos de más de 10,000 40,000-XNUMX XNUMX ms durante la primera hora de la prueba.

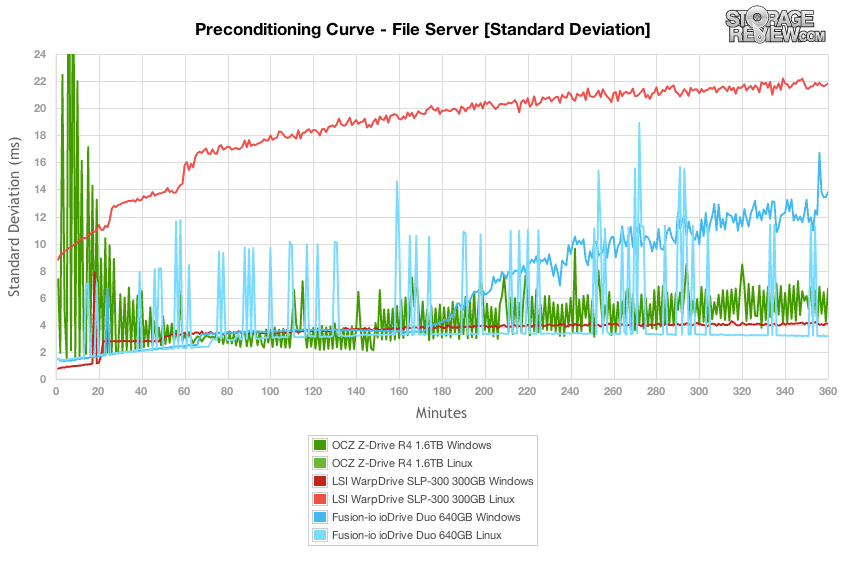

Al examinar la desviación estándar de los dispositivos ejecutados a través de nuestra prueba de preacondicionamiento del servidor de archivos, la diferencia más sorprendente se encontró con LSI WarpDrive, donde su tiempo de respuesta de E/S de Linux aumentó significativamente durante la prueba en comparación con su rendimiento de Windows. El ioDrive Duo experimentó un cambio similar cuando la unidad alcanzó el estado estable, donde ambas rutas divergieron y la capacidad de respuesta de Windows se volvió menos agrupada. En general, la unidad con el mejor desempeño en esta sección fue LSI WarpDrive bajo Windows, donde mantuvo la curva de desviación estándar más plana durante toda la prueba.

Una vez que nuestro proceso de preacondicionamiento finalizó con una carga alta de 16T/16Q, analizamos el rendimiento del servidor de archivos en una amplia gama de niveles de actividad. Fusion-io ioDrive Duo mantuvo el rendimiento más alto con un número bajo de subprocesos y colas, y solo fue superado por OCZ Z-Drive R4 en rendimiento con niveles de E/S sobresalientes más altos.

Al analizar la latencia promedio en nuestra prueba de carga variable, el Z-Drive R4 obtuvo los tiempos de respuesta más rápidos en promedio a medida que aumentaba la actividad en nuestra prueba. A medida que el nivel de cola pendiente aumentaba por número de subprocesos, la latencia de ioDrive Duo aumentó en su lado de Linux, aunque el controlador de Windows tuvo un rendimiento ligeramente inferior.

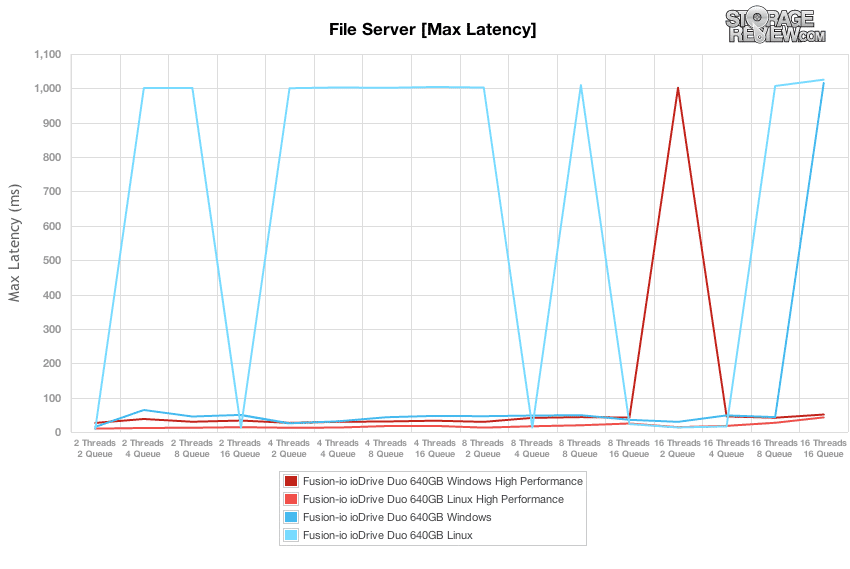

En cuanto a la latencia máxima durante la duración de nuestra prueba de servidor de archivos principal, ioDrive en Linux aún mostró sus picos más altos de 1,000 ms en niveles de conteo de subprocesos/colas altos y bajos. Sin embargo, su contraparte de Windows ofreció los tiempos de respuesta máximos consistentes más bajos, hasta la carga de trabajo 16T/16Q.

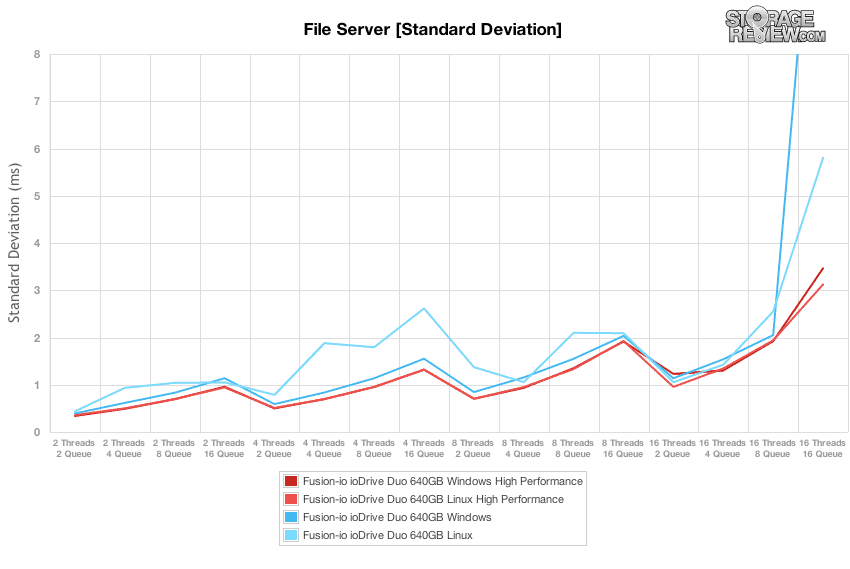

El perfil de desviación estándar del servidor de archivos de ioDrive Duo y WarpDrive permaneció bastante ajustado tanto en Windows como en Linux hasta las profundidades de cola efectivas más altas. En el caso del ioDrive Duo, el controlador de Linux mantuvo una mejor compostura en el nivel 16T/16Q, donde el rendimiento de Windows se dispersó.

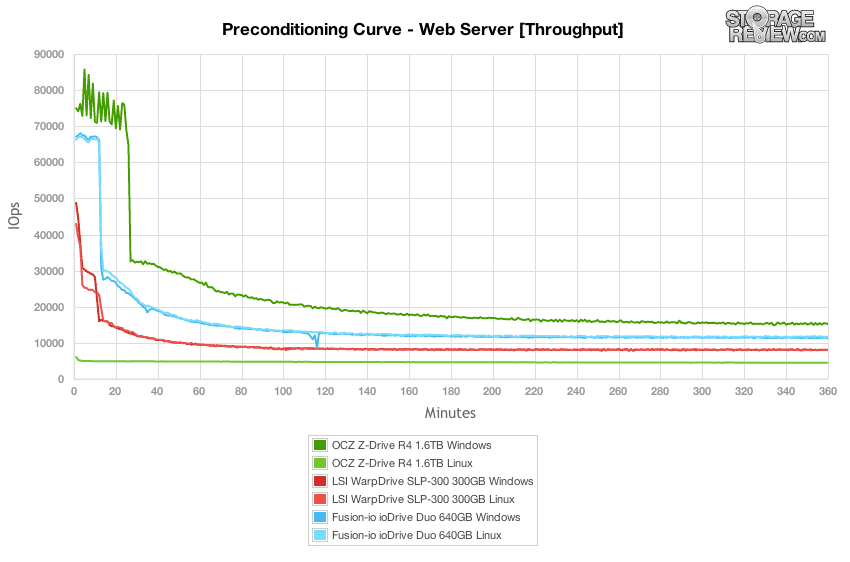

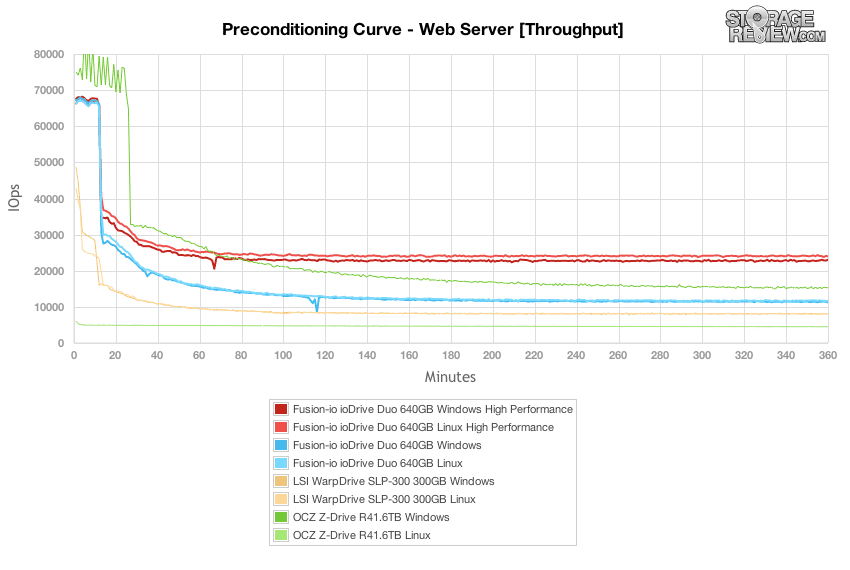

Nuestra última carga de trabajo es bastante única en la forma en que analizamos la fase de preacondicionamiento de la versión de prueba del resultado principal. Como carga de trabajo diseñada con una actividad de lectura del 100 %, es difícil mostrar el verdadero rendimiento de lectura de cada dispositivo sin un paso de acondicionamiento previo adecuado. Para mantener la carga de trabajo de acondicionamiento igual que la carga de trabajo de prueba, invertimos el patrón para que sea 100 % de escritura. Por esta razón, los gráficos de preacondicionamiento son mucho más dramáticos que los números finales de carga de trabajo. En estas duras condiciones, el OCZ Z-Drive R4 mantuvo el rendimiento más alto de ráfaga a estado estable, seguido por ioDrive Duo y tercero por WarpDrive.

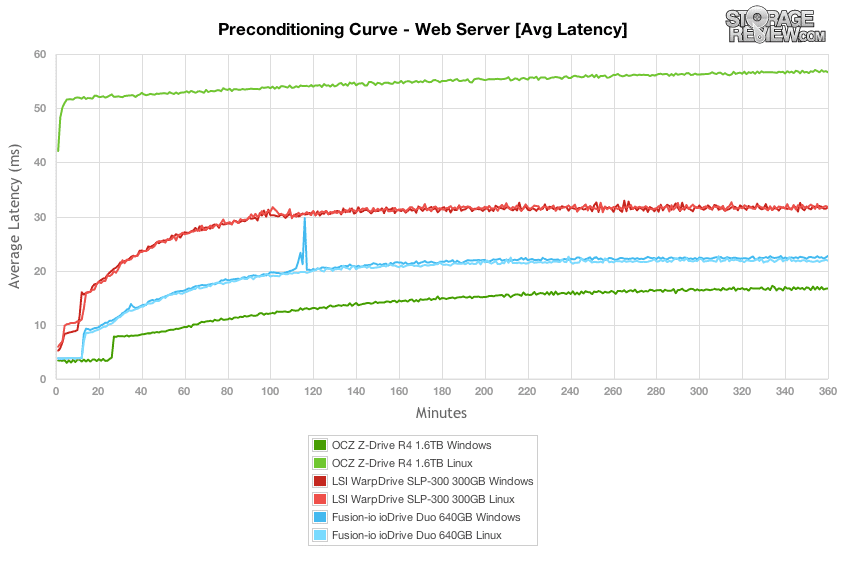

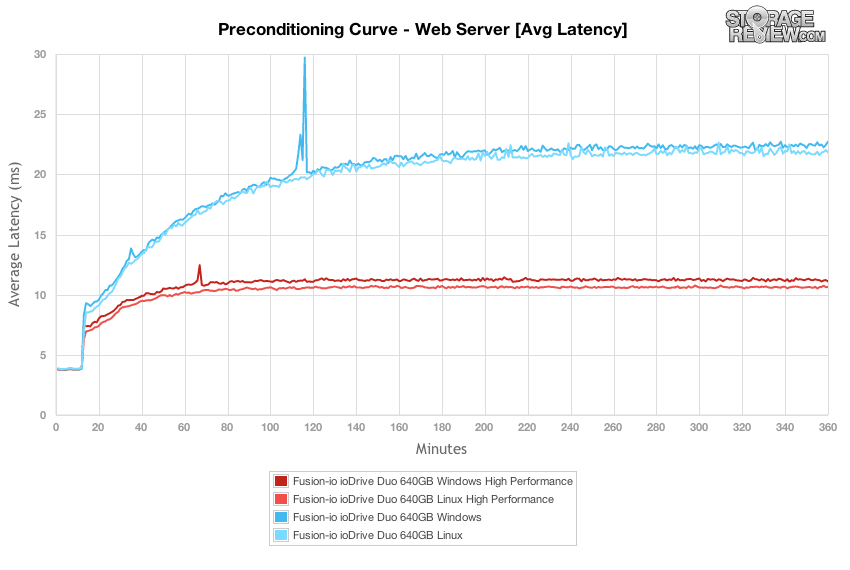

La latencia promedio durante el proceso de preacondicionamiento del servidor web de 100 % de escritura mostró que ioDrive Duo en Linux tenía la ventaja con tiempos de respuesta ligeramente más bajos que el conjunto de controladores de Windows. El LSI WarpDrive mostró prácticamente el mismo tiempo de respuesta promedio, mientras que el Z-Drive R4 tuvo una gran diferencia entre el rendimiento de Windows y Linux.

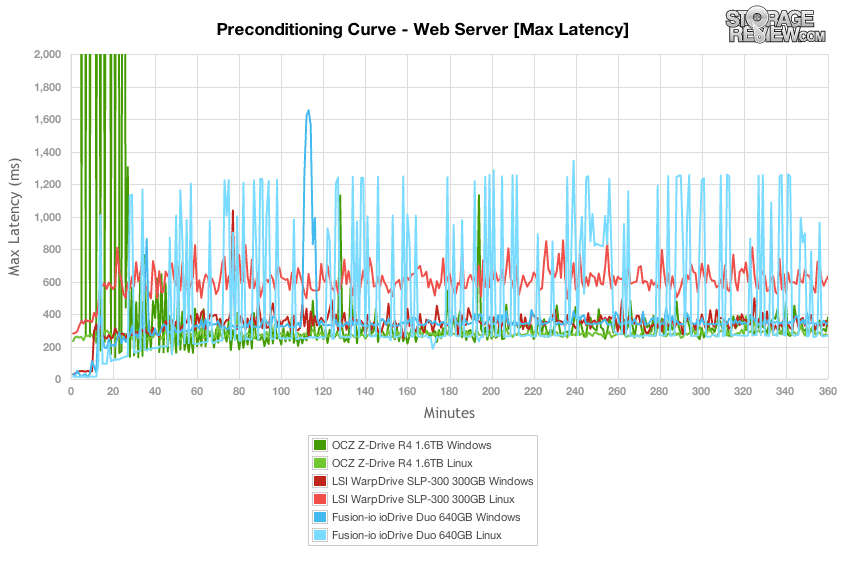

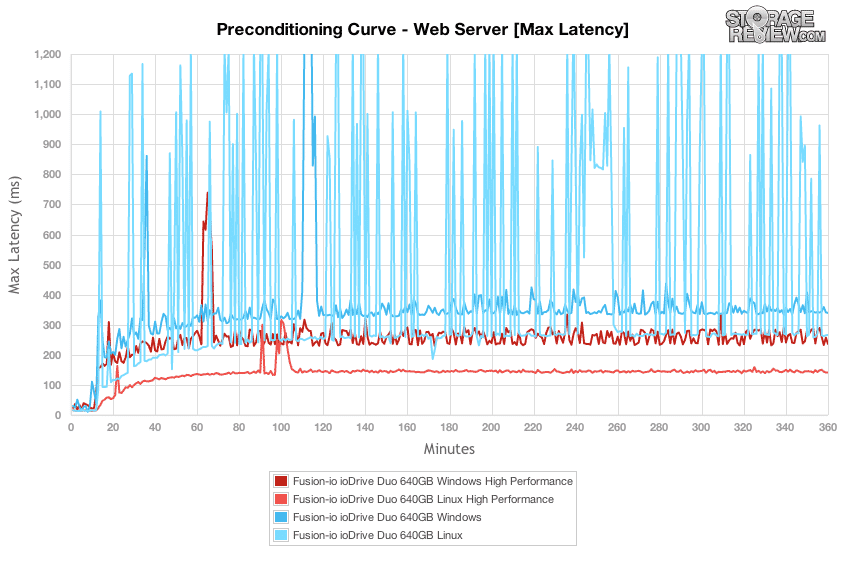

En cuanto a la latencia máxima en la curva de preacondicionamiento del servidor web, el Z-Drive R4 tuvo los picos más altos, pero una vez que se estabilizó, mantuvo una menor cantidad de picos de alta latencia. En cuanto al ioDrive Duo, si bien su rendimiento de Linux tuvo la ventaja en rendimiento y tiempos de respuesta promedio, tuvo algunos de los picos más altos en esta prueba, superando los 1,200 ms, mientras que el controlador de Windows fue mucho más tranquilo con sus picos generalmente en el Rango de 300 a 400 ms (excepto por un pico grande de más de 1,600 ms).

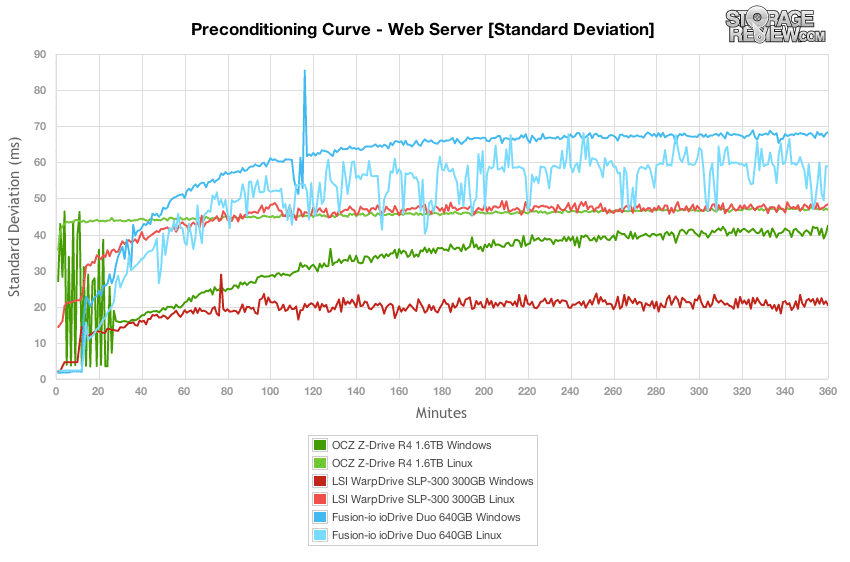

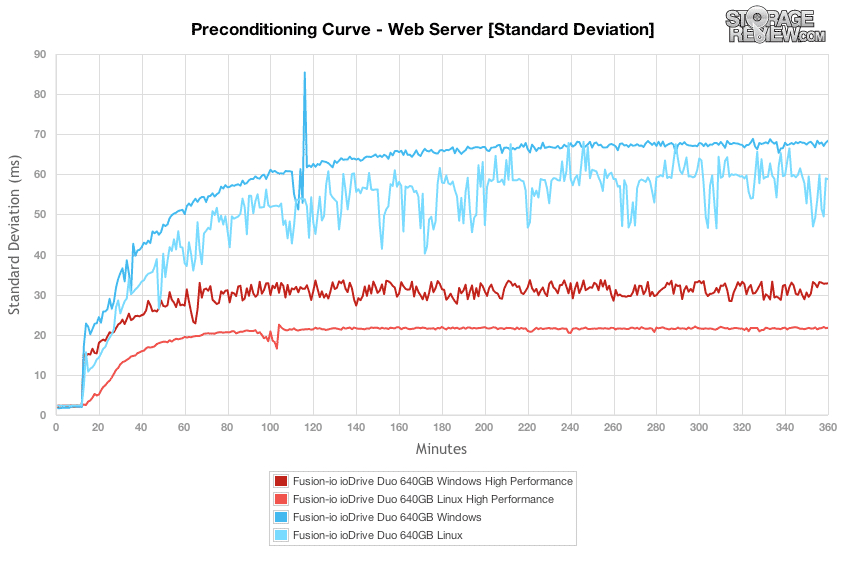

El LSI WarpDrive basado en SLC mantuvo el perfil de desviación estándar más bajo durante el proceso de preacondicionamiento del servidor web en Windows, seguido por el Z-Drive R4 una vez que se calmó, seguido nuevamente por el WarpDrive con su controlador de Linux y luego por el ioDrive Duo en Linux y luego en Windows.

Al volver a una carga de trabajo de servidor web de lectura del 100 % después del proceso de preacondicionamiento, el OCZ Z-Drive R4 definitivamente ofreció el rendimiento más alto dentro de un rendimiento de Windows, con más del doble de la velocidad de rendimiento en su punto más alto. Al mismo tiempo, se contrastó con su rendimiento en Linux, que fue más lento en los mismos puntos en que ofreció el mayor rendimiento en Windows. Con las cargas de trabajo más pequeñas, ioDrive Duo apareció nuevamente con las velocidades más rápidas, aunque Z-Drive R4 lo superó rápidamente una vez que aumentó la profundidad efectiva de la cola.

Tanto el ioDrive Duo como el WarpDrive permanecieron juntos en la prueba de latencia promedio del servidor web, aunque ambos fueron superados fácilmente por el R4 en Windows.

Fue algo sorprendente ver que algunos de los picos de latencia más altos en el rango de 1,000 ms permanecieron en la prueba del servidor web de lectura intensiva, aunque aunque el comportamiento se ve más en ioDrive Duo en Linux, se notó en los tres dispositivos en diferentes puntos de la prueba.

El gráfico de desviación estándar de la actividad del servidor web mostró que ioDrive Duo tiene tiempos de respuesta consistentemente más altos a tasas de profundidad de cola más altas, con un pico de 16T/16Q. Esto fue mientras el rendimiento de Windows se mantuvo ajustado hasta las cargas de trabajo más altas. El LSI WarpDrive mantuvo un perfil bastante plano, hasta el final en el lado de Linux, donde la latencia comenzó el aleteo.

Análisis de carga de trabajo sintético empresarial (modo de alto rendimiento)

De los tres aceleradores de aplicaciones PCIe de esta revisión, solo Fusion-io ioDrive Duo ofrece un método para cambiar el tamaño del sector o el espacio formateado visible para el usuario para un mayor rendimiento. Si bien es posible particionar parte del disco y no usarlo con los otros productos, ese proceso no es tan intuitivo. Algunos ni siquiera son conscientes de las implicaciones de cambiar la capacidad por una mejora del rendimiento.

Si bien la mayor parte de esta revisión se centró en las capacidades de stock de ioDrive Duo, la parte restante revisa nuestro nuevo Análisis de carga de trabajo sintético para ver cómo el rendimiento difiere entre el modo de alto rendimiento y la configuración de stock. Con un tamaño de stock de 320 GB por dispositivo, ioDrive Duo tiene un nivel de sobreaprovisionamiento del 20 % entre RAW NAND y visible para el usuario. Formatear el ioDrive Duo al modo de alto rendimiento reduce esa capacidad a 256 GB, o un 36 % de sobreaprovisionamiento, lo que reduce la capacidad total de 640 GB a 512 GB. Si bien intercambia una buena cantidad de capacidad disponible, nos sorprendió cuánto afectaría el rendimiento de estado estable. En algunos casos, vimos un rendimiento de más del doble.

Con el ioDrive Duo puesto en modo de alto rendimiento, las velocidades de ráfaga de escritura al 4 % de 100K se mantuvieron aproximadamente iguales en ~257k IOPS, pero la diferencia en el rendimiento de estado estable es dramática. Mientras que el ioDrive Duo en la configuración original mantuvo velocidades de rendimiento de 41-42k IOPS hacia el final de la fase de preacondicionamiento, el modo de alto rendimiento elevó los niveles a alrededor de 90,000 2 IOPS. Eso es más que un salto XNUMXx al sacrificar algo de capacidad de usuario.

Yendo de la mano con un rendimiento más rápido, la latencia también se redujo a la mitad en la etapa de preacondicionamiento de escritura 4K.

Al observar el perfil de latencia máxima de la prueba de preacondicionamiento de escritura 4K, se mantuvieron muchas de las mismas características, aunque esta vez mucho más bajas. La latencia de Windows 4K era un poco más alta originalmente, aunque tenía menos picos de alta latencia que los que se observaron en el entorno de Linux. Cuando la unidad se formateó en modo de alto rendimiento, el perfil de Windows todavía tenía más inestabilidad, pero el perfil de Linux tenía mejor compostura y carecía de los picos de alta latencia vistos anteriormente.

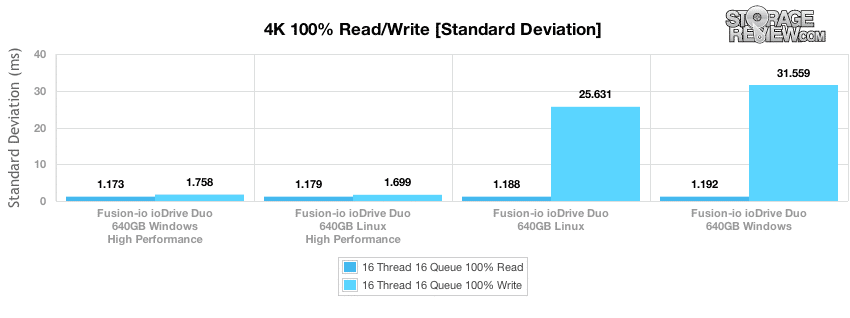

El gráfico más revelador que muestra la mejora espectacular de ioDrive Duo en modo de alto rendimiento es el perfil de desviación estándar de latencia. Con el aumento del espacio para la actividad del GC en segundo plano, bajo una carga de escritura completa de 4K al 100 %, la desviación estándar disminuyó de los 25-30 ms anteriores a los 2-5 ms.

Al comparar nuestros puntajes de lectura y escritura 4K 100 % de estado estable entre los modos estándar y de alto rendimiento, no vimos ningún aumento en el rendimiento de lectura. Esto no es tan poco común, ya que el aprovisionamiento excesivo generalmente solo mejora las velocidades de escritura de estado estable, sin afectar las velocidades de ráfaga de lectura o escritura. En este caso, el rendimiento de lectura 100 % 4K se mantuvo en poco más de 140,000 40.9 IOPS, con un rendimiento de escritura de estado estable que saltó de 42.6-90.4 K hasta 91-XNUMX K IOPS.

La mejora de la latencia de escritura 4K que observamos originalmente en la fase de preacondicionamiento promedió 2.80-2.82 ms en el modo de alto rendimiento ioDrive Duo, en comparación con 6-6.25 ms en el modo estándar.

Aunque no medimos una disminución notable en el tiempo de respuesta promedio de lectura de 4K o un aumento en el rendimiento, el ioDrive Duo configurado de alto rendimiento ofreció respuestas de lectura pico mucho más bajas. Los tiempos máximos de respuesta de escritura en 4K también se redujeron drásticamente.

La diferencia en la desviación estándar entre los dos modos de aprovisionamiento excesivo fue la noche y el día, con el ioDrive Duo de alto rendimiento midiendo 1.70-1.76 ms frente a los 25.6-31.6 ms anteriores.

Si bien el aumento del rendimiento en escritura aleatoria de 4K fue impresionante, estábamos más interesados en ver cómo cambiaría ioDrive Duo en una carga de trabajo mixta con actividad de lectura en la mezcla. En nuestra prueba de preacondicionamiento 8K 70/30, el rendimiento aumentó significativamente, desde el rango de 51-53k IOPS antes de aproximadamente 76K IOPS en el modo de alto rendimiento. Las velocidades de ráfaga fueron bastante similares entre las configuraciones de formateo, aunque el ioDrive Duo sobreaprovisionado comenzó a caer en estado estable más rápido.

En cuanto a la latencia en nuestra carga de trabajo 8K 70/30, las diferencias moderadas entre el controlador de Linux y Windows en el ioDrive Duo en modo de alto rendimiento se han ido. La latencia promedio se redujo significativamente y se mantuvo muy constante durante el proceso de preacondicionamiento.

Si bien las mejoras en el rendimiento y la latencia promedio son importantes, la latencia máxima es otro factor al que se debe prestar atención al cambiar la configuración de ioDrive Duo. En este caso, el espacio adicional sobreaprovisionado le dio a la unidad suficiente espacio en segundo plano para suprimir la mayoría de los saltos de latencia máxima que vimos en la configuración de picos. Dicho esto, no se habían ido por completo, pero la mayor parte de la actividad se redujo a niveles mucho más bajos.

Al observar la desviación estándar de la latencia, puede ver la imagen completa de cuán grande es el impacto que puede tener el ioDrive Duo con un espacio adicional de aprovisionamiento excesivo. La desviación estándar se redujo en un factor de 5, manteniéndose alrededor de 2 ms durante todo el proceso de preacondicionamiento, frente a los 8-12 ms anteriores.

El ioDrive Duo continuó mostrando beneficios de rendimiento en todos los ámbitos en nuestras principales pruebas de rendimiento en las que variamos la carga entre 2T/2Q y 16T/16Q.

Al observar las diferencias de latencia promedio en nuestra carga de trabajo 8K 70/30 comparando el stock de ioDrive Duo con los modos de alto rendimiento, la diferencia fue más notable en las profundidades de cola más altas en cada recuento de subprocesos.

Como vimos en la etapa de latencia máxima de la prueba de preacondicionamiento 8K 70/30, muchos de los mismos picos altos se mantuvieron durante la duración de la prueba, aunque hubo menos.

Al comparar la desviación estándar de la latencia en todos los ámbitos, el sobreaprovisionamiento tuvo un mayor impacto en algunas cargas de mayor profundidad de cola, mientras que áreas como 8T/16Q no experimentaron ningún cambio.

El Fusion ioDrive Duo no experimentó una gran mejora en el rendimiento total al aumentar la cantidad de aprovisionamiento excesivo. El rendimiento siguió aumentando, aunque el aumento fue modesto, en comparación con el salto espectacular encontrado en la escritura 100 % 4K o la carga de trabajo 8K 70/30 %.

La latencia promedio durante la duración de la prueba de preacondicionamiento del servidor de archivos mejoró de aproximadamente 7-7.5 ms a poco más de 6 ms a medida que ioDrive Duo se acercaba al rendimiento de estado estable.

Aunque Fusion ioDrive Duo no experimentó una mejora espectacular en el rendimiento o la latencia promedio, pudo suprimir muchos de los picos de alta latencia que se encuentran en la configuración de aprovisionamiento excesivo. La mayor mejora se produjo con el controlador de Windows, que mantuvo un límite máximo de latencia de alrededor de 50-75 ms en estado estable frente al rango anterior de 225-250 ms.

Al analizar la desviación estándar de la latencia en la prueba de preacondicionamiento del servidor de archivos, el aumento del sobreaprovisionamiento mantuvo el aleteo al mínimo una vez que la unidad se acercó al estado estable. La desviación estándar de la latencia de Linux no mejoró mucho, pero la desviación estándar de Windows se redujo de 12 a 14 ms a poco menos de 3 ms.

El aumento del aprovisionamiento excesivo de Fusion ioDrive Duo permitió que la tarjeta aumentara su rendimiento en aproximadamente 5,000 IOPS en la mayoría de las combinaciones de subprocesos y profundidad de cola, con el mayor aumento en cargas de mayor profundidad de cola.

La latencia mejoró en ambas áreas, con Fusin ioDrive Duo en Windows obteniendo la mayor mejora en la carga 16T/16Q, pasando de la más lenta a la más rápida.

Al comparar la latencia máxima en la carga de trabajo del servidor de archivos, ioDrive Duo se calmó mucho en Linux, perdiendo muchos de sus picos de 1,000 ms anteriores. Esta vez solo tuvo un pico de 1,000 ms en la prueba de Windows.

La desviación estándar en todos los ámbitos se redujo bastante, lo que muestra cuánto se calmó ioDrive Duo con el aumento de la sobreaprovisionamiento.

Si bien nuestra curva de preacondicionamiento del servidor web no es la mejor representación de la actividad del servidor web, de hecho, es lo opuesto al 100% de escritura, aún muestra el impacto que puede tener el aumento del sobreaprovisionamiento. El rendimiento total aumentó bastante, superando incluso al OCZ Z-Drive R4.

La latencia promedio durante la duración de nuestra prueba de preacondicionamiento del servidor web se redujo a la mitad, de más de 20 ms anteriormente, a poco más de 10 ms en el modo de alto rendimiento.

Casi todos los picos de alta latencia se suprimieron con un mayor aprovisionamiento excesivo, y el rendimiento de Linux fue el que más mejoró.

La desviación estándar de la latencia mejoró drásticamente durante la duración de la sección de preacondicionamiento del servidor web, con el mayor cambio en el lado de Linux con la curva casi plana en comparación con el rendimiento de las acciones.

Al volver a cambiar el perfil del servidor web al 100 % de lectura, vimos poca o ninguna mejora en la velocidad de rendimiento entre stock y un mayor aprovisionamiento excesivo en esta carga de trabajo en particular. Sin embargo, esto no es sorprendente, ya que el aprovisionamiento excesivo realmente solo beneficia el rendimiento relacionado con la escritura.

La latencia promedio fue casi idéntica en todos los ámbitos, mostrando pocos signos de mejora con un sobreaprovisionamiento adicional.

Si bien el rendimiento y la latencia promedio no mejoraron, los tiempos de respuesta de latencia alta desaparecieron por completo en este perfil de servidor web de lectura del 100 % cuando se aumentaron los niveles de aprovisionamiento excesivo.

De manera similar a la disminución de la latencia máxima en nuestro perfil de servidor web con ioDrive Duo en modo de alto rendimiento, la desviación estándar de la latencia también se redujo en gran medida en nuestra prueba de Linux, mientras que la prueba de Windows experimentó mejoras mínimas.

Conclusión

Al echar un vistazo renovado al ioDrive Duo, hay varias cosas que se destacan. Dado que Fusion-io fue uno de los primeros pioneros de esta iteración particular de la tecnología de almacenamiento y posee varias piezas de propiedad intelectual clave en torno al almacenamiento, no debería sorprender que el paquete general sea tan ajustado, pero el nivel de precisión es digno de crédito. Eso no es solo precisión en términos de rendimiento, que incluso como tecnología de generación anterior, lo hace bien. Pero precisión en términos de la sensación pulida en todas partes, desde el empaque hasta la interfaz del software y el rendimiento constante en muchas de sus plataformas compatibles, incluidas las versiones de Windows y Linux que probamos. Si bien el software ioDrive Duo actual ha sido actualizado varias veces desde su lanzamiento inicial, teniendo en cuenta que la unidad salió a principios de 2009, muestra muy poca antigüedad.

Para una unidad basada en MLC, el ioDrive Duo se mantiene muy bien frente al LSI WarpDrive basado en SLC, que podría considerarse su competidor más cercano. Como productos diseñados directamente para el segmento de aceleración de aplicaciones empresariales, ambos modelos se destacan con cargas de trabajo pesadas en múltiples plataformas de sistemas operativos. En casi todas las pruebas, el ioDrive Duo ofreció un rendimiento constante, aunque en términos de latencia máxima, el WarpDrive con su SLC-NAND obtuvo mejores resultados que nuestro ioDrive Duo de 640 GB equipado con MLC. Al compararlo con el OCZ Z-Drive R4 basado en MLC, fue fácil ver cómo ambos productos están diseñados para mercados claramente diferentes. El Z-Drive ofrecía alta velocidad y alta capacidad gracias a los controladores NAND de grado de consumo de menor costo y de nueva generación, pero su latencia máxima y desviación estándar eran más inconsistentes que el ioDrive Duo o WarpDrive. Los puntos fuertes de Z-Drives estaban más en el lado de lectura intensa, mientras que ioDrive Duo y WarpDrive encontraron su lugar en un entorno de escritura intensa. Para las implementaciones fuera de Windows, donde ioDrive Duo y WarpDrive ofrecieron un rendimiento similar en Linux, el rendimiento de Z-Drive R4 contrastó marcadamente con los puntajes de Windows, mostrando un rendimiento exponencialmente más lento en todo momento.

Por supuesto, el ioDrive Duo con capacidad de stock no está exento de debilidades, como se ve en sus frecuentes parpadeos de 1,000 ms en pruebas de profundidad de cola baja y alta cuando está en estado estable. Sin embargo, dada la desviación estándar constante, muchas de esas irregularidades fueron eventos breves, en lugar de alcanzar tasas de respuesta más altas de manera constante. Se puede encontrar otra área menor de preocupación dependiendo de la plataforma, ya que Linux tiende a ser el punto fuerte de este producto, incluso si solo supera ligeramente el rendimiento de Windows. Sin embargo, al final del día, estos problemas de latencia probablemente no aparecerían en el ioDrive Duo basado en SLC, que podría verse como un competidor más cercano al LSI WarpDrive, que solo está disponible en una configuración SLC de 300 GB.

Cuando probamos el ioDrive Duo en su modo de alto rendimiento, que redujo la capacidad formateada de 256 GB a 320 GB por ioDimm, el rendimiento se duplicó con creces en algunos casos. El rendimiento de escritura aleatoria de 4K se disparó de 40,000 90,000 IOPS a XNUMX XNUMX IOPS y, al mismo tiempo, la latencia máxima cayó como una roca. Para los usuarios empresariales que deseen intercambiar capacidad en nombre de la velocidad y la baja latencia, Fusion-io ofrece una manera fácil para que el usuario final realice esos cambios. Ninguna de las soluciones PCIe de la competencia ofrece ese tipo de configuración de rendimiento a menos que esté dispuesto a particionar manualmente el espacio del usuario y dejar una sección sin usar, lo que podría no ser factible en todas las aplicaciones.

Ventajas

- La integración más estrecha de software y hardware de cualquier proveedor de Acelerador de aplicaciones PCIe

- La paridad de rendimiento más cercana entre los controladores de Windows y Linux

- Gran rendimiento y latencia en modo stock que mejora aún más en modo de alto rendimiento

- Sólido rendimiento de baja cola/bajo recuento de subprocesos

Contras

- La instalación y la configuración inicial pueden ser más difíciles que otras soluciones (se requiere alimentación externa, no es compatible con el controlador del sistema operativo integrado)

- Necesita más recursos del sistema con espacio VSL utilizado para presentar el ioDrive como un nivel de memoria

Resumen Final

Desde una perspectiva de facilidad de uso, ioDrive Duo establece el estándar sobre cómo se debe presentar un Acelerador de aplicaciones PCIe al usuario final. Independientemente del sistema operativo utilizado, la experiencia es casi idéntica, hasta las herramientas de administración de la consola y la GUI suministradas. Desde el primer día, el usuario puede sentarse, independientemente del sistema operativo, y obtener el estado del hardware de ioDrive Duo, formatearlo o aprovisionarlo en exceso a su gusto y ponerlo en producción. El ioDrive Duo es una oferta completa que es más refinada que cualquier otra cosa en el mercado de almacenamiento empresarial.

Página del producto Fusion-io Duo

Actualizar 8/17/12 - Nuestra Revisión de LSI Nytro WarpDrive se ha publicado y agregado a los gráficos utilizados en esta revisión de Fusion-io.