Arista Networks hat eine bahnbrechende Technologiedemonstration zur Schaffung von KI-Rechenzentren angekündigt, die Rechen- und Netzwerkdomänen in einer einzigen, verwalteten KI-Einheit zusammenführen.

Arista Networks hat eine bahnbrechende Technologiedemonstration zur Schaffung von KI-Rechenzentren angekündigt, die Rechen- und Netzwerkdomänen in einer einzigen, verwalteten KI-Einheit zusammenführen. Diese in Zusammenarbeit mit NVIDIA durchgeführte Initiative zielt darauf ab, optimale generative KI-Netzwerke aufzubauen, die kürzere Auftragsabschlusszeiten bieten, indem sie es Kunden ermöglichen, KI-Cluster über kritische Komponenten, einschließlich Netzwerke, NICs und Server hinweg, einheitlich zu konfigurieren, zu verwalten und zu überwachen.

Einheitliches Management für KI-Cluster

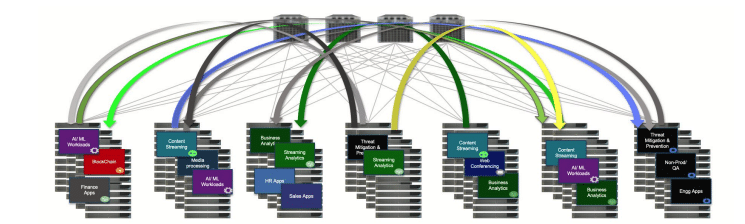

Da KI-Cluster und große Sprachmodelle (LLMs) weiter wachsen, nehmen auch die Komplexität und die Anzahl der beteiligten Komponenten deutlich zu. Zu diesen Komponenten gehören GPUs, NICs, Switches, Optik und Kabel, die zusammenhängend funktionieren müssen, um ein umfassendes Netzwerk zu bilden. Einheitliche Kontrollen stellen sicher, dass KI-Server, die NICs und GPUs hosten, über verschiedene Ebenen hinweg mit KI-Netzwerk-Switches synchronisiert sind. Ohne diese Ausrichtung besteht das Risiko einer Fehlkonfiguration oder Fehlausrichtung, insbesondere zwischen NICs und den Netzwerk-Switches, was aufgrund schwer zu diagnostizierender Netzwerkprobleme die Auftragsabwicklung erheblich beeinträchtigen kann.

Koordiniertes Staumanagement

Große KI-Cluster erfordern ein synchronisiertes Überlastungsmanagement, um Paketverluste und eine Unterauslastung der GPUs zu verhindern. Zur Optimierung der Rechen- und Netzwerkressourcen sind außerdem koordinierte, gleichzeitige Verwaltung und Überwachung erforderlich. Das Herzstück der Lösung von Arista ist ein EOS-basierter Agent, der die Kommunikation zwischen dem Netzwerk und dem Host ermöglicht und Konfigurationen zur Optimierung von KI-Clustern koordiniert.

Remote-KI-Agent für verbesserte Kontrolle

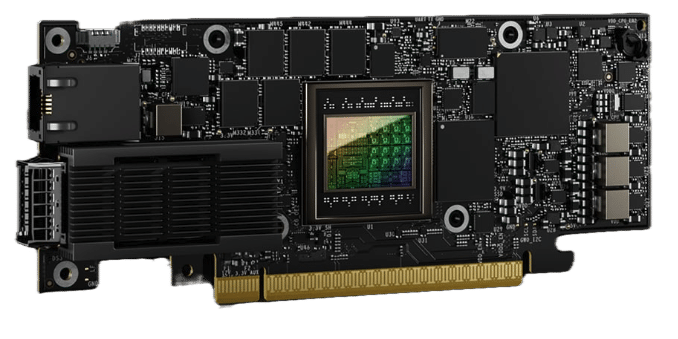

Das auf Arista-Switches ausgeführte Arista EOS kann über einen Remote-KI-Agenten auf direkt angeschlossene Netzwerkkarten und Server erweitert werden. Dies ermöglicht einen zentralen Kontroll- und Sichtbarkeitspunkt im gesamten KI-Rechenzentrum und schafft so eine einheitliche Lösung. Der Remote-KI-Agent, der auf einer NVIDIA BlueField-3 SuperNIC gehostet wird oder auf dem Server läuft und Telemetriedaten von der SuperNIC sammelt, ermöglicht es EOS auf dem Netzwerk-Switch, Netzwerkprobleme auf dem Server zu konfigurieren, zu überwachen und zu debuggen. Dadurch wird eine durchgängige Netzwerkkonfiguration und QoS-Konsistenz (Quality of Service) sichergestellt, sodass KI-Cluster als zusammenhängende Lösung verwaltet und optimiert werden können.

John McCool, Chief Platform Officer von Arista Networks, erklärte: „Arista zielt darauf ab, die Effizienz der Kommunikation zwischen dem erkannten Netzwerk und der GPU-Topologie zu verbessern, um die Auftragsabwicklungszeiten durch koordinierte Orchestrierung, Konfiguration, Validierung und Überwachung von NVIDIA-Accelerated-Compute-NVIDIA-SuperNICs zu verkürzen.“ , und Arista-Netzwerkinfrastruktur.“

Diese neue Technologie verdeutlicht, wie ein auf Arista EOS basierender Remote-KI-Agent die Verwaltung eines integrierten KI-Clusters als eine einzige Lösung ermöglicht. Durch die Ausweitung der EOS-Funktionen auf Server und SuperNICs über Remote-KI-Agenten gewährleistet Arista die kontinuierliche Verfolgung und Meldung von Leistungsproblemen oder Ausfällen zwischen Hosts und Netzwerken und ermöglicht so eine schnelle Isolierung und Minimierung von Auswirkungen. Die EOS-basierten Netzwerk-Switches sorgen für einen ständigen Überblick über die genaue Netzwerktopologie, und die Ausweitung von EOS auf SuperNICs und Server mit dem Remote-KI-Agenten verbessert die koordinierte Optimierung der End-to-End-QoS über alle Elemente im KI-Rechenzentrum hinweg und verkürzt so letztendlich die Auftragsabwicklungszeiten .

Als nächstes für Arista Networks

Arista Networks wird die KI-Agent-Technologie am 10. Juni anlässlich des 5-jährigen Jubiläums des Börsengangs von Arista an der NYSE vorstellen. Kundentests werden voraussichtlich in der zweiten Hälfte des Jahres 2024 beginnen. Diese Demonstration stellt einen bedeutenden Schritt auf dem Weg zu einer herstellerübergreifenden Interoperabilität dar Ökosystem, das eine nahtlose Kontrolle und Koordination zwischen KI-Netzwerken und KI-Recheninfrastruktur ermöglicht und so den wachsenden Anforderungen von KI- und LLM-Workloads gerecht wird.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed