Von George Teixeira, CEO und Präsident, DataCore-Software

Im Jahr 2012 ist der Begriff „Big Data“ in aller Munde, genau wie vor fünf Jahren die Virtualisierung. Ebenso wie bei Virtualisierung und Cloud Computing gibt es einen großen Hype, der die wichtigeren Diskussionen über IT-Herausforderungen, erforderliche Fähigkeiten und die Frage, wie man tatsächlich eine Infrastruktur aufbaut, die effektive Big-Data-Technologien unterstützen kann, verdeckt.

Als die Menschen über die Wunder der Virtualisierung schwärmten, übersahen sie die neuen Leistungsanforderungen und die enorme Steigerung der Speicherkapazität, die zur Unterstützung von Server- und Desktop-Initiativen erforderlich sind. Der Bedarf an höherer Leistung und kontinuierlicher Verfügbarkeit hatte einen hohen Preis, und offensichtlich verzögerten oder scheiterten viele Projekte aufgrund der budgetsprengenden Auswirkungen.

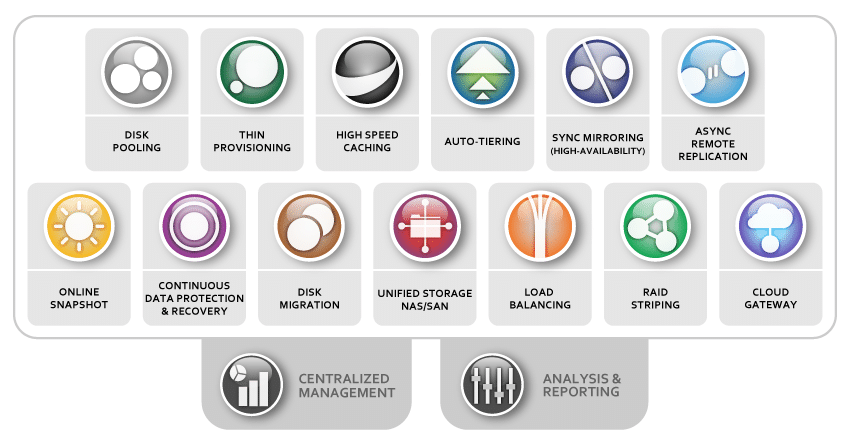

Diese Probleme werden nun durch die Einführung der Speichervirtualisierung gelöst, die Brancheninnovationen in Sachen Leistung nutzt, eine stärkere Kommerzialisierung teurer Geräte vorantreibt und die Speicherverwaltung mit neuen Technologien wie unternehmensweiter Auto-Tiering-Software automatisiert.

Dieselbe Dynamik ist wieder am Werk, nur dieses Mal mit Big Data.

Business-Intelligence-Unternehmen wollen Sie glauben machen, dass Sie ihre Analyseplattformen einfach auf ein Hadoop-Framework und BINGO aufsetzen – schon haben Sie eine Big-Data-Anwendung. Die Realität ist, dass Hadoop-Produktionsbereitstellungen in großen Unternehmen praktisch nicht existieren. Es gibt einfach nicht viele Menschen, die diese neuen Technologien verstehen und nutzen können. Darüber hinaus ist das Ökosystem der unterstützenden Technologien und Methoden noch zu unausgereift, was bedeutet, dass die Branche einen schmerzhaften Prozess des Versuchs und Irrtums durchläuft, genau wie vor fünf Jahren bei der Virtualisierung. Auch hier erweist sich die Unterschätzung des Speicherbedarfs als großes Hindernis für die Einführung, da die uralte Praxis, „das Problem mit Hardware zu lösen“, oft untragbare Kosten und Komplexität verursacht.

Um es ganz klar auszudrücken: Big Data erfordert nicht einfach nur großen Speicher – es erfordert großen, intelligenten Speicher. Leider droht die Branche, große Fehler der Vergangenheit zu wiederholen!

Bevor ich mich der Technologie zuwende, möchte ich auf die größte Herausforderung beim Eintritt in die Welt von Big Data hinweisen: Wir müssen die Leute entwickeln, die nützliche Big-Data-Systeme vorantreiben und implementieren. Ein aktueller Forbes-Artikel wies darauf hin, dass unsere Schulen mit den Bildungsanforderungen, die Big Data mit sich bringt, nicht Schritt gehalten haben. Meiner Meinung nach bringt die folgende Passage das Problem gut auf den Punkt: „Wir stehen vor einem enormen Mangel an Menschen, die nicht nur mit Big Data umgehen können, sondern, was noch wichtiger ist, über das Wissen und die Fähigkeiten verfügen, um aus Daten einen Mehrwert zu generieren – um mit dem ununterbrochenen Tsunami fertig zu werden.“ Wie aggregiert und filtert man Daten, wie präsentiert man die Daten, wie analysiert man sie, um Erkenntnisse zu gewinnen, wie nutzt man die Erkenntnisse, um die Entscheidungsfindung zu unterstützen, und wie integriert man diese dann aus Branchensicht in Ihr Geschäftsprozess?“

Nun zurück zu den Produkttechnologien, die einen Unterschied machen werden – insbesondere denen im Zusammenhang mit der Speicherverwaltung für dieses neue Paradigma.

Wie wir alle wissen, hat das Datenwachstum explosionsartig zugenommen, und herkömmliche Ansätze zur Skalierung von Speicherung und Verarbeitung stoßen an rechnerische, betriebliche und wirtschaftliche Grenzen. Um die Leistungs- und Verfügbarkeitsanforderungen schnell wachsender Datensätze intelligent zu verwalten und zu erfüllen, ist ein neuer Ansatz erforderlich. Noch vor wenigen Jahren war es für Unternehmen praktisch unbekannt, über eine Skalierung über mehrere hundert Terabyte hinaus zu sprechen, heute geht es in der Diskussion um mehrere Petabyte. Auch in der Vergangenheit entschieden sich Unternehmen dafür, einen großen Teil ihrer Inhalte auf Band zu archivieren. In der heutigen On-Demand- und Social-Media-zentrierten Welt ist dies jedoch nicht mehr machbar. Benutzer fordern jetzt sofortigen Zugriff und tolerieren keine Verzögerungen bei der Wiederherstellung von Daten aus langsamen und/oder entfernten Bandspeichern.

Sofortige Befriedigung ist angesagt und Leistung ist entscheidend.

Neue Speichersysteme müssen Daten automatisch und unterbrechungsfrei von einer Generation eines Systems auf eine andere migrieren, um eine effektive Langzeitarchivierung zu ermöglichen. Zu diesem Problem kommt auch die Notwendigkeit hinzu, den Speicher auf mehrere Rechenzentren zu verteilen, entweder für die Notfallwiederherstellung oder um Inhalte näher an den anfragenden Benutzern zu platzieren, um die Latenz auf ein Minimum zu beschränken und die Antwortzeiten zu verbessern.

Dies ist besonders wichtig für die Leistung von Anwendungen, die für den täglichen Betrieb eines Unternehmens von entscheidender Bedeutung sind, wie z. B. Datenbanken, Unternehmensressourcenplanung und andere transaktionsorientierte Arbeitslasten. Zusätzlich zu den Daten, die diese ressourcenintensiven Anwendungen produzieren, müssen sich IT-Abteilungen mit der enormen Verbreitung neuer Medien wie Facebook und YouTube auseinandersetzen. Herkömmliche Speichersysteme eignen sich nicht gut zur Lösung dieser Probleme, so dass IT-Architekten kaum eine andere Wahl haben, als zu versuchen, selbst Lösungen zu entwickeln, oder mit komplexen, leistungsschwachen Systemen zu kämpfen haben.

Speichersysteme stellen in Big-Data- und Cloud-Umgebungen große Herausforderungen dar, da sie für den Einsatz auf immer größeren Speicher-Arrays konzipiert sind, die sich normalerweise an einem einzigen Standort befinden. Diese proprietären High-End-Systeme haben einen hohen Preis in Bezug auf Kapital- und Betriebskosten sowie Agilität und Anbieterbindung. Sie bieten unzureichende Mechanismen zur Schaffung eines gemeinsamen, zentral verwalteten Ressourcenpools. Dadurch muss ein IT-Architekt das Problem mit einer Vielzahl einzelner Speichersysteme lösen, die in der Regel aus unterschiedlichen Marken, Marken und Modellen bestehen und einen anderen Ansatz für die standortübergreifende Replikation und eine Form der benutzerdefinierten Verwaltung erfordern.

Vor diesem Hintergrund müssen vier große Probleme angegangen werden:

- Virtuelles Ressourcenmanagement und Flexibilität: Es bedarf intelligenter Software, um die aktuelle Landschaft monolithischer, unabhängiger Lösungen in einen virtuellen Speicherressourcenpool umzuwandeln, der die große Vielfalt der heute verfügbaren Speicherhardware und -geräte einbezieht und nutzt. Hohe Kapital- und Betriebskosten: Um die Betriebskosten zu senken, ist eine höhere Produktivität durch Automatisierung und zentralisierte Verwaltung unerlässlich. Genauso wichtig ist es für eine kosteneffektive Speicherskalierbarkeit, Unternehmen mit einer größeren Fähigkeit zur Kommerzialisierung und Ermöglichung der Hardware-Austauschbarkeit auszustatten. Niemand kann sich „großes Geld“ leisten, um einer Big-Data-Welt teurere „Big-Box“-Lösungen zuzuwerfen. Hypervisoren wie VMware und Microsoft Hyper-V haben den Benutzern Kaufkraft eröffnet. Heutzutage ist die Verwendung eines Dell-, HP-, IBM- oder Intel-Servers weitgehend eine persönliche Vorliebe eines Unternehmens. Derselbe Ansatz ist für die Speicherung erforderlich und hat den Bedarf an Hypervisoren erhöht.

- Skalierbarkeit erfordert Leistung und kontinuierliche Verfügbarkeit: Da der Datenspeicher wächst und mehr Anwendungen, Benutzer und Systeme gewartet werden müssen, steigt gleichzeitig der Bedarf an höherer Leistung und Verfügbarkeit. Es geht nicht mehr darum, wie viel in eine große Kiste passen kann, sondern darum, wie wir neue Technologien nutzen können, um die Speicherung schneller und reaktionsfähiger zu machen. Unabhängig davon, wie zuverlässig eine einzelne Speicherbox auch sein mag, ist sie nicht mit vielen Systemen zu vergleichen, die an verschiedenen Standorten zusammenarbeiten, um ein Höchstmaß an Geschäftskontinuität zu gewährleisten, unabhängig von der zugrunde liegenden Hardware.

- Dynamischer versus statischer Speicher: Es ist auch offensichtlich, dass wir nicht mehr mit der Optimierung von Unternehmensdaten für maximale Leistung und Kostenkompromisse Schritt halten können. Softwareautomatisierung ist jetzt von entscheidender Bedeutung. Technologien wie Thin-Provisioning, die mehrere Speichergeräte umfassen, sind für mehr Effizienz und eine bessere Nutzung der Speicherressourcen erforderlich. Leistungsstarke unternehmensweite Funktionen, die über eine Vielzahl von Speicherklassen und Gerätetypen hinweg funktionieren, werden zu einem Muss. Für die Migration von einer Speicherklasse zu einer anderen ist ein automatisiertes Speicher-Tiering erforderlich. Daher sind hochentwickelte Speicherhypervisoren von entscheidender Bedeutung, unabhängig davon, ob der Daten- und E/A-Verkehr am besten von dynamischen Hochgeschwindigkeits-RAM-Speichern, Solid-State-Laufwerken, Festplatten oder sogar Cloud-Speicheranbietern migriert wird.

Intensive Anwendungen benötigen jetzt ein Speichersystem, das klein anfangen kann, sich aber problemlos auf viele Petabyte skalieren lässt. Es muss eine Lösung sein, die Inhalte schnell bereitstellt und die täglich wachsende Arbeitsbelastung von Tausenden von Benutzern bewältigt. Es muss außerdem äußerst benutzerfreundlich sein, so weit wie möglich automatisiert sein und kein hohes Maß an Fachwissen für die Bereitstellung oder Optimierung erfordern. Am wichtigsten ist vielleicht, dass sich das Speicherparadigma von der Zementierung auf ein einzelnes Array oder einen einzelnen Standort hin zu einem verteilten und dennoch zentral verwalteten System ändern muss, das Inhalte aktiv speichern, abrufen und überall dort verteilen kann, wo sie benötigt werden. Die gute Nachricht ist, dass Speicherhypervisoren wie SANsymphony-V von DataCore eine benutzerfreundliche, skalierbare Lösung für den IT-Architekten bieten, der mit großen Datenmengen konfrontiert ist, die in einem modernen Unternehmen laufen.

Ja, Big Data bietet großes Potenzial. Stellen wir dieses Mal einfach sicher, dass wir den Speicher richtig einsetzen, um zu vermeiden, dass die großen Fehler der Vergangenheit wiederholt werden.

George Teixeira ist CEO und Präsident von DataCore-Software. Die Software-as-Infrastructure-Plattform des Unternehmens löst das große Problem, das Virtualisierungsinitiativen zum Stillstand bringt, indem sie speicherbezogene Barrieren beseitigt, die die Virtualisierung zu schwierig und zu teuer machen. Sie können den Autor unter kontaktieren [E-Mail geschützt] .