Microsoft hat während der Microsoft Ignite-Veranstaltung dieser Woche mehrere neue Entwicklungen im Bereich kundenspezifisches Chipdesign und KI-Infrastruktur vorgestellt, darunter auch die Erweiterung seines Silizium-Portfolios.

Microsoft hat auf der Ignite 2024 mehrere wichtige Entwicklungen im Bereich kundenspezifisches Chipdesign und KI-Infrastruktur angekündigt. Das Unternehmen erweitert sein Siliziumportfolio um neue Sicherheits- und Datenverarbeitungschips und baut gleichzeitig seine Partnerschaft mit NVIDIA für KI-Computing aus. Diese Updates zielen darauf ab, die Effizienz, Sicherheit und Leistung aller Cloud-Dienste von Microsoft zu verbessern.

Microsofts kundenspezifische Siliziumrevolution

Microsoft erweitert sein Portfolio an kundenspezifischen Siliziumchips deutlich über die Azure Maia-KI-Beschleuniger und Azure Cobalt-CPUs hinaus. Das Unternehmen hat das Azure Integrated HSM eingeführt, einen internen Sicherheitschip, der die Schlüsselverwaltung ohne Leistungseinbußen verbessern soll. Im Jahr 2025 wird Microsoft das HSM-Sicherheitsmodul in alle neuen Rechenzentrumsserver integrieren, um vertrauliche und allgemeine Workloads zu schützen.

Microsoft stellte außerdem Azure Boost DPU vor, seine erste Datenverarbeitungseinheit. Dieser Spezialchip bewältigt datenzentrierte Workloads mit außergewöhnlicher Effizienz. Neue Server mit dieser DPU werden den Stromverbrauch um zwei Drittel senken und eine viermal bessere Leistung als aktuelle Server bieten.

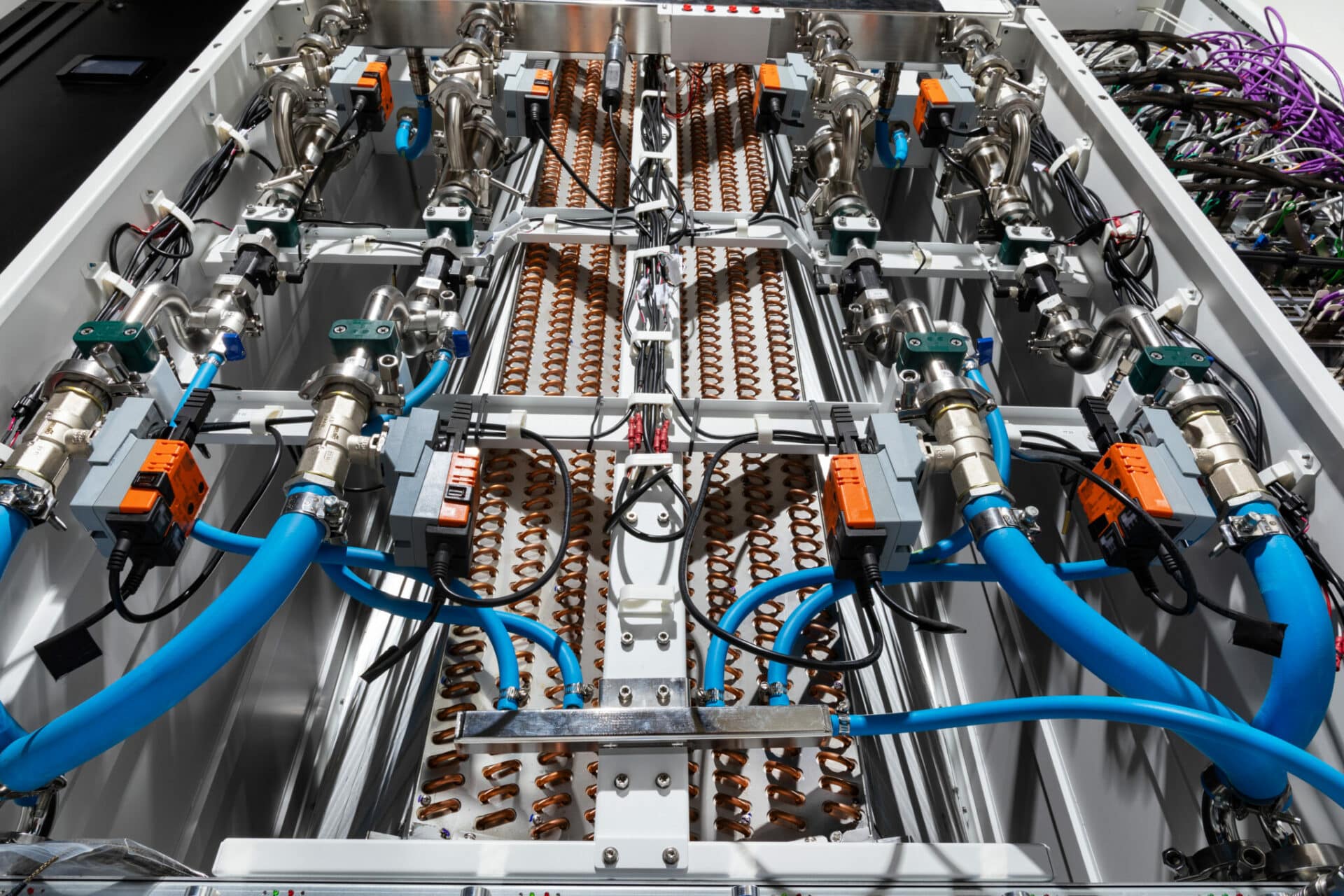

Kühl- und Stromversorgungsinfrastruktur

Microsoft hat sein „Sidekick“-Rack der nächsten Generation mit Flüssigkeitskühlung vorgestellt. Diese Wärmetauschereinheit kann in Azure-Rechenzentren nachgerüstet werden, um große KI-Systeme zu unterstützen, darunter die GB200-Infrastruktur von NVIDIA. Microsoft hat außerdem mit Meta an einem disaggregierten Power-Rack-Design mit 400-Volt-Gleichstrom zusammengearbeitet, das bis zu 35 % mehr KI-Beschleuniger in jedem Server-Rack ermöglicht.

Im Bestreben nach branchenweiter Weiterentwicklung macht Microsoft diese Spezifikationen für Kühlungs- und Stromversorgungsracks über das Open Compute Project als Open Source verfügbar, sodass die gesamte Branche von diesen Innovationen profitieren kann.

KI- und Computerinfrastruktur der nächsten Generation

Die KI-Infrastruktur von Azure entwickelt sich mit der Einführung der ND H200 V5 Virtual Machine-Serie mit NVIDIA H200-GPUs weiter. Die Plattform hat bemerkenswerte Leistungssteigerungen gezeigt und übertrifft den Branchen-Benchmarking-Standard mit NVIDIA H100- und H200-GPUs um den Faktor zwei.

Microsoft hat außerdem Azure ND GB200 v6 angekündigt, eine neue KI-optimierte VM-Serie, die das NVIDIA GB200 NVL 72 Rack-Scale-Design mit Quantum InfiniBand-Netzwerken enthält. Diese Weiterentwicklung ermöglicht KI-Supercomputing-Leistung im großen Maßstab und verbindet Zehntausende von Blackwell-GPUs.

Für CPU-basiertes Supercomputing versprechen die neuen virtuellen Azure HBv5-Maschinen, die von benutzerdefinierten AMD EPYC™ 9V64H-Prozessoren angetrieben werden, eine bis zu achtmal schnellere Leistung als aktuelle Alternativen und werden 2025 zur Vorschau verfügbar sein.

Azure Container Apps und NVIDIA-Integration

Azure Container Apps unterstützt jetzt NVIDIA-GPUs und ermöglicht so eine vereinfachte und skalierbare KI-Bereitstellung. Diese serverlose Containerplattform vereinfacht die Bereitstellung und Verwaltung von Microservices-basierten Anwendungen, indem sie die zugrunde liegende Infrastruktur abstrahiert. Dank sekundengenauer Abrechnung und Scale-to-Zero-Funktionen zahlen Kunden nur für die von ihnen genutzte Rechenleistung, was eine wirtschaftliche und effiziente Ressourcennutzung gewährleistet.

Die NVIDIA-KI-Plattform auf Azure umfasst neue Referenzworkflows für industrielle KI und NVIDIA Omniverse Blueprint zum Erstellen immersiver, KI-gestützter Visualisierungen. In Kürze ist ein Referenzworkflow für die 3D-Fernüberwachung industrieller Abläufe verfügbar, der es Entwicklern ermöglicht, physikalisch genaue 3D-Modelle industrieller Systeme mit Echtzeitdaten aus Azure IoT Operations und Power BI zu verbinden.

RTX-KI-PCs und Advanced Computing

NVIDIA hat seinen neuen multimodalen SLM NVIDIA Nemovision-4B Instruct angekündigt, der visuelle Bilder in der realen Welt und auf dem Bildschirm verstehen soll. Diese Technologie, die bald in RTX-KI-PCs und -Workstations eingeführt wird, wird digitale menschliche Interaktionen realistischer gestalten.

Updates für NVIDIA TensorRT Model Optimizer (ModelOpt) bieten Windows-Entwicklern jetzt einen verbesserten Weg, Modelle für die ONNX Runtime-Bereitstellung zu optimieren. Dadurch können Entwickler KI-Modelle für PCs erstellen, die schneller und genauer sind, wenn sie durch RTX-GPUs beschleunigt werden, und gleichzeitig die Bereitstellung im gesamten PC-Ökosystem mit ONNX-Runtimes vereinfachen.

Über 600 Windows-Apps und -Spiele führen KI lokal auf über 100 Millionen GeForce RTX AI-PCs weltweit aus und bieten eine schnelle, zuverlässige Leistung mit geringer Latenz. Die Zusammenarbeit zwischen NVIDIA und Microsoft treibt weiterhin Innovationen bei Personalcomputern voran und bringt anspruchsvolle KI-Funktionen in den Alltagsgebrauch.

Microsoft Cloud und Hybrid-Infrastruktur

Microsofts Engagement für Multi-Cloud- und Hybridlösungen wird durch Azure Arc veranschaulicht, das mittlerweile über 39,000 Kunden weltweit bedient. Das neue Azure Local bietet eine sichere, mit der Cloud verbundene Hybridinfrastruktur mit flexiblen Optionen, darunter GPU-Server für KI-Inferenz.

Microsoft hat außerdem Windows Server 2025 und SQL Server 2025 angekündigt, die Azure Arc nutzen, um Cloud-Funktionen in lokalen und Cloud-Umgebungen bereitzustellen. SQL Server 2025 zeichnet sich durch seine neuen integrierten KI-Funktionen aus, die die Entwicklung von KI-Anwendungen und RAG-Mustern mit Vektorunterstützung vereinfachen.

Fazit

Die jüngsten Innovationen von Microsoft unterstreichen das Engagement des Unternehmens, kundenspezifische Silizium-, KI-Infrastruktur- und Hybrid-Cloud-Lösungen voranzutreiben. Mit bahnbrechenden Entwicklungen wie dem Azure Integrated HSM und Azure Boost DPU setzt Microsoft neue Maßstäbe für den sicheren, effizienten und leistungsstarken Betrieb von Rechenzentren. Die Einführung von Kühl- und Stromversorgungstechnologien der nächsten Generation sowie Open-Sourcing-Innovationen unterstreichen das Engagement von Microsoft, die Zusammenarbeit und Nachhaltigkeit in der Branche zu fördern.

Die Entwicklung der KI- und Computerinfrastruktur von Azure, einschließlich der virtuellen Maschinen ND H200 V5 und ND GB200 v6, zeigt, dass Microsoft in der Lage ist, KI-Leistung in großem Maßstab bereitzustellen. Gleichzeitig versprechen die neuen virtuellen Maschinen HBv5 Leistung für CPU-basiertes Supercomputing und stellen sicher, dass Azure weiterhin führend im Bereich des Hochleistungsrechnens bleibt.

Und schließlich stattet Microsoft Unternehmen mit den robusten Hybridfunktionen von Azure Arc und der Einführung KI-gestützter Tools wie SQL Server 2025 mit flexiblen, skalierbaren Lösungen aus, um die Komplexität moderner Workloads zu bewältigen. Zusammen festigen diese Fortschritte Microsofts Position als führender Anbieter der Zukunft von KI, Cloud und Hybrid-Infrastruktur.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed