NVIDIA hebt während re:Invent Fortschritte und Innovationen mit AWS hervor.

NVIDIA hat während der AWS re:Invent dieser Woche ein Potpourri an Neuigkeiten angekündigt. Wir haben die Neuigkeiten zusammengefasst, um Ihnen die Highlights zu präsentieren.

NVIDIA DGX Cloud auf AWS: KI-Computing im großen Maßstab

Die NVIDIA DGX Cloud AI-Plattform ist auf AWS Marketplace verfügbar und bietet Unternehmen eine vollständig verwaltete, leistungsstarke Lösung zum Trainieren und Anpassen von KI-Modellen. Diese Plattform bietet Flexibilität hinsichtlich der Laufzeiten, ermöglicht direkten Zugriff auf NVIDIA-Experten und bietet Skalierbarkeit für Unternehmen, die ihre KI-Fähigkeiten erweitern möchten. Frühe Anwender wie Leonardo.ai, Teil der Canva-Familie, nutzen DGX Cloud, um fortschrittliche Design-Tools zu entwickeln.

AWS-Rechenzentren mit Flüssigkeitskühlung und NVIDIA Blackwell

AWS hat Liquid-to-Chip-Kühllösungen für hochdichte Rechenchips eingeführt, die die Leistung und Energieeffizienz bei KI-Workloads verbessern. Dieses innovative System integriert Luft- und Flüssigkeitskühlung, um Supercomputing-Systeme der nächsten Generation wie NVIDIA GB200 NVL72 und zukünftige NVIDIA Blackwell-basierte Plattformen zu unterstützen. Blackwell wird Amazon EC2 P6-Instanzen und Projekte wie DGX Cloud auf AWS und Project Ceiba unterstützen und maximale Leistung und Skalierbarkeit für KI-Anwendungen bieten.

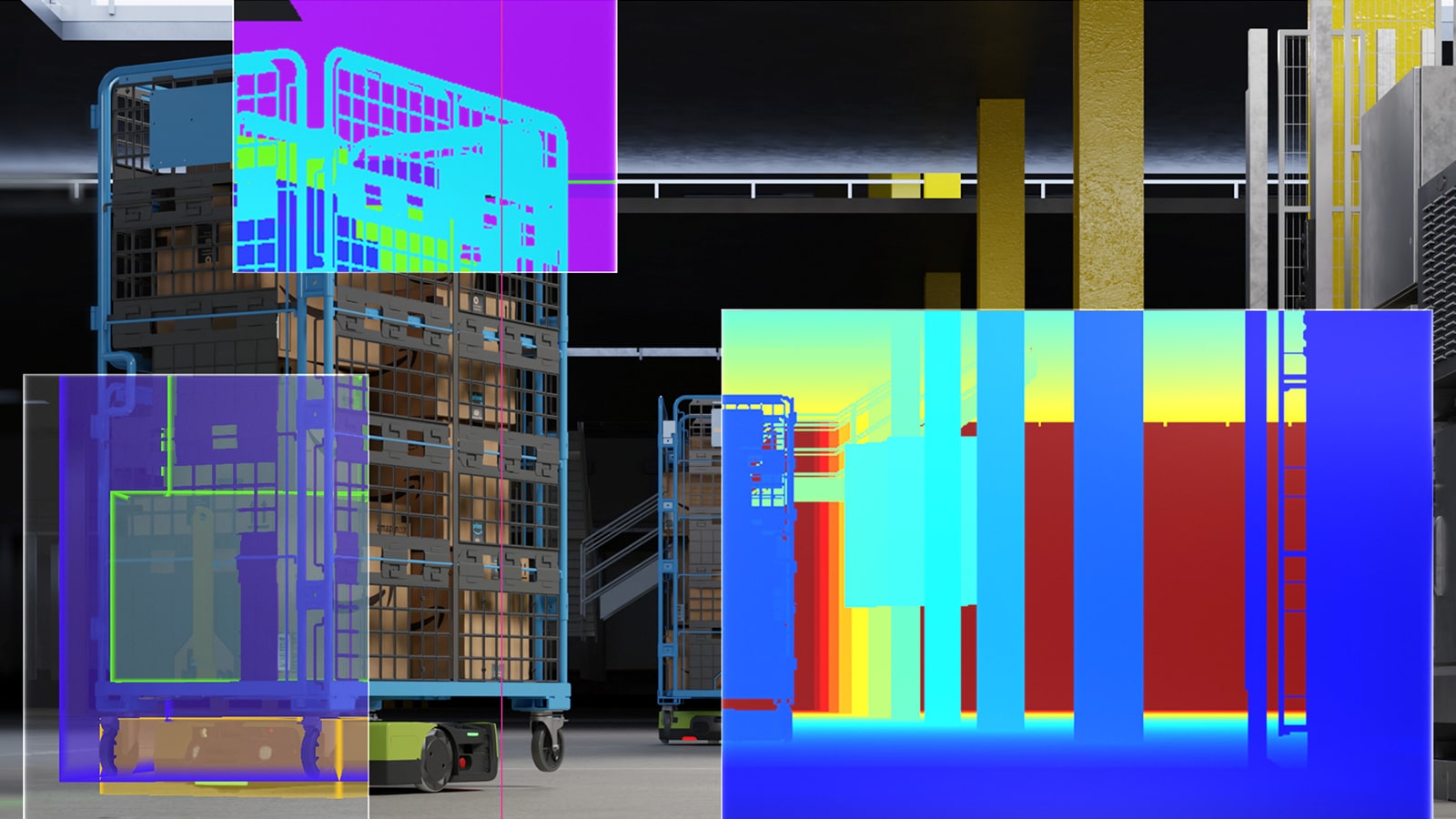

Beschleunigte Robotiksimulation auf AWS mit NVIDIA Isaac Sim

NVIDIA Isaac Sim, angetrieben von NVIDIA L40S GPUs auf Amazon EC2 G6e-Instanzen, erweitert die Robotikentwicklung auf AWS. Isaac Sim ermöglicht Entwicklern die Simulation KI-gesteuerter Roboter in virtuellen Umgebungen und beinhaltet erweiterte Tools zur Generierung synthetischer Daten über OpenUSD NIM-Mikroservices. Robotik-Innovatoren wie Aescape, Cobot und Swiss Mile verwenden Isaac Sim, um Designs zu validieren und die Leistung vor der Bereitstellung zu optimieren.

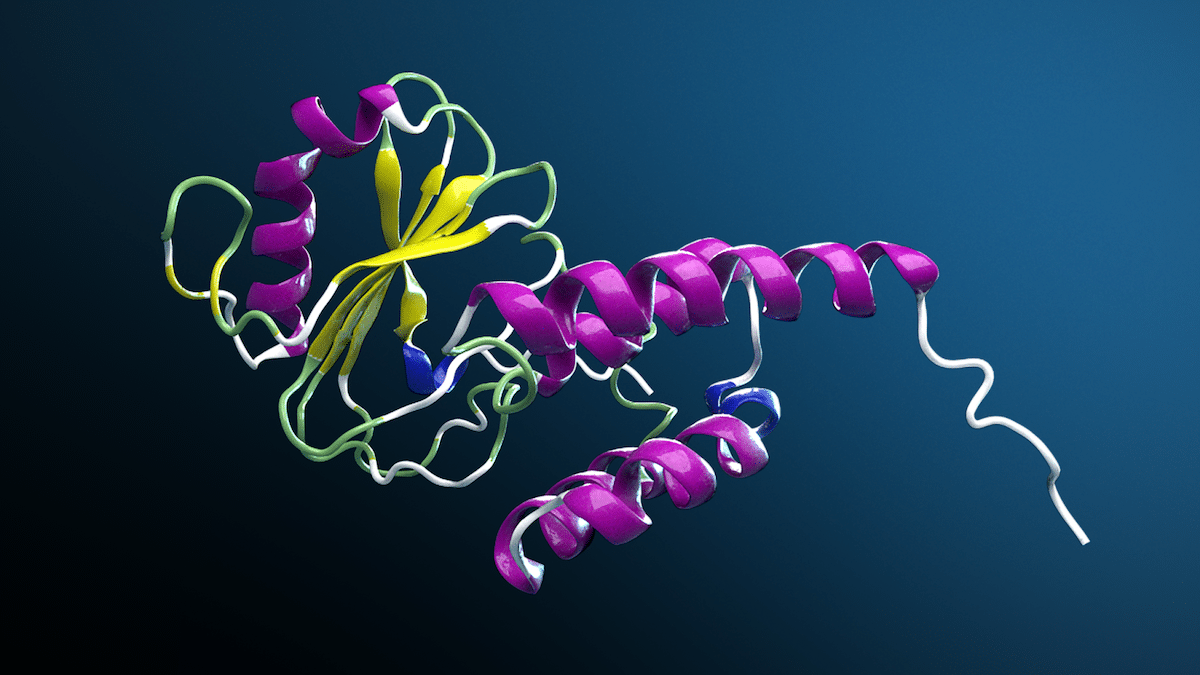

NVIDIA BioNeMo auf AWS für die Arzneimittelentdeckung

NVIDIA BioNeMo lässt sich in AWS HealthOmics integrieren, um die KI-gesteuerte Arzneimittelforschung zu optimieren. Unternehmen wie A-Alpha Bio und SoftServe nutzen die Funktionen von BioNeMo, um die Forschung zu beschleunigen. A-Alpha Bio beispielsweise erreichte mit NVIDIA H12-GPUs auf AWS eine 100-fache Steigerung der Inferenzgeschwindigkeit. Darüber hinaus hat SoftServe Drug Discovery eingeführt, eine generative KI-Lösung auf Basis von NVIDIA Blueprints, die die Arbeitsabläufe bei der Arzneimittelentwicklung vereinfachen soll.

Echtzeit-KI-Blaupausen für Unternehmensanwendungen

NVIDIAs KI-Blueprints sind für die Bereitstellung auf AWS verfügbar und ermöglichen eine schnelle Integration in Arbeitsabläufe. Zu den Anwendungsfällen gehören Videosuch- und Zusammenfassungsagenten, Schwachstellenanalysen für die Cybersicherheit und kontinuierliche Integration für frühzeitiges Sicherheitspatching. Diese Blueprints bieten skalierbare, einsatzbereite Lösungen für verschiedene Branchen.

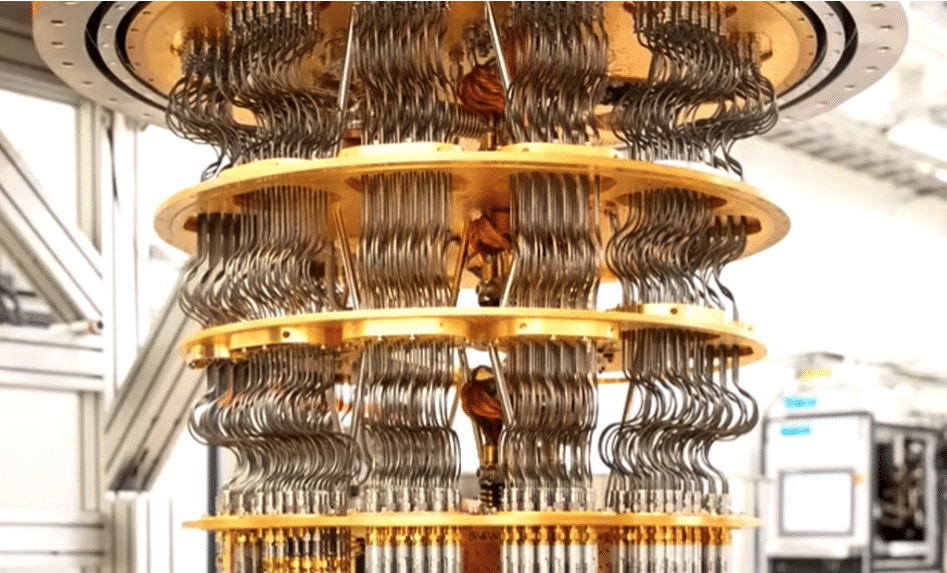

NVIDIA CUDA-Q auf Amazon Braket: Hybride quantenklassische Anwendungen

Die Integration von NVIDIA CUDA-Q mit Amazon Braket erleichtert die Entwicklung von Quantencomputern, indem sie Hybridanwendungen über Quantenprozessoren und GPU-beschleunigte Simulationen hinweg ermöglicht. CUDA-Q bietet nahtlose Entwicklungstools für die Quantenforschung, die jetzt für effiziente Arbeitsabläufe auf Braket vorinstalliert sind.

Skalierbarkeit der Unternehmens-KI durch Partnerschaften mit NVIDIA und AWS

Führende Integratoren wie Deloitte und Plattformanbieter wie Cloudera skalieren KI-Lösungen mithilfe von NVIDIA-Technologien auf AWS. Cloudera verbessert die KI-Inferenz, während Cohesity NVIDIA NeMo Retriever in seinen generativen KI-Assistenten integriert, um die Konversationssuche zu verbessern. Andere Unternehmen wie DataStax und Deloitte nutzen NVIDIA NeMo für Anwendungen, die von eingebetteten Datenbanken bis hin zu CFO-spezifischen Finanzanalysen reichen.

RAPIDS-Schnellstart-Notebooks auf Amazon EMR

AWS und NVIDIA haben RAPIDS Accelerator für Apache Spark auf Amazon EMR eingeführt, der schnellere Datenanalyse- und Machine-Learning-Workloads ermöglicht. Diese Quick Start-Notebooks vereinfachen die Spark-Job-Qualifizierung und reduzieren die Datenverarbeitungskosten ohne Codeänderungen um bis zu 80 %.

Weiterentwicklung industrieller Edge-Systeme mit NVIDIA und AWS

Die Plattformen NVIDIA IGX Orin und Jetson Orin lassen sich jetzt in AWS IoT Greengrass integrieren, um eine skalierbare Bereitstellung von KI-Modellen am Edge zu ermöglichen. Diese Zusammenarbeit optimiert den Betrieb von Industrie- und Roboteranwendungen, indem sie NVIDIAs Edge-Computing mit AWS-IoT-Diensten kombiniert. Für den Einstieg in diese erweiterten Tools steht ein Entwicklerhandbuch zur Verfügung.

Diese Ankündigungen unterstreichen die Integration von NVIDIA-Technologien mit AWS und verbessern Skalierbarkeit, Energieeffizienz und Leistung in den Bereichen KI, Robotik, Arzneimittelforschung und Quantencomputeranwendungen.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed