NVIDIA Spectrum-X inclut un routage adaptatif pour endiguer le flux de collisions et optimiser l'utilisation de la bande passante.

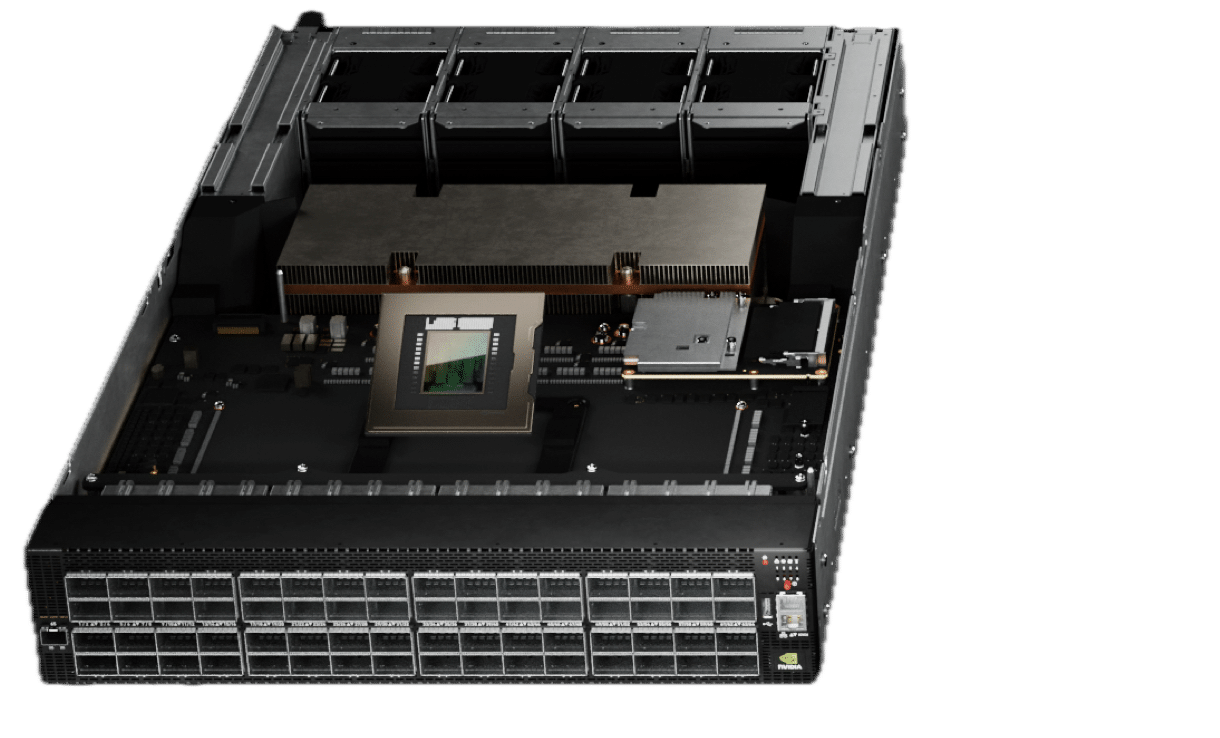

Les usines d’IA nécessitent plus que des structures de calcul hautes performances pour fonctionner efficacement. Si les réseaux Est-Ouest jouent un rôle essentiel dans la connexion des GPU, les structures de stockage, chargées de relier les baies de stockage à haut débit, sont tout aussi essentielles. Les performances de stockage ont un impact significatif sur plusieurs étapes du cycle de vie de l’IA, notamment les points de contrôle de formation et les techniques d’inférence telles que la génération augmentée de récupération (RAG). Pour répondre à ces exigences, NVIDIA et son écosystème de stockage ont étendu la plateforme réseau NVIDIA Spectrum-X pour améliorer les performances de la structure de stockage, accélérant ainsi le temps d’obtention des informations sur l’IA.

Comprendre les collisions de réseau dans les clusters d'IA

Les collisions réseau se produisent lorsque plusieurs paquets de données tentent de traverser simultanément le même chemin réseau, ce qui entraîne des interférences, des retards et, parfois, la nécessité d'une retransmission. Dans les clusters d'IA à grande échelle, de telles collisions sont plus probables lorsque les GPU sont entièrement chargés ou que le trafic est important en raison d'opérations gourmandes en données.

Les GPU traitant simultanément des calculs complexes, les ressources réseau peuvent devenir saturées, ce qui entraîne des goulots d'étranglement des communications. Spectrum-X est conçu pour remédier à ces problèmes en redirigeant automatiquement et dynamiquement le trafic et en gérant la congestion, garantissant ainsi que les flux de données critiques ne soient pas interrompus sans avoir recours à des implémentations telles que l'ECMP amélioré de Meta décrit dans le Document LLAMA 3.

Optimisation des performances de stockage avec Spectrum-X

NVIDIA Spectrum-X introduit des fonctionnalités de routage adaptatif qui atténuent les collisions de flux et optimisent l'utilisation de la bande passante. Par rapport à RoCE v2, le protocole réseau Ethernet largement utilisé dans les structures de calcul et de stockage d'IA, Spectrum-X atteint des performances de stockage supérieures. Les tests démontrent une amélioration allant jusqu'à 48 % de la bande passante de lecture et une augmentation de 41 % de la bande passante d'écriture. Ces avancées se traduisent par une exécution plus rapide des charges de travail d'IA, réduisant les délais d'achèvement des tâches de formation et minimisant la latence entre les jetons pour les tâches d'inférence.

À mesure que les charges de travail de l’IA gagnent en complexité, les solutions de stockage doivent évoluer en conséquence. Les principaux fournisseurs de stockage, dont DDN, VAST Data et WEKA, se sont associés à NVIDIA pour intégrer Spectrum-X dans leurs solutions de stockage. Cette collaboration permet aux structures de stockage IA de tirer parti des capacités de mise en réseau de pointe, améliorant ainsi les performances et l’évolutivité.

Le supercalculateur Israel-1 : validation de l'impact de Spectrum-X

NVIDIA a construit le supercalculateur génératif d'IA Israel-1 comme banc d'essai pour optimiser les performances de Spectrum-X dans des scénarios réels. L'équipe Israel-1 a mené une analyse comparative approfondie pour évaluer l'impact de Spectrum-X sur les performances du réseau de stockage. À l'aide du test d'évaluation Flexible I/O Tester (FIO), ils ont comparé une configuration réseau RoCE v2 standard avec le routage adaptatif et le contrôle de congestion de Spectrum-X activés.

Les tests ont porté sur des configurations allant de 40 à 800 GPU, démontrant systématiquement des performances supérieures avec Spectrum-X. Les améliorations de la bande passante en lecture ont varié de 20 % à 48 %, tandis que la bande passante en écriture a enregistré des gains compris entre 9 % et 41 %. Ces résultats correspondent étroitement aux améliorations de performances observées dans les solutions de l'écosystème partenaire, ce qui valide davantage l'efficacité de la technologie dans les structures de stockage IA.

Le rôle des réseaux de stockage dans les performances de l'IA

L'efficacité du réseau de stockage est essentielle aux opérations d'IA. La formation des modèles s'étend souvent sur des jours, des semaines, voire des mois, ce qui nécessite des révisions périodiques. point de contrôle pour éviter la perte de données en cas de défaillance du système. Avec des modèles d'IA à grande échelle atteignant des états de point de contrôle à l'échelle du téraoctet, une gestion efficace du réseau de stockage garantit une continuité de formation transparente.

Les charges de travail d'inférence basées sur RAG soulignent encore davantage l'importance des structures de stockage hautes performances. En combinant un LLM avec une base de connaissances dynamique, RAG améliore la précision des réponses sans nécessiter de réentraînement du modèle. Généralement stockées dans de grandes bases de données vectorielles, ces bases de connaissances nécessitent un accès au stockage à faible latence pour maintenir des performances d'inférence optimales, en particulier dans les environnements d'IA générative multi-locataires qui gèrent des volumes de requêtes élevés.

Application du routage adaptatif et du contrôle de congestion au stockage

Spectrum-X présente des innovations clés en matière de réseau Ethernet adaptées d'InfiniBand pour améliorer les performances de la structure de stockage :

- Routage adaptatif: Spectrum-X équilibre dynamiquement le trafic réseau pour éviter les collisions de flux d'éléphants pendant les points de contrôle et les opérations gourmandes en données. Les commutateurs Ethernet Spectrum-4 analysent les données de congestion en temps réel, en sélectionnant le chemin le moins encombré pour chaque paquet. Contrairement à l'Ethernet traditionnel, où les paquets désordonnés nécessitent une retransmission, Spectrum-X utilise des SuperNIC et des DPU pour réorganiser les paquets à la destination, garantissant un fonctionnement transparent et une utilisation plus efficace de la bande passante.

- Contrôle de la congestion: Point de contrôle et d'autres opérations de stockage d'IA entraînent fréquemment une congestion de type « plusieurs à un », où plusieurs clients tentent d'écrire sur un seul nœud de stockage. Spectrum-X atténue ce problème en régulant les taux d'injection de données à l'aide d'une télémétrie basée sur le matériel, évitant ainsi les points chauds de congestion qui pourraient dégrader les performances du réseau.

Assurer la résilience des structures de stockage de l'IA

Les usines d'IA à grande échelle intègrent un vaste réseau de commutateurs, de câbles et d'émetteurs-récepteurs, ce qui fait de la résilience un facteur essentiel pour maintenir les performances. Spectrum-X utilise un routage adaptatif global pour rediriger rapidement le trafic en cas de panne de liaison, minimisant ainsi les interruptions et préservant une utilisation optimale de la structure de stockage.

Intégration transparente avec la pile d'IA NVIDIA

Outre les innovations matérielles de Spectrum-X, NVIDIA propose des solutions logicielles pour accélérer les flux de travail de stockage de l'IA. Celles-ci incluent :

- NVIDIA Air:Un outil de simulation basé sur le cloud pour la modélisation des commutateurs, des SuperNIC et du stockage, simplifiant le déploiement et les opérations.

- NVIDIA Cumulus Linux:Un système d'exploitation réseau avec automatisation intégrée et prise en charge API pour une gestion efficace à grande échelle.

- NVIDIA DOCA:Un SDK pour SuperNIC et DPU, offrant une programmabilité et des performances de stockage améliorées.

- NVIDIA NetQ:Un outil de validation de réseau en temps réel s'intégrant à la télémétrie du commutateur pour une visibilité et des diagnostics améliorés.

- Stockage NVIDIA GPUDirect:Une technologie de transfert de données direct optimisant les voies de stockage vers la mémoire GPU pour un débit de données amélioré.

En intégrant Spectrum-X dans les réseaux de stockage, NVIDIA et ses partenaires redéfinissent les performances de l'infrastructure IA. La combinaison de la mise en réseau adaptative, du contrôle de la congestion et de l'optimisation logicielle garantit que les usines IA peuvent évoluer efficacement, offrant des informations plus rapides et une efficacité opérationnelle améliorée.

S'engager avec StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Flux RSS