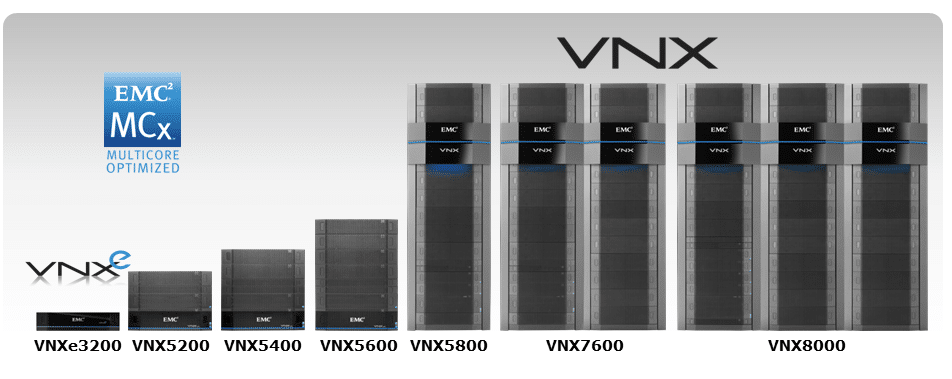

Lo storage controller VNX5200 di EMC è il punto di ingresso per le offerte VNX2 dell'azienda e offre storage a blocchi con funzionalità di file e storage unificato opzionali. VNX5200 è in grado di gestire fino a 125 dischi rigidi e SSD SAS e NL-SAS da 2.5" o 3.5" ed è realizzato con l'architettura multicore MCx di EMC. Kevin O'Brien, Direttore dello StorageReview Enterprise Test Lab, si è recato di recente al data center EMC a Hopkinton, Massachusetts, per provare in prima persona e confrontare i benchmark del sistema VNX5200.

In Settembre dell'anno scorso, EMC ha aggiornato la popolare linea VNX di array di storage unificati con significativi miglioramenti hardware. Il risultato è stata la linea VNX2, con miglioramenti come il passaggio da PCIe 2.0 a PCIe 3.0 e la nuova architettura MCx (che comprende RAID multicore, cache multicore e FAST Cache multicore) per sfruttare meglio i core CPU multipli nei processori di storage.

Molti di questi miglioramenti mirano a consentire alla piattaforma VNX di utilizzare meglio la tecnologia flash in un momento in cui gli amministratori dello storage continuano a spostarsi verso configurazioni di array ibridi. Secondo EMC, quasi il 70% dei sistemi VNX2 viene ora fornito in configurazioni flash ibride, un cambiamento che ha attribuito maggiore importanza anche al ruolo della suite FAST di EMC per il caching e il tiering.

Mentre il più piccolo VNXe3200 che abbiamo recensito in precedenza è stato aggiornato anche con le tecnologie VNX2, VNX5200 è progettato per i clienti del mercato medio che necessitano di un sistema di storage primario presso la sede centrale e per esigenze di uffici remoti/filiali più robusti di quanto può gestire VNXe3200. VNX5200 può essere configurato per storage a blocchi, file o unificato e utilizza uno chassis DPE (Disk Processor Enclosure) EMC 3U, 25x 2.5 pollici. Le unità processore di storage del VNX5200 incorporano un processore Xeon E1.2 a quattro core da 5 GHz con 16 GB di RAM e possono gestire un massimo di 125 unità con connettività FC, iSCSI, FCoE e NAS.

La famiglia VNX2 comprende attualmente anche cinque sistemi di storage progettati per scale più ampie rispetto a VNXe3200 e VNX5200.

- VNX5400: fino a 1 PB di capacità raw su 250 unità, fino a 1 TB di SSD FAST Cache e fino a 8 moduli I/O UltraFlex per array

- VNX5600: fino a 2 PB di capacità raw su 500 unità, fino a 2 TB di SSD FAST Cache e fino a 10 moduli I/O UltraFlex per array

- VNX5800: fino a 3 PB di capacità raw su 750 unità, fino a 3 TB di SSD FAST Cache e fino a 10 moduli I/O UltraFlex per array

- VNX7600: fino a 4 PB di capacità raw su 1,000 unità, fino a 4.2 TB di SSD FAST Cache e fino a 10 moduli I/O UltraFlex per array

- VNX8000: fino a 6 PB di capacità raw su 1,500 unità, fino a 4.2 TB di SSD FAST Cache e fino a 22 moduli I/O UltraFlex per array

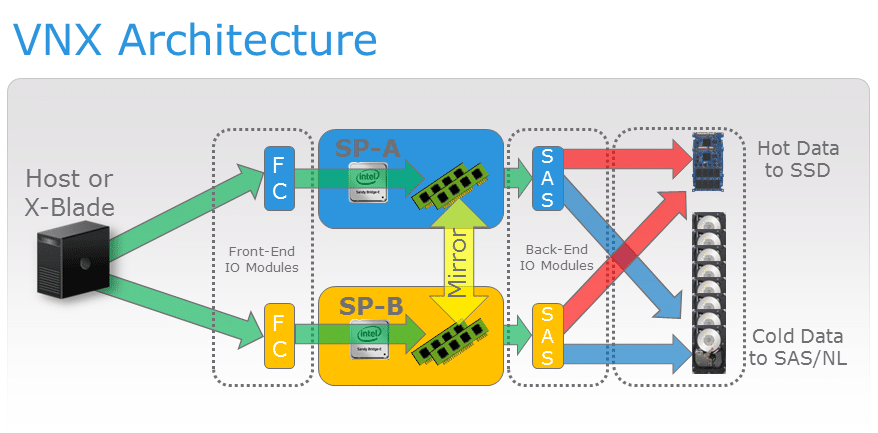

Lo storage a blocchi VNX5200 è alimentato da due processori di storage VNX con una topologia di unità SAS da 6 Gb. Una distribuzione VNX2 può utilizzare uno o più Data Mover e un'unità controller per offrire servizi NAS. Come gli altri membri della serie VNX, VNX5200 utilizza moduli I/O UltraFlex sia per i data mover che per i processori di storage a blocchi. VNX5200 supporta fino a tre Data Mover e un massimo di tre moduli UltraFlex per Data Mover.

Funzionalità multicore MCx

VNX è antecedente alla diffusa tecnologia dei processori multicore e le generazioni precedenti della piattaforma non erano costruite su basi in grado di sfruttare il dimensionamento dinamico della CPU. FLARE, l'ambiente operativo VNX1 e CLARiiON CX, consentiva l'esecuzione di servizi tra cui RAID su uno specifico core della CPU, ma il paradigma a thread singolo di FLARE implicava che molte funzioni core fossero vincolate al primo core della CPU. Ad esempio, tutti i processi I/O in entrata venivano gestiti dal Core 0 prima di essere delegati ad altri core, creando scenari con colli di bottiglia.

MCx implementa ciò che EMC definisce come scalabilità orizzontale del sistema multicore, che consente la distribuzione di tutti i servizi su tutti i core. Con questa nuova architettura disponibile sia su VNX2 che su VNXe3200, è meno probabile che i processi I/O in ingresso subiscano colli di bottiglia perché, ad esempio, le porte Fibre Channel front-end possono essere distribuite uniformemente tra diversi core del processore. MCx implementa anche l'affinità dei core I/O attraverso il concetto di core preferiti. Ogni porta, front-end e back-end, ha sia un core preferito che un'assegnazione core alternativa. I servizi di sistema ospitano le richieste con lo stesso core front-end da cui hanno avuto origine per evitare lo scambio di cache e contesto tra i core.

Uno dei principali vantaggi della nuova architettura MCx è il supporto per LUN attivo/attivo simmetrico, che consente agli host di accedere simultaneamente ai LUN tramite entrambi i processori di storage nell'array. A differenza dell'implementazione asimmetrica di FLARE, la modalità attivo/attivo simmetrico consente a entrambi gli SP di scrivere direttamente sulla LUN senza la necessità di inviare aggiornamenti allo storage processore primario.

Al momento, i sistemi VNX2 supportano l'accesso attivo/attivo simmetrico per i LUN del gruppo RAID classico, ma non supportano l'accesso attivo/attivo per i LUN del pool privato che possono invece utilizzare la modalità attivo/attivo asimmetrico. I LUN del pool privato o i "LUN classici" non possono attualmente utilizzare la modalità attivo/attivo simmetrico se utilizzano servizi dati diversi dallo splitter VNX RecoverPoint.

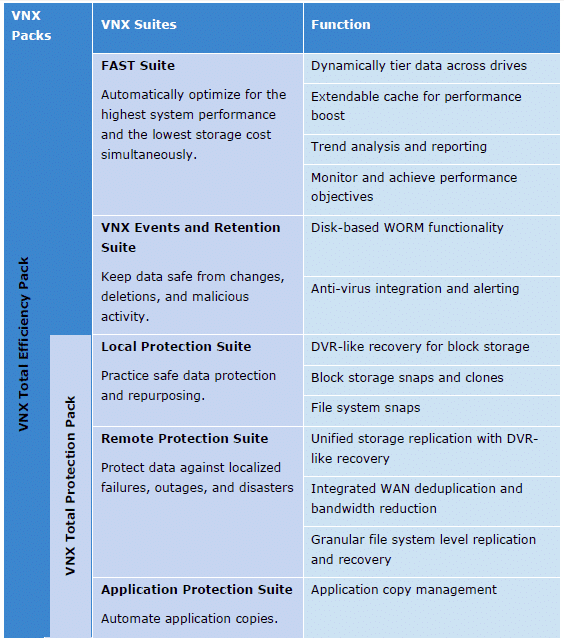

Una delle sinergie più interessanti di VNX5200 tra l'architettura MCx e lo storage di supporti flash è il supporto del sistema per EMC FAST Suite, che consente agli amministratori di sfruttare i supporti di storage flash per aumentare le prestazioni dell'array su unità eterogenee. La FAST Suite combina due approcci per l'utilizzo di flash per accelerare le prestazioni di archiviazione (caching e tiering) in una soluzione integrata. Gli aggiornamenti VNX2 alla FAST Suite includono una granularità del tiering quattro volte migliore e il supporto per le nuove unità flash eMLC.

VNX FAST Cache consente di utilizzare fino a 4.2 TB di storage SSD per gestire dati altamente attivi e adattarsi dinamicamente ai picchi del carico di lavoro, sebbene il limite superiore della dimensione della cache di VNX5200 sia 600 GB. Man mano che i dati invecchiano e diventano meno attivi nel tempo, FAST VP li suddivide da unità ad alte prestazioni a unità ad alta capacità con incrementi di 256 MB in base a policy definite dall'amministratore.

Specifiche EMC VNX5200

- Contenitore per array: contenitore per processore disco 3U

- Involucri di unità:

- SAS/Flash da 2.5 pollici (2U), 25 unità

- SAS/Flash da 3.5 pollici (3U), 15 unità

- Numero massimo di host SAN: 1,024

- Unità min/max: 4/125

- Cache FAST massima: 600 GB

- CPU/memoria per array: 2x Intel Xeon E5-2600 4-Core 1.2GHz/32GB

- RAID: 0/1/10/3/5/6

- Capacità massima massima: 500 TB

- Protocolli: FC, FCoE, NFS, CIFS, iSCSI,

- Tipi di archiviazione: unificato, SAN, NAS, oggetto

- Tipi di unità: SSD flash, SAS, NL-SAS

- Ottimizzazione della capacità: thin provisioning, deduplicazione a blocchi, compressione a blocchi, deduplicazione e compressione a livello di file

- Prestazioni: MCx, FAST VP, FAST Cache

- Gestione: EMC Unisphere

- Supporto per la virtualizzazione: VMware vSphere, VMware Horizon View, Microsoft Hyper-V, Citrix XenDesktop

- Numero massimo di moduli I/O UltraFlex Block per array: 6

- Porte totali massime per array: 28

- Porte massime FC 2/4/8 Gb/s per array: 24

- Porte totali massime iSCSI 1GBASE-T per array: 16

- Numero massimo di porte FCoE per array: 12

- Porte totali massime iSCSI 10GbE per array: 12

- Stazioni di controllo: 1 o 2

- LUN massimi supportati: 1,000 (in pool)

- Dimensione massima LUN: 256 TB (pool LUN virtuale)

- Dimensione massima del file system: 16 TB

- Numero di data mover file: 1, 2 o 3

- CPU/memoria per spostamento dati: Intel Xeon 5600/6 GB

- Moduli di espansione I/O UltraFlex per blocco:

- Canale in fibra ottica a 4 porte da 2/4/8 Gb/s

- iSCSI a 4 porte da 1 Gb/s (rame).

- iSCSI a 2 porte da 10 Gb/s (ottico).

- iSCSI 2GBASE-T (rame) a 10 porte

- FCoE a 2 porte 10GbE (ottico o twinax).

- Moduli di espansione I/O UltraFlex per file:

- 4 porte 1GBASE-T

- 4 porte 1GBASE-T e 1GbE (ottico)

- 2 porte 10GbE (ottico)

- 2GBASE-T a 10 porte (rame)

Progetta e costruisci

Nella terminologia VNX, un'implementazione di storage è costituita da diversi componenti rack integrati. Il componente del controller è un contenitore per processore di storage (SPE) che non incorpora alloggiamenti per unità o, come nel caso di questo VNX5200, un contenitore per processore di disco (DPE) che fornisce storage interno. I VNX Disk Array Enclosure (DAE) possono essere utilizzati per incorporare ulteriore capacità di storage.

Una SPE incorpora i processori di storage VNX oltre a doppi moduli SAS, doppi alimentatori e fan pack. Gli Enclosure per processori a disco (DPE) includono un Enclosure, moduli disco, processori di storage, doppi alimentatori e quattro fan pack. È possibile aggiungere ulteriore spazio di archiviazione tramite l'uso di DAE utilizzando 15 alloggiamenti per unità da 3.5 pollici, 25 x 2.5 pollici o 60 x 3.5 pollici con doppie schede di controllo del collegamento SAS e doppi alimentatori.

Che facciano parte di un contenitore di storage processore o di un contenitore di processore disco, i processori di storage VNX forniscono l'accesso ai dati a host esterni e collegano lo storage a blocchi dell'array con la funzionalità di storage di file VNX2 opzionale. VNX5200 può sfruttare una varietà di moduli IO UltraFlex di EMC per personalizzare la propria connettività.

Opzioni del modulo IO a blocco UltraFlex:

- Modulo Fibre Channel da 8 Gb/s a quattro porte con cablaggio ottico SFP e OM2/OM3 per il collegamento a uno switch HBA o FC.

- Modulo iSCSI da 1 Gb/s a quattro porte con motore di offload TCP e quattro porte Cat1 6GBaseT.

- Modulo iSCSI opzionale da 10 Gb/s a due porte con un motore di offload TCP, due porte Ethernet da 10 Gb/s e una connessione ottica SFP+ o una connessione in rame twinax a uno switch Ethernet.

- Modulo iSCSI 10GBaseT a due porte con motore di offload TCP e due porte Ethernet 10GBaseT

- Modulo FCoE 10GbE a due porte con due porte Ethernet 10Gb/s e una connessione ottica SFP+ o una connessione in rame twinax

- Modulo SAS V6 da 2.0 Gb/s a quattro porte per la connettività backend ai Block Storage Processor VNX. Ciascuna porta SAS dispone di quattro corsie per porta a 6 Gb/s per un throughput nominale di 24 Gb/s. Questo modulo è progettato per la connettività PCIe 3 e può essere configurato come 4x4x6 o 2x8x6.

Per configurare VNX5200 per lo storage di file o lo storage unificato, è necessario utilizzarlo insieme a una o più unità Data Mover. Il Data Mover Enclosure (DME) VNX ha dimensioni 2U e ospita i Data Mover. I Data Mover utilizzano processori Xeon 2.13 a quattro core da 5600 GHz con 6 GB di RAM per Data Mover e possono gestire una capacità di archiviazione massima di 256 TB per Data Mover. L'enclosure del data mover può funzionare con uno, due o tre data mover.

Le stazioni di controllo hanno dimensioni di 1U e forniscono funzioni di gestione ai data mover, inclusi i controlli per il failover. Una stazione di controllo può essere implementata con una stazione di controllo secondaria per ridondanza. Le opzioni del modulo UltraFlex File IO includono:

- Modulo IP 1GBase-T a quattro porte con quattro porte RJ-45 per cavi Cat6

- Modulo IP Opt 10GbE a due porte con due porte Ethernet 10Gb/s e una scelta di connessione ottica SFP+ o connessione in rame twinax a uno switch Ethernet

- Modulo IP 10 GBase-T a due porte con connessioni in rame a uno switch Ethernet

- Modulo Fibre Channel da 8 Gb/s a quattro porte con cablaggio ottico SFP e OM2/OM3 per la connessione diretta a un captive array e per fornire una connessione a nastro NDMP

Servizi di gestione e dati

Unisphere incorpora funzionalità di snapshot che includono opzioni di configurazione per una policy di eliminazione automatica che elimina gli snapshot (1) dopo un periodo di tempo specificato o (2) una volta che lo spazio di archiviazione degli snapshot supera una percentuale specifica di capacità di storage. Gli snapshot VNX possono utilizzare le tecnologie di thin provisioning e reindirizzamento in scrittura di EMC per migliorare la velocità e ridurre i requisiti di storage per gli snapshot archiviati.

VNX utilizza algoritmi di compressione file e blocchi progettati per LUN e file relativamente inattivi, consentendo l'esecuzione in background delle operazioni di compressione e deduplicazione con un sovraccarico prestazionale ridotto. La deduplica a blocchi fissi di VNX è realizzata con granularità da 8 KB per scenari come macchine virtuali, desktop virtuali e ambienti di test/sviluppo con molto da guadagnare dalla deduplica. La deduplicazione può essere impostata a livello di LUN del pool e le LUN thin, Thick e deduplicate possono essere archiviate in un unico pool.

Unisphere Central fornisce monitoraggio multi-box centralizzato per un massimo di migliaia di sistemi VNX e VNXe, ad esempio sistemi distribuiti in uffici remoti e filiali. La suite Unisphere include anche il software di monitoraggio e reporting VNX per l'utilizzo dello storage e i modelli dei carichi di lavoro per facilitare la diagnosi dei problemi, l'analisi delle tendenze e la pianificazione della capacità.

Negli ambienti virtualizzati, VNX5200 può implementare Virtual Storage Integrator di EMC per VMware vSphere 5 per il provisioning, la gestione, la clonazione e la deduplica. Per VMware, VNX5200 offre integrazioni API per VAAI e VASA e negli ambienti Hyper-V può essere configurato per il trasferimento dati offload e la copia offload per file. EMC Storage Integrator offre funzionalità di provisioning per Hyper-V e SharePoint. Il software EMC Site Recovery Manager è in grado di gestire il failover e il failback anche in situazioni di disaster recovery.

Gli array VNX2 da VNX5200 a VNX8000 offrono la nuova crittografia dei dati a riposo basata su controller di EMC, denominata D@RE, che crittografa tutti i dati utente a livello di unità. D@RE utilizza la crittografia AES 256 ed è in attesa di convalida per la conformità FIPS-140-2 Livello 1. I nuovi array VNX con funzionalità D@RE vengono forniti con l'hardware di crittografia incluso e i sistemi VNX2 esistenti possono essere aggiornati sul campo per supportare D@RE e crittografare senza interruzioni lo storage esistente come attività in background.

D@RE crittografa tutti i dati scritti sull'array utilizzando un normale protocollo di percorso dati con una chiave univoca per disco. Se per qualsiasi motivo le unità vengono rimosse dall'array, le informazioni sull'unità saranno incomprensibili. D@RE incorpora anche la funzionalità di cancellazione crittografica poiché le sue chiavi di crittografia vengono eliminate quando un gruppo RAID o un pool di archiviazione viene eliminato.

VNX2 offre funzionalità di cache di scrittura con mirroring, in cui ciascun processore di storage contiene sia i dati principali memorizzati nella cache per i relativi LUN sia una copia secondaria della cache per il processore di storage peer. I livelli RAID 0, 1, 1/0, 5 e 6 possono coesistere nello stesso array e la funzione proattiva di hot sparing del sistema aumenta ulteriormente la protezione dei dati. Il sistema utilizza unità di backup a batteria integrate per fornire la disattivazione della cache e altre considerazioni per uno spegnimento ordinato durante le interruzioni di corrente.

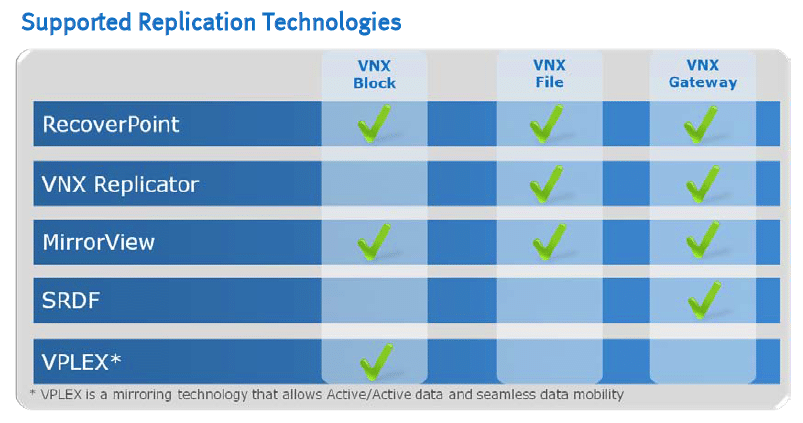

La protezione locale è disponibile tramite la funzionalità di snapshot point-in-time di Unisphere, mentre la protezione continua dei dati è disponibile tramite la replica locale di RecoverPoint. VPLEX di EMC può essere utilizzato per estendere la disponibilità continua all'interno e tra i data center. Secondo EMC, ha utilizzato i DVR televisivi come ispirazione per il suo software di replica remota continua RecoverPoint.

Replication Manager e AppSync forniscono protezione coerente con le applicazioni con le soluzioni EMC Backup and Recovery tra cui Data Domain, Avamar e Networker per ridurre le finestre di backup e i tempi di ripristino.

Test di background e supporti di archiviazione

Pubblichiamo un inventario del nostro ambiente di laboratorio, una panoramica delle capacità di rete del laboratorioe altri dettagli sui nostri protocolli di test in modo che gli amministratori e i responsabili dell'acquisizione delle apparecchiature possano valutare equamente le condizioni in cui abbiamo ottenuto i risultati pubblicati. Per mantenere la nostra indipendenza, nessuna delle nostre revisioni viene pagata o gestita dal produttore delle apparecchiature che stiamo testando.

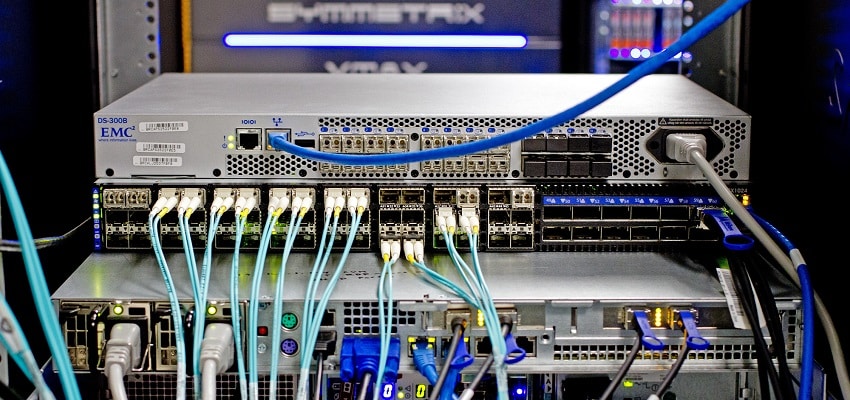

La recensione di EMC VNX5200 si distingue per un approccio di test piuttosto unico rispetto al modo in cui solitamente valutiamo le apparecchiature. Nel nostro processo di revisione standard il fornitore ci spedisce la piattaforma, che poi colleghiamo alle nostre piattaforme di test fisse per i benchmark delle prestazioni. Con VNX5200, le dimensioni e la complessità, nonché la configurazione iniziale, ci hanno portato a modificare questo approccio e a portare il nostro revisore e le nostre apparecchiature presso il laboratorio EMC. EMC ha preparato un VNX5200 con le apparecchiature e le opzioni necessarie per i test iSCSI e FC. EMC ha fornito il proprio switch FC dedicato da 8 Gb, mentre noi abbiamo portato uno dei nostri switch Mellanox SX10 da 40/1024 Gb per la connettività Ethernet. Per stressare il sistema abbiamo sfruttato un server EchoStreams OSS1A-1U, superando le specifiche hardware di ciò che utilizziamo nel nostro ambiente di laboratorio tradizionale.

EchoStreams OSS1A-1U Specifiche tecniche:

- 2x Intel Xeon E5-2697 v2 (2.7 GHz, 30 MB di cache, 12 core)

- Chipset Intel C602A

- Memoria: RDIMM registrati DDR16 da 2 GB (8x 1333 GB) a 3 MHz

- Windows Server Standard 2012 R2

- SSD di avvio: RealSSD P100e Micron da 400 GB

- 2 schede NIC Mellanox ConnectX-3 a doppia porta 10GbE

- 2 HBA a doppia porta PCIe 16002 Emulex LightPulse LPe5 Gen 8 Fibre Channel (16GFC, 3.0GFC)

La nostra valutazione di VNX5200 confronterà le sue prestazioni in benchmark sintetici su cinque configurazioni che riflettono il modo in cui i clienti EMC distribuiscono i sistemi VNX2 in un ambiente di produzione. Ciascuna configurazione sfruttava 8 LUN da 25 GB.

- Un array RAID10 composto da supporti SSD con connettività Fibre Channel

- Un array RAID10 composto da supporti SSD con connettività iSCSI

- Un array RAID6 composto da supporti HDD da 7k con connettività Fibre Channel

- Un array RAID5 composto da supporti HDD da 10k con connettività Fibre Channel

- Un array RAID5 composto da supporti HDD da 15k con connettività Fibre Channel.

Ciascuna configurazione incorporava 24 unità e utilizzava le configurazioni RAID più comuni con la loro implementazione in un ambiente di produzione.

Analisi sintetica del carico di lavoro aziendale

Prima di avviare ciascuno dei benchmark fio sintetici, il nostro laboratorio precondiziona il dispositivo in stato stazionario sotto un carico pesante di 16 thread con una coda eccezionale di 16 per thread. Quindi lo storage viene testato a intervalli prestabiliti con più profili di profondità thread/coda per mostrare le prestazioni in condizioni di utilizzo leggero e intenso.

Prove di precondizionamento e di stato stazionario primario:

- Throughput (lettura+scrittura IOPS aggregati)

- Latenza media (latenza di lettura+scrittura mediata insieme)

- Latenza massima (latenza di picco in lettura o scrittura)

- Deviazione standard della latenza (deviazione standard di lettura e scrittura mediata insieme)

Questa analisi sintetica incorpora quattro profili ampiamente utilizzati nelle specifiche e nei benchmark dei produttori:

- 4k casuale: 100% lettura e 100% scrittura

- Sequenziale 8k: 100% lettura e 100% scrittura

- 8k casuale – 70% lettura/30% scrittura

- Sequenziale 128k: 100% lettura e 100% scrittura

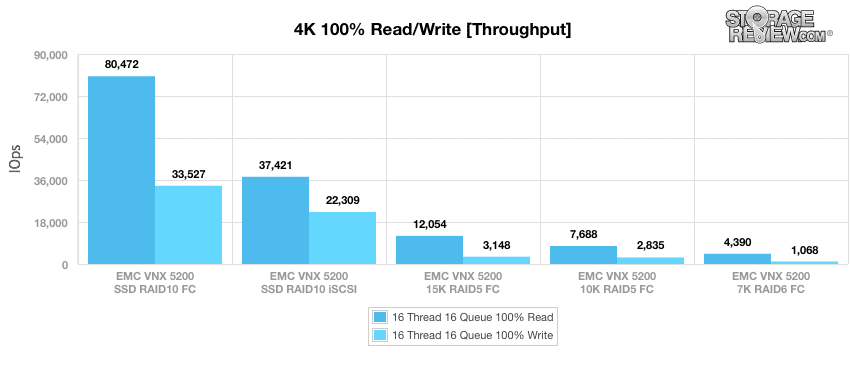

Dopo essere stato precondizionato per carichi di lavoro 4K, abbiamo sottoposto il VNX5200 ai nostri test principali. Pertanto, se configurato con SSD e accessibile tramite Fibre Channel, ha registrato 80,472 IOPS in lettura e 33,527 IOPS in scrittura. Utilizzando gli stessi SSD in RAID10 (anche se questa volta utilizzando il nostro test iSCSI a livello di blocco), il VNX5200 ha raggiunto 37,421 IOPS in lettura e 22,309 IOPS in scrittura. Il passaggio a HDD da 15 in RAID5 utilizzando la connettività Fibre Channel ha mostrato 12,054 IOPS in lettura e 3,148 IOPS in scrittura, mentre la configurazione con HDD da 10 IOPS ha raggiunto 7,688 IOPS in lettura e 2,835 IOPS in scrittura. Quando si utilizzano HDD da 7K in una configurazione RAID6 dello stesso tipo di connettività, VNX5200 ha registrato 4,390 IOPS in lettura e 1,068 IOPS in scrittura.

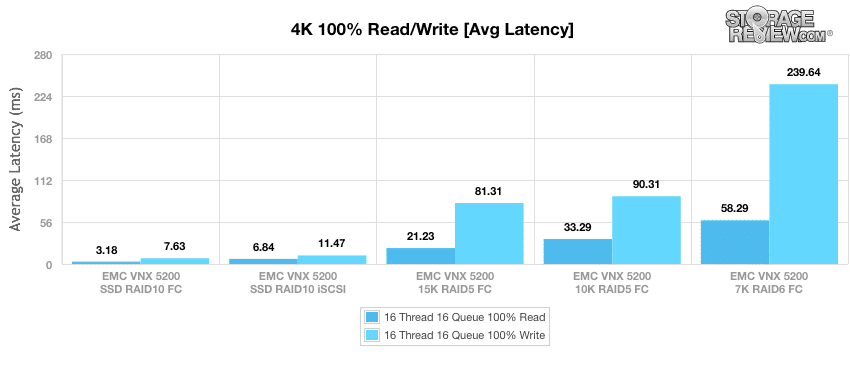

I risultati sono stati più o meno gli stessi in termini di latenza media. Se configurato con SSD in RAID10 e utilizzando una connettività Fibre Channel, ha mostrato 3.18 ms in lettura e 7.63 ms in scrittura. Utilizzando gli stessi SSD con il nostro test iSCSI a livello di blocco, il VNX5200 vantava 6.84 ms in lettura e 11.47 ms in scrittura. Il passaggio a HDD da 15 in RAID5 utilizzando la connettività Fibre Channel ha mostrato 21.23 ms in lettura e 81.31 ms in scrittura di latenza media, mentre la configurazione HDD da 10 ha registrato 33.29 ms in lettura e 90.31 ms in scrittura. Quando si passa a HDD da 7K in una configurazione RAID6 dello stesso tipo di connettività, il VNX5200 ha registrato 58.29 ms in lettura e 239.64 ms in scrittura.

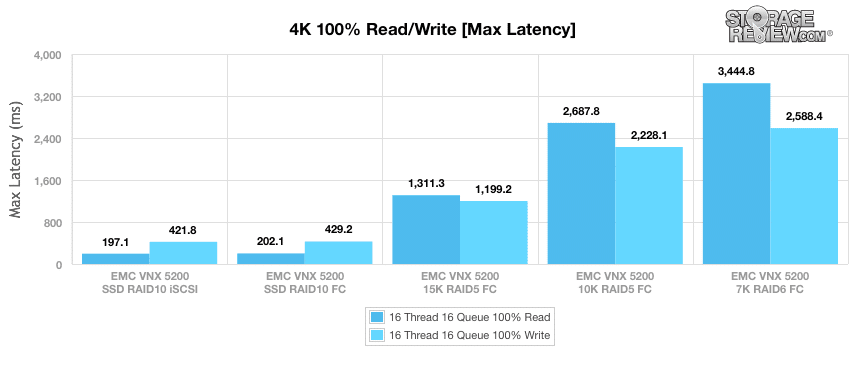

Successivamente, passiamo al nostro benchmark di latenza massima. Se configurato con SSD in RAID10 e utilizzando il nostro test iSCSI a livello di blocco, ha mostrato 197 ms in lettura e 421.8 ms in scrittura. Utilizzando gli stessi SSD, anche se questa volta con connettività Fibre Channel, il VNX5200 vantava 202.1 ms in lettura e 429.2 ms in scrittura. Il passaggio a HDD da 15 in RAID5 utilizzando la connettività Fibre Channel ha registrato 1,311.3 ms in lettura e 1,199.2 ms in scrittura per la massima latenza, mentre la configurazione con HDD da 10 HDD ha registrato 2,687.8 ms in lettura e 2,228.1 ms in scrittura. Quando si passa a HDD da 7K in una configurazione RAID6 dello stesso tipo di connettività, il VNX5200 ha registrato 3,444.8 ms in lettura e 2,588.4 ms in scrittura.

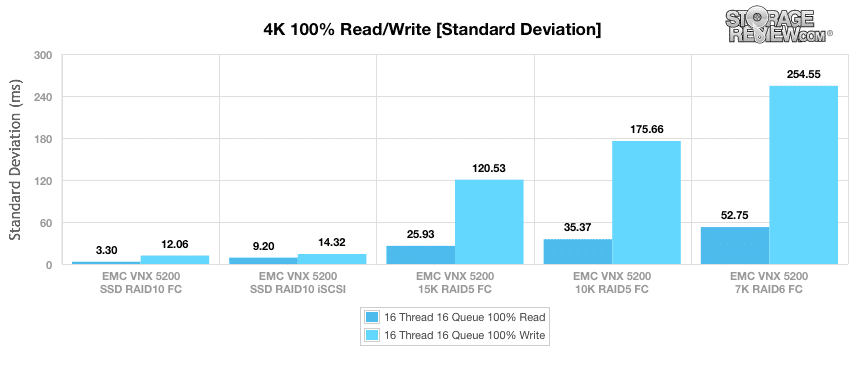

Il nostro ultimo benchmark 4K è la deviazione standard, che misura la coerenza del Le prestazioni di VNX5200. Se configurato con SSD in RAID10 utilizzando il nostro test iSCSI a livello di blocco, il VNX5200 pubblicato 3.30 ms in lettura e 12.06 ms in scrittura. Utilizzando gli stessi SSD con connettività Fibre Channel si ottengono 9.20 ms in lettura e 14.32 ms in scrittura. Il passaggio a HDD da 15 in RAID5 con connettività Fibre Channel ha registrato 25.93 ms in lettura e 120.53 ms in scrittura, mentre la configurazione con HDD da 10 HDD ha registrato 35.37 ms in lettura e 175.66 ms in scrittura. Quando si utilizza la configurazione RAID7 degli HDD da 6K con lo stesso tipo di connettività, il VNX5200 ha registrato 52.75 ms in lettura e 254.55 ms in scrittura.

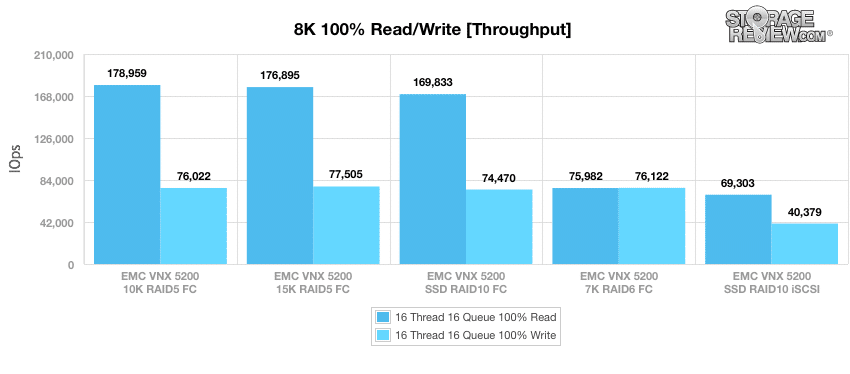

Il nostro prossimo benchmark utilizza un carico di lavoro sequenziale composto da operazioni di lettura al 100% e quindi da operazioni di scrittura al 100% con una dimensione di trasferimento di 8k. In questo caso, il VNX5200 ha registrato 178,959 IOPS in lettura e 76,022 IOPS in scrittura se configurato con HDD da 10 unità in connettività Fibre Channel RAID5. L'utilizzo di HDD da 15 in RAID5 con connettività Fibre Channel mostra 176,895 IOPS in lettura e 77,505 IOPS in scrittura. Il passaggio agli SSD in RAID10 utilizzando una connettività Fibre Channel ha registrato 169,833 IOPS in lettura e 74,470 IOPS in scrittura, mentre il test a livello di blocco SSD iSCSI ha mostrato 69,303 IOPS in lettura e 40,379 IOPS in scrittura. Quando si utilizzano HDD da 7K in una configurazione RAID6 con connettività Fibre Channel, il VNX5200 ha registrato 75,982 IOPS in lettura e 76,122 IOPS in scrittura.

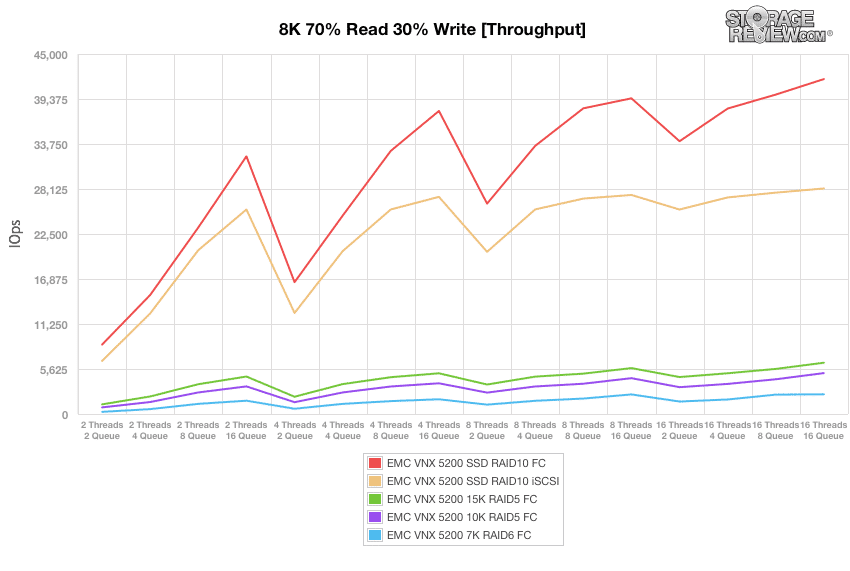

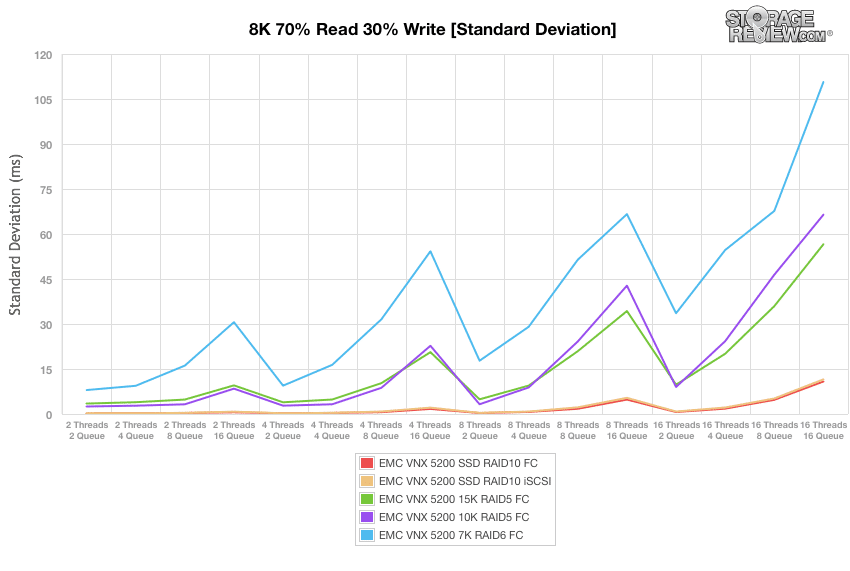

La nostra prossima serie di carichi di lavoro è composta da una combinazione di operazioni di lettura (8%) e scrittura (70%) da 30k fino a una coda di 16 thread e 16, la nostra prima delle quali è il throughput. Se configurato con SSD in RAID10 utilizzando la connettività Fibre Channel, il VNX5200 ha registrato una gamma di 8,673 IOPS a 41,866 IOPS entro 16T/16Q. L'utilizzo degli stessi SSD durante il nostro test iSCSI a livello di blocco mostra una serie di Da 6,631 IOPS a 28,193 IOPS. Il passaggio a HDD da 15 in RAID5 con connettività Fibre Channel ha registrato una serie di 1,204 IOP e di 6,411 IOP, mentre la configurazione dell'HDD da 10K ha registrato 826 IOPS e 5,113 IOPS entro 16T/16Q. Quando si utilizza la configurazione RAID7 degli HDD da 6K con lo stesso tipo di connettività, il VNX5200 ha registrato un intervallo compreso tra 267 IOPS e 2,467 IOPS.

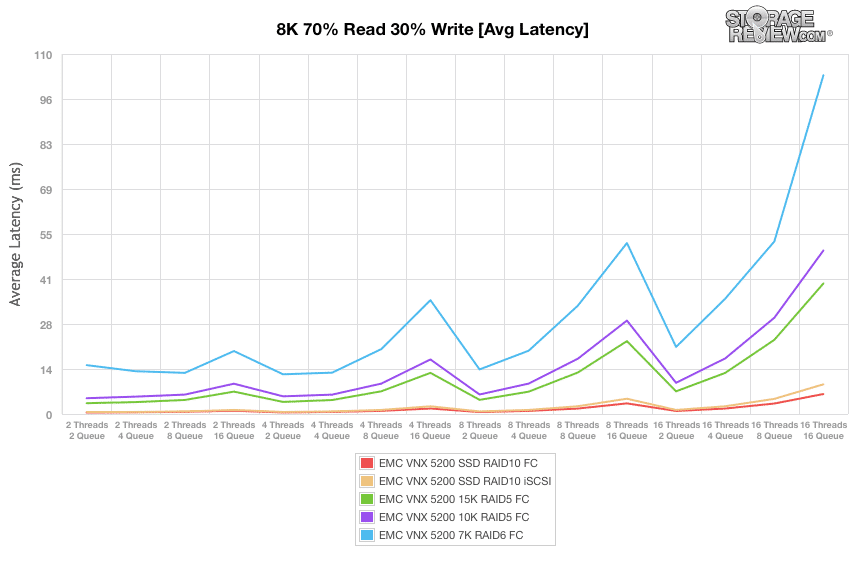

Successivamente, abbiamo esaminato la latenza media. Se configurato con SSD in RAID10 utilizzando la connettività Fibre Channel, il VNX5200 ha registrato un intervallo compreso tra 0.45 ms e 6.11 ms entro 16 T/16 Q. Utilizzando gli stessi SSD durante il nostro test iSCSI a livello di blocco mostra un intervallo compreso tra 0.59 ms e 9.07 ms. Il passaggio a HDD da 15 in RAID5 con connettività Fibre Channel ha registrato un intervallo di 3.31 ms e 39.89 ms, mentre la configurazione HDD da 10 ha registrato inizialmente 4.83 ms e 49.97 ms a 16T/16Q. Quando si utilizza la configurazione RAID7 degli HDD da 6K con lo stesso tipo di connettività, il VNX5200 ha registrato un intervallo compreso tra 14.93 ms e 103.52 ms.

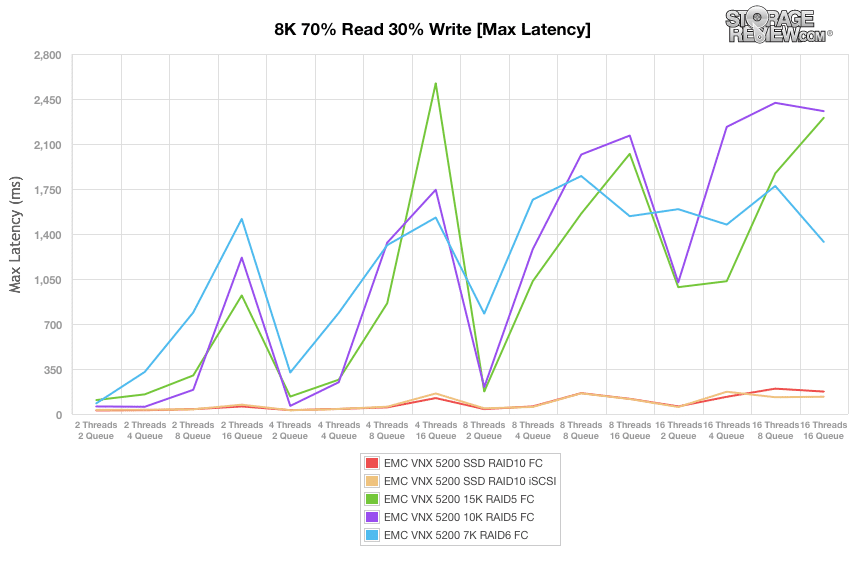

Dando un'occhiata ai risultati di latenza massima, se configurato con SSD in RAID10 utilizzando la connettività Fibre Channel, il VNX5200 ha avuto un intervallo compreso tra 27.85 ms e 174.43 ms entro 16 T/16 Q. Utilizzando gli stessi SSD durante il nostro test iSCSI a livello di blocco mostra un intervallo compreso tra 31.78 ms e 134.48 ms nella latenza massima. Il passaggio a HDD da 15 in RAID5 con connettività Fibre Channel ha registrato un intervallo di 108.48 ms e 2,303.72 ms, mentre la configurazione HDD da 10 ha mostrato 58.83 ms e 2,355.53 ms entro 16T/16Q. Quando si utilizza la configurazione RAID7 degli HDD da 6K con lo stesso tipo di connettività, il VNX5200 ha registrato un intervallo di latenza massima compreso tra 82.74 ms e 1,338.61 ms.

Il nostro prossimo carico di lavoro analizza la deviazione standard per le nostre operazioni 8k con 70% di lettura e 30% di scrittura. Utilizzando gli SSD in RAID10 e la connettività Fibre Channel, il VNX5200 ha registrato un intervallo compreso tra appena 0.18 ms e 10.83 ms entro 16 T/16 Q. Utilizzando gli stessi SSD durante il nostro test iSCSI a livello di blocco mostra un intervallo simile compreso tra 0.21 ms e 11.54 ms in termini di coerenza della latenza. Il passaggio a HDD da 15 in RAID5 con connettività Fibre Channel ha registrato un intervallo compreso tra 3.48 ms e 56.58 ms, mentre la configurazione HDD da 10 ha mostrato inizialmente 2.5 ms e 66.44 ms a 16T/16Q. Quando si utilizza la configurazione RAID7 degli HDD da 6K con lo stesso tipo di connettività, il VNX5200 ha registrato un intervallo di deviazione standard compreso tra 7.98 ms e 110.68 ms.

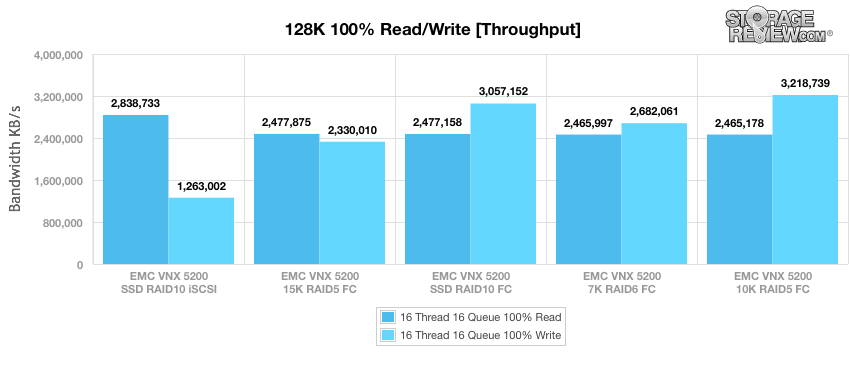

Il nostro benchmark sintetico finale ha utilizzato trasferimenti sequenziali di 128k e un carico di lavoro composto al 100% da operazioni di lettura e al 100% da operazioni di scrittura. In questo scenario, il VNX5200 ha registrato 2.84 GB/s in lettura e 1.26 GB/s in scrittura se configurato con SSD utilizzando il nostro test iSCSI a livello di blocco. Utilizzando HDD da 15 in RAID5 con connettività Fibre Channel si ottengono 2.48 GB/s in lettura e 2.33 GB/s in scrittura. Tornando agli SSD in RAID10 (questa volta utilizzando una connettività Fibre Channel) ha registrato 2.48 GB/s in lettura e 3.06 GB/s in scrittura. Quando si utilizzano HDD da 7K in una configurazione RAID6 con connettività Fibre Channel, il VNX5200 ha registrato 2.47 GB/s in lettura e 2.68 GB/s in scrittura mentre la configurazione HDD da 10K ha registrato 2.47 GB/s in lettura e 3.22 GB/s in scrittura.

Conclusione

L'ecosistema VNX di EMC è ben consolidato nel mercato dello storage aziendale, ma VNX2 riflette la volontà dell'azienda di rivedere completamente l'architettura VNX per sfruttare al massimo i progressi nelle tecnologie di processore, flash e rete. Proprio come il VNXe3200, orientato a implementazioni più piccole, VNX5200 dimostra inoltre che EMC sta prestando attenzione alle aziende del mercato di medie dimensioni e alle filiali/filiali che potrebbero non essere in grado di giustificare la spesa dei sistemi più grandi della famiglia VNX ma desiderano comunque tutti i vantaggi aziendali .

Utilizzato insieme a FAST Suite, VNX5200 è in grado di offrire flash caching e tiering in tandem, una combinazione contro la quale i concorrenti di EMC hanno difficoltà a competere. Nei nostri test abbiamo analizzato i livelli e le configurazioni comuni di storage per illustrare con una suite di test limitata proprio ciò che gli utenti possono aspettarsi dal 5200. I test hanno riguardato HDD da 7K fino agli SSD, illustrando la flessibilità del sistema, offrendo capacità, prestazioni, o entrambi su una varietà di opzioni di interfaccia.

In definitiva, la piattaforma VNX2 è in grado di gestire praticamente qualsiasi cosa gli venga lanciata; ed è proprio questa flessibilità a far vincere ogni giorno le trattative EMC. Data la combinazione di opzioni di archiviazione, moduli IO e supporto NAS, i sistemi sono in grado di gestire quasi tutto ciò di cui un'organizzazione potrebbe aver bisogno. Naturalmente ci sono casi d'uso che vanno oltre i 5200 che abbiamo testato qui. La famiglia VNX si espande notevolmente (e anche leggermente con VNXe3200) per soddisfare queste esigenze, sia con maggiore potenza di elaborazione, allocazione flash o scaffali per dischi.

Vantaggi

- Una varietà di opzioni di connettività tramite moduli I/O UltraFlex

- Configurazioni che supportano scenari di archiviazione a blocchi, file e unificati

- Accesso al solido ecosistema VNX di strumenti amministrativi e integrazioni di terze parti

Svantaggi

- Massimo 600 GB di cache FAST

Conclusione

EMC VNX5200 rappresenta un elemento chiave in una nuova ondata di array di storage unificati progettati per sfruttare lo storage flash, le CPU multi-core e i moderni ambienti di rete di data center. La sua convenienza, la flessibilità nella configurazione e l'accesso al software di gestione VNX2 e alle integrazioni di terze parti costituiscono un pacchetto complessivo formidabile per il mercato medio.

Pagina del prodotto EMC VNX5200