Meta avslöjar Llama 4, en kraftfull MoE-baserad AI-modellfamilj som erbjuder förbättrad effektivitet, skalbarhet och multimodal prestanda.

Meta har introducerat sin senaste AI-innovation, Llama 4, en samling modeller som förbättrar multimodal intelligens. Llama 4 är baserad på Mixture-of-Experts (MoE)-arkitekturen, som erbjuder exceptionell effektivitet och prestanda.

Förstå MoE-modeller och sparsamhet

Mixture-of-Experts (MoE)-modeller skiljer sig markant från traditionella täta modeller, där hela modellen bearbetar varje input. I MoE-modeller aktiveras endast en delmängd av de totala parametrarna, kallade "experter", för varje ingång. Denna selektiva aktivering beror på egenskaperna hos ingången, vilket gör att modellen kan allokera resurser dynamiskt och förbättra effektiviteten.

Sparsitet är ett väsentligt begrepp i MoE-modeller, som indikerar förhållandet mellan inaktiva parametrar för en specifik ingång. MoE-modeller kan avsevärt minska beräkningskostnaderna genom att använda sparsitet samtidigt som prestanda bibehålls eller förbättras.

Möt familjen Llama 4: Scout, Maverick och Behemoth

Llama 4-sviten består av tre modeller: Llama 4 Scout, Llama 4 Maverick och Llama 4 Behemoth. Varje modell är designad för att tillgodose olika användningsfall och krav.

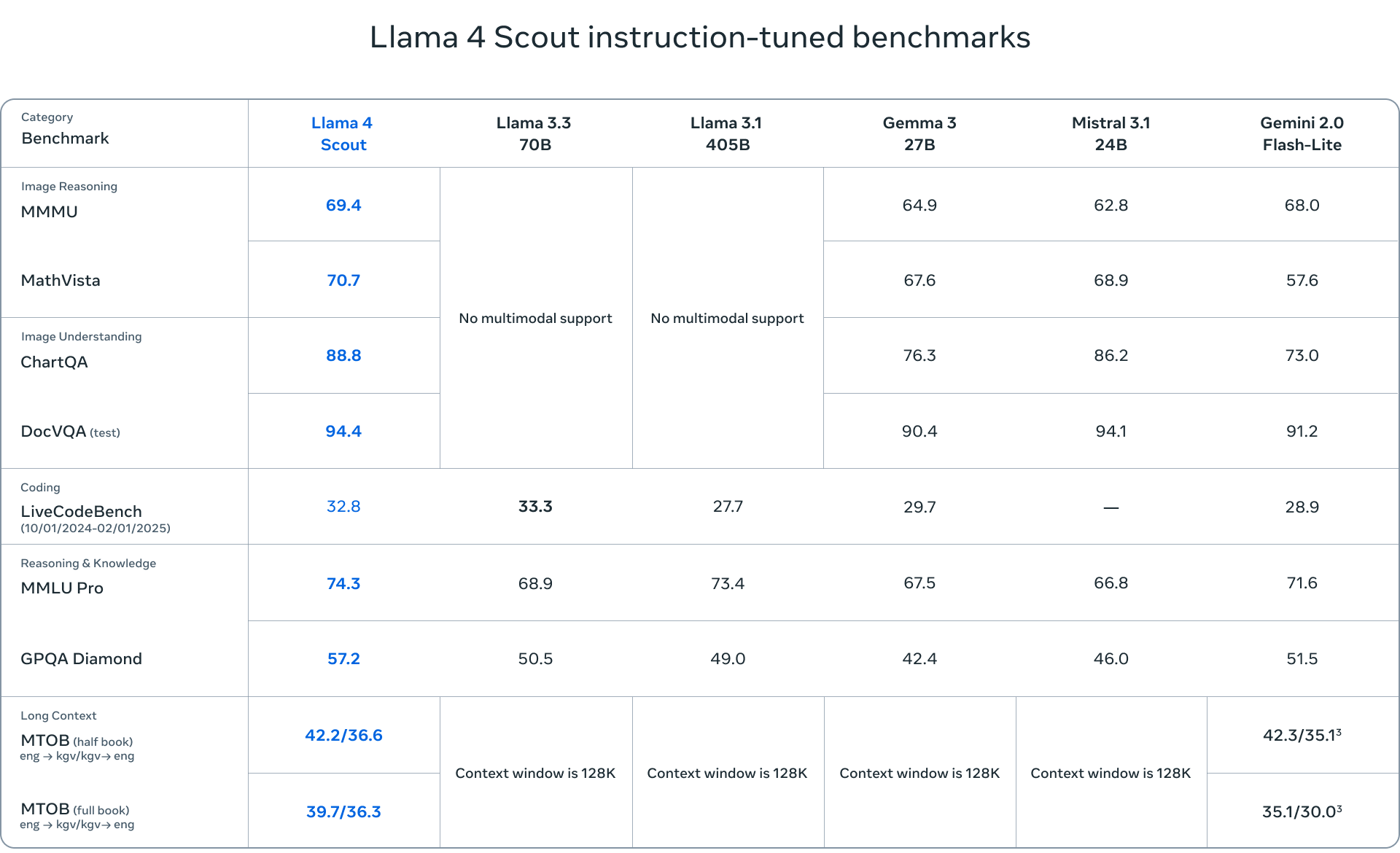

- Llama 4 Scout är en kompakt modell med 17 miljarder aktiva parametrar och 109 miljarder totala parametrar över 16 experter. Den är optimerad för effektivitet och kan köras på en enda NVIDIA H100 GPU (FP4 Quantized). Scout har ett imponerande kontextfönster på 10 miljoner token, vilket gör det idealiskt för applikationer som kräver lång sammanhangsförståelse.

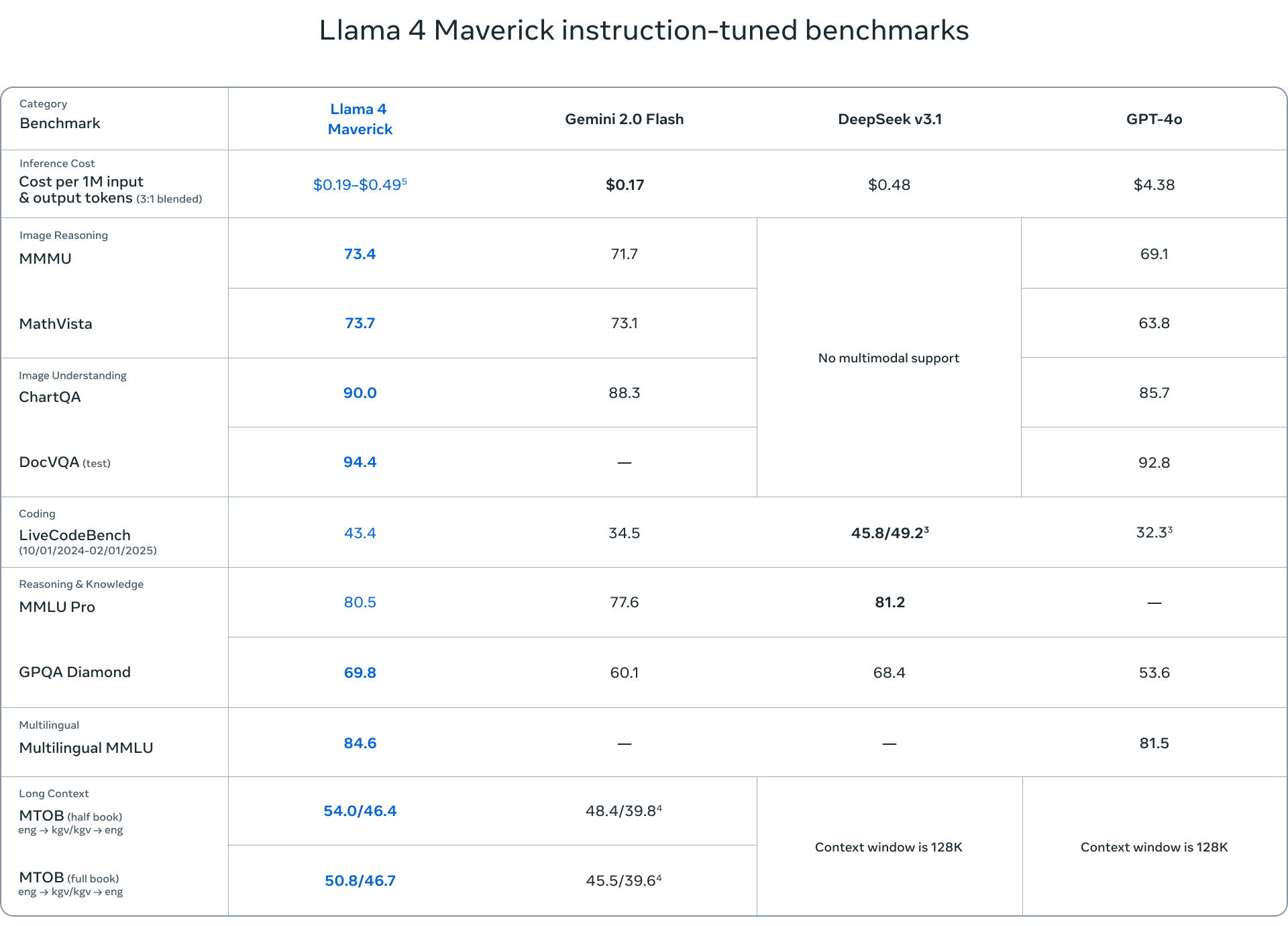

- Llama 4 Maverick är en mer robust modell med samma 17 miljarder aktiva parametrar men med 128 experter, totalt 400 miljarder parametrar. Maverick utmärker sig i multimodal förståelse, flerspråkiga uppgifter och kodning, överträffar konkurrenter som GPT-4o och Gemini 2.0 Flash.

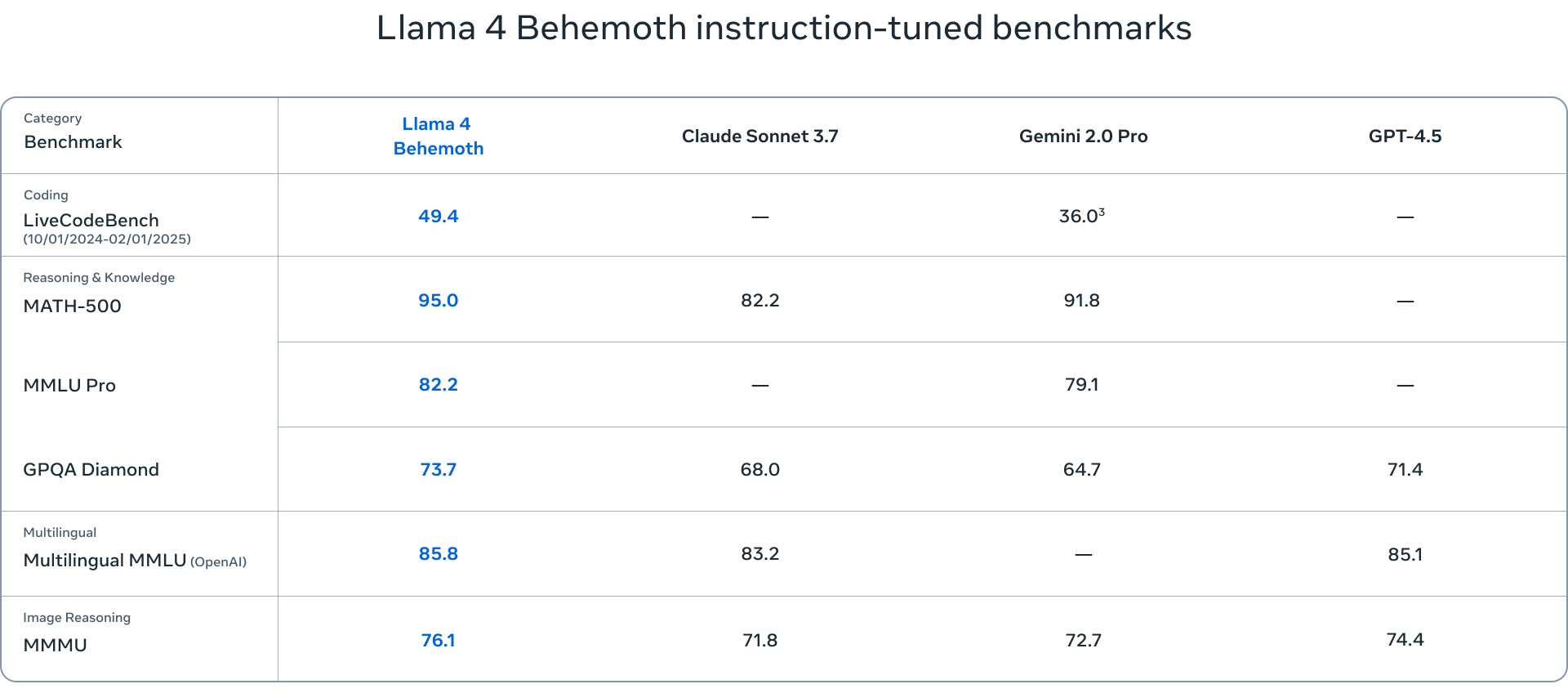

- Llama 4 Behemoth är den största modellen i sviten, med 288 miljarder aktiva parametrar och nästan 2 biljoner totala parametrar hos 16 experter. Även om Behemoth fortfarande är i träning, har Behemoth redan visat toppmodern prestanda på olika riktmärken och överträffat modeller som GPT-4.5 och Claude Sonnet 3.7.

Riktmärkena som används för att utvärdera Llama 4-modellerna täcker en rad uppgifter, inklusive språkförståelse (MMLU – Massive Multitask Language Understanding, GPQA – Google-Proof Question Answering), matematisk problemlösning (MATH – Mathematical Problem-Solving, MathVista – ett riktmärke för att lösa matematiska problem i visuella sammanhang – (MUMM) Multimodal Multitask Understanding). Dessa standardriktmärken ger en omfattande bedömning av modellernas kapacitet och hjälper till att identifiera områden där de utmärker sig eller kräver ytterligare förbättringar.

Lärarmodellernas roll i Lama 4

En lärarmodell är en stor, förutbildad modell som vägleder mindre modeller och överför sina kunskaper och förmågor till dem genom destillation. När det gäller Llama 4, fungerar Behemoth som lärarens modell och destillerar sin kunskap till både Scout och Maverick. Destillationsprocessen innebär att de mindre modellerna tränas i att efterlikna lärarmodellens beteende, så att de kan lära sig av dess styrkor och svagheter. Detta tillvägagångssätt gör det möjligt för de mindre modellerna att uppnå imponerande prestanda samtidigt som de är mer effektiva och skalbara.

Implikationer och framtida riktningar

Utgivningen av Llama 4 markerar en betydande milstolpe i AI-landskapet, med långtgående konsekvenser för forskning, utveckling och tillämpningar. Historiskt sett har lamamodeller varit en katalysator för nedströmsforskning och inspirerat till olika studier och innovationer. Llama 4-versionen förväntas fortsätta denna trend, vilket gör det möjligt för forskare att bygga vidare på och finjustera modellerna för att hantera komplexa uppgifter och utmaningar.

Många modeller har finjusterats och byggts ovanpå Llama-modeller, vilket visar mångsidigheten och potentialen hos Llama-arkitekturen. Llama 4-versionen kommer sannolikt att accelerera denna trend när forskare och utvecklare utnyttjar modellerna för att skapa nya och innovativa applikationer. Detta är viktigt eftersom Llama 4 är en stark modellrelease och kommer att möjliggöra ett brett utbud av forsknings- och utvecklingsaktiviteter.

Det är värt att notera att Llama 4-modellerna, liknande sina föregångare, är icke-tänkande. Därför kan framtida Llama 4-seriesläpp potentiellt eftertränas för resonemang, vilket ytterligare förbättrar deras prestanda.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde