Vid VMware Explore 2023-evenemanget presenterade VMware nya privata AI-erbjudanden som syftar till att främja införandet av generativ AI inom företag och utnyttja potentialen hos betrodd data. VMware Private AI kännetecknas av dess arkitektoniska tillvägagångssätt och balanserar fördelarna med AI med den praktiska integritets- och efterlevnadskraven för organisationer.

Vid VMware Explore 2023-evenemanget presenterade VMware nya privata AI-erbjudanden som syftar till att främja införandet av generativ AI inom företag och utnyttja potentialen hos betrodd data. VMware Private AI kännetecknas av dess arkitektoniska tillvägagångssätt och balanserar fördelarna med AI med den praktiska integritets- och efterlevnadskraven för organisationer.

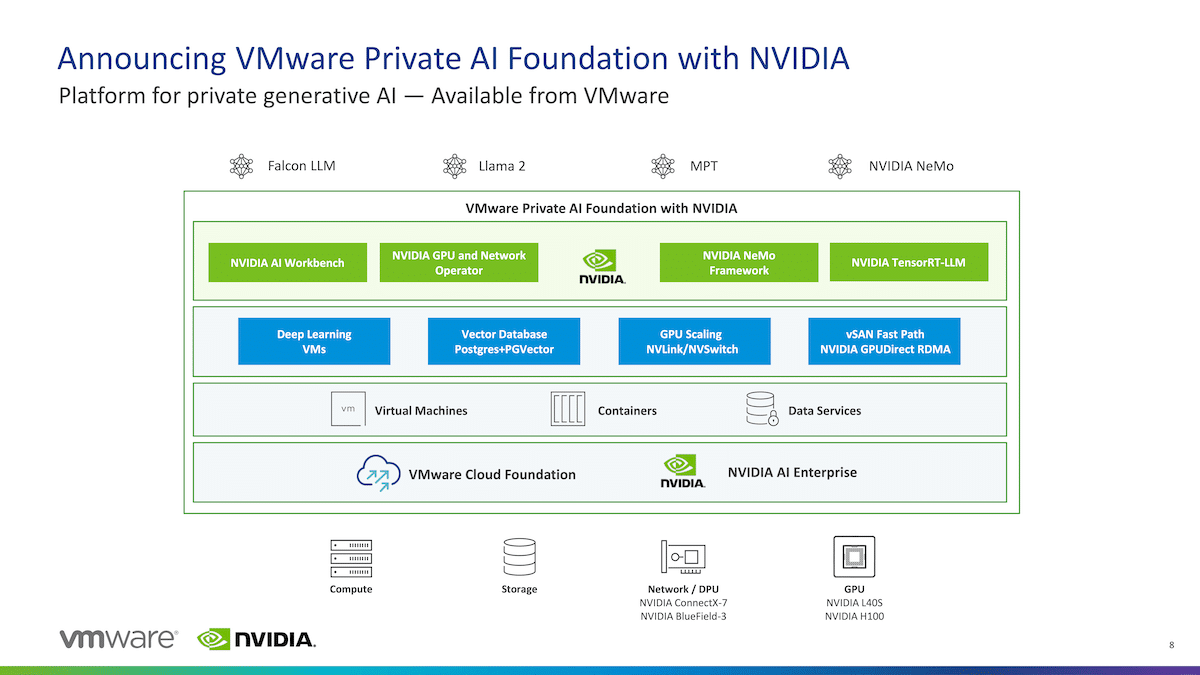

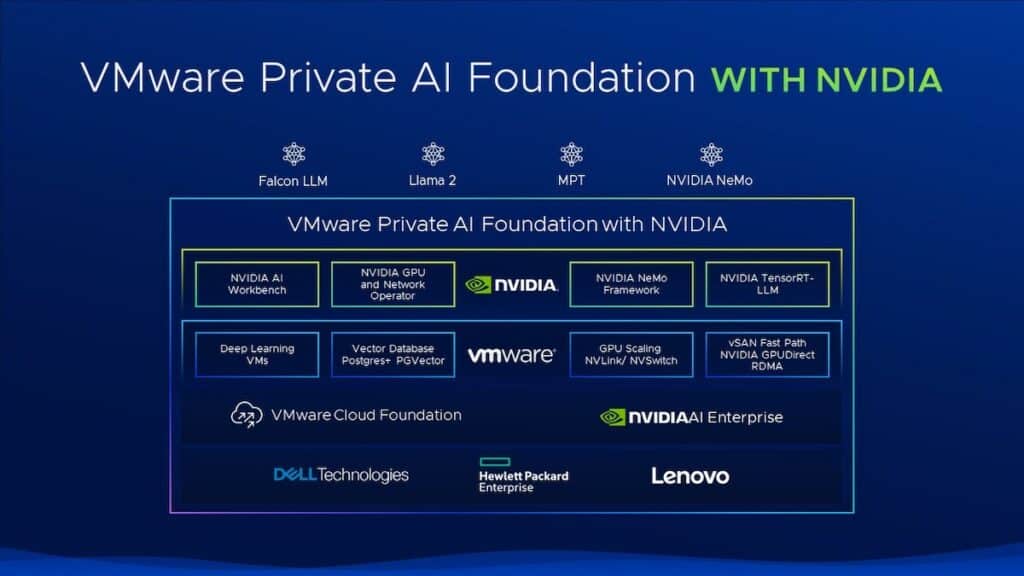

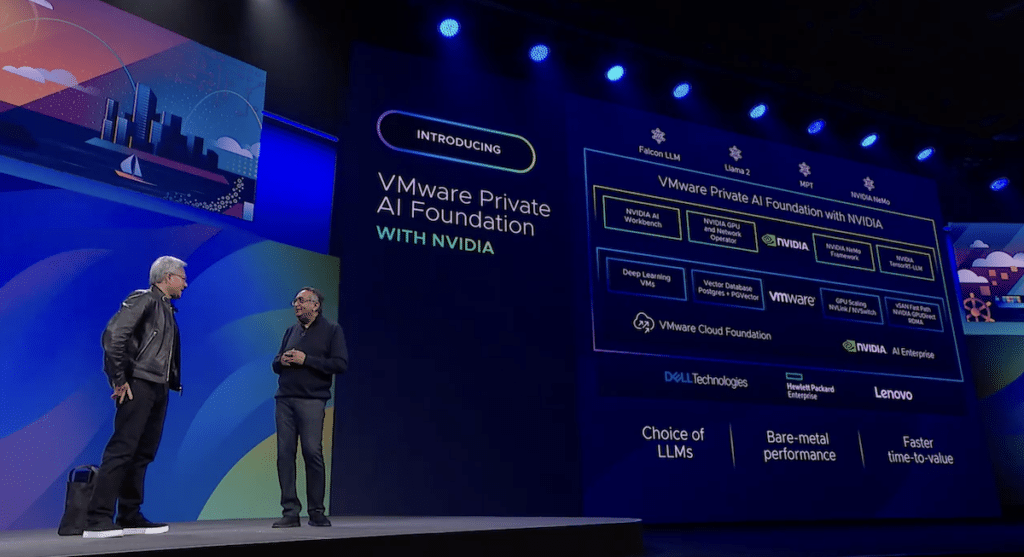

VMware Private AI Foundation med NVIDIA kommer att göra det möjligt för företag att anpassa modeller och köra generativa AI-applikationer, inklusive intelligenta chatbots, assistenter, sökning och sammanfattningar. Plattformen kommer att vara en helt integrerad lösning med generativ AI-mjukvara och accelererad datoranvändning från NVIDIA, byggt på VMware Cloud Foundation och optimerad för AI.

VMware Private AI Foundation med NVIDIA-erbjudande bygger på sitt strategiska partnerskap och ger företag implementering på VMwares molninfrastruktur med verktyg för att omfamna det växande intresset för generativ AI. Denna tillägg integrerar VMwares privata AI-arkitektur med NVIDIA AI Enterprise-programvara och accelererad datoranvändning, vilket ger en nyckelfärdig lösning för att distribuera generativa AI-applikationer över datacenter, offentliga moln och kanten.

För att uppnå affärsfördelar snabbare försöker företag effektivisera utvecklingen, testningen och driftsättningen av generativa AI-applikationer. VMware Private AI Foundation med NVIDIA kommer att göra det möjligt för företag att utnyttja denna kapacitet, anpassa stora språkmodeller, producera säkrare och privata modeller för intern användning och erbjuda generativ AI som en tjänst till sina användare, och säkert köra slutledningsarbetsbelastningar i stor skala.

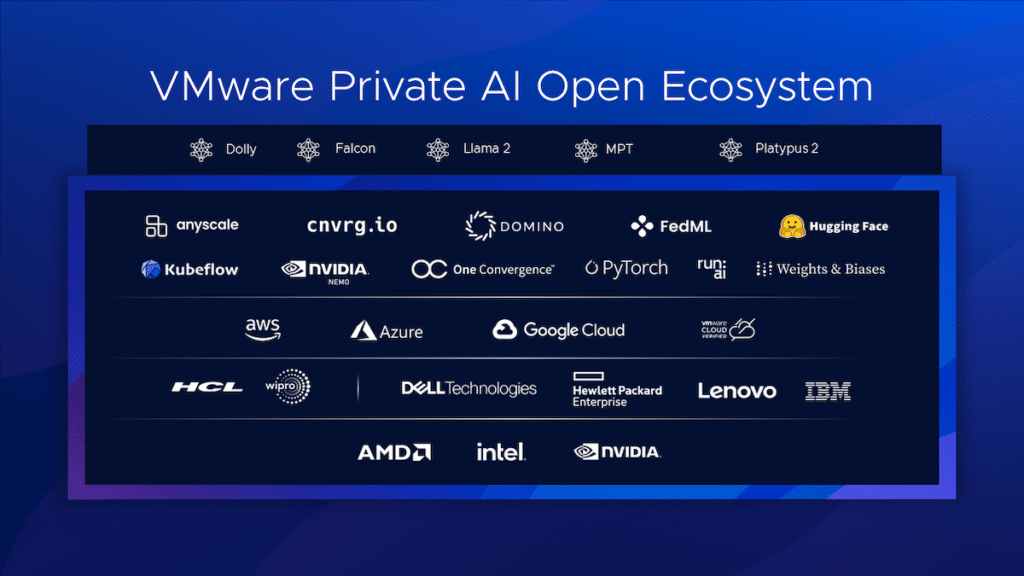

Plattformen förväntas inkludera integrerade AI-verktyg för att ge företag möjlighet att köra beprövade modeller utbildade på deras privata data kostnadseffektivt. Kunder får önskade AI-resultat med VMware Private AI Reference Architecture för öppen källkod som utnyttjar högklassig öppen källkodsprogramvaruteknik för att tillgodose nuvarande och framtida krav.

Plattformen förväntas bygga på VMware Cloud Foundation och NVIDIA AI Enterprise-programvara, med många fördelar. Ur ett integritetsperspektiv kan kunder köra AI-tjänster i anslutning till där data finns med en arkitektur som bevarar datasekretess med säker åtkomst.

Företag kommer att ha ett brett urval av var de ska bygga och köra sina modeller, från NVIDIA NeMo till Llama 2. Det inkluderar OEM-hårdvarukonfigurationer och, i framtiden, offentliga moln- och tjänsteleverantörer.

Den förväntade prestandan bör vara lika med eller överstiga ren metall med plattformen som körs på NVIDIA-accelererad infrastruktur. GPU-skalningsoptimeringarna i virtualiserade miljöer kommer att göra det möjligt för AI-arbetsbelastningar att skala upp till 16 vGOU:er/GPU:er i en enda virtuell dator och flera noder för att påskynda finjustering och implementeringar av generativ AI-modell.

Att maximera användningen av alla beräkningsresurser över GPU:er, DPU:er och processorer innebär att de totala kostnaderna förväntas bli lägre samtidigt som man skapar en poolad resursmiljö som delas mellan team. VMware vSAN Express Storage Architecture (ESA) kommer att leverera prestandaoptimerad NVMe-lagring, som stöder GPUDirect-lagring över RDMA och ger direkt I/O-överföring från lagring till GPU:er utan att involvera processorn.

Den djupa integrationen mellan vSphere och NVIDIA NVSwitch kommer att göra det möjligt för multi-GPU-modeller att köras utan inter-GPU-flaskhalsar som levererar accelererat nätverk.

Alla dessa fördelar kommer att betyda lite om det tar för lång tid att implementera och realisera tid till värde. Med vSphere Deep Learning VM-bilder och bildarkiv erbjuder snabba prototypfunktioner en stabil nyckelfärdig lösningsbild som inkluderar förinstallerade ramverk och prestandaoptimerade bibliotek.

NVIDIA NeMo, ett end-to-end, molnbaserat ramverk och operativsystemet för NVIDIA AI-plattformen som ingår i NVIDIA AI Enterprise, är en plattformsfunktion. NeMo låter företag bygga, anpassa och distribuera generativa AI-modeller praktiskt taget var som helst, genom att kombinera anpassningsramverk, skyddsräckesverktyg, verktyg för datakurering och förutbildade modeller för att erbjuda företag en enkel, kostnadseffektiv och effektiv väg till generativ AI-adoption.

Genom att distribuera generativ AI i produktionen använder NeMo TensorRT för stora språkmodeller (TRT-LLM), vilket accelererar och optimerar slutledningsprestanda på de senaste LLM:erna på NVIDIA GPU:er. Med NeMo gör VMware Private AI Foundation med NVIDIA det möjligt för företag att dra in sin data för att bygga och köra anpassade generativa AI-modeller på VMwares hybridmolninfrastruktur.

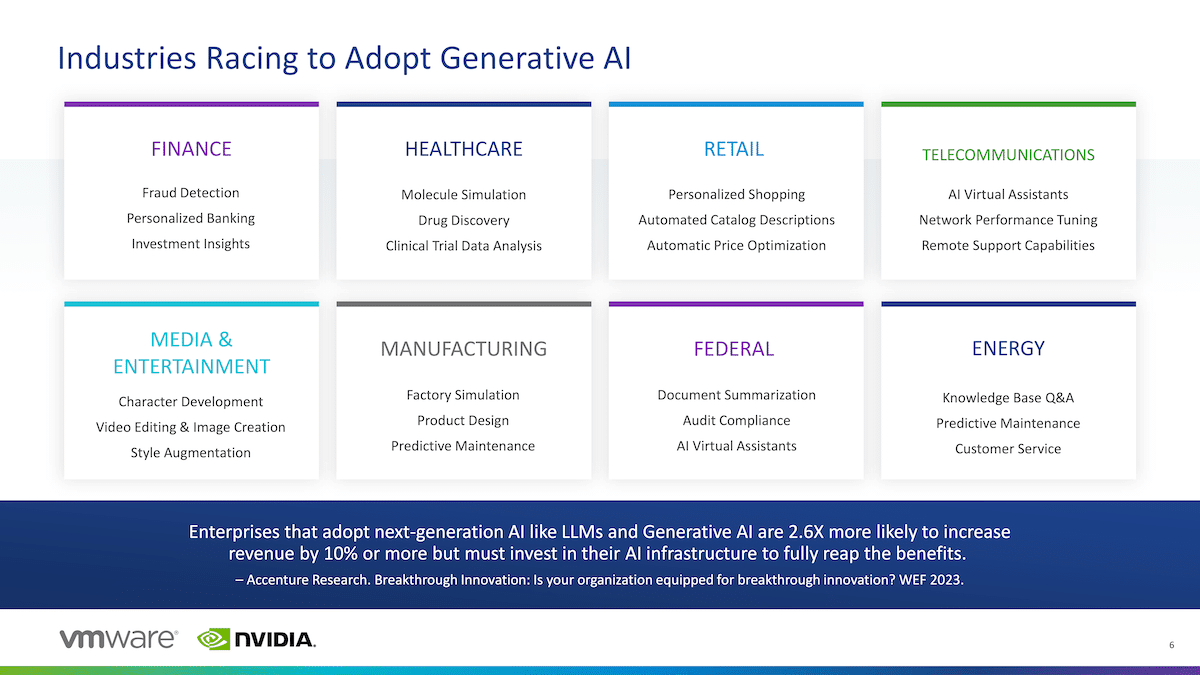

VMware Private AI Foundation utökar AI-funktioner och -modeller till där företagsdata genereras, bearbetas och konsumeras, oavsett om det är inom ett offentligt moln, företagsdatacenter eller vid kanten. Genom att introducera dessa nya erbjudanden vill VMware göra det möjligt för kunder att kombinera flexibilitet och kontroll, vilket driver fram en ny generation av AI-drivna applikationer. Applikationerna har potentialen att avsevärt förbättra arbetarnas produktivitet, utlösa omvandling mellan viktiga affärsfunktioner och skapa betydande ekonomisk påverkan – en McKinsey-rapport projicerar generativ AI för att bidra med upp till 4.4 biljoner dollar årligen till den globala ekonomin.

Avgörande för framgången med denna utveckling är etableringen av en miljö med flera moln, eftersom det banar väg för privat men brett spridd dataanvändning. VMwares multimolnstrategi ger företag större flexibilitet när det gäller att bygga, anpassa och distribuera AI-modeller med hjälp av privata data samtidigt som säkerhet och motståndskraft säkerställs i olika miljöer.

Raghu Raghuram, VD för VMware, betonar att lönsamheten för generativ AI beror på att upprätthålla datasekretess och minimera IP-risker. VMware Private AI tar itu med dessa problem, vilket gör det möjligt för organisationer att utnyttja sin betrodda data för effektiv AI-modellbyggnad och exekvering i en miljö med flera moln.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde