SAS 616iSD 10G är en del av en omfattande linje av block-nivå lagringsmatriser som erbjuds av JetStor. iSCSI 616iSD erbjuder upp till 48 TB lagring via 16 3.5-tumsfack i ett 3U-hölje. JetStor har dubbla redundanta aktiva/aktiva RAID-kontroller och fyra 10 GbE-portar, två per kontroller. Varje kontroller drivs av en Intel IOP342 64-bitars Chevelon dual-core lagringsprocessor och inkluderar funktioner som paritetsassist ASIC, iSCSI-assistmotor och TCP Offload Engine (TOE). Skulle 48TB visa sig vara otillräckligt kan 616iSD utökas med fyra JBOD-hyllor (SAS716J) för en maximal kapacitet på 240TB per array.

Till sin natur är JetStor SAS 616iSD 10G designad för att vara enkel. Slå på den, ge den åtkomst till Ethernet-tyget och kör iväg. JetStors enkelhet i design fungerar genomgående, med funktioner som en kabellös design internt, som även om den förmodligen aldrig har setts, erbjuder en större användarvänlighet om något skulle gå fel. Enheten inkluderar även dubbla strömförsörjningar, turbokylningsfläktar och tre års garanti som täcker alla komponenter med telefon- och e-postsupport under enhetens livstid.

Specifikationer för Jetstor SAS 616iSD 10G

- Värdportar: Två, 10 Gigabit Ethernet med iSCSI-protokoll, SFP+ värdgränssnitt per redundant styrenhet

- Diskgränssnitt: 3Gb/s SAS

- Erbjudna hårddiskar: 300GB (15k), 450GB (15k), 600GB SAS (15k), 1TB (7.2k), 2TB (7.2k) och 3TB (7.2k)

- Enheter: 16 (3.5”)/ Upp till 160 genom två 3Gb/s SAS-expansionsportar

- RAID-lägen som stöds: RAID 0, 0+1, 1, 3, 5, 6, 10, 30, 50 och RAID 60, Global Hot Spare Disk, Auto Rebuild

- Intel IOP342 64-bitars Chevelon dual-core lagringsprocessor på varje styrenhet

- 2 GB cache (standard) – 4 GB (valfritt) / DDR2-800 ECC registrerat SDRAM

- Valfri batteribackup

- Två RJ45/Ethernet Management/ Monitor portar

- SMTP-hanterare och SNMP-agent

- Kraft och kylning

- Fyra turbofläktar

- Ström 110 eller 220 VAC, ±20 % @ 6 ampere / 3 ampere topp

- Två 460W PS/fläktmoduler m/PFC

- Miljö

- Relativ luftfuktighet 10 % till 85 % icke-kondenserande (drift)

- Driftstemperatur 50°F till 104°F

- 3U fysiska mått (B x D x H) 19 tum bred, 22 tum djup, 5.25 tum hög

- Vikt (utan drivenheter) 40 lb. / 18 kg.

- Operativsystem som stöds: VMWare ESX Server, vSphere, Windows Server 2008, Windows Server 2003, XenServer, Oracle/Solaris, Linux, MAC OS X och andra kommer att tillkännages

- Garanti: 3 års logik, 3 års strömförsörjning, 5 år SAS-enheter, 3 eller 5 år SATA-enheter

Design och bygga

JetStor SAS 616iSD är ett 16-fack 10GbE-utrustat SAN med dubbla kontroller. Framsidan av 616iSD har ett grundläggande användargränssnitt som visar information som t.ex. aktuell hanterings-IP utan att behöva dyka in i din router eller DHCP för att spåra vilken IP som ska användas för sin webbaserade hantering. Den främre konsolen inkluderar en LCD, samt en handfull knappar för att gå igenom menyer för att få tillgång till SAN lokalt. För att hantera hårdvaruaspekterna i JetStor-modellen, vänd helt enkelt upp hela ansiktet och få tillgång till de sexton 3.5-tumsfacken under.

Vår recension JetStor SAS 616iSD 10G inkluderade tolv Seagate Cheetah 15K.7 ST3600057SS 600GB hårddiskar, även om systemet kan konfigureras med en mängd olika 15K och 7,200 XNUMX RPM-enheter. Varje enhet är monterad i sin egen hot-swap-caddy, vilket gör det enkelt att byta ut i händelse av ett diskfel. Varje drivbricka inkluderar också en grundläggande låsmekanism för att förhindra att fel drivenhet av misstag matas ut i en produktionsmiljö.

För att enkelt montera SAS 616iSD 10G i rack, inkluderar JetStor ett grundläggande, glidande skenpaket som enkelt ställs in på några minuter. Eftersom tyngden av SAN lätt väger in i kategorin "laglyft", är det förmodligen bäst att få hjälp med att lyfta in SAN i racket när skenorna är monterade. Skenorna är lätta att rikta in i mottagningsslitsarna, och den förblir stadigt placerad i vår Eaton 42U ställ utan någon indikation på hängning när den väl är monterad.

Vyn från baksidan av JetStor SAS 616iSD 10G visar redundanta diskkontroller och strömförsörjning. Båda dessa tas snabbt bort med tumskruvar, med hjälp av en inbyggd spak och handtagsmekanism för att både ta bort och stadigt låsa på plats. Gränssnittsanslutningar på baksidan inkluderar två SFP+-anslutningar per kontrollenhet (en port på varje är fylld med en fiberoptisk transceiver på vår granskningsenhet), en hanteringsport per kontrollenhet, samt en SFF-8088 SAS-kontakt per kontrollenhet för extern JBOD-expansion använder SAS716J. Det finns även UPS- och RS-232-kontakter för att möjliggöra kommunikation med annan utrustning.

I det osannolika fallet att en styrenhet behöver bytas ut tog det oss inte mer än 60 sekunder att ta bort och sätta tillbaka enheten när den installerades i vårt rack. Även om låsspakarna har tumskruvar rekommenderar JetStor fortfarande att fälttekniker drar åt skruvarna med en platt skruvmejsel för att se till att allt är säkert installerat.

Strömförsörjningen var lika enkel att ta bort och installera om, även om dess större storlek krävde mer noggrann ansträngning för att rensa omgivande kablar och utrustning på baksidan av vårt testställ.

JetStor-webbhanteringsverktygen som erbjuds för att konfigurera SAS 616iSD är enkla att följa, men ganska grundläggande när det gäller design och implementering. Från första inloggningen var det ganska lätt att få systemet att fungera, även om gränssnittet ibland verkade långsamt. För en SMB eller mindre företagsmiljö skulle det vara lätt att hantera några av dessa plattformar tillsammans, även om en miljö med mer än en handfull kan orsaka problem med att behöva logga in på varje enhet för att konfigurera individuellt.

Testbakgrund och jämförelser

När det kommer till att testa företagshårdvara är miljön lika viktig som testprocesserna som används för att utvärdera den. På StorageReview erbjuder vi samma hårdvara och infrastruktur som finns i många datacenter där de enheter vi testar i slutändan skulle vara avsedda för. Detta inkluderar företagsservrar såväl som lämplig infrastrukturutrustning som nätverk, rackutrymme, strömkonditionering/övervakning och jämförbar hårdvara av samma klass för att korrekt utvärdera hur en enhet presterar. Ingen av våra recensioner betalas för eller kontrolleras av tillverkaren av utrustningen vi testar.

StorageReview Enterprise Test Lab Översikt

StorageReview 10GbE Enterprise Testing Platform:

- 2 x Intel Xeon X5650 (2.66 GHz, 12 MB cache)

- Windows Server 2008 Standard Edition R2 SP1 64-bitars och CentOS 6.2 64-bitars

- Intel 5500+ ICH10R Chipset

- Minne – 8GB (2 x 4GB) 1333Mhz DDR3-registrerade RDIMM

Mellanox SX1036 10/40 Gb Ethernet-switch och hårdvara

- 36 40 GbE-portar (upp till 64 10 GbE-portar)

- QSFP splitterkablar 40GbE till 4x10GbE

- Mellanox ConnectX-3 EN PCIe 3.0 Twin 10G Ethernet-adapter

Vår nuvarande 10/40Gb Ethernet SAN- och NAS-testinfrastruktur består av vår Lenovo ThinkServer RD240-testplattform utrustad med Mellanox ConnectX-3 PCIe-adaptrar anslutna via Mellanox 36-portars 10/40GbE-switch. Denna miljö tillåter lagringsenheten vi testar att vara I/O-flaskhalsen, istället för själva nätverksutrustningen.

Syntetisk arbetsbelastningsanalys för företag

För lagringsuppsättningsrecensioner förutsätter vi med en tung belastning på 8 trådar med en enastående kö på 8 per tråd, och testar sedan i inställda intervaller i flera tråd-/ködjupsprofiler för att visa prestanda under lätt och tung användning. För tester med 100 % läsaktivitet är förkonditioneringen med samma arbetsbelastning, även om den har vänts till 100 % skrivning.

Förkonditionering och primära stationära tester:

- Genomströmning (Read+Write IOPS Aggregate)

- Genomsnittlig fördröjning (läs+skrivfördröjning i medeltal)

- Max fördröjning (maximal läs- eller skrivfördröjning)

- Latens standardavvikelse (läs+skriv standardavvikelse i genomsnitt)

För närvarande inkluderar Enterprise Synthetic Workload Analysis vanliga sekventiella och slumpmässiga profiler, som kan försöka återspegla verklig aktivitet. Dessa valdes för att ha viss likhet med våra tidigare riktmärken, samt en gemensam grund för att jämföra med allmänt publicerade värden som max 4K läs- och skrivhastighet, samt 8K 70/30 som vanligtvis används för företagsenheter. Vi inkluderade också två äldre blandade arbetsbelastningar, inklusive den traditionella filservern och webbservern som erbjuder en bred blandning av överföringsstorlekar. Dessa två sista kommer att fasas ut med applikationsriktmärken i dessa kategorier när de introduceras på vår webbplats och ersätts med nya syntetiska arbetsbelastningar.

- 1024K (sekventiell)

- 100% Läs eller 100% Skriv

- 8K (sekventiell)

- 100% Läs eller 100% Skriv

- 4K (slumpmässigt)

- 100% Läs eller 100% Skriv

- 8K 70/30 (slumpmässigt)

- 70 % läser, 30 % skriver

- Filserver (slumpmässig)

- 80 % läser, 20 % skriver

- 10% 512b, 5% 1k, 5% 2k, 60% 4k, 2% 8k, 4% 16k, 4% 32k, 10% 64k

- Webbserver (slumpmässig)

- 100% läst

- 22% 512b, 15% 1k, 8% 2k, 23% 4k, 15% 8k, 2% 16k, 6% 32k, 7% 64k, 1% 128k, 1% 512k

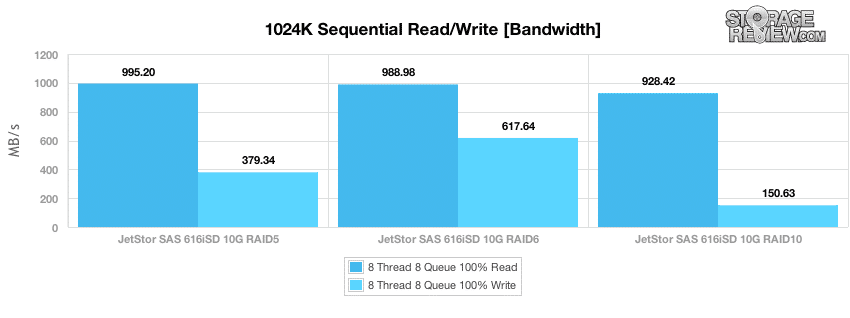

För att starta vår benchmarking tittar vi på sekventiell prestanda med stora block med en belastning på 8 trådar som var och en har en enastående kö på 8 I/O, som är utformad för att visa mättnadshastigheten för SAN över nätverket, vilket i det här fallet är 10 GbE över två anslutningar som använder MPIO, en per styrenhet. I våra tester gynnades toppsekventiell prestanda av RAID5- och RAID6-lägena framför RAID10. Hastigheterna varierade från 995MB/s som högst med RAID5 ner till 928MB/s med RAID10. Skrivprestandan var starkast med RAID6, som mätte 617MB/s, med RAID5 som kom in med 379MB/s och RAID10 mätte bara 150MB/s.

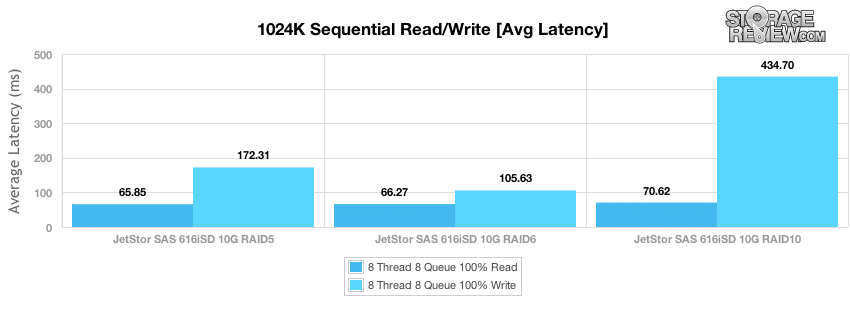

Genomsnittlig latens under vår sekventiella överföringsprestanda mätte 65ms för RAID5, 66ms för RAID6 och 70ms för RAID10 i vårt 1024k lästest, och 105ms i RAID6, 172ms i RAID5 och 434ms för RAID10 i vårt skrivsegment.

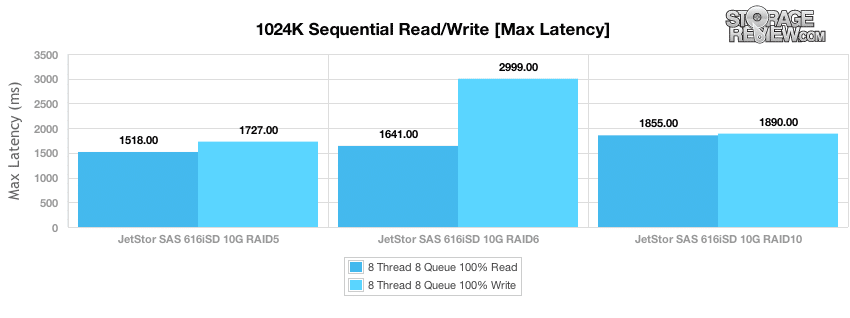

Medan genomsnittlig latens är ett viktigt mått att tänka på när man tittar på den övergripande prestandan, är det lika värdefullt att veta vad den värsta latensen kan vara. I fallet med JetStor SAS 616iSD hölls de maximala lässvarstiderna till 1,518 1,855-1,727 2,999 ms i läsaktivitet och XNUMX XNUMX-XNUMX XNUMX ms i skrivaktivitet.

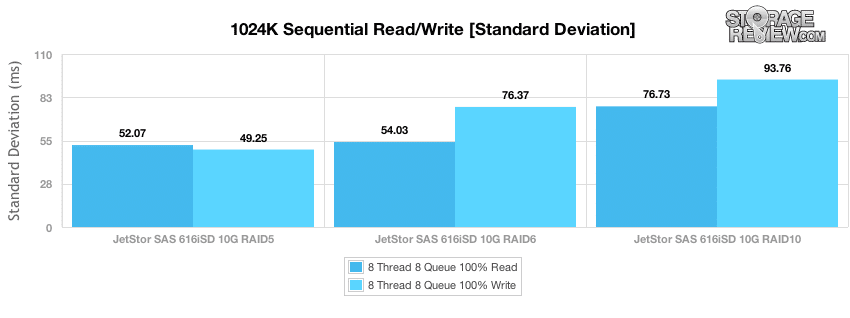

Det sista måttet vi tittar på i våra tester är latensstandardavvikelse, för att se hur tätt grupperad latensspridningen var under testets varaktighet. JetStor i RAID5 erbjöd den mest konsekventa prestandan i både läs- och skrivaktivitet med stora block, med RAID6 på andra plats, och RAID10 hade den bredaste spridningen i båda våra läs- och skrivtester.

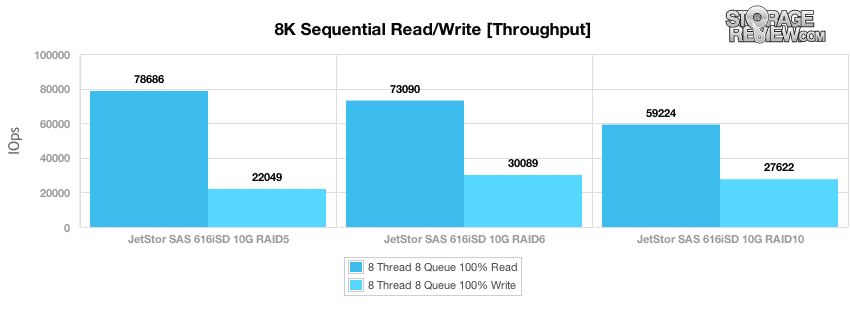

Medan 1024k sekventiell överföringstestet utformades för att mäta posten för bandbreddsmättnad, tittar vårt nästa test på småblocks sekventiell aktivitet med en 8K-överföring för att mäta I/O-genomströmning i ett bästa fall. Medan den mesta aktiviteten som ett SAN kan se i en produktionsmiljö kommer att vara slumpmässig eftersom fler system kommer åt det, kan nattlig backup eller bakgrundsaktivitet under vilotid se nära dessa hastigheter. Den högsta sekventiella 8K-läsprestandan vi mätte uppgick till 78,686 5 IOPS i en RAID73,090-konfiguration, och sjönk till 6 59,224 IOPS i RAID10 till 8 30,089 IOPS i RAID6. Peak 10K sekventiell skrivprestanda uppmättes till 27,622 5 IOPS i RAID22,049, med RAIDXNUMX med XNUMX XNUMX IOPS och RAIDXNUMX med XNUMX XNUMX IOPS.

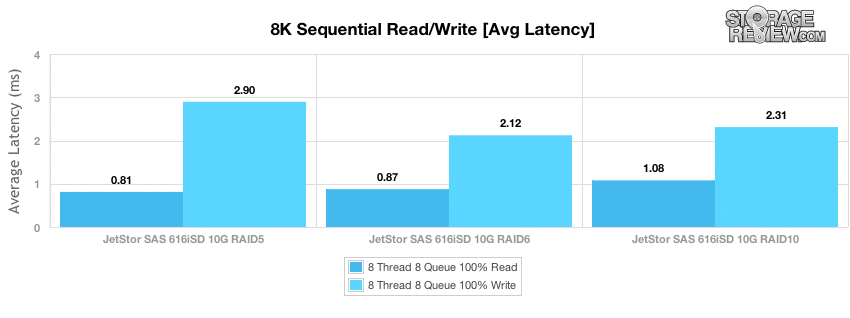

Den genomsnittliga sekventiella latensen för små block var låg över hela linjen i vårt 8K-överföringstest, där RAID5-läsningen kom in snabbast med en svarstid på 0.81 ms, RAID6 kom nästa med 0.87 ms och RAID10 med 1.08 ms. Skrivlatenserna var något högre med tanke på deras långsammare I/O-överföringsresultat, med RAID6 som mätte 2.12 ms, RAID10 med 2.31 ms och RAID5 med 2.9 ms.

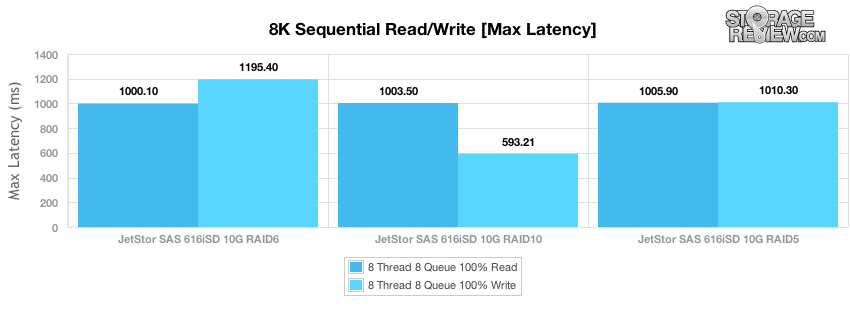

Max läslatens i vårt 8K sekventiell överföringstest mätte en topp på cirka 1,000 593 ms över hela linjen i lässegmentet i vårt test, med skrivtoppslatens som mätte 10 ms i RAID1,195 upp till 6 XNUMX ms i RAIDXNUMX.

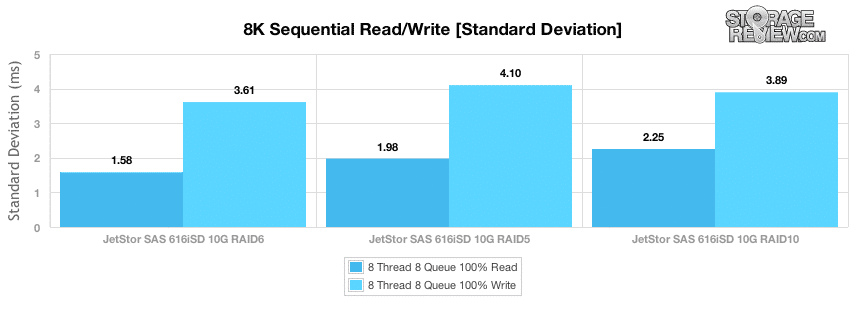

Om man tittar på spridningen av latensstandardavvikelsen bibehöll RAID6-läget den mest konsekventa sekventiella läsprestandan, med RAID5 RAID10 som var något mer inkonsekvent. RAID6 erbjöd också den bästa 8K sekventiella standardavvikelsen vid skrivöverföringar.

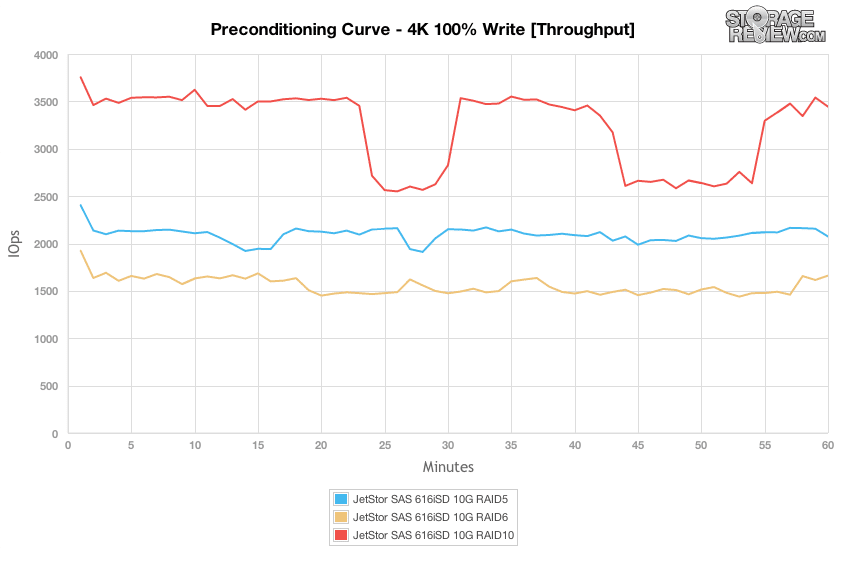

Vår nästa grupp av tester flyttar fokus till slumpmässiga arbetsbelastningar, där den första är 100 % 4K-skrivning i förkonditioneringssegmentet. När det gäller hur RAID-lägena stack upp, erbjöd RAID10 den högsta genomströmningen, med RAID5 och RAID6 som kom in under den. Det som dock var intressant var nedgångarna i prestanda från RAID10-arrayen, troligen orsakad av bakgrundsunderhåll, vilket RAID5- och RAID6-inställningarna inte hade.

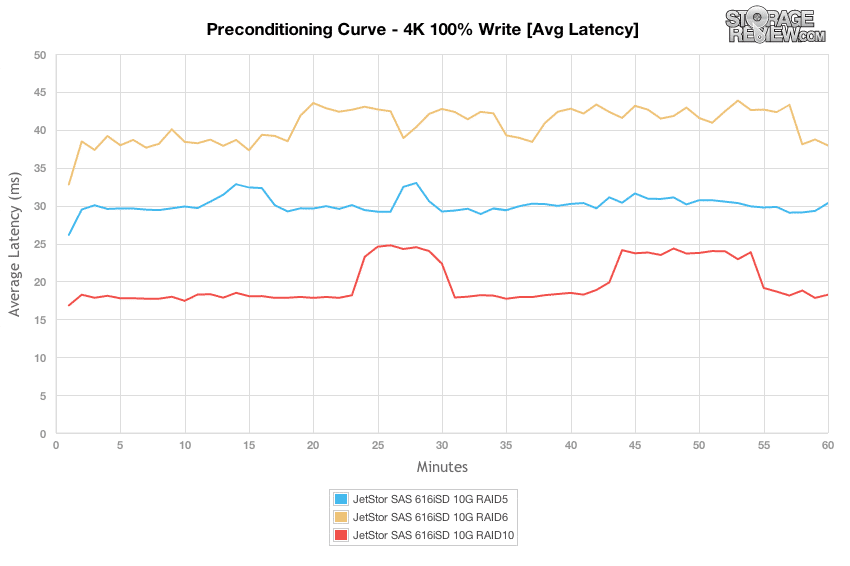

Om man tittar på den genomsnittliga latensen under vår förkonditioneringsfas, för varje RAID-läge kan du se hur inbyggd cache buffrade den inkommande slumpmässiga aktiviteten i 1-2 minuter, innan den planade ut till själva diskarnas prestanda.

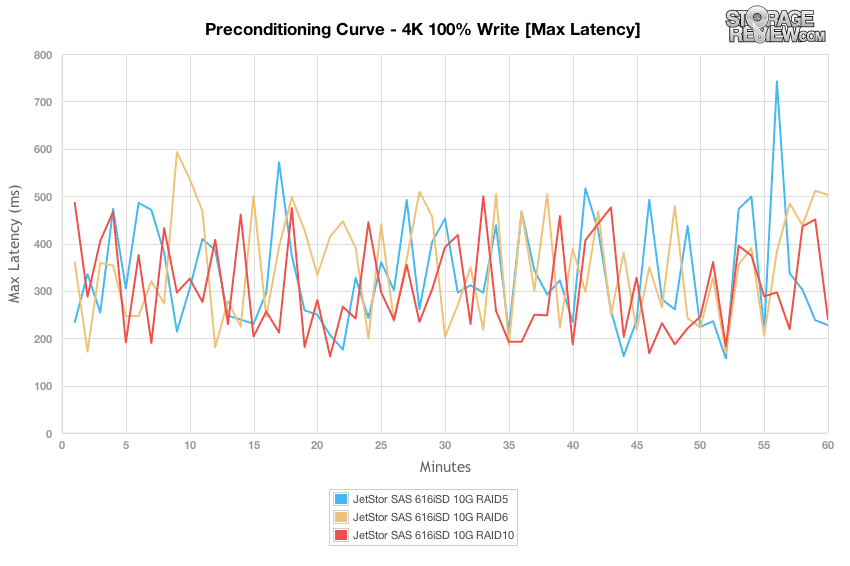

Under vår belastning på 8 trådar, var och en med 8 enastående I/O:er, flöt toppfördröjningen mellan 200-500ms för varje RAID-läge med 100 % 4K-skrivaktivitet.

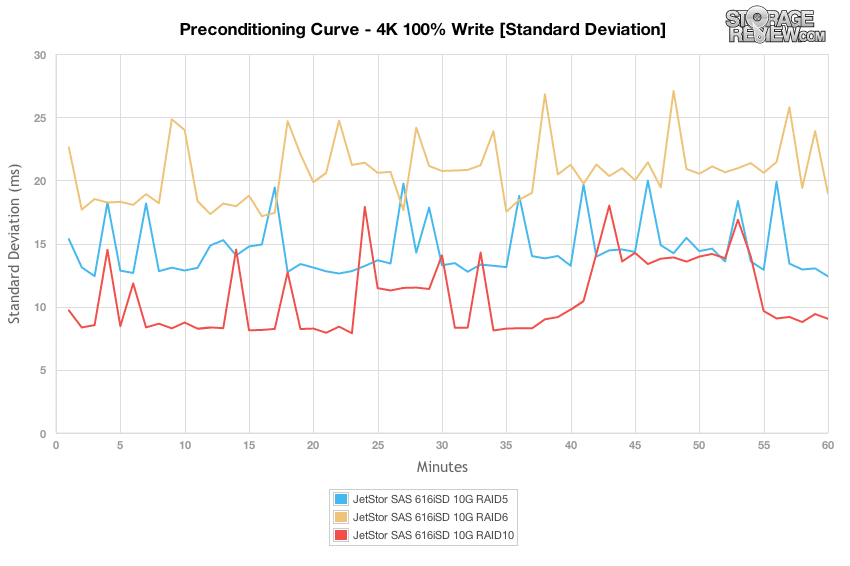

Genom att byta fokus till latensstandardavvikelse kan vi se att svarstiderna överensstämde mest med RAID10-konfigurationen, följt av RAID5 och RAID6.

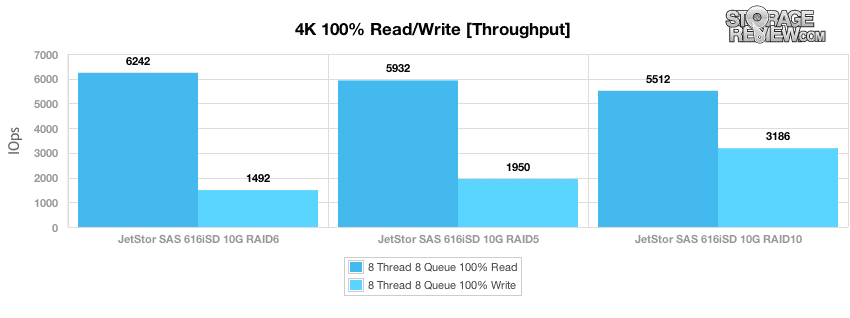

Efter att förkonditioneringsprocessen avslutats tog vi längre prover av 100 % 4K slumpmässig läs- och slumpmässig skrivprestanda från varje RAID-läge. RAID6 erbjöd de snabbaste läshastigheterna på 6,242 1,492 IOPS, även om långsammare skrivprestanda mätte 10 3,186 IOPS. RAID4 erbjöd den bästa slumpmässiga skrivprestandan som mätte 5,512 XNUMX IOPS, men hade långsammare XNUMXK slumpmässig läshastighet på XNUMX XNUMX IOPS.

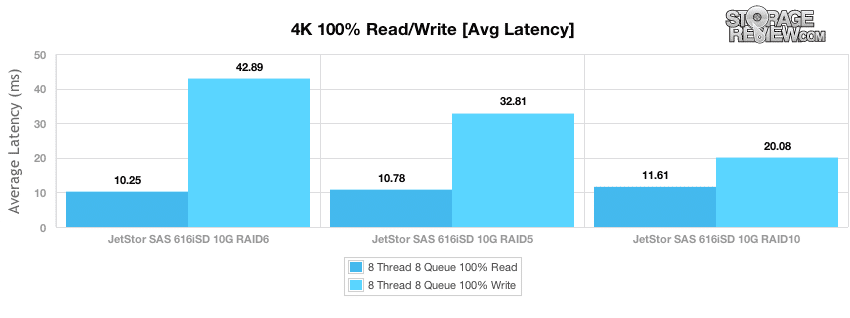

Med ett enastående effektivt ködjup på 64 mätte vi 4K slumpmässig läs- och skrivlatens i varje RAID-läge. Slumpmässig 4K-läsfördröjning varierade från 10.25 ms i RAID6 till 11.61 ms i RAID10. Skrivlatens skalad från 20.08 ms i RAID10 till 42.89 ms i RAID6.

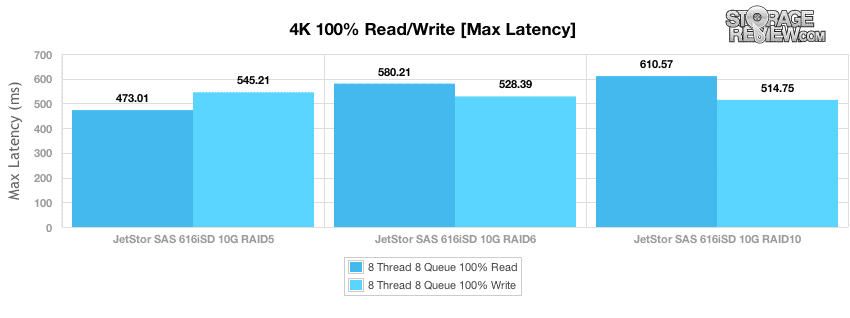

Under vår längre samplingsperiod utanför förkonditioneringsfasen mätte vi toppsvarstider från 473-610 ms i lästransaktioner och 514-545 ms under skrivaktivitet.

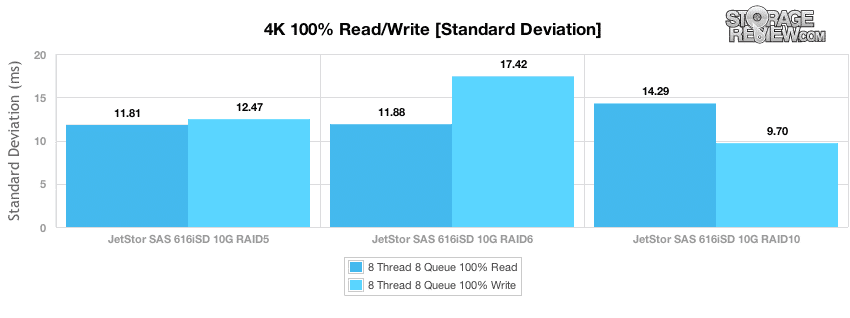

Medan topplatens visar de sämsta svarstiderna under samplingsperioden, visar standardavvikelsen spridningen av latens över hela testperioden. RAID5 erbjöd den mest konsekventa slumpmässiga 4K-läsfördröjningen, medan RAID10 erbjöd den mest konsekventa 4K-skrivfördröjningen.

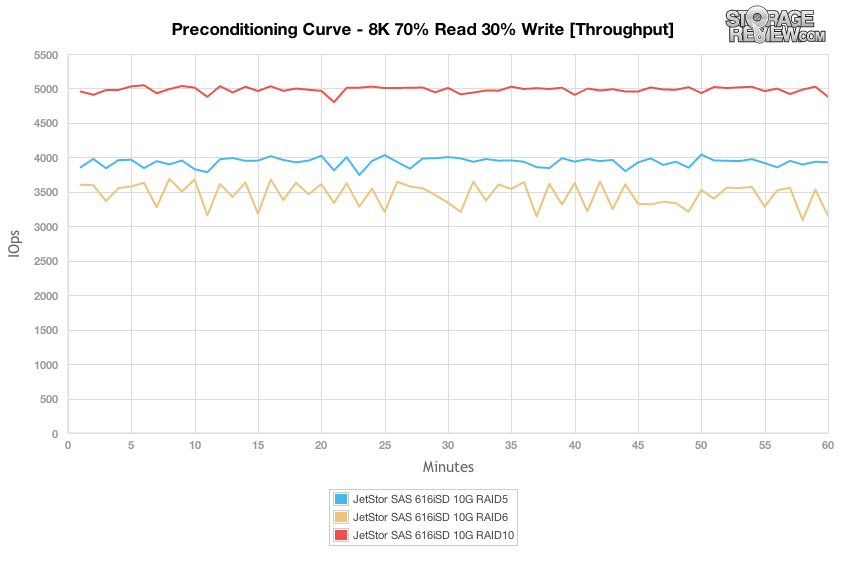

Nästa förkonditioneringstest fungerar med en mer realistisk läs/skriv-arbetsbelastningsspridning, jämfört med 100 % skrivaktivitet i våra 1024K, 100 % 8K eller 100 % 4K arbetsbelastningar. Här har vi en 70 % läs- och 30 % skrivmix av 8K slumpmässiga överföringar. Om vi tittar på vår 8K 70/30 blandade arbetsbelastning under en tung belastning på 8 trådar och 8 köer per tråd, ser vi att RAID10 erbjöd den högsta genomströmningen, följt av RAID5 och sedan RAID6. Prestandan var mycket konsekvent under hela förkonditioneringsprocessen, med endast mindre störningar i prestanda.

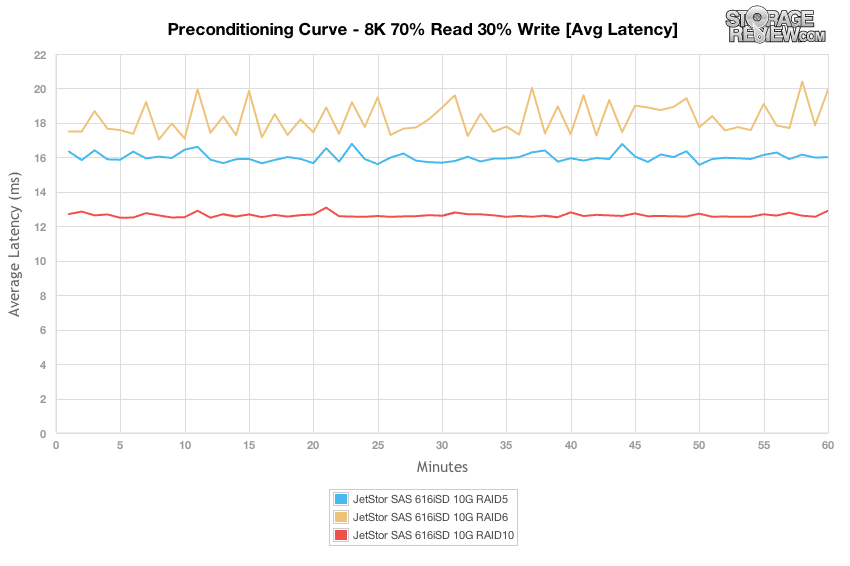

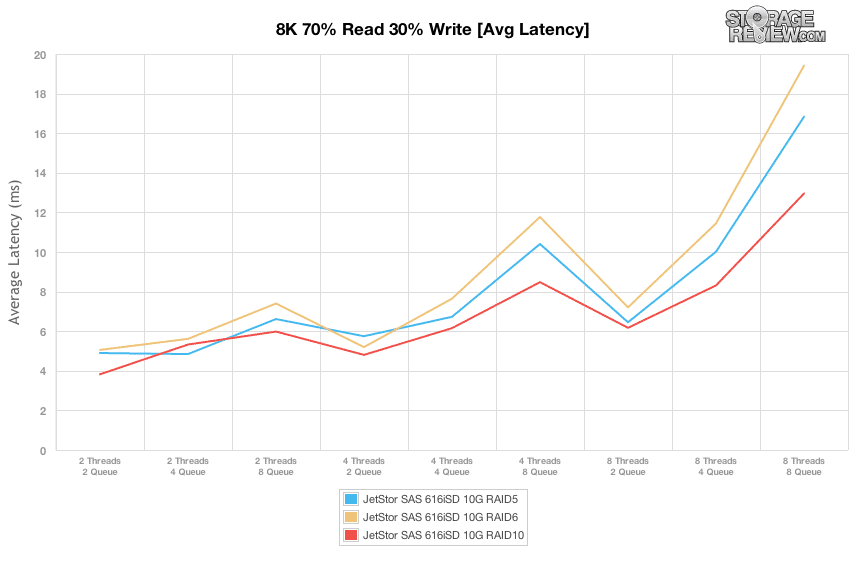

Om man tittar på spridningen av genomsnittlig latens under vår 8K 70/30 arbetsbelastning, var RAID10 den plattaste, mätte 12-13ms under testets varaktighet, följt av RAID6 med cirka 16-17ms, med RAID5 som mätte 17-20ms.

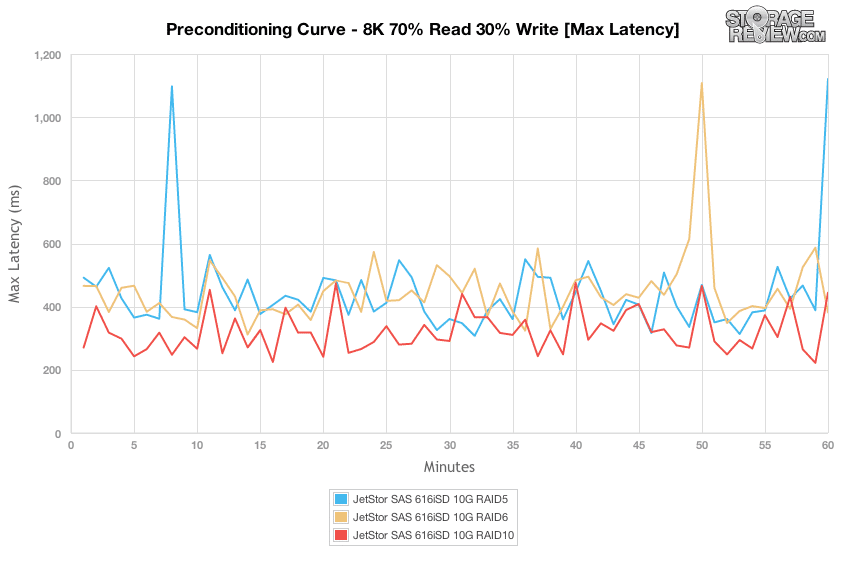

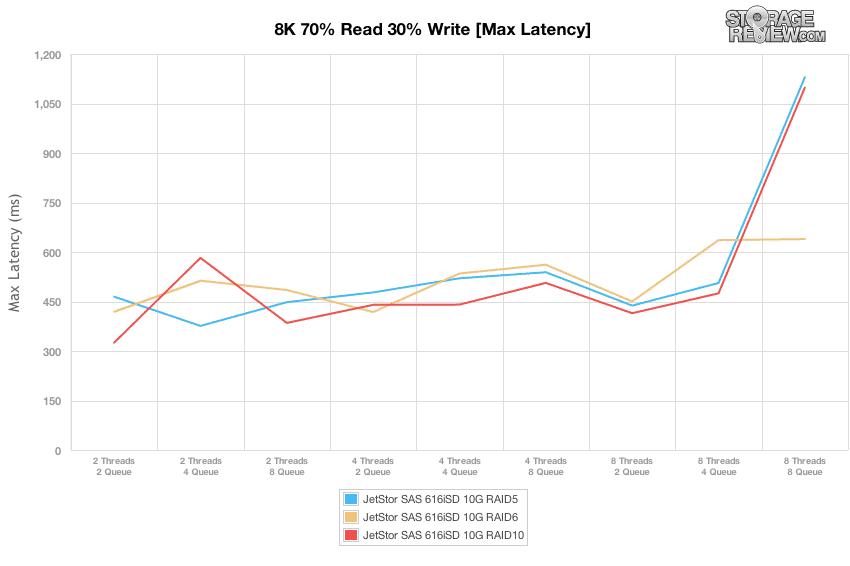

De maximala svarstiderna för varje RAID-typ var ganska konsekventa i bandet 300-500ms, med några blips över 1,000 5ms från RAID6- och RAIDXNUMX-RAID-typerna.

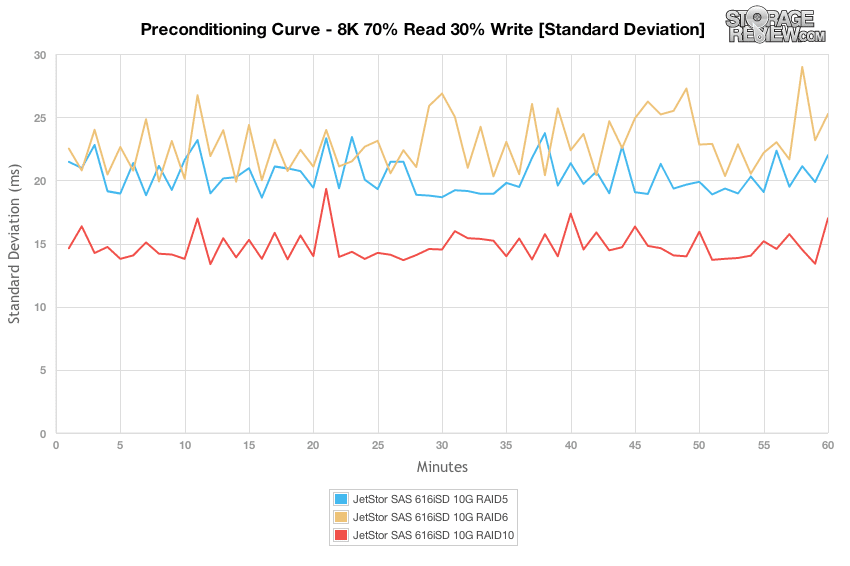

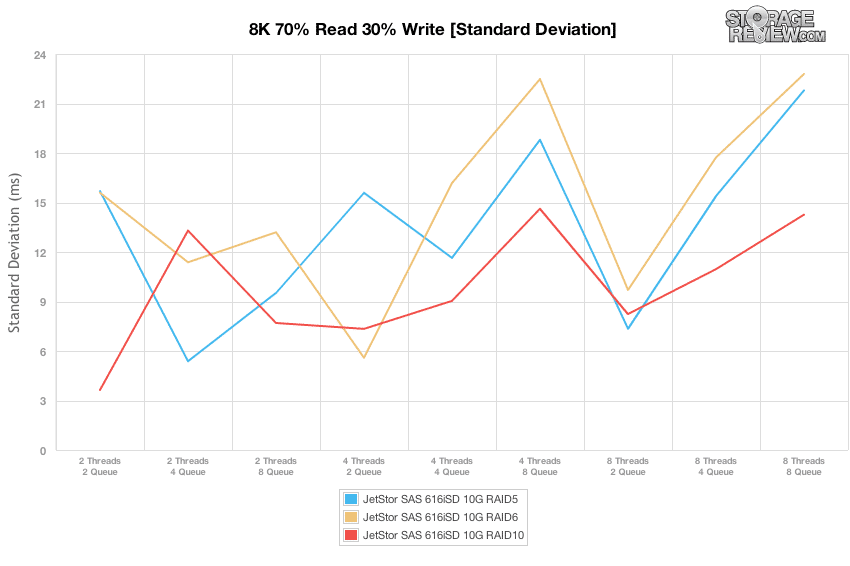

Genom att jämföra skillnaderna i latensstandardavvikelsen mellan RAID-typerna erbjöd RAID10 den mest konsekventa latensen, följt av RAID5 och sedan RAID6.

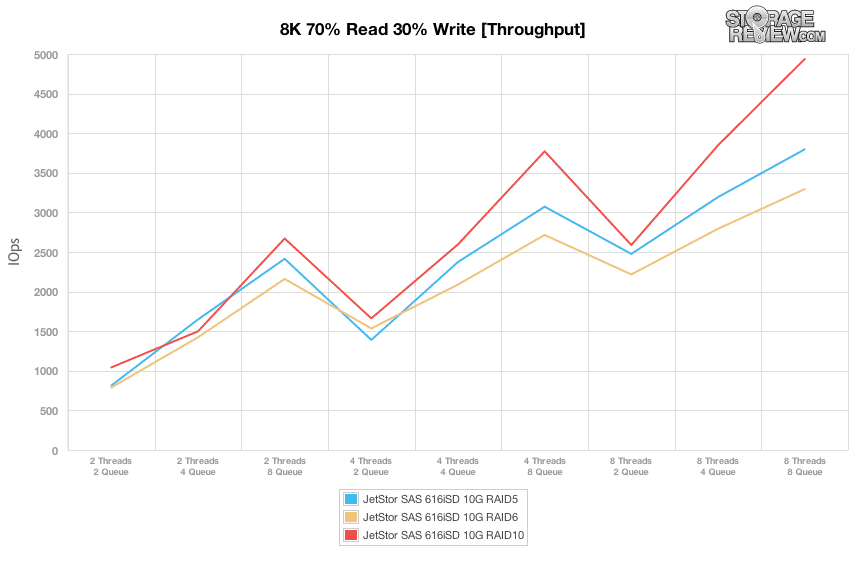

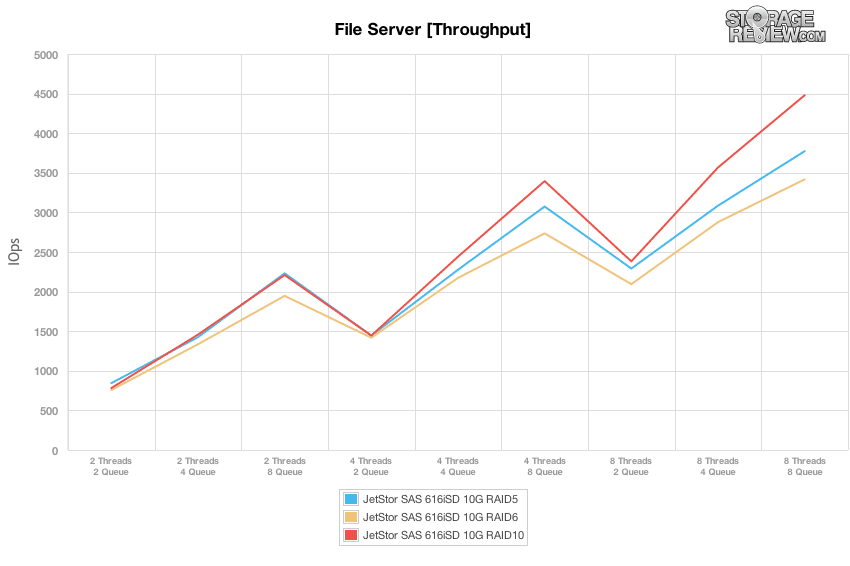

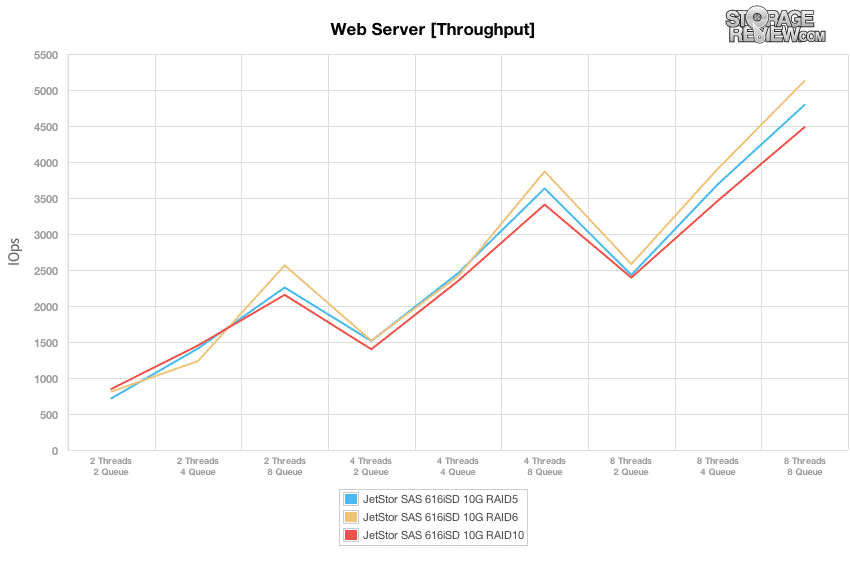

Jämfört med den fasta arbetsbelastningen med 8 trådar och 8 köer som vi utförde i 100 % 4K, 8K och 1024K-testerna, skalar våra profiler för blandad arbetsbelastning prestandan över ett brett utbud av tråd-/kökombinationer. I dessa tester spänner vi över vår arbetsbelastningsintensitet från 2 trådar och 2 köer upp till 8 trådar och 8 köer. Om man tittar på skillnaderna i genomströmning kördes varje RAID-läge ungefär i paritet med varandra i områden där det effektiva ködjupet var 16 och lägre. När det väl gick över 32, sett i arbetsbelastningarna 4T/8Q, 8T/4Q och 8T/8Q, erbjöd RAID10-läget den högsta prestandan, efterföljd av RAID5, och sedan av RAID6. Under det intervallet erbjöd varje RAID-läge liknande prestanda.

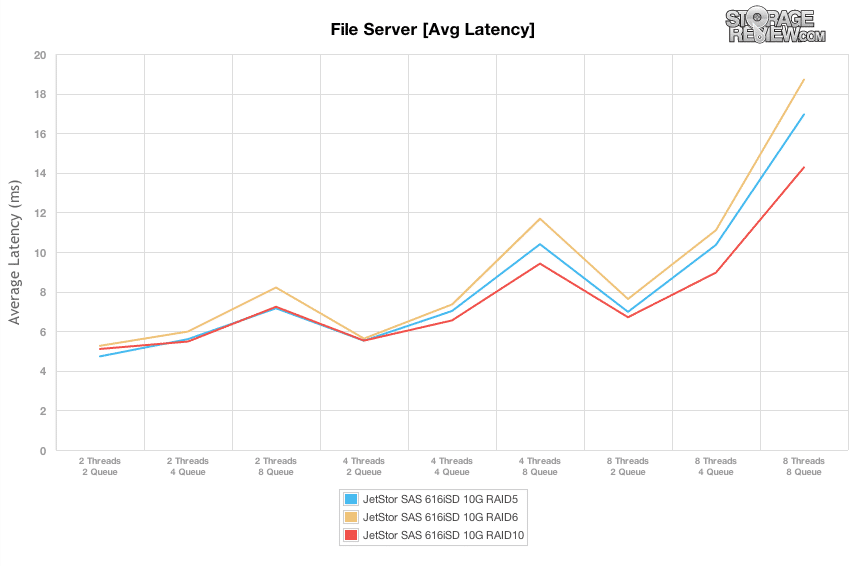

Även om det är viktigt att känna till toppkapacitetsintervallet, är det ännu viktigare att veta hur man ställer in din belastning för att matcha lagringsarrayen. Snabba I/O-hastigheter blandat med hög latens innebär bara en trög användarinteraktion, så att veta vilken prestandanivå du kan pressa ut innan latensen börjar öka markant är avgörande för användbarheten. Sweet spot i våra tester, som erbjöd den högsta genomströmningen, men också höll latensen relativt låg mellan 6-8ms, var vid 8T/2Q, där prestanda varierade mellan 2,250 2,750 och XNUMX XNUMX IOPS.

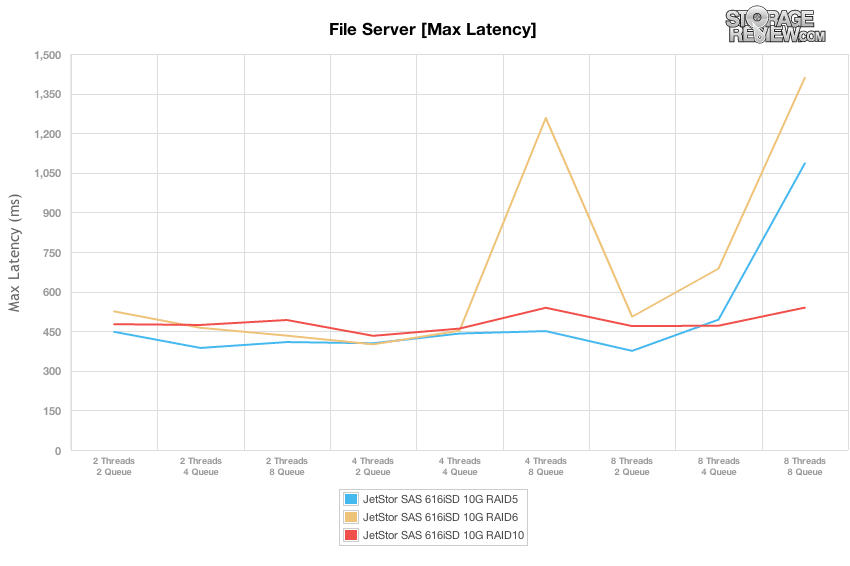

Genom att jämföra det effektiva ködjupet med topplatensen från JetStor SAS 616iSD, kunde SAN innehålla de högre svarstiderna till under 500ms fram till 8T/8Q-arbetsbelastningen. Vid den tidpunkten fördubblades topplatensen för RAID5 och RAID6.

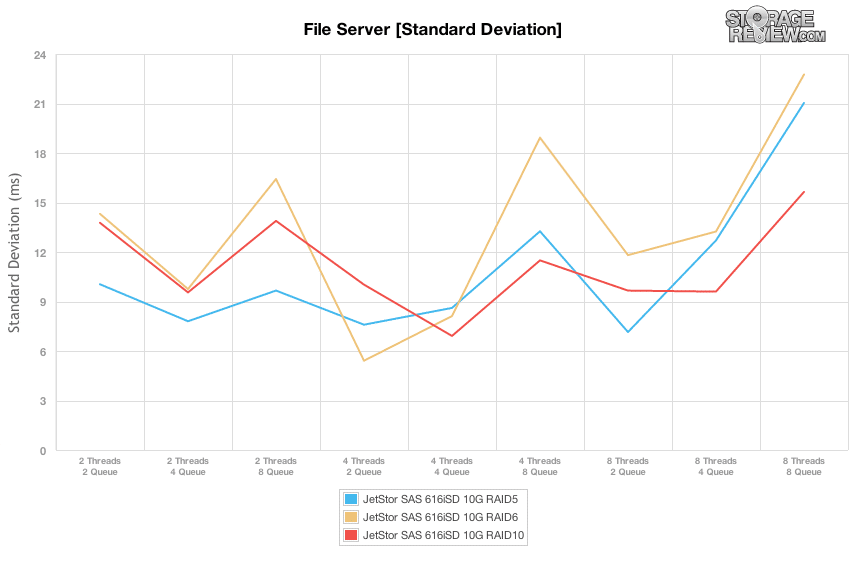

Genom att jämföra latensstandardavvikelsen i alla tre RAID-typerna erbjöd RAID10 en liten fördel, där RAID6 vanligtvis har den största spridningen. Den sweet spot för mest konsekvent latens var dock 8T/2Q-belastningen, som var optimal för alla RAID-typer.

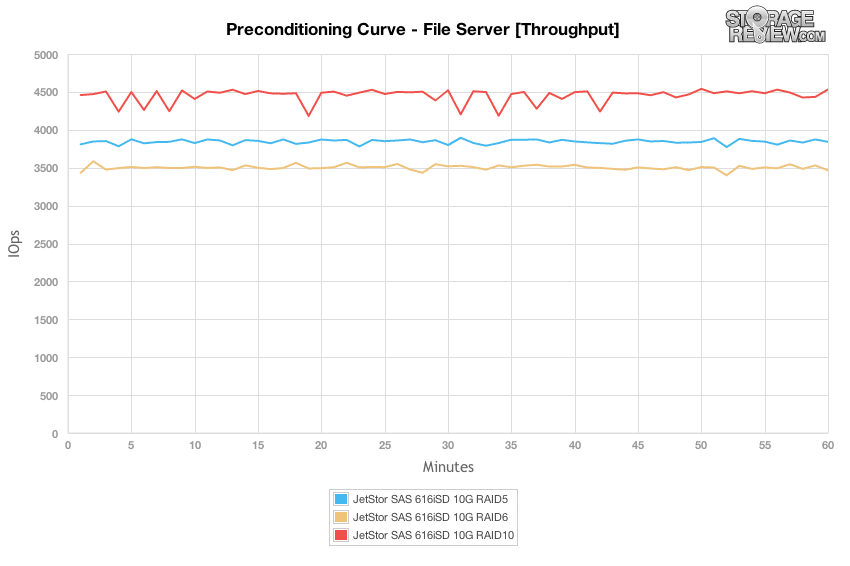

Filserverns arbetsbelastning representerar ett större spektrum av överföringsstorlekar som träffar varje enskild array, så istället för att sätta sig in i en statisk 4k eller 8k arbetsbelastning måste SAN klara av förfrågningar som sträcker sig från 512b till 64K. I likhet med de andra helt slumpmässiga arbetsbelastningarna erbjöd RAID10-konfigurationen den högsta genomströmningen, som mätte cirka 4,500 5 IOPS under hela vår förkonditioneringsprocess. RAID3,800 följde med en hastighet på 6 3,500 IOPS, med RAIDXNUMX efter med cirka XNUMX XNUMX IOPS. Varje RAID-typ erbjöd liknande prestanda från början till slut, med endast mindre variationer.

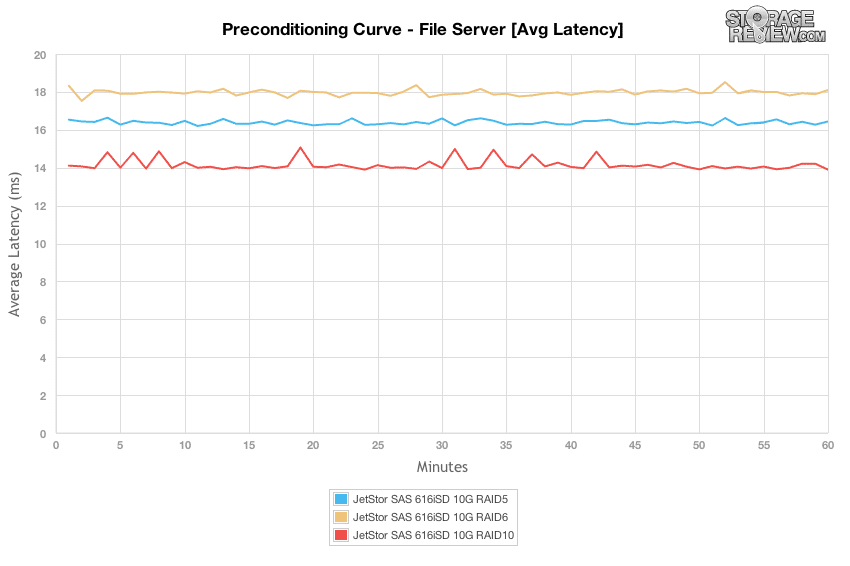

Om man tittar på genomsnittlig latens, förblev varje RAID-konfiguration ganska platt under förkonditioneringstestets varaktighet, med RAID10-läget på 14 ms, RAID5 vid 16.5 ms och RAID6 ovan vid 18 ms.

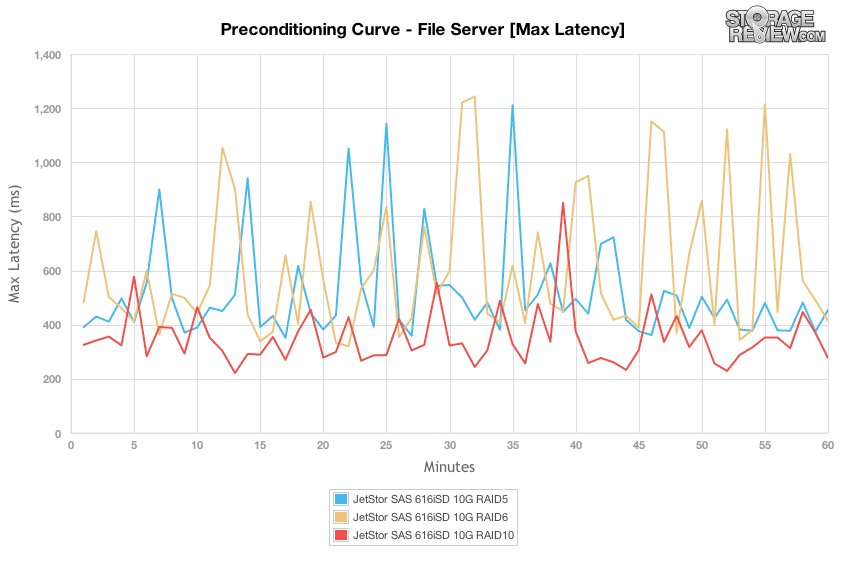

Toppsvarstiderna var mer spridda, från så låga som 200 ms till så höga som 1,200 10 ms under förkonditioneringsfasen. RAID250-konfigurationen var den lägsta, med en spridning från 800ms till drygt 5ms. RAID6 och RAID300 toppade dock högre från 1,200 ms till över XNUMX XNUMX ms.

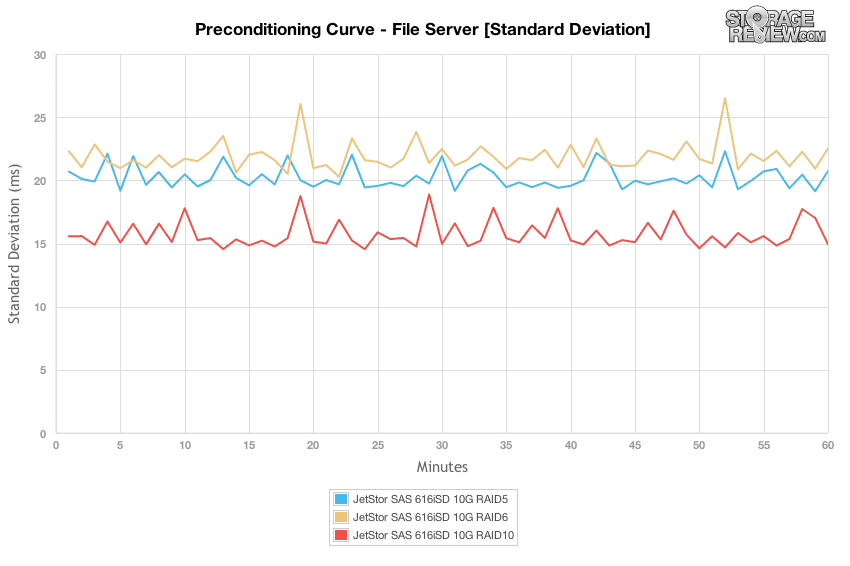

RAID10 erbjöd den mest konsekventa latensstandardavvikelsen, efterföljd av RAID5 och RAID6 som var ett steg över det.

När vi bytte till vårt skalade filservergenomströmningsdiagram där vi ökar belastningen från 2T/2Q till 8T/8Q, noterade vi en liknande trend där det vid eller under ett effektivt ködjup på 16 var mycket liten prestandaskillnad mellan var och en av RAID-typerna . Över den nivån erbjöd RAID10 högsta prestanda, följt av RAID5 och sedan RAID6.

Genom att byta till synen på genomsnittlig latens med vår filserver-arbetsbelastning flöt svarstiderna mellan 5-8 ms medan det effektiva ködjupet stannade på eller under 16, och hoppade sedan så högt som 14-19 ms under toppbelastning. Sweet spot, liknande 8K 70/30-arbetsbelastningen, var återigen vid 8T/2Q, där JetStor SAS 606iSD kunde erbjuda den högsta genomströmningen på 2,000 2,500-7 8 IOPS med en latens på XNUMX-XNUMXms.

I vårt filservertest höll sig max latens inom 400-500 ms för RAID5 och RAID6 upp till 8T/4Q och 8T/8Q, innan latensen ökade avsevärt. Max svarstider från RAID10 förblev konsekventa under hela varaktigheten av våra tester.

Standardavvikelsen från alla RAID-typer förblev konsekvent inkonsekvent under varaktigheten av det varierande belastningstestet. Vid högre belastningar där konfigurationerna nådde ett ködjup på 8 ökade variationen över hela linjen.

Vår senaste arbetsbelastning är ganska unik i sättet vi analyserar testets förkonditioneringsfas jämfört med huvudutgången. Eftersom en arbetsbelastning utformad med 100 % läsaktivitet är det svårt att visa varje enhets verkliga läsprestanda utan ett ordentligt förkonditioneringssteg. För att hålla konditioneringsarbetsbelastningen densamma som testarbetsbelastningen inverterade vi mönstret till 100 % skrivning. Av denna anledning är förkonditioneringsdiagrammen långsammare än de slutliga arbetsbelastningssiffrorna.

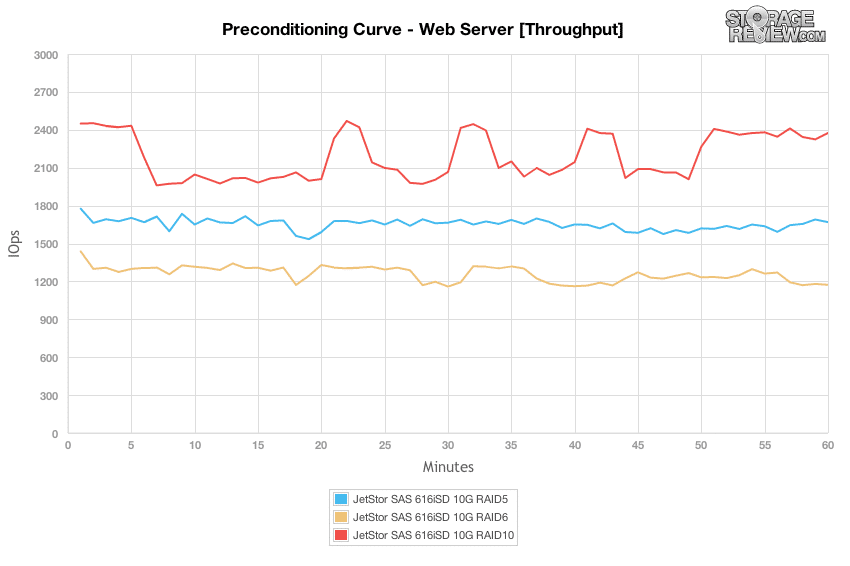

I ett webbserverscenario med 100 % skrivtillstånd erbjöd RAID10-konfigurationen den högsta prestandan, även om den liknade beteendet vi noterade i slumptestet i 4K, sjönk den under hela delar av testet när den utförde bakgrundsaktivitet. De andra RAID-profilerna gav inte samma resultat, även om de också var långsammare överlag.

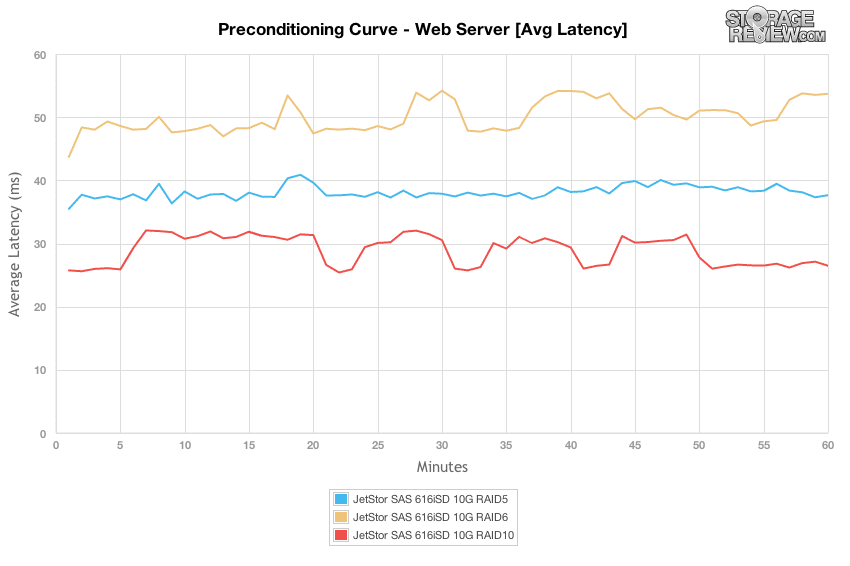

I webbserverns förkonditioneringsprocessen med en belastning på 8T/8Q fanns det en stor spridning av prestandaskillnader, där RAID10 erbjuder de snabbaste svarstiderna totalt sett på 26-32 ms, RAID5 mätte ca 38-41 ms och RAID6 med 48-54 ms.

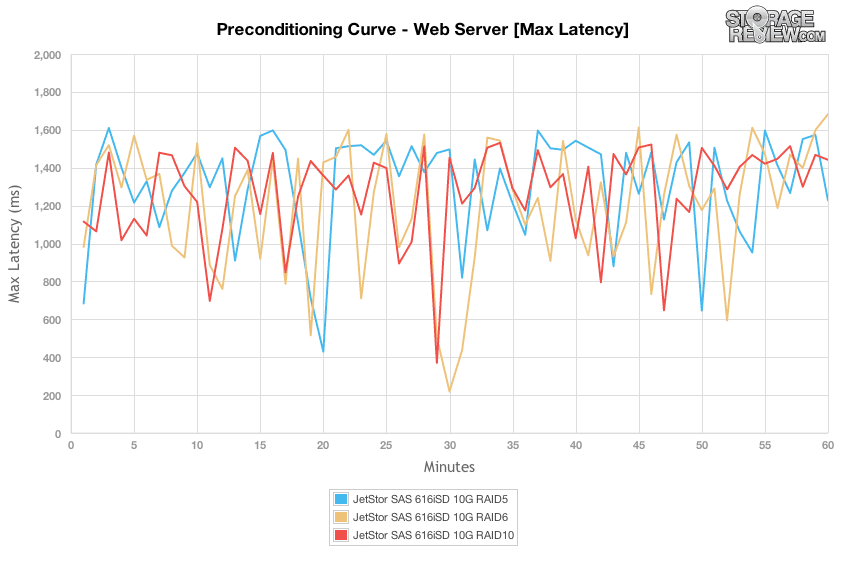

Genom att jämföra skillnaderna i max latens i vår webbserver förkonditioneringsarbetsbelastning, erbjöd alla RAID-typer ett liknande intervall av toppsvarstider som mätte 200-1,600 XNUMX ms totalt.

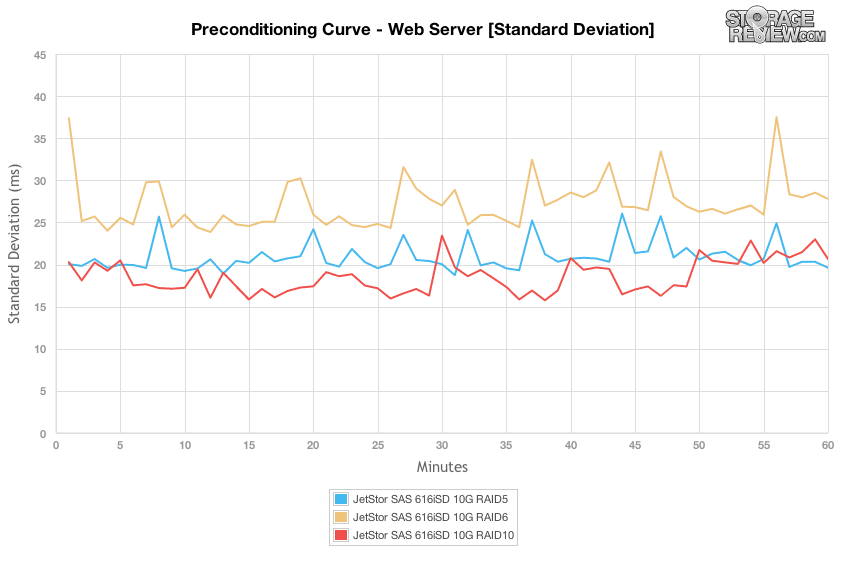

När vi jämför max latens kanske det inte har varit så många skillnader, men när vi ändrar fokus till latensstandardavvikelse ser vi att RAID10 erbjöd den snästa spridningen i latens, följt av RAID5 och sedan RAID6.

Genom att byta från 100 % skrivaktivitet i vår förkonditioneringsfas till 100 % läsaktivitet är skillnaden mellan varje RAID-typ inte lika märkbar förrän de högre effektiva ködjupen. På sina toppar kunde RAID10-läget stödja 5,100 5 IOPS, RAID4,800 med 6 4,500 och RAIDXNUMX med XNUMX XNUMX.

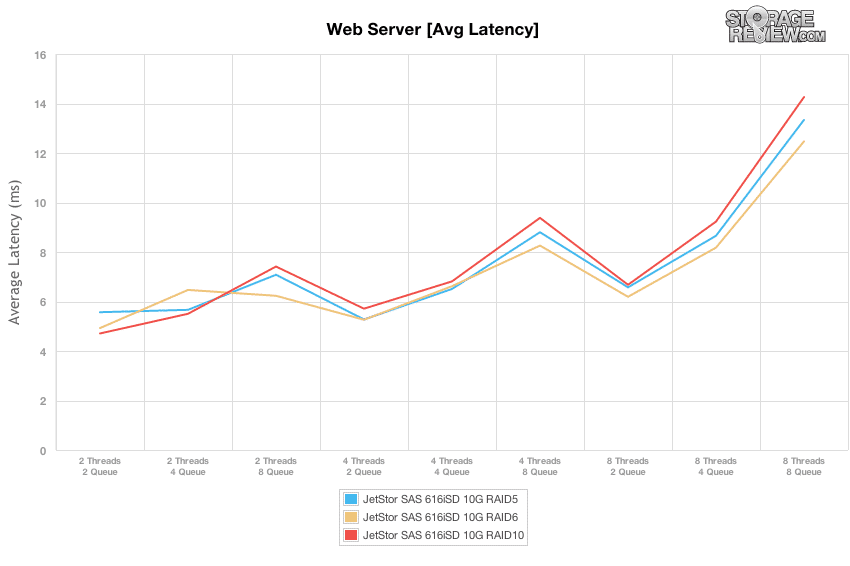

Den söta punkten med 100 % läsaktivitet i vår webbserverprofil var fortfarande 8T/2Q-belastningen, som erbjöd en svarstid på 6.2-6.6 ms med en genomströmning på 2,400 2,600-13 15 IOPS innan latensen spetsade till XNUMX-XNUMX ms.

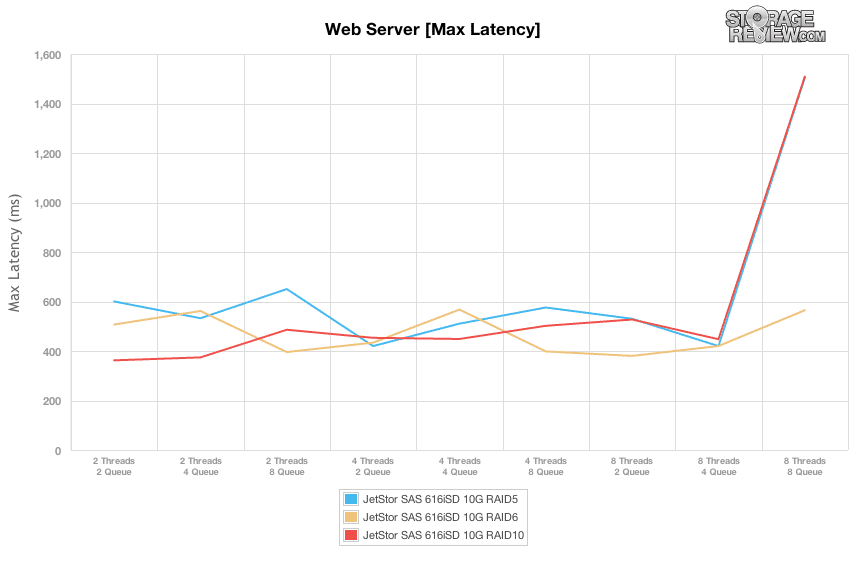

Genom att jämföra max latens i våra varierande belastningstester, bibehöll JetStor SAS 616iSD ett intervall på 400-600 ms fram till 8T/8Q-arbetsbelastningen där RAID5- och RAID10-konfigurationer sköt upp till 1,500 XNUMX ms.

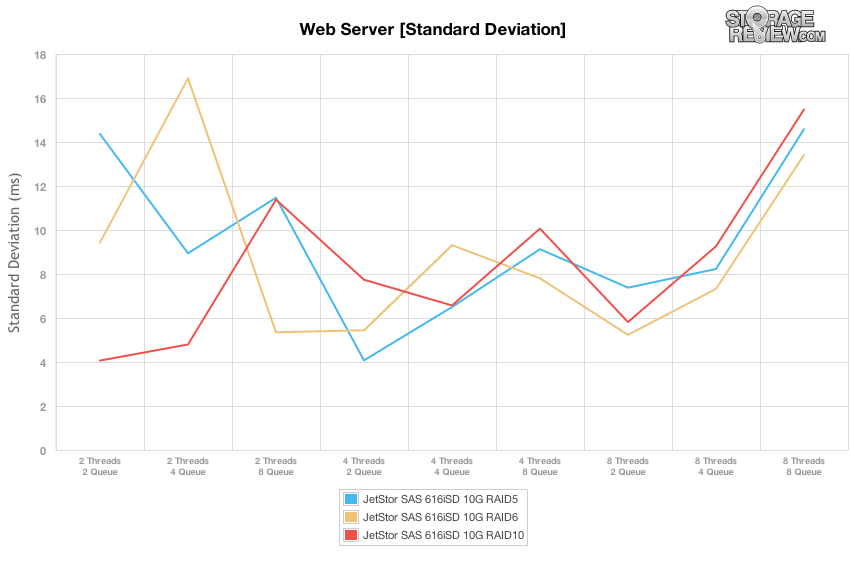

Genom att jämföra skillnaderna i latensstandardavvikelse erbjöd varje RAID-typ på JetStor SAN mer konsekventa svarstider när den var under en måttlig belastning, ända tills den placerades under vår toppbelastning på 8T/8Q. I sweet spot-intervallet 8T/2Q erbjöd RAID6 den mest konsekventa latensen, följt av RAID10 och RAID5.

Energiförbrukning

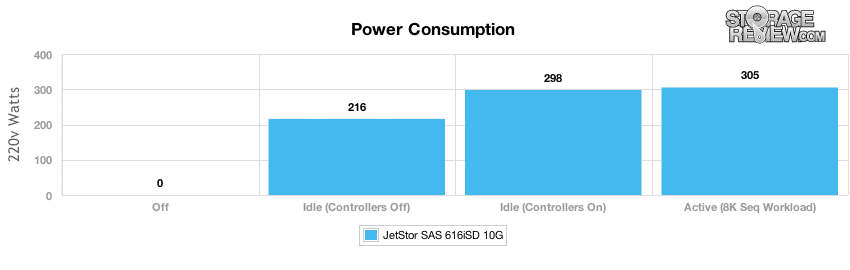

Som med alla enheter som är placerade i ett modernt datacenter, är strömförbrukning och termisk effekt alltid framme eftersom de påverkar resultatet två gånger både när det gäller strömanvändning av själva enheten och den kylning som behövs för att kompensera värmen den skapar under drift. Med de flesta SAN- och NAS-arrayer är den största komponenten för den totala strömanvändningen själva enheterna, vilket om du har ganska konstant åtkomst betyder lite tid att gå på tomgång och snurra ner. I våra tester mätte vi ström i ett avstängt tillstånd, systemet slogs på men styrenheterna stängdes av, systemet var påslaget och inaktivt, samt systemet slogs på och såg en konstant hög I/O-belastning.

Med tolv 600GB 15k SAS-hårddiskar installerade kommer huvuddelen av strömanvändningen från att hålla dessa enheter aktiva. Med kontrollerna avstängda behövde arrayen 216 watt vid tomgång, vilket ökade till 298 watt med kontrollerna på. Även med en aktiv belastning ökade strömförbrukningen med endast ytterligare 7 watt till 305w med en 8K sekventiell arbetsbelastning. Med dubbla 460W strömförsörjningar fann vi att JetStor SAN var blygsamt överprovisionerat när det gäller dess strömbehov, eftersom det stannade på 66 % utnyttjande med 15,000 XNUMX RPM hårddiskar installerade. Även med fyra oanvända fack hade den fortfarande massor av overhead kvar, även om en strömförsörjning misslyckades och togs bort från ekvationen.

Slutsats

Jetstor SAS 616iSD 10G passar in i en något amorf lagringsuppsättningskategori genom att den kan användas på egen hand med prestanda eller stor kapacitetsenheter för att fylla virtualiserings- eller allmänna lagringsbehov för en SMB, eller paras ihop med ytterligare hyllor för att lösa stora företagslagringsproblem. JetStor har designat 616iSD väl, allt inifrån och ut är genomtänkt och enheten lämpar sig väl för enkel fältservice. Objekt som en kabellös intern design eller verktygsfria komponentbyten innebär att tekniker behöver göra väldigt lite arbete för att hålla SAS 616-SD igång i en produktionsmiljö. Installation är också en bris, det är ganska mycket plug and play, väl åtminstone inom företagens betydelse för sådana saker.

När det gäller prestanda testade vi arrayen i vanliga konfigurationer av RAID5, RAID6 och RAID10. Att titta på alla tre är verkligen relevant, eftersom våra tester såg betydande variationer i varje läge. RAID10 visade konsekvent högsta prestanda, efterföljd av RAID5 och sedan RAID6 när det gäller råprestanda och lägsta latens. Eftersom ett företag övervägde att distribuera denna eller vilken annan array som helst, är det särskilt viktigt att förstå platsen för prestanda för att lyckas med lagringsdistributionen. I det här fallet såg vi det bästa prestandamålet vid 8 trådar, 2 köer där JetStor SAS 606iSD kunde erbjuda hög genomströmning såväl som låg latens över de flesta arbetsbelastningar och alla RAID-typer. Prestanda skulle kunna fortsätta att skala bortom den punkten, även om latensen skulle öka avsevärt. På strömsidan fann vi att vår 12-drivna 15k SAS-konfiguration förbrukar 305 watt under belastning, vilket är långt under 460 watt varje nätaggregat är utformat för att hantera. Det ger systemet gott om utrymme, även om det måste köras av från en enda PSU i händelse av ett komponentfel.

Där JetStor stöter på lite problem är när de försöker flytta mer up-market till större kunder. I de fallen blir hanteringslagret väldigt viktigt och det är något JetStor helt enkelt inte har så mycket djup. När man jämför med sådana som EMC eller NetApp, där du kan hantera storskaliga beräknings- och lagringsplattformar genom ett enda hanteringsfönster, måste JetStor SAN konfigureras på egen hand. Det är inte precis ett problem när man arbetar med ett fåtal system, det är mer en fråga om att förstå vilket segment av marknaden som denna box spelar. Till JetStors förtjänst försöker de inte ersätta stora företagslagringsuppsättningar med SAS 616iSD; de pekar starkt på mellanmarknaden där denna design är mycket vettig.

Fördelar

- Fin hölje/komponentdesign

- Mycket robust design som är lätt att serva

- Erbjuder stark, konsekvent prestanda i ett brett spektrum av arbetsbelastningar

Nackdelar

- Saknar storskalig programvara för företagsdatahantering

Bottom Line

JetStor är inte precis ett känt namn när det kommer till lagring, även om det kanske borde vara med nästan 20 år i branschen och en robust uppsättning erbjudanden. Specifikt för den här recensionen, JetStor SAS 616iSD 10G gör allt som den begärs och har tillräckligt med flexibilitet för att konfigureras med 10GbE och 15K hårddiskar för prestandabehov, eller högkapacitets 3.5" hårddiskar för bulklagring. Arrayen är enkel att distribuera och är välkonstruerad och lämpar sig väl för applikations- och virtualiseringslagring för små och medelstora företag och filialer/fjärrkontorsanvändning.

JetStor SAS 616iSD 10G produktsida