Supermicro 推出了一套新的解決方案來推進生成式 AI 的部署,標誌著大型語言模型 (LLM) 基礎設施的發展邁出了重要一步。這些 SuperCluster 解決方案被設計為支援當前和未來人工智慧需求的核心組件。

Supermicro 推出了一套新的解決方案來推進生成式 AI 的部署,標誌著大型語言模型 (LLM) 基礎設施的發展邁出了重要一步。這些 SuperCluster 解決方案被設計為支援當前和未來人工智慧需求的核心組件。

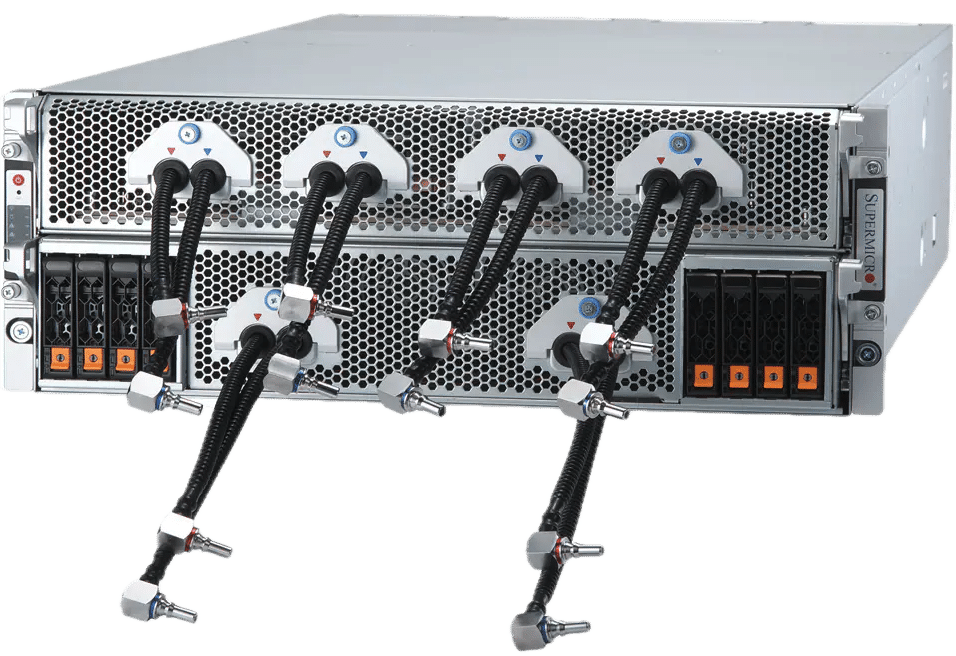

這個新版本包括三種不同的 SuperCluster 配置,專為生成式 AI 任務而客製化。選項包括 4U 液冷系統和 8U 風冷設置,專為強化 LLM 培訓和高容量 LLM 推理而設計。此外,採用 Supermicro NVIDIA MGX 系統的 1U 風冷變體適用於雲規模推理應用。這些系統旨在在 LLM 訓練中提供無與倫比的性能,具有大批量大小和用於 LLM 推理的大量處理能力等功能。

AI集群擴容

Supermicro 每月能夠生產多達 5,000 個機架,能夠快速供應完整的生成式 AI 集群,承諾為客戶提供更快的交付速度。例如,一個 64 節點叢集可以包含 512 個 NVIDIA HGX H200 GPU,利用高速 NVIDIA Quantum-2 InfiniBand 和 Spectrum-X 乙太網路來實現強大的 AI 訓練環境。與 NVIDIA AI Enterprise 軟體結合使用,該配置是企業和雲端基礎設施的理想解決方案,旨在訓練具有數兆參數的複雜法學碩士。

創新冷卻和性能

與 4U 風冷替代方案相比,新型 Supermicro 100U NVIDIA HGX H200/H8 8-GPU 系統利用液體冷卻將密度提高了一倍,從而降低了能耗並降低了資料中心的總擁有成本。這些系統支援基於 NVIDIA Blackwell 架構的下一代 GPU,採用高效冷卻技術,可保持最佳溫度以實現最佳效能。

超級叢集規格

Supermicro SuperClusters 是可擴展的解決方案,用於訓練大規模基礎模型和創建雲端規模的 LLM 推理基礎架構。憑藉高度可擴展的網路架構,這些系統可以從 32 個節點擴展到數千個,確保無縫的可擴展性。整合先進的液體冷卻和全面的測試流程可保證營運效率和有效性。

Supermicro 詳細介紹了兩種主要配置:配備4U 液冷系統的SuperCluster,能夠在緊湊的佔地面積內支援多達512 個GPU,以及配備1U 風冷NVIDIA MGX 系統的SuperCluster,專為大容量、低延遲的推理任務而設計。兩種配置都因其高網路效能而突出,這對於 LLM 訓練和推理至關重要。

以下是其規格的簡要概述:

SuperCluster 配備 4 個機架中的 5U 液冷系統或 8 個機架中的 9U 風冷系統

- 一個可擴充單元中包含 256 個 NVIDIA H100/H200 Tensor Core GPU

- 液體冷卻支援 512 個 GPU、64 個節點,與風冷的 256 個 GPU、32 節點解決方案佔用的空間相同

- 一個可擴展單元中包含 20TB HBM3(配備 NVIDIA H100)或 36TB HBM3e(配備 NVIDIA H200)

- 1:1 網路為每個 GPU 提供高達 400 Gbps 的速度,以啟用 GPUDirect RDMA 和儲存來訓練具有多達數兆個參數的大型語言模型

- 400G InfiniBand 或 400GbE 乙太網路交換器結構,具有高度可擴展的脊葉網路拓撲,包括 NVIDIA Quantum-2 InfiniBand 和 NVIDIA Spectrum-X 乙太網路平台。

- 可自訂的 AI 資料管道儲存結構,具有業界領先的平行檔案系統選項

- NVIDIA AI Enterprise 5.0 軟體,支援新的 NVIDIA NIM 推理微服務,可加速 AI 模式的大規模部署

SuperCluster 在 1 個機架中配備 9U 氣冷式 NVIDIA MGX 系統

- 一個可擴充單元中包含 256 個 GH200 Grace Hopper 超級晶片

- 高達 144GB HBM3e + 480GB LPDDR5X 統一內存,適用於雲規模、大容量、低延遲和高批量大小的推理,能夠在一個節點中擬合 70B+ 參數模型。

- 具有高度可擴展的脊葉網路拓撲的 400G InfiniBand 或 400G 乙太網路交換結構

- 每個節點最多 8 個內建 E1.S NVMe 儲存設備

- 可自訂的 AI 資料管道儲存結構,配備 NVIDIA BlueField-3 DPU 和業界領先的平行檔案系統選項,可為每個 GPU 提供高吞吐量和低延遲的儲存訪問

- NVIDIA AI Enterprise 5.0 軟體

Supermicro 透過使用 NVIDIA Blackwell 架構的新系統和機架擴展 AI 產品組合

Supermicro 也宣布擴展其 AI 系統產品,包括 NVIDIA 旨在大規模產生 AI 的資料中心創新的最新成果。這些新技術包括 NVIDIA GB200 Grace Blackwell Superchip 以及 B200 和 B100 Tensor Core GPU。

為了適應這些進步,Supermicro 正在無縫升級其現有的 NVIDIA HGX H100/H200 8-GPU 系統整合 NVIDIA HGX B100 8-GPU 和 B200。此外,採用 NVIDIA GB200 的新型號將增強 NVIDIA HGX 產品線,其中包括配備 72 個 NVIDIA Blackwell GPU 的全面機架級解決方案。除了這些進步之外,美超微還推出了全新 4U NVIDIA HGX B200 8-GPU 液冷系統,利用直接晶片液冷技術來滿足最新 GPU 日益增長的散熱需求,並釋放 NVIDIA 的全部性能能力。布萊克韋爾技術。

全新 Supermicro 的 GPU 優化系統即將推出,與 NVIDIA Blackwell B200 和 B100 Tensor Core GPU 完全相容,並通過了最新 NVIDIA AI Enterprise 軟體的認證。 Supermicro 系列包括多種配置,從 NVIDIA HGX B100 和 B200 8-GPU 系統到能夠容納多達 20 個 B100 GPU 的 SuperBlade,確保了各種人工智慧應用的多功能性和高效能。這些系統包括率先上市的 NVIDIA HGX B200 和 B100 8-GPU 型號,採用先進的 NVIDIA NVLink 互連技術。 Supermicro 表示,他們準備為法學碩士提供培訓成果(速度提高 3 倍),並支援可擴展的叢集來滿足嚴格要求的 AI 工作負載,這標誌著 AI 運算效率和效能的重大飛躍。

參與 StorageReview

電子報 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | 的TikTok | RSS訂閱