Cloud-Giganten wie AWS, Google und Azure entwickeln kundenspezifische Siliziumchips, um den KI-Bedarf zu decken und Leistung, Effizienz und Kontrolle zu steigern.

Die Cloud-Umgebung erlebt derzeit einen tiefgreifenden Wandel. Im vergangenen Jahr haben Hyperscaler wie Amazon Web Services (AWS), Google Cloud und Microsoft Azure ihre Investitionen in kundenspezifische Siliziumchips drastisch erhöht. Die Zahl der KI-Unternehmen, die in den Chipmarkt einsteigen, nimmt weiter zu.

Dieser rasante Anstieg der Chipentwicklung verändert das Rechenzentrum und verspricht neue Leistungs-, Effizienz- und Differenzierungsniveaus. Während herkömmliche Chiphersteller Prozessoren und Beschleuniger für die breite Masse entwickeln, entwickeln diese neuen Player Chips speziell für anspruchsvolle KI-Workloads.

Chip-Design

Die Motivation für die Entwicklung kundenspezifischer Chips liegt darin begründet, dass handelsübliche CPUs und Beschleuniger den Anforderungen hyperskalierter Cloud-Workloads nicht gerecht werden können. Insbesondere KI und maschinelles Lernen erfordern eine höhere Rechendichte, geringere Latenzzeiten und höhere Anforderungen an die Energieeffizienz. Hyperscaler reagieren darauf mit der Entwicklung maßgeschneiderter Chips, die auf ihre Infrastruktur und die Bedürfnisse ihrer Kunden zugeschnitten sind. Immer mehr neue Akteure drängen mit Prozessoren und Beschleunigern auf den Markt, die als die „schnellsten“, „günstigsten“ oder „besten“ der Branche angepriesen werden.

Natürlich ist das kein neues Phänomen. Cloud-Anbieter entwickeln seit vielen Jahren maßgeschneiderte Netzwerkhardware, Speichergeräte und Server. Die Entwicklung von Prozessoren ist jedoch eine ganz andere Sache.

Wer sind die Spieler?

Dies ist keine vollständige Liste. Derzeit sind dies die wichtigsten Akteure in diesem Bereich. Wir haben auch neue Anbieter aufgenommen, die ihre besondere Note in die KI-orientierte Leistungserbringung einbringen.

AWS

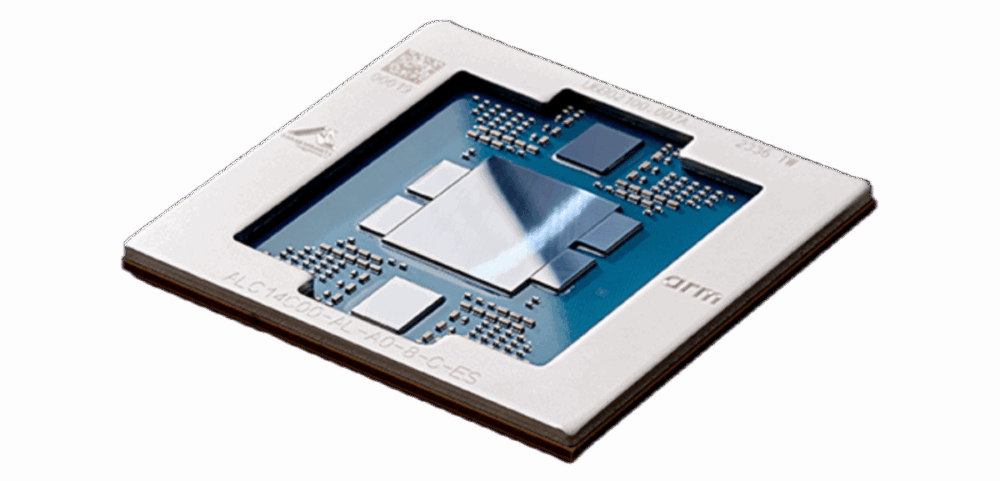

Inzwischen in der vierten Generation Amazons Graviton Die Serie hat den Maßstab für Arm-basierte CPUs in der Cloud gesetzt und bietet im Vergleich zu herkömmlichen x86-Modellen deutliche Leistungssteigerungen pro Watt. AWS hat außerdem kundenspezifische KI-Beschleuniger eingeführt, wie beispielsweise Inferentia und Trainium, mit Fokus auf Inferenz- und Trainings-Workloads im großen Maßstab.

Laut der AWS-Website gab Anthropic an, dass AWS sein wichtigster Schulungspartner sein und AWS Trainium für die Schulung und Bereitstellung seiner größten Basismodelle nutzen werde. Amazon soll außerdem weitere 4 Milliarden US-Dollar in Anthropic investieren.

Google setzt unterdessen mit seinen Tensor Processing Units (TPUs) weiterhin neue Maßstäbe und treibt damit einige der größten KI-Modelle in der Produktion an. Die neuesten TPU v5 und Ironwood Die Architekturen sind auf massive Parallelität ausgelegt und eng in die Rechenzentrumsstruktur von Google integriert.

Azure

Microsoft ist nicht weit dahinter und hat kürzlich seine benutzerdefinierten KI-Chips vorgestellt. Azure Maia und Azure Cobalt, optimiert für KI und allgemeine Workloads. Diese Chips werden bereits in den Rechenzentren von Microsoft eingesetzt und unterstützen alles von großen Sprachmodellen bis hin zu zentralen Cloud-Diensten.

CSPs sind nicht allein

Obwohl es sich dabei nicht unbedingt um Cloud-Anbieter handelt, gibt es auch andere Akteure auf dem Chipentwicklungsmarkt. Diese Unternehmen erkennen ebenfalls die Vorteile der Chipentwicklung: geringere Kosten, Leistung, Verwaltung und Besitz.

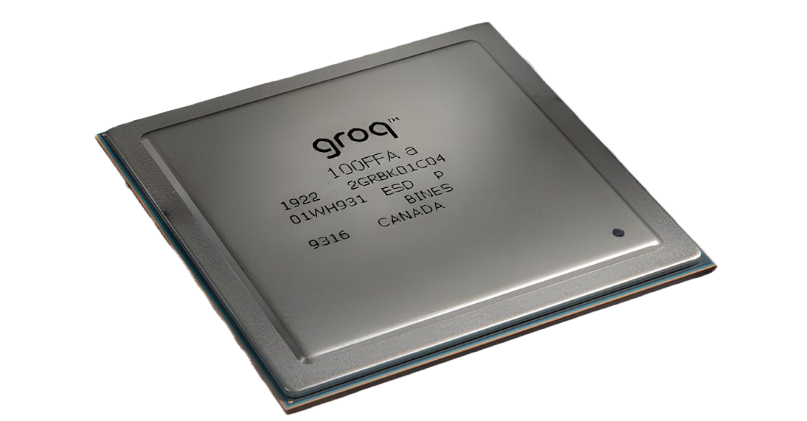

Groq

Groq bietet eine KI-Inferenzplattform, die auf seinen benutzerdefinierten Sprachverarbeitungseinheit (LPU) und Cloud-Infrastruktur. Es bietet hohe Leistung zu geringen Kosten für beliebte KI-Modelle.

Im Gegensatz zu GPUs, die für Grafiken entwickelt wurden, ist die LPU für KI-Inferenz und Sprachaufgaben optimiert. Groq bietet die LPU über GroqCloud™ und lokale Lösungen anstelle einzelner Chips an.

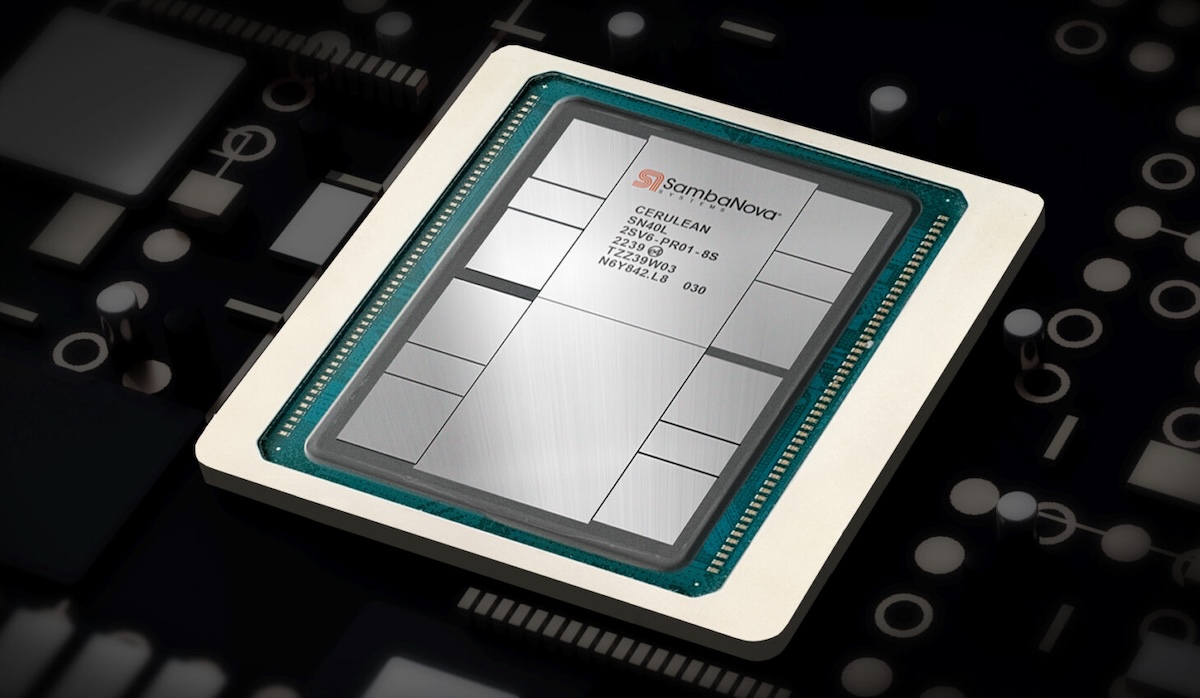

SambaNova-Systeme

SambaNova-Systeme hat eine KI-Plattform entwickelt, die auf komplexe Workloads zugeschnitten ist. Sie basiert auf dem DataScale®-System und benutzerdefinierten, für Dataflow-Computing optimierten Reconfigurable Dataflow Unit (RDU)-Chips.

Das Unternehmen bietet vortrainierte Basismodelle und die SambaNova Suite, die Hardware, Software und Modelle kombiniert, um eine schnelle KI-Bereitstellung, insbesondere im Finanz- und Gesundheitswesen, zu ermöglichen.

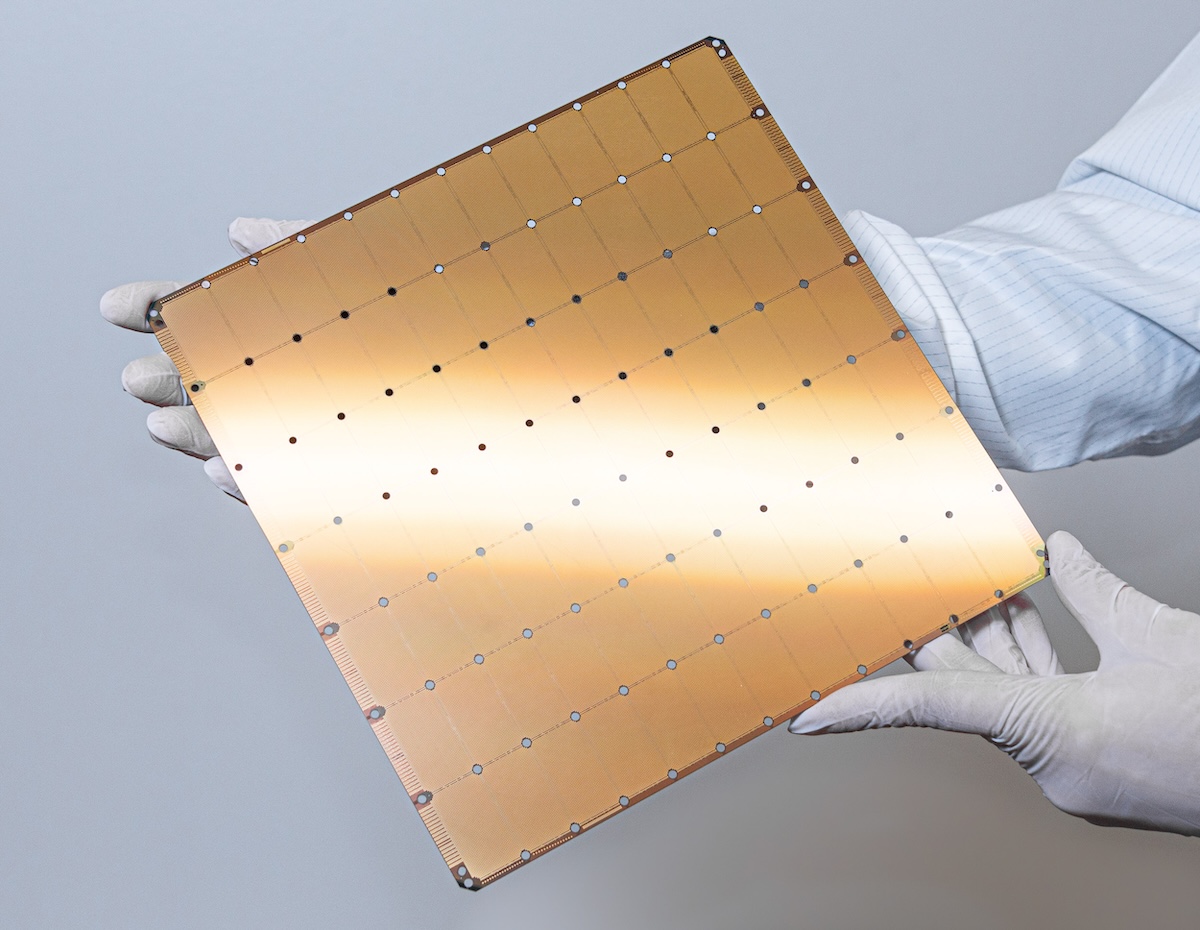

Großhirn

Cerebras ist bekannt für seine KI-Inferenz- und Trainingsplattform, die Folgendes bietet: Wafer-Scale Engine (WSE). Mit seinen zahlreichen KI-optimierten Kernen und dem On-Chip-Speicher ermöglicht dieser große Chip Cerebras-Systemen die Verarbeitung komplexer Modelle, die für herkömmliche Hardware eine Herausforderung darstellen.

Organisationen in der medizinischen Forschung und im Energiebereich verwenden Cerebras-Systeme für Supercomputer vor Ort, während Entwickler über die Cerebras Cloud auf die Funktionen zugreifen können.

Tensturm

Tensturm entwickelt fortschrittliche KI und Hochleistungsrechnerhardware unter der Leitung eines auf Computerarchitektur und ASIC-Design spezialisierten Teams. Ihr Ansatz ähnelt Googles TPUs und konzentriert sich auf offene Hard- und Software. Sie haben Investitionen von Persönlichkeiten wie Jeff Bezos angezogen.

Die Blackhole™ PCIe-Karten des Unternehmens sind für skalierbare KI-Verarbeitung konzipiert und verfügen über RISC-V-Kerne und GDDR6-Speicher. Das Modell Blackhole p100a enthält den Blackhole Tensix-Prozessor und ist für Desktop-Workstations konzipiert.

Die Vorteile: Leistung, Effizienz und Kontrolle

Maßgeschneiderte Chips bieten CSPs und anderen Akteuren robuste Möglichkeiten. Anbieter können ihre Workloads, Rechenzentrumsarchitekturen und Strom-/Kühlungsanforderungen durch die Eigenentwicklung von Chips optimieren. Dies führt zu einer besseren Leistung pro Dollar, verbesserter Energieeffizienz und der Möglichkeit, Kunden differenzierte Dienste anzubieten. Strategisch gesehen reduziert der Besitz des Chip-Stacks die Abhängigkeit von Drittanbietern, minimiert Lieferkettenrisiken und ermöglicht schnellere Innovationszyklen. Diese Agilität ist ein Wettbewerbsvorteil in einer Welt, in der sich KI-Modelle rasant weiterentwickeln.

Chipbau ist nichts für schwache Nerven. Er erfordert fundiertes Ingenieurswissen, erhebliche Investitionen und eine enge Zusammenarbeit mit Fertigungsbetrieben und Designpartnern. CSPs investieren zudem erheblich in Software-Stacks, Compiler und Entwicklertools, um die Zugänglichkeit und Benutzerfreundlichkeit ihrer kundenspezifischen Hardware zu gewährleisten. Die Auswirkungen sind branchenweit spürbar. Traditionelle Chiphersteller wie Intel, AMD und NVIDIA sehen sich mit neuer Konkurrenz konfrontiert, während Startups und IP-Anbieter neue Möglichkeiten der Zusammenarbeit mit CSPs finden. Die Open-Source-Hardware-Bewegung, typisch für RISC-V, gewinnt an Dynamik, da Anbieter nach flexibleren und anpassbaren Architekturen suchen.

Die Zukunft von Cloud Silicon

Das Innovationstempo zeigt keine Anzeichen einer Verlangsamung. Mit der Weiterentwicklung von KI, Analytik und Edge Computing werden CSPs und Hyperscaler voraussichtlich in stark kundenspezifische Chips investieren und gleichzeitig in neue Bereiche wie Netzwerk, Speicher und Sicherheit expandieren. Die nächste Generation der Cloud-Infrastruktur wird sowohl von der Hardware als auch von der darauf basierenden Software und den Services geprägt sein.

Dieser Fortschritt bietet mehr Optionen, verbesserte Leistung und die Möglichkeit, Arbeitslasten zu bewältigen, die Unternehmen und Entwicklern bislang als unmöglich galten. Für die Branche markiert dies den Beginn einer neuen Ära, in der die größten Cloud-Anbieter gleichzeitig zu den einflussreichsten Chip-Entwicklern gehören.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed