Bleibe auf dem Laufenden! MLPerf-Ergebnisse wurden veröffentlicht, wobei NVIDIA die höchste Leistung und Effizienz von der Cloud bis zum Edge für KI-Inferenz liefert. MLPerf bleibt als unabhängiger Benchmark von Drittanbietern ein nützliches Maß für die KI-Leistung. Die KI-Plattform von NVIDIA steht seit der Einführung von MLPerf ganz oben auf der Liste für Training und Inferenz, einschließlich der neuesten MLPerf Inference 3.0-Benchmarks.

Bleibe auf dem Laufenden! MLPerf-Ergebnisse wurden veröffentlicht, wobei NVIDIA die höchste Leistung und Effizienz von der Cloud bis zum Edge für KI-Inferenz liefert. MLPerf bleibt als unabhängiger Benchmark von Drittanbietern ein nützliches Maß für die KI-Leistung. Die KI-Plattform von NVIDIA steht seit der Einführung von MLPerf ganz oben auf der Liste für Training und Inferenz, einschließlich der neuesten MLPerf Inference 3.0-Benchmarks.

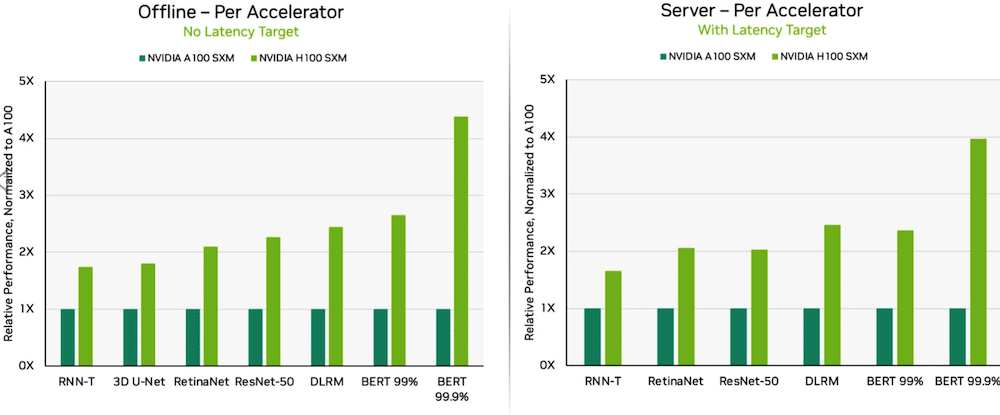

Dank Softwareoptimierungen lieferten NVIDIA H100 Tensor Core GPUs, die in DGX H100-Systemen laufen, in jedem Test der KI-Inferenz die höchste Leistung, 54 Prozent mehr als beim Debüt im September. Im Gesundheitswesen lieferten H100-GPUs eine Leistungssteigerung von 31 Prozent auf 3D-UNet, dem MLPerf-Benchmark für medizinische Bildgebung.

Dell PowerEdge XE9680 mit 8X H100 GPUs

Die auf der Hopper-Architektur basierende H100-GPU basiert auf ihrer Transformer Engine und übertraf BERT. BERT ist ein von Google entwickeltes Modell für die Verarbeitung natürlicher Sprache, das bidirektionale Darstellungen von Text lernt, um das kontextbezogene Verständnis von unbeschriftetem Text bei vielen verschiedenen Aufgaben deutlich zu verbessern. Es ist die Basis für eine ganze Familie BERT-ähnlicher Modelle wie RoBERTa, ALBERT und DistilBERT.

Mit generativer KI können Benutzer schnell Texte, Bilder, 3D-Modelle und vieles mehr erstellen. Unternehmen, vom Startup bis zum Cloud-Service-Anbieter, setzen generative KI ein, um neue Geschäftsmodelle zu ermöglichen und bestehende zu beschleunigen. Ein generatives KI-Tool, das in letzter Zeit in den Nachrichten war, ist ChatGPT. Es wird von Millionen Menschen verwendet, die auf Anfragen und Eingaben sofortige Antworten erwarten.

Da Deep Learning überall eingesetzt wird, ist die Leistung bei der Inferenz von entscheidender Bedeutung, von Fabrikhallen bis hin zu Online-Empfehlungssystemen.

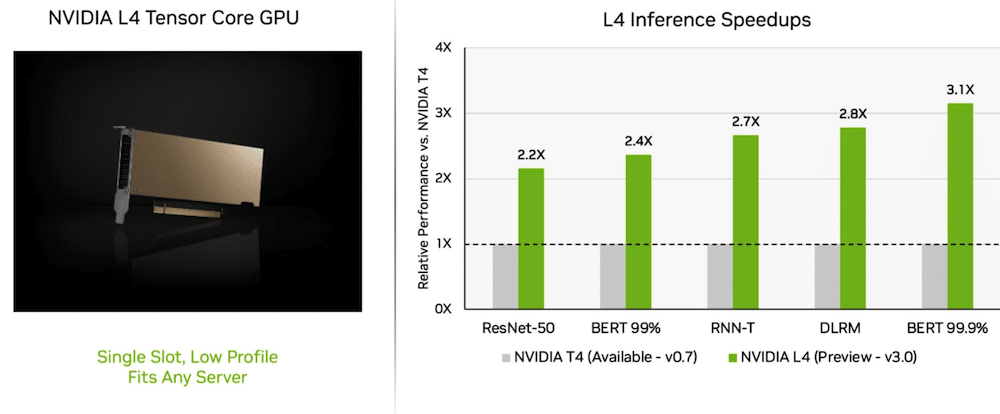

L4-GPUs liefern atemberaubende Leistung

Auf seiner Jungfernfahrt NVIDIA L4 Tensor-Core-GPUs arbeiteten mit mehr als der dreifachen Geschwindigkeit der T3-GPUs der vorherigen Generation. Die L4-GPU-Beschleuniger sind in einem Low-Profile-Formfaktor verpackt und so konzipiert, dass sie auf nahezu jeder Serverplattform einen hohen Durchsatz und eine geringe Latenz liefern. Die L4-Tensor-GPUs führten alle MLPerf-Workloads aus und dank ihrer Unterstützung für das FP4-Format waren die Ergebnisse auf dem leistungshungrigen BERT-Modell hervorragend.

Zusätzlich zur extremen KI-Leistung bieten L4-GPUs eine bis zu 10-mal schnellere Bilddekodierung, eine bis zu 3.2-mal schnellere Videoverarbeitung und eine über 4-mal schnellere Grafik- und Echtzeit-Rendering-Leistung. Die vor einigen Wochen auf der GTC angekündigten Beschleuniger sind bei Systemherstellern und Cloud-Dienstanbietern erhältlich.

Welche Netzwerkabteilung?

Die Full-Stack-KI-Plattform von NVIDIA hat sich in einem neuen MLPerf-Test bewährt: Network-Division-Benchmark!

Der Network-Division-Benchmark streamt Daten an einen Remote-Inferenzserver. Es spiegelt das vorherrschende Szenario wider, in dem Unternehmensbenutzer KI-Jobs in der Cloud ausführen und die Daten hinter Unternehmens-Firewalls gespeichert werden.

Auf BERT lieferten entfernte NVIDIA DGX A100-Systeme bis zu 96 Prozent ihrer maximalen lokalen Leistung, wurden teilweise langsamer, während sie darauf warteten, dass die CPUs einige Aufgaben erledigten. Beim ResNet-50-Test für Computer Vision, der ausschließlich von GPUs durchgeführt wird, erreichten sie 100 %.

NVIDIA Quantum Infiniband-Netzwerke, NVIDIA ConnectX SmartNICs und Software wie NVIDIA GPUDirect spielten eine wichtige Rolle bei den Testergebnissen.

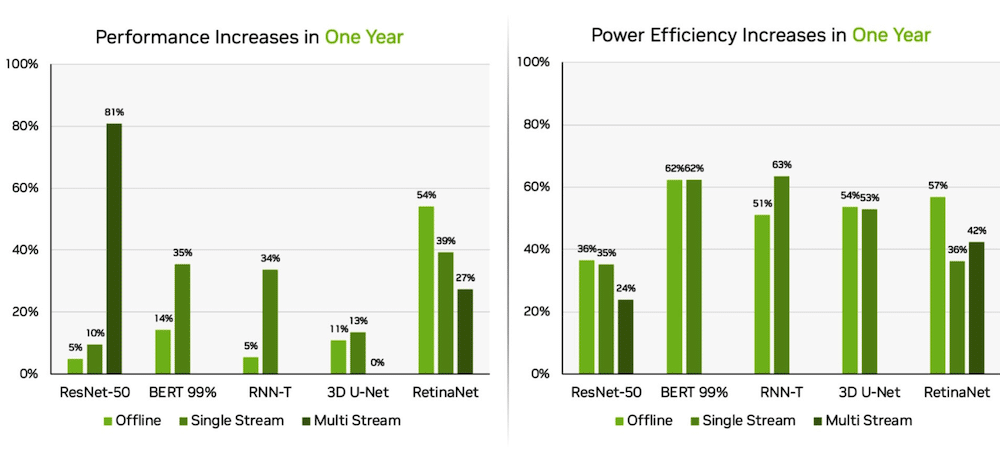

Orin verbessert sich am Edge

Unabhängig davon lieferte das NVIDIA Jetson AGX Orin System-on-Module im Vergleich zu den Ergebnissen des Vorjahres eine Steigerung der Energieeffizienz um bis zu 63 Prozent und der Leistung um 81 Prozent. Jetson AGX Orin liefert Schlussfolgerungen, wenn KI in engen Räumen mit niedrigem Stromverbrauch, einschließlich batteriebetriebener Systeme, benötigt wird.

Das Jetson Orin NX 16G, ein kleineres Modul, das weniger Strom benötigt, schnitt in den Benchmarks gut ab. Er lieferte die bis zu 3.2-fache Leistung des Jetson Xavier NX-Prozessors.

NVIDIA KI-Ökosystem

Die MLPerf-Ergebnisse zeigen, dass NVIDIA AI durch ein breites Ökosystem für maschinelles Lernen unterstützt wird. Zehn Unternehmen haben in dieser Runde Ergebnisse auf der NVIDIA-Plattform eingereicht, darunter Microsoft Azure Cloud-Service- und Systemhersteller, ASUS, Dell Technologies, GIGABYTE, H3C, Lenovo, Nettrix, Supermicro und xFusion. Ihre Arbeit zeigt, dass Benutzer mit NVIDIA AI sowohl in der Cloud als auch auf Servern, die in ihren eigenen Rechenzentren laufen, eine hervorragende Leistung erzielen können.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed