AWS, Google, Azure와 같은 클라우드 거대 기업은 AI 수요를 충족하고 성능, 효율성, 제어를 강화하기 위해 맞춤형 실리콘을 구축하고 있습니다.

클라우드 환경은 현재 상당한 변화를 겪고 있습니다. 지난 한 해 동안 Amazon Web Services(AWS), Google Cloud, Microsoft Azure를 포함한 하이퍼스케일러(Hyperscaler)들은 맞춤형 실리콘에 대한 투자를 크게 늘렸습니다. 칩 시장에 진출하는 AI 기업의 수도 계속 증가하고 있습니다.

이러한 칩 개발의 급증은 데이터 센터의 모습을 변화시키고 있으며, 새로운 차원의 성능, 효율성, 그리고 차별화를 약속하고 있습니다. 일반적인 칩 제조업체들이 대중을 위한 프로세서와 가속기를 개발하는 반면, 이러한 새로운 업체들은 까다로운 AI 워크로드를 위한 칩을 개발하고 있습니다.

칩 디자인

맞춤형 실리콘 개발의 동기는 기성 CPU와 가속기가 하이퍼스케일 클라우드 워크로드의 수요를 따라잡을 수 없다는 데서 비롯됩니다. 특히 AI와 머신러닝은 더 높은 컴퓨팅 밀도, 더 낮은 지연 시간, 그리고 더 높은 에너지 효율 요건을 요구합니다. 하이퍼스케일러는 자사 인프라와 고객 요구에 맞춰 맞춤형 칩을 개발함으로써 이러한 요구에 대응합니다. 업계에서 "가장 빠른", "가장 저렴한", "최고"라는 찬사를 받는 프로세서와 가속기를 내세우는 신규 업체들이 시장에 빠르게 진입하고 있습니다.

물론 이는 새로운 현상이 아닙니다. 클라우드 제공업체들은 수년간 맞춤형 네트워킹 하드웨어, 저장 장치, 서버를 구축해 왔습니다. 하지만 엔지니어링 프로세서는 완전히 다른 분야입니다.

플레이어는 누구인가?

이는 전체 목록이 아닙니다. 현재 이 분야의 주요 업체들을 소개합니다. 또한, AI 중심 서비스 제공에 특별한 역량을 더하는 새로운 공급업체도 포함했습니다.

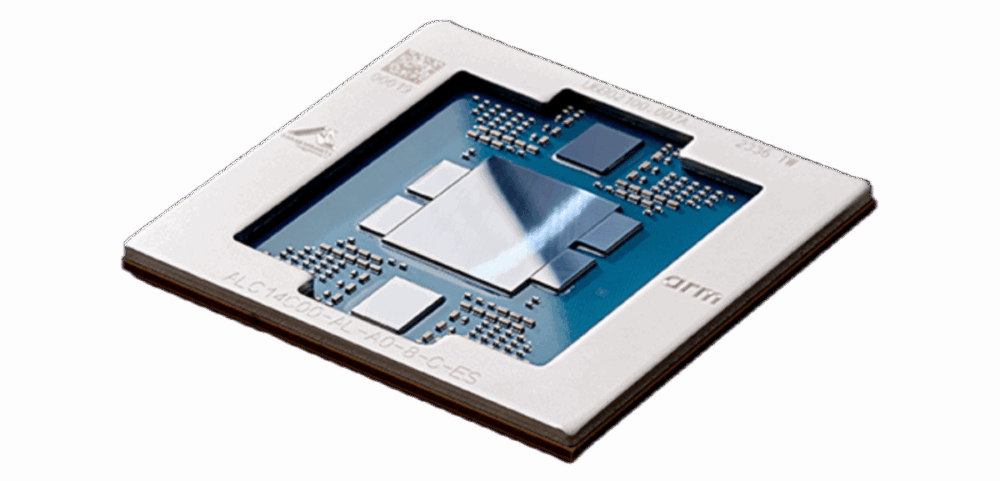

AWS

이제 4세대로 접어들었습니다. 아마존의 그래비톤 시리즈는 클라우드에서 Arm 기반 CPU의 선두 자리를 차지하며 기존 x86 제품군에 비해 와트당 성능이 크게 향상되었습니다. AWS는 또한 다음과 같은 맞춤형 AI 가속기를 출시했습니다. 추론과 훈련대규모 추론 및 학습 워크로드를 타겟으로 합니다.

AWS 웹사이트에 따르면, Anthropic은 AWS가 주요 교육 파트너가 되어 AWS Trainium을 통해 자사의 가장 큰 기반 모델을 교육하고 배포할 것이라고 밝혔습니다. Amazon은 또한 Anthropic에 4억 달러를 추가로 투자할 예정이라고 합니다.

구글

한편, 구글은 텐서 프로세싱 유닛(TPU)을 통해 계속해서 한계를 뛰어넘고 있으며, 현재 프로덕션 환경에서 가장 큰 규모의 AI 모델 중 일부를 구동하고 있습니다. 구글의 최신 TPU v5와 아이언 우드 아키텍처는 대규모 병렬 처리를 위해 설계되었으며 Google의 데이터 센터 구조와 긴밀하게 통합되어 있습니다.

하늘빛

Microsoft도 최근 자체 AI 칩을 공개하면서 뒤처지지 않았습니다. Azure Maia와 Azure CobaltAI 및 범용 워크로드에 최적화된 이 칩은 이미 Microsoft 데이터 센터에 구축되어 대규모 언어 모델부터 핵심 클라우드 서비스까지 모든 것을 지원합니다.

CSP는 혼자가 아닙니다

클라우드 제공업체는 아니더라도 칩 개발 시장에는 다른 업체들도 참여하고 있습니다. 이들 또한 칩 설계의 이점, 즉 비용 절감, 성능 향상, 관리 및 소유권 유지라는 이점을 인지하고 있습니다.

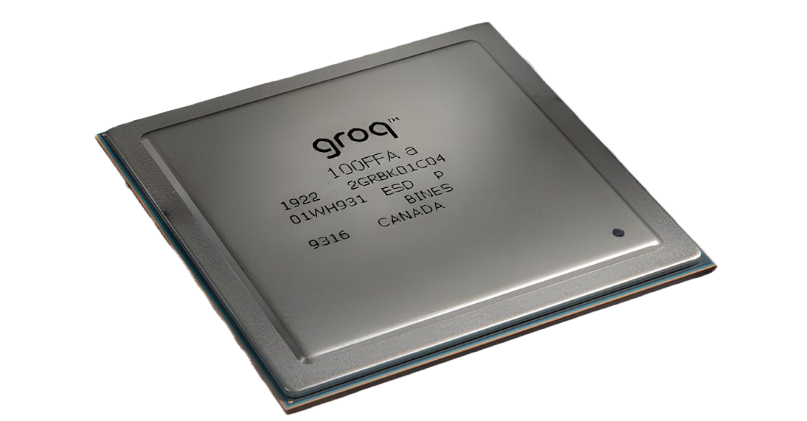

그로크

Groq는 맞춤형 AI 추론 플랫폼을 제공합니다. 언어 처리 장치(LPU) 클라우드 인프라를 갖추고 있습니다. 인기 있는 AI 모델에 저렴한 비용으로 고성능을 제공합니다.

그래픽용으로 설계된 GPU와 달리 LPU는 AI 추론 및 언어 작업에 최적화되어 있습니다. Groq는 개별 칩 대신 GroqCloud™ 및 온프레미스 솔루션을 통해 LPU를 제공합니다.

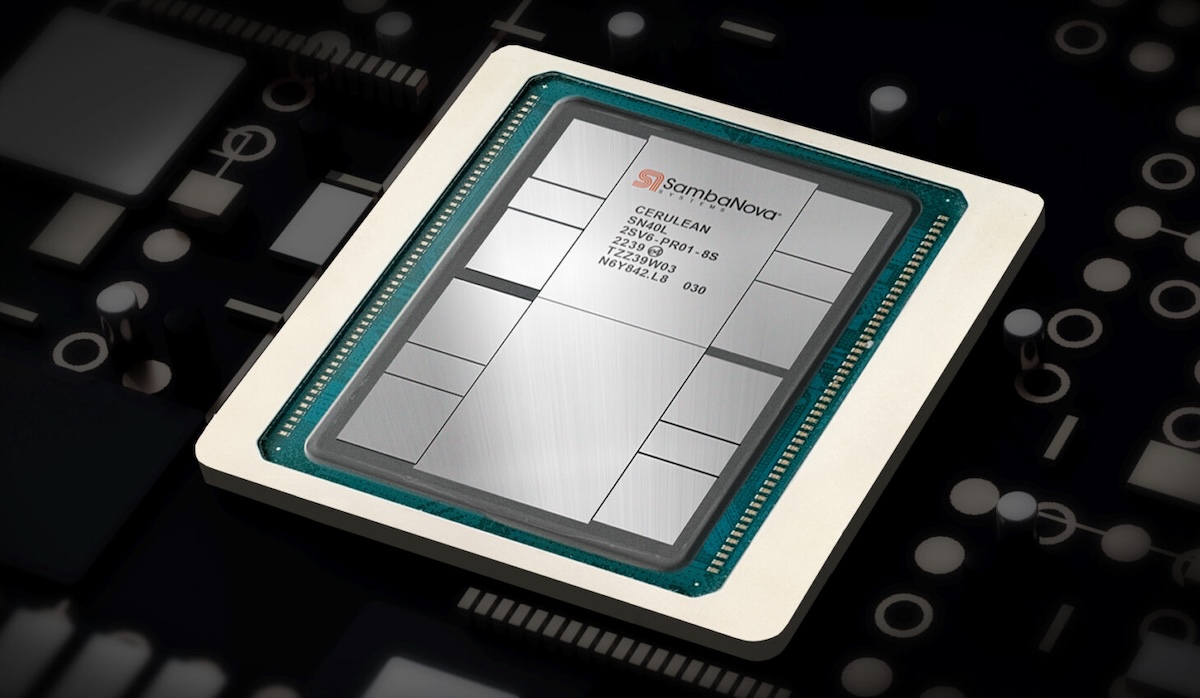

SambaNova 시스템

SambaNova 시스템 복잡한 워크로드에 최적화된 AI 플랫폼을 구축했습니다. 이 플랫폼은 DataScale® 시스템과 데이터 흐름 컴퓨팅에 최적화된 맞춤형 재구성 가능 데이터 흐름 유닛(RDU) 칩을 중심으로 구성됩니다.

이 회사는 사전 훈련된 기초 모델과 하드웨어, 소프트웨어, 모델을 결합하여 특히 금융과 의료 분야에서 신속한 AI 배포를 가능하게 하는 SambaNova Suite를 제공합니다.

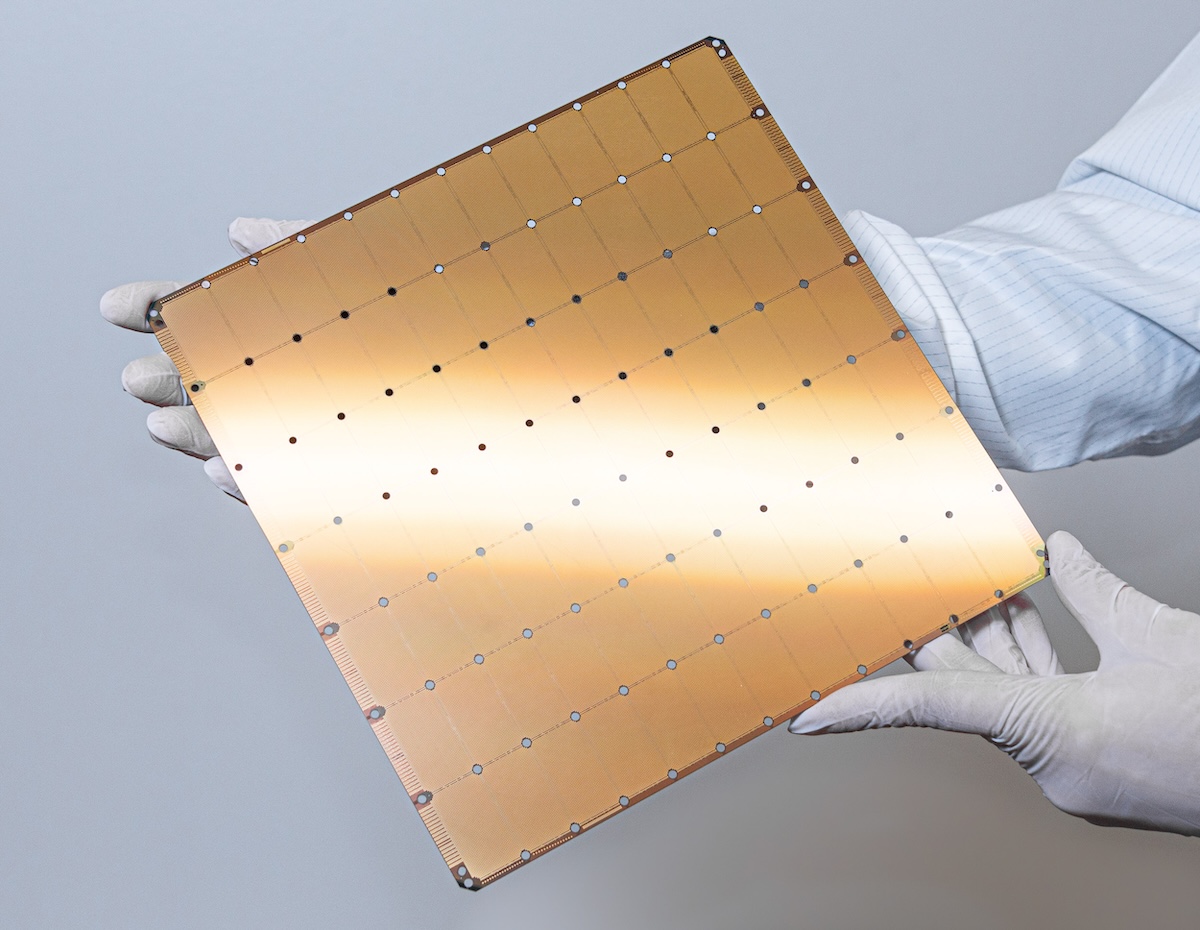

대뇌

Cerebras는 AI 추론 및 교육 플랫폼으로 유명합니다. 웨이퍼 스케일 엔진(WSE)수많은 AI 최적화 코어와 온칩 메모리를 탑재한 이 대형 칩을 통해 Cerebras 시스템은 기존 하드웨어로는 처리하기 어려운 복잡한 모델을 처리할 수 있습니다.

의료 연구 및 에너지 분야의 조직은 온프레미스 슈퍼컴퓨터에 Cerebras 시스템을 사용하고, 개발자는 Cerebras 클라우드를 통해 해당 기능에 액세스할 수 있습니다.

텐스토런트

텐스토런트 컴퓨터 아키텍처와 ASIC 설계 전문 팀이 이끄는 첨단 AI 및 고성능 컴퓨팅 하드웨어를 개발하고 있습니다. 이들의 접근 방식은 구글의 TPU와 유사하며, 오픈 하드웨어와 소프트웨어에 중점을 두고 있으며, 제프 베조스 등 유명 인사들의 투자를 유치했습니다.

이 회사의 Blackhole™ PCIe 보드는 확장 가능한 AI 프로세싱을 위해 설계되었으며, RISC-V 코어와 GDDR6 메모리를 탑재하고 있습니다. Blackhole p100a 모델에는 Blackhole Tensix 프로세서가 탑재되어 있으며 데스크톱 워크스테이션용으로 제작되었습니다.

이점: 성능, 효율성 및 제어

맞춤형 실리콘은 CSP와 기타 업체에 강력한 영향력을 제공합니다. 공급업체는 자체 칩을 설계하여 워크로드, 데이터센터 아키텍처, 전력/냉각 제약 조건을 최적화할 수 있습니다. 이를 통해 비용 대비 성능 향상, 에너지 효율 개선, 그리고 고객에게 차별화된 서비스 제공이 가능합니다. 전략적으로, 실리콘 스택을 직접 구축하면 타사 공급업체에 대한 의존도를 줄이고, 공급망 위험을 완화하며, 혁신 주기를 단축할 수 있습니다. 이러한 민첩성은 AI 모델이 번개처럼 빠르게 진화하는 세상에서 경쟁 우위를 확보하는 데 중요한 요소입니다.

칩 개발은 쉽지 않습니다. 심도 있는 엔지니어링 전문 지식, 상당한 자본 투자, 그리고 파운드리 및 설계 파트너와의 긴밀한 협력이 필요합니다. CSP(통신 서비스 제공업체)는 맞춤형 하드웨어의 접근성과 사용자 편의성을 보장하기 위해 소프트웨어 스택, 컴파일러, 개발자 도구에도 상당한 투자를 하고 있습니다. 이러한 파급 효과는 업계 전반에 걸쳐 나타나고 있습니다. 인텔, AMD, 엔비디아와 같은 기존 칩 제조업체들은 새로운 경쟁에 직면하는 반면, 스타트업과 IP 벤더들은 CSP와 협력할 새로운 기회를 모색하고 있습니다. RISC-V로 대표되는 오픈소스 하드웨어 움직임은 공급업체들이 더욱 유연하고 사용자 정의 가능한 아키텍처를 추구함에 따라 더욱 탄력을 받고 있습니다.

클라우드 실리콘의 미래

혁신의 속도는 둔화될 기미가 보이지 않습니다. AI, 분석, 엣지 컴퓨팅이 발전함에 따라 CSP와 하이퍼스케일러는 새로운 네트워킹, 스토리지, 보안 분야로 진출하는 동시에 맞춤형 실리콘에 막대한 투자를 할 것으로 예상됩니다. 차세대 클라우드 인프라는 하드웨어 자체뿐만 아니라 그 위에 구축되는 소프트웨어와 서비스에 의해서도 결정될 것입니다.

이러한 발전은 더 많은 옵션, 향상된 성능, 그리고 이전에는 기업과 개발자에게 불가능했던 워크로드를 처리할 수 있는 역량을 제공합니다. 업계에 있어 이는 최대 규모의 클라우드 제공업체가 가장 영향력 있는 칩 설계 업체로 거듭나는 새로운 시대의 시작을 의미합니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 틱톡 서비스 | RSS 피드