Microsoft는 이번 주 Microsoft Ignite 이벤트에서 맞춤형 칩 설계 및 AI 인프라 분야에서 여러 가지 새로운 개발 사항을 공개했는데, 여기에는 실리콘 포트폴리오 확장도 포함됩니다.

Microsoft는 Ignite 2024에서 맞춤형 칩 설계 및 AI 인프라에 대한 몇 가지 주요 개발 사항을 발표했습니다. 이 회사는 새로운 보안 및 데이터 처리 칩으로 실리콘 포트폴리오를 확장하는 동시에 AI 컴퓨팅을 위한 NVIDIA와의 파트너십을 강화하고 있습니다. 이러한 업데이트는 Microsoft의 클라우드 서비스 전반에서 효율성, 보안 및 성능을 개선하는 것을 목표로 합니다.

Microsoft의 맞춤형 실리콘 혁명

Microsoft는 Azure Maia AI 가속기와 Azure Cobalt CPU를 넘어 맞춤형 실리콘 포트폴리오를 크게 확장하고 있습니다. Microsoft는 성능 저하 없이 키 관리를 강화하도록 설계된 자체 보안 칩인 Azure Integrated HSM을 출시했습니다. Microsoft는 2025년에 모든 신규 데이터 센터 서버에 HSM 보안 모듈을 추가하여 기밀 및 범용 워크로드를 보호할 예정입니다.

Microsoft는 또한 첫 번째 데이터 처리 장치인 Azure Boost DPU를 출시했습니다. 이 특수 칩은 뛰어난 효율성으로 데이터 중심 워크로드를 처리합니다. 이 DPU가 장착된 새로운 서버는 전력 사용량을 3분의 2로 줄이고 현재 서버보다 4배 더 나은 성능을 발휘합니다.

냉각 및 전력 인프라

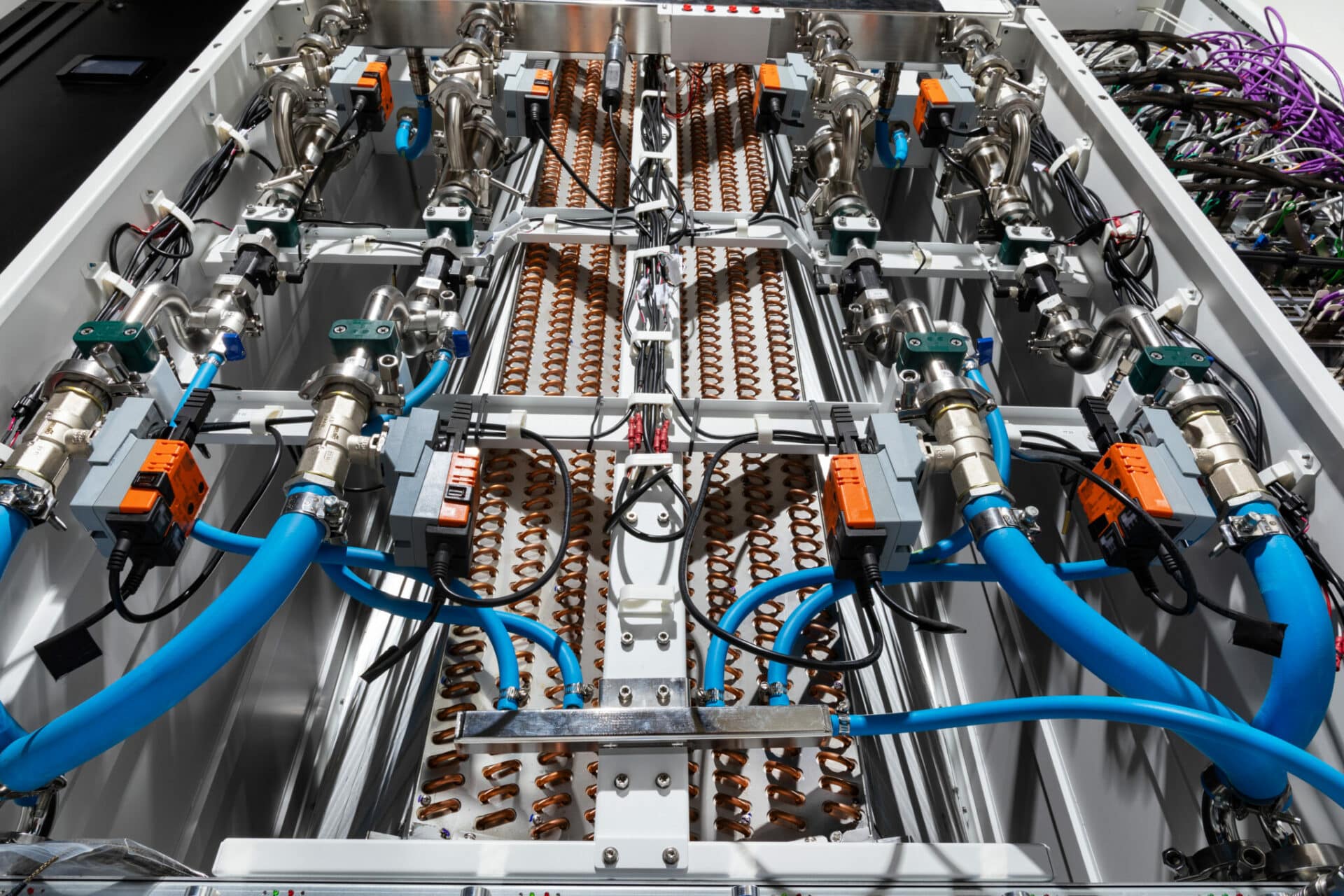

Microsoft는 차세대 액체 냉각 "사이드킥" 랙을 선보였습니다. 이 열 교환기 장치는 NVIDIA의 GB200 인프라를 포함한 대규모 AI 시스템을 지원하기 위해 Azure 데이터 센터에 개조할 수 있습니다. 또한 400볼트 DC 전원을 특징으로 하는 분산형 전원 랙 설계에 대해 Meta와 협력하여 각 서버 랙에 최대 35% 더 많은 AI 가속기를 사용할 수 있습니다.

Microsoft는 업계 전반의 발전을 목표로 Open Compute Project를 통해 이러한 냉각 및 전원 랙 사양을 오픈 소스로 공개하고 있으며, 이를 통해 업계 전체가 이러한 혁신의 혜택을 누릴 수 있게 되었습니다.

차세대 AI 및 컴퓨팅 인프라

Azure의 AI 인프라는 NVIDIA의 H200 GPU를 탑재한 ND H5 V200 Virtual Machine 시리즈의 출시로 계속 진화하고 있습니다. 이 플랫폼은 놀라운 성능 향상을 보였으며 NVIDIA H100과 H200 GPU 사이에서 업계 벤치마킹 표준을 두 배로 뛰어넘었습니다.

Microsoft는 또한 NVIDIA GB200 NVL 6 랙 스케일 디자인과 Quantum InfiniBand 네트워킹을 통합한 새로운 AI 최적화 VM 시리즈인 Azure ND GB200 v72를 발표했습니다. 이 발전은 수만 개의 Blackwell GPU를 연결하여 대규모 AI 슈퍼컴퓨팅 성능을 가능하게 합니다.

CPU 기반 슈퍼컴퓨팅의 경우, 맞춤형 AMD EPYC™ 5V9H 프로세서로 구동되는 새로운 Azure HBv64 가상 머신은 현재 대안보다 최대 2025배 더 빠른 성능을 약속하며 XNUMX년에 미리 볼 수 있을 예정입니다.

Azure 컨테이너 앱 및 NVIDIA 통합

Azure Container Apps는 이제 NVIDIA GPU를 지원하여 간소화되고 확장 가능한 AI 배포를 가능하게 합니다. 이 서버리스 컨테이너 플랫폼은 기본 인프라를 추상화하여 마이크로서비스 기반 애플리케이션의 배포 및 관리를 간소화합니다. 초당 청구 및 0으로 확장 기능을 통해 고객은 사용하는 컴퓨팅에 대해서만 비용을 지불하여 경제적이고 효율적인 리소스 활용을 보장합니다.

Azure의 NVIDIA AI 플랫폼에는 산업용 AI를 위한 새로운 참조 워크플로와 몰입형 AI 기반 비주얼을 만드는 NVIDIA Omniverse Blueprint가 포함되어 있습니다. 산업 운영의 3D 원격 모니터링을 위한 참조 워크플로가 곧 출시되어 개발자가 산업 시스템의 물리적으로 정확한 3D 모델을 Azure IoT Operations 및 Power BI의 실시간 데이터에 연결할 수 있습니다.

RTX AI PC 및 고급 컴퓨팅

NVIDIA는 실제 세계와 화면에서 시각적 이미지를 이해하기 위한 새로운 멀티모달 SLM인 NVIDIA Nemovision-4B Instruct를 발표했습니다. 곧 RTX AI PC와 워크스테이션에 도입될 이 기술은 더욱 사실적으로 디지털 인간 상호 작용을 향상시킵니다.

NVIDIA TensorRT Model Optimizer(ModelOpt)에 대한 업데이트는 이제 Windows 개발자에게 ONNX Runtime 배포를 위한 모델을 최적화하는 개선된 경로를 제공합니다. 이를 통해 개발자는 RTX GPU로 가속화될 때 더 빠르고 정확한 PC용 AI 모델을 만들 수 있으며, ONNX 런타임을 통해 PC 생태계 전반에 배포하기 쉽습니다.

600개가 넘는 Windows 앱과 게임이 전 세계 100억 대가 넘는 GeForce RTX AI PC에서 로컬로 AI를 실행하여 빠르고 안정적이며 지연 시간이 짧은 성능을 제공합니다. NVIDIA와 Microsoft의 협업은 개인용 컴퓨팅 기기의 혁신을 계속 추진하여 일상적인 사용자에게 정교한 AI 기능을 제공합니다.

Microsoft 클라우드 및 하이브리드 인프라

Microsoft의 멀티 클라우드 및 하이브리드 솔루션에 대한 노력은 현재 전 세계적으로 39,000명 이상의 고객에게 서비스를 제공하는 Azure Arc에서 잘 드러납니다. 새로운 Azure Local은 AI 추론을 위한 GPU 서버를 포함하여 유연한 옵션과 함께 안전한 클라우드 연결 하이브리드 인프라를 제공합니다.

Microsoft는 또한 Windows Server 2025와 SQL Server 2025를 발표하여 Azure Arc를 활용하여 온프레미스 및 클라우드 환경에서 클라우드 기능을 제공합니다. SQL Server 2025는 새로운 기본 제공 AI 기능으로 돋보이며, 벡터 지원을 통해 AI 애플리케이션 개발 및 RAG 패턴을 간소화합니다.

결론

Microsoft의 최근 혁신은 맞춤형 실리콘, AI 인프라 및 하이브리드 클라우드 솔루션을 발전시키려는 Microsoft의 헌신을 강조합니다. Azure Integrated HSM 및 Azure Boost DPU와 같은 획기적인 개발을 통해 Microsoft는 안전하고 효율적이며 고성능 데이터 센터 운영을 위한 새로운 템플릿을 설정하고 있습니다. 차세대 냉각 및 전력 기술과 오픈 소싱 혁신의 도입은 업계 협업과 지속 가능성을 촉진하려는 Microsoft의 노력을 강조합니다.

ND H200 V5 및 ND GB200 v6 가상 머신을 포함한 Azure의 AI 및 컴퓨팅 인프라의 진화는 Microsoft가 대규모로 AI 성능을 제공할 수 있는 능력을 보여줍니다. 한편, 새로운 HBv5 가상 머신은 CPU 기반 슈퍼컴퓨팅의 성능을 약속하여 Azure가 고성능 컴퓨팅의 선두 주자로 남을 수 있도록 합니다.

마지막으로, Azure Arc의 강력한 하이브리드 기능과 SQL Server 2025와 같은 AI 강화 도구의 도입으로 Microsoft는 기업에 현대적 워크로드의 복잡성을 해결할 수 있는 유연하고 확장 가능한 솔루션을 제공하고 있습니다. 이러한 발전은 함께 AI, 클라우드 및 하이브리드 인프라의 미래를 주도하는 리더로서 Microsoft의 입지를 공고히 합니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 틱톡 서비스 | RSS 피드