NVIDIA heeft de beschikbaarheid aangekondigd van NVIDIA NIM, inferentiemicroservices die modellen leveren als geoptimaliseerde containers. Deze microservices stellen de 28 miljoen ontwikkelaars ter wereld in staat om eenvoudig generatieve AI-applicaties te bouwen. Deze applicaties kunnen worden ingezet in de cloud, datacenters of werkstations, waardoor de ontwikkeltijd aanzienlijk wordt verkort van weken naar minuten.

NVIDIA heeft de beschikbaarheid aangekondigd van NVIDIA NIM, microservices afleiden die modellen leveren als geoptimaliseerde containers. Deze microservices stellen de 28 miljoen ontwikkelaars ter wereld in staat om eenvoudig generatieve AI-applicaties te bouwen. Deze applicaties kunnen worden ingezet in de cloud, datacenters of werkstations, waardoor de ontwikkeltijd aanzienlijk wordt verkort van weken naar minuten.

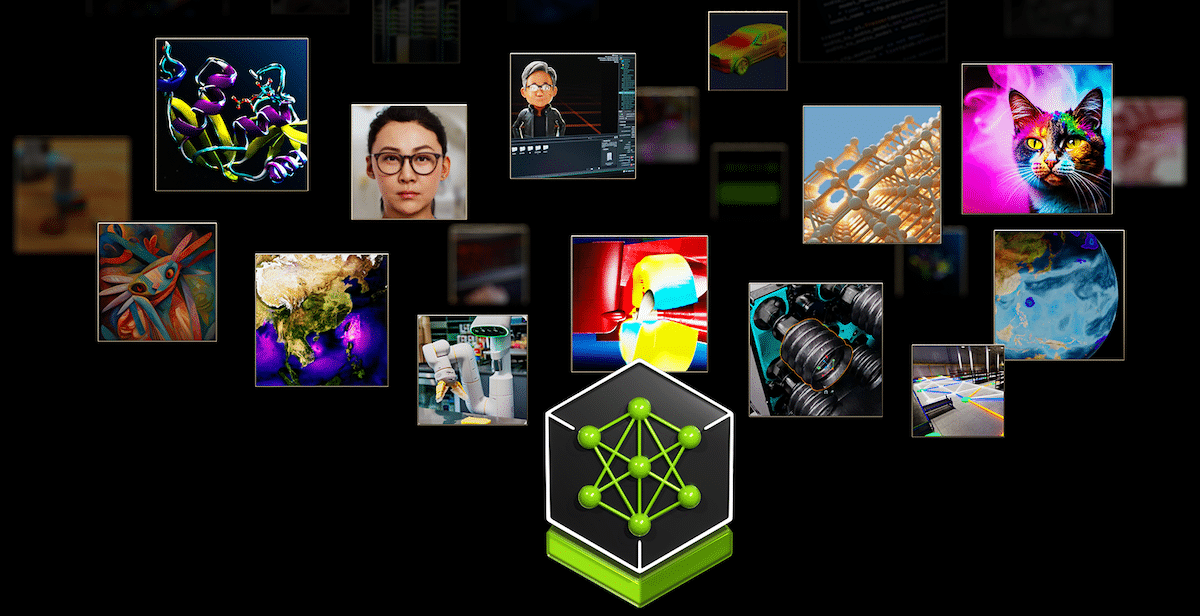

Naarmate generatieve AI-applicaties steeds complexer worden, waarbij vaak gebruik wordt gemaakt van meerdere modellen voor het genereren van tekst, afbeeldingen, video en spraak, verbetert NVIDIA NIM de productiviteit van ontwikkelaars door een gestandaardiseerde methode aan te bieden voor het integreren van generatieve AI in applicaties. NIM stelt ondernemingen in staat hun infrastructuurinvesteringen te maximaliseren, wat wordt geïllustreerd door de mogelijkheid om Meta Llama 3-8B uit te voeren met tot drie keer meer generatieve AI-tokens op versnelde infrastructuur dan traditionele methoden. Deze efficiëntieverbetering stelt ondernemingen in staat meer reacties te genereren met dezelfde computerbronnen.

Brede acceptatie door de industrie

Bijna 200 technologiepartners, waaronder Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI en Synopsys, integreren NVIDIA NIM om generatieve AI-implementaties voor domeinspecifieke applicaties zoals copilots, code-assistenten en digitale menselijke avatars te versnellen. Hugging Face biedt ook NIM aan, te beginnen met Meta Llama 3.

Jensen Huang, oprichter en CEO van NVIDIA, benadrukte de toegankelijkheid en impact van NIM door NIM en zei: “Elke onderneming wil generatieve AI aan haar activiteiten toevoegen, maar niet elke onderneming heeft een toegewijd team van AI-onderzoekers.” NVIDIA NIM maakt generatieve AI beschikbaar voor vrijwel elke organisatie.

Bedrijven kunnen AI-applicaties implementeren met behulp van NIM via het NVIDIA AI Enterprise-softwareplatform. Vanaf volgende maand hebben leden van het NVIDIA Developer Program gratis toegang tot NIM voor onderzoek, ontwikkeling en testen op de infrastructuur van hun voorkeur.

Generatieve AI mogelijk maken in alle modaliteiten

NIM-containers zijn vooraf gebouwd om de modelimplementatie voor GPU-versnelde inferentie te versnellen en omvatten NVIDIA CUDA-software, NVIDIA Triton Inference Server en NVIDIA TensorRT-LLM-software. Meer dan 40 modellen, waaronder Databricks DBRX, Google's Gemma, Meta Llama 3, Microsoft Phi-3 en Mistral Large, zijn beschikbaar als NIM-eindpunten op ai.nvidia.com.

Ontwikkelaars hebben toegang tot NVIDIA NIM-microservices voor Meta Llama 3-modellen via het Hugging Face AI-platform, waardoor ze Llama 3 NIM gemakkelijk kunnen uitvoeren met behulp van Hugging Face Inference Endpoints, mogelijk gemaakt door NVIDIA GPU's.

Uitgebreide ecosysteemondersteuning

Platformaanbieders zoals Canonical, Red Hat, Nutanix en VMware ondersteunen NIM op open-source KServe- of bedrijfsoplossingen. AI-toepassingsbedrijven, waaronder Hippocratic AI, Glean, Kinetica en Redis, zetten NIM in om generatieve AI-inferentie mogelijk te maken. Toonaangevende AI-tools en MLOps-partners zoals Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot en anderen hebben NIM in hun platforms ingebed, waardoor ontwikkelaars domeinspecifieke generatieve AI-applicaties met geoptimaliseerde inferentie kunnen bouwen en implementeren.

Wereldwijde systeemintegratoren en serviceleveringspartners zoals Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS en Wipro hebben NIM-competenties ontwikkeld om bedrijven te helpen snel productie-AI-strategieën te ontwikkelen en in te zetten. Bedrijven kunnen NIM-compatibele applicaties draaien op NVIDIA-gecertificeerde systemen van fabrikanten zoals Cisco, Dell Technologies, Hewlett-Packard Enterprise, Lenovo en Supermicro, evenals op servers van ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron en Wiwynn. NIM-microservices zijn ook geïntegreerd in grote cloudplatforms, waaronder Amazon Web Services, Google Cloud, Azure en Oracle Cloud Infrastructure.

Industrie-adoptie en gebruiksscenario's

Toonaangevende bedrijven maken gebruik van NIM voor diverse toepassingen in verschillende sectoren. Foxconn gebruikt NIM voor domeinspecifieke LLM's in AI-fabrieken, slimme steden en elektrische voertuigen. Pegatron gebruikt NIM voor Project TaME om de lokale LLM-ontwikkeling voor verschillende industrieën te bevorderen. Amdocs gebruikt NIM voor een LLM voor klantfacturering, waardoor de kosten en latentie aanzienlijk worden verlaagd en de nauwkeurigheid wordt verbeterd. ServiceNow integreert NIM-microservices binnen zijn Now AI multimodale model, waardoor klanten snelle en schaalbare LLM-ontwikkeling en -implementatie kunnen krijgen.

Beschikbaarheid

Ontwikkelaars kunnen experimenteren met NVIDIA-microservices op ai.nvidia.com geen kosten. Bedrijven kunnen NIM-microservices van productiekwaliteit implementeren met NVIDIA AI Enterprise op NVIDIA-gecertificeerde systemen en toonaangevende cloudplatforms. Ontwikkelaars die geïnteresseerd zijn in gratis toegang tot NIM voor onderzoek en testen kunnen zich registreren voor toegang, die naar verwachting volgende maand beschikbaar zal zijn.

Neem contact op met StorageReview

Nieuwsbrief | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed