Under AWS re:Invent keynote tillkännagav AWS och NVIDIA en betydande utveckling för artificiell intelligens (AI). AWS VD Adam Selipsky bjöd in NVIDIAs VD Jensen Huang på scenen för att utveckla de två företagens strategiska samarbetsinsatser. Detta partnerskap är inställt på att leverera den mest avancerade infrastrukturen, mjukvaran och tjänsterna, vilket underblåser generativa AI-innovationer. Samarbetet är en blandning av NVIDIAs banbrytande teknik och AWS robusta molninfrastruktur, vilket markerar en ny era inom AI-utveckling.

Under AWS re:Invent keynote tillkännagav AWS och NVIDIA en betydande utveckling för artificiell intelligens (AI). AWS VD Adam Selipsky bjöd in NVIDIAs VD Jensen Huang på scenen för att utveckla de två företagens strategiska samarbetsinsatser. Detta partnerskap är inställt på att leverera den mest avancerade infrastrukturen, mjukvaran och tjänsterna, vilket underblåser generativa AI-innovationer. Samarbetet är en blandning av NVIDIAs banbrytande teknik och AWS robusta molninfrastruktur, vilket markerar en ny era inom AI-utveckling.

Revolutionerande Cloud AI med NVIDIA GH200 Grace Hopper Superchips

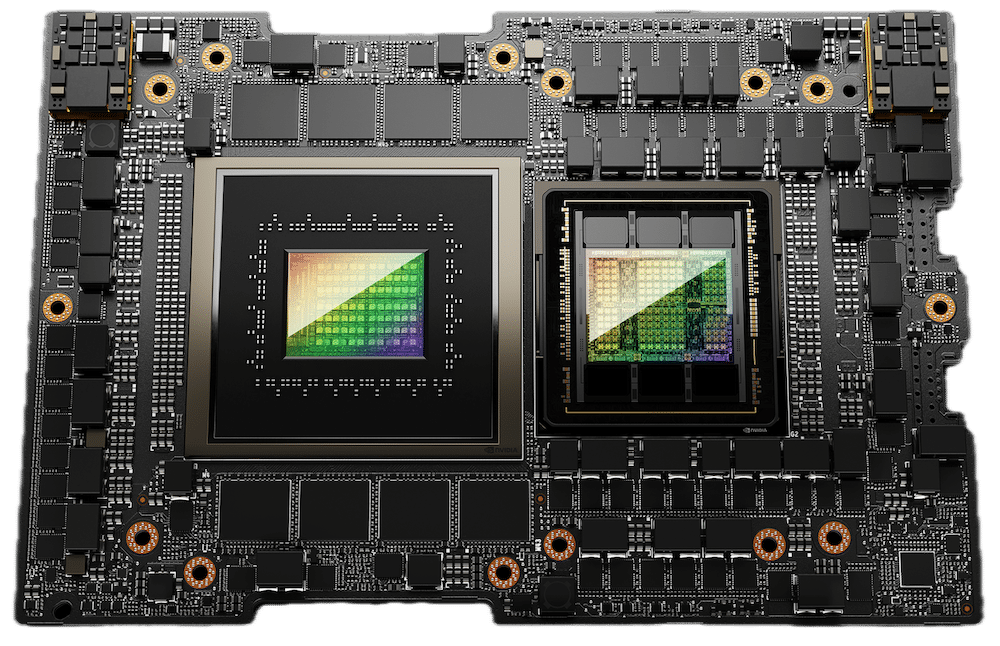

En hörnsten i detta samarbete är AWS:s introduktion av NVIDIAs GH200 Grace Hopper Superchips in i molnet, en första bland molnleverantörer. Dessa superchips representerar ett betydande steg i molnbaserad AI-beräkning. GH200 NVL32 multi-nod-plattformen, som ansluter 32 Grace Hopper Superchips med hjälp av NVIDIA NVLink- och NVSwitch-tekniker, kommer att integreras i Amazon EC2-instanser. Dessa nya Amazon EC2-instanser tillgodoser olika arbetsbelastningar för AI, HPC och grafik.

Varje GH200 Superchip kombinerar en Arm-baserad Grace CPU med en NVIDIA Hopper-arkitektur GPU på samma modul, vilket gör att en enda EC2-instans kan tillhandahålla upp till 20TB delat minne för att driva terabyte-skala arbetsbelastningar. Denna inställning tillåter gemensamma kunder att skala till tusentals GH200 Superchips, vilket erbjuder oöverträffad beräkningskraft för AI-forskning och applikationer.

Överladdning Generativ AI, HPC, design och simulering

AWS introducerar tre nya EC2-instanser: P5e-instanserna, drivna av NVIDIA H200 Tensor Core GPU:er, är designade för storskaliga och banbrytande generativa AI- och HPC-arbetsbelastningar. G6- och G6e-instanserna, som drivs av NVIDIA L4 respektive L40S GPU, är lämpade för AI-finjustering, slutledning, grafik och videoarbetsbelastningar. G6e-instanserna är särskilt lämpliga för att utveckla 3D-arbetsflöden, digitala tvillingar och applikationer med NVIDIA Omniverse, en plattform för att bygga generativa AI-aktiverade 3D-applikationer.

NVIDIA GH200-drivna EC2-instanser kommer att ha 4.5 TB HBM3e-minne. Det är en ökning på 7.2 gånger jämfört med nuvarande H100-drivna EC2 P5d-instanser. CPU-till-GPU-minneskoppling kommer att ge upp till 7 gånger högre bandbredd än PCIe, vilket möjliggör chip-till-chip-kommunikation som utökar det totala minnet som är tillgängligt för applikationer.

AWS-instanser med GH200 NVL32 kommer att vara den första AI-infrastrukturen på AWS som har vätskekylning. Detta kommer att hjälpa till att säkerställa att tätt packade serverrack fungerar effektivt med maximal prestanda. EC2-instanser med GH200 NVL32 kommer också att dra nytta av AWS Nitro System, den underliggande plattformen för nästa generations EC2-instanser. Nitro avlastar I/O för funktioner från värd-CPU/GPU till specialiserad hårdvara, vilket ger mer konsekvent prestanda med förbättrad säkerhet för att skydda kundkod och data under bearbetning.

NVIDIA-programvara på AWS ökar generativ AI-utveckling

I ett annat spelförändrande tillkännagivande kommer NVIDIA-programvara som körs på AWS att öka generativ AI-utveckling. NVIDIA NeMo Retriever microservice kommer att erbjuda verktyg för att skapa korrekta chatbots och sammanfattningsverktyg med hjälp av accelererad semantisk hämtning.

Läkemedelsföretag kan påskynda läkemedelsupptäckten med NVIDIA BioNeMo, som är tillgänglig på Amazon SageMaker och kommer till DGX Cloud.

Med hjälp av NVIDIA NeMo-ramverket kommer AWS att träna utvalda nästa generations Amazon Titan LLM. Amazon Robotics använder NVIDIA Omniverse Isaac för att bygga digitala tvillingar för automatisering, optimering och planering av autonoma lager i virtuella miljöer innan de distribueras i den verkliga världen.

NVIDIA DGX Cloud Hosted on AWS: Democratizing AI Training

En annan central aspekt av detta partnerskap är att vara värd för NVIDIA DGX Cloud på AWS. Denna AI-utbildning-som-en-tjänst kommer att vara den första med GH200 NVL32, vilket ger utvecklare det största delade minnet i en enda instans. De DGX Cloud på AWS kommer att avsevärt påskynda utbildningen av banbrytande generativ AI och stora språkmodeller (LLM), som potentiellt når över 1 biljon parametrar. Den här tjänsten demokratiserar tillgången till avancerade AI-utbildningsresurser, som tidigare endast var tillgängliga för de med betydande beräkningsinfrastruktur.

Projekt Ceiba: Bygga världens snabbaste GPU-drivna AI-superdator

I ett ambitiöst drag samarbetar AWS och NVIDIA i Project Ceiba för att bygga världens snabbaste GPU-drivna AI-superdator. Detta system, som har 16,384 200 NVIDIA GH65 Superchips och kan bearbeta XNUMX exaflops av AI, kommer att vara värd för NVIDIAs forsknings- och utvecklingsteam av AWS. Superdatorn kommer att driva fram NVIDIAs generativa AI-innovation och påverka områden som digital biologi, robotik, autonoma fordon och klimatförutsägelser.

En ny era av AI-utveckling på AWS

Detta utökade samarbete mellan AWS och NVIDIA är mer än bara ett tekniskt framsteg; det är ett paradigmskifte inom molnbaserad AI-beräkning. Genom att kombinera NVIDIAs avancerade AI-infrastruktur och AWS:s molnfunktioner kommer detta partnerskap att revolutionera hur generativ AI utvecklas och distribueras i olika branscher. Från läkemedel till autonoma fordon, implikationerna av detta samarbete är omfattande och långtgående och lovar att låsa upp nya möjligheter inom AI och vidare.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde