NVIDIA tog rampljuset på AWS re:Invent genom att introducera NVIDIA NeMo Retriever, en ny generativ AI-mikrotjänst som lovar att förbättra företagets AI-landskap genom att möjliggöra integration av anpassade stora språkmodeller (LLM) med företagsdata. Målet är att NeMo Retriever ska leverera oöverträffade exakta svar för AI-applikationer i företaget.

NVIDIA tog rampljuset på AWS re:Invent genom att introducera NVIDIA NeMo Retriever, en ny generativ AI-mikrotjänst som lovar att förbättra företagets AI-landskap genom att möjliggöra integration av anpassade stora språkmodeller (LLM) med företagsdata. Målet är att NeMo Retriever ska leverera oöverträffade exakta svar för AI-applikationer i företaget.

NVIDIA NeMo Retriever är det senaste tillskottet till NeMo-familjen, känd för sina avancerade ramverk och verktyg utformade för att bygga, anpassa och distribuera banbrytande generativa AI-modeller. Denna mikrotjänst för semantisk hämtning i företagsklass är konstruerad för att förbättra generativa AI-applikationer med robusta RAG-funktioner (Retrieval Augmented Generation).

Det som utmärker NeMo Retriever är dess förmåga att ge mer exakta svar genom NVIDIA-optimerade algoritmer. Den här mikrotjänsten gör det möjligt för utvecklare att sömlöst ansluta sina AI-applikationer till olika affärsdata, oavsett plats - över moln eller i datacenter. En del av NVIDIA AI Enterprise-programvaruplattformen är lätt tillgänglig på AWS Marketplace.

NVIDIA NeMo Retriever används redan

Teknikens inverkan är redan märkbar med branschledare som Cadence, Dropbox, SAP och ServiceNow som samarbetar med NVIDIA. De integrerar den här tekniken i sina anpassade generativa AI-applikationer och tjänster, och tänjer på gränserna för vad som är möjligt inom business intelligence.

"Generativ AI introducerar innovativa tillvägagångssätt för att möta kundernas behov, såsom verktyg för att upptäcka potentiella brister tidigt i designprocessen," Anirudh Devgan, VD och koncernchef för Cadence

Cadence, en global ledare inom design av elektroniska system, använder NeMo Retriever för att utveckla RAG-funktioner för AI-applikationer inom industriell elektronikdesign. Anirudh Devgan, Cadences VD, lyfte fram potentialen hos generativ AI för att tidigt avslöja designbrister och därigenom påskynda produktutvecklingen av hög kvalitet.

Till skillnad från RAG-verktygssatser med öppen källkod kommer NeMo Retriever till marknaden med sin produktionsklara ställning, och erbjuder kommersiellt gångbara modeller, API-stabilitet, säkerhetskorrigeringar och företagsstöd. Dess optimerade inbäddningsmodeller är ett stort tekniskt framsteg, som fångar intrikata ordrelationer och förbättrar LLM:ers bearbetnings- och analysmöjligheter.

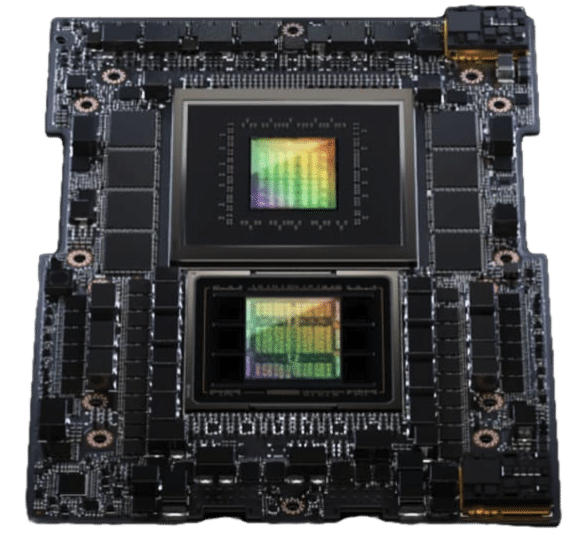

NVIDIA GH200 Superchip

Varför NVIDIA NeMo Retriever spelar roll

NeMo Retrievers förmåga att ansluta LLM till flera datakällor och kunskapsbaser är anmärkningsvärd. Det gör det möjligt för användare att interagera med data genom enkla samtalsuppmaningar och få korrekta, uppdaterade svar. Den här funktionen sträcker sig över olika datamodaliteter, inklusive text, PDF-filer, bilder och videor, vilket säkerställer omfattande och säker informationsåtkomst.

Mest spännande är att NVIDIA NeMo Retriever lovar mer exakta resultat med mindre träning, vilket snabbar upp tiden till marknaden och stödjer energieffektivitet i utvecklingsarbetsflödet för generativa AI-applikationer.

Det är här NeMo Retriever verkligen lyser. Genom att integrera RAG med LLM:er övervinner NeMo Retriever begränsningarna hos traditionella modeller. RAG kombinerar kraften i informationshämtning med LLM:er, särskilt för applikationer för svar på frågor med öppen domän, vilket avsevärt förbättrar LLM:s tillgång till omfattande, uppdateringsbara kunskapsbaser.

En titt in i RAG Pipeline

NeMo Retriever optimerar RAG-processer, med början från att koda kunskapsbasen i en offlinefas. I denna fas klipps dokument i olika format och bäddas in med hjälp av en djupinlärningsmodell för att producera täta vektorrepresentationer. Dessa lagras sedan i en vektordatabas, avgörande för semantiska sökningar senare. Inbäddningsprocessen är nyckeln, eftersom den fångar relationerna mellan ord, vilket gör det möjligt för LLM:er att bearbeta och analysera textdata med ökad noggrannhet.

Under huven, i produktion och svar på frågor är där NeMo Retrievers kapacitet verkligen lyser. Det involverar två avgörande faser: hämtning från vektordatabasen och svarsgenerering. När en användare matar in en fråga, bäddar NeMo Retriever först in denna fråga som en tät vektor och använder den för att söka i vektordatabasen. Denna databas hämtar sedan de mest relevanta dokumentbitarna relaterade till frågan. I slutfasen kombineras dessa bitar för att bilda ett sammanhang, som tillsammans med användarens fråga matas in i LLM. Denna process säkerställer att de svar som genereras är korrekta och mycket relevanta för användarens fråga.

Övervinna företagsutmaningar med NVIDIA NeMo

Att bygga en RAG-pipeline för företagstillämpningar är en betydande utmaning. Från komplexiteten i verkliga frågor till efterfrågan på samtal i flera svängar, företag kräver en lösning som är både tekniskt avancerad, kompatibel och kommersiellt gångbar. NeMo Retriever strävar efter att uppfylla denna uppgift genom att tillhandahålla produktionsklara komponenter optimerade för låg latens och hög genomströmning, och lovar att företag kan distribuera dessa funktioner i sina AI-applikationer.

NVIDIAs engagemang för den här tekniken sträcker sig till att kontinuerligt förbättra sina modeller och tjänster, som med NVIDIAs inbäddningsmodell för Q&A Retrieval. Som en transformatorkodare säger NVIDIA att den har finjusterats för att tillhandahålla de mest exakta inbäddningarna för textbaserade frågesvar, som utnyttjar både privata och offentliga datauppsättningar.

Bemyndigande företag med state-of-the-art AI

De praktiska tillämpningarna av NeMo Retriever är omfattande och varierande. Från IT- och HR-hjälpassistenter till FoU-forskningsassistenter, NeMo Retrievers förmåga att ansluta LLM:er till flera datakällor och kunskapsbaser ger företag möjlighet att interagera med data på ett mer konversativt, intuitivt sätt. NeMo Retriever är redo att förbättra användarupplevelsen och öka effektiviteten och produktiviteten i olika affärsfunktioner över företag.

Utvecklare som är ivriga att utnyttja denna revolutionerande teknik kan registrera sig för tidig åtkomst till NVIDIA NeMo Retriever.

Spänningen kring den här utgåvan är påtaglig, eftersom den förbättrar nuvarande AI-kapacitet och öppnar upp en mängd möjligheter för LLM-antagande i företagssektorn. Termen "game-changer" slängs oftare än inte i de senaste AI-nyheterna. Ändå är NeMo Retriever en nyckelsten i att länka samman generativ AI och handlingsbar affärsintelligens, vilket ger en påtaglig brygga mellan avancerade AI-funktioner och verkliga företagsapplikationer.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde