IBM kommer att lägga till AMD Instinct MI300X-acceleratorer som en tjänst på IBM Cloud för att förbättra prestanda och energieffektivitet för GenAI-modeller.

IBM har meddelat ett utökat samarbete med AMD för att introducera AMD Instinct MI300X-acceleratorer som en tjänst på IBM Cloud. Den här lösningen förbättrar prestanda och energieffektivitet för generativa AI-modeller (GenAI) och högpresterande datorapplikationer (HPC), och möter den ökande efterfrågan på skalbara AI-lösningar bland företagskunder.

Partnerskapet utökar stödet till AMD Instinct MI300X acceleratorer över IBM:s AI och dataekosystem, inklusive watsonx AI-plattformen och Red Hat® Enterprise Linux® för AI-inferencing. Detta är i linje med IBM Clouds befintliga portfölj, som redan finns Intel Gaudi 3 acceleratorer och förlänger NVIDIA H100 Tensor Core GPU instanser, vilket ytterligare förbättrar dess förmåga att leverera högpresterande AI- och HPC-arbetsbelastningar.

Avancerade funktioner hos AMD Instinct MI300X-acceleratorer

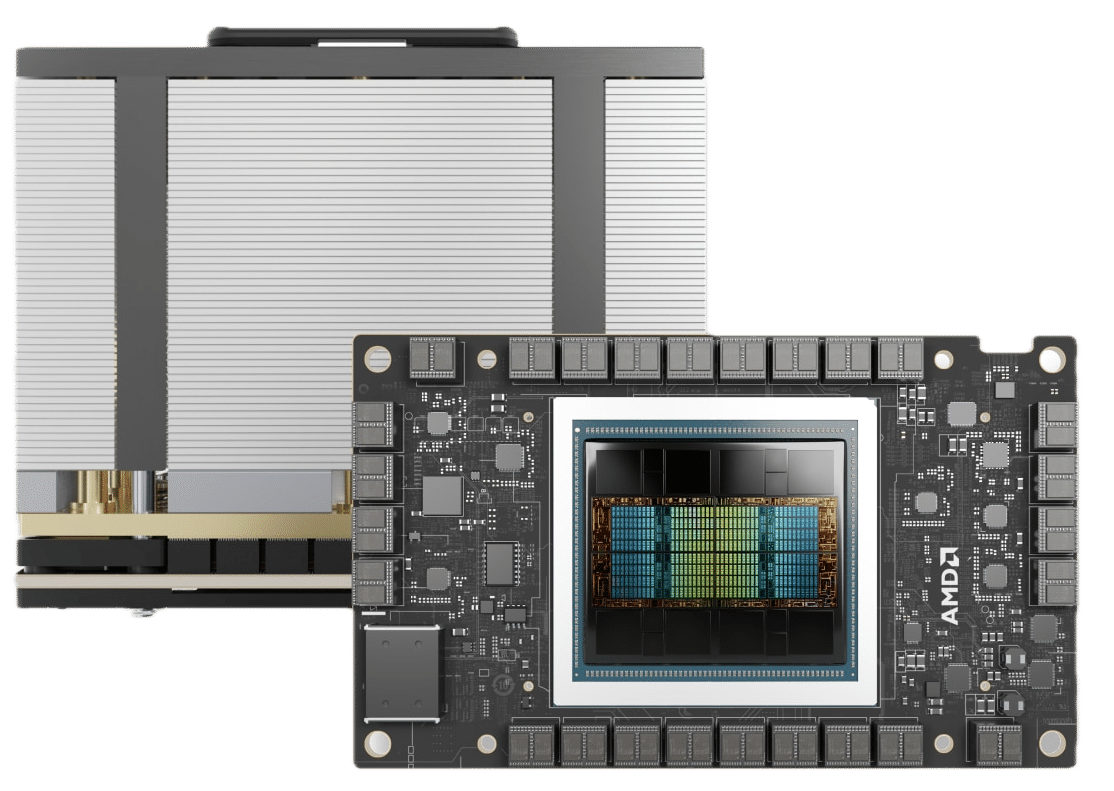

AMD Instinct MI300X-acceleratorerna, utrustade med 192 GB minne med hög bandbredd (HBM3), är konstruerade för att stödja inferencing och finjustering av stora modeller för AI-applikationer för företag. Deras höga minneskapacitet gör att företag kan köra större AI-modeller med färre grafikprocessorer, vilket minskar kostnaderna samtidigt som prestanda och skalbarhet bibehålls. Vi testade nyligen dessa acceleratorer i vår XE9680 recension.

Genom att erbjuda dessa acceleratorer som en tjänst på IBM Cloud Virtual Servers för VPC och via containeriserade lösningar som IBM Cloud Kubernetes Service och IBM Red Hat OpenShift, strävar IBM efter att förse företagskunder med en säker, högpresterande miljö optimerad för deras AI-arbetsbelastningar. Denna flexibilitet gör det möjligt för organisationer att skala sina AI-distributioner effektivt samtidigt som de bibehåller robust säkerhet och efterlevnad – särskilt viktigt för kunder i starkt reglerade branscher.

Integration med IBM watsonx och Red Hat Platforms

För att möta behoven av generativa AI-inferencing-arbetsbelastningar planerar IBM att integrera AMD Instinct MI300X-acceleratorer med sin watsonx AI-plattform. Detta kommer att utrusta watsonx-klienter med ytterligare AI-infrastrukturresurser, vilket gör det möjligt för dem att skala arbetsbelastningar sömlöst över hybridmolnmiljöer. Acceleratorerna kommer också att stödja Red Hat Enterprise Linux AI och Red Hat OpenShift AI-plattformar, vilket gör att företag kan distribuera stora språkmodeller (LLM) som Granite-familjen med avancerade anpassningsverktyg som InstructLab.

Dessa integrationer understryker acceleratorernas förmåga att hantera datorintensiva arbetsbelastningar med större flexibilitet, vilket gör det möjligt för företag att prioritera prestanda, kostnadseffektivitet och skalbarhet i sina AI-distributioner.

Philip Guido, Executive Vice President och Chief Commercial Officer på AMD, betonade vikten av prestanda och flexibilitet vid bearbetning av datorintensiva arbetsbelastningar, särskilt när företag använder större AI-modeller. Han noterade att AMD Instinct-acceleratorer, parade med AMD ROCm-programvara, erbjuder omfattande ekosystemstöd för plattformar som IBM watsonx AI och Red Hat OpenShift AI, vilket gör det möjligt för kunder att exekvera och skala GenAI-inferencing utan att kompromissa med effektivitet eller kostnad.

Alan Peacock, General Manager för IBM Cloud, upprepade dessa känslor och betonade AMD och IBM:s gemensamma vision att föra AI-lösningar till företag. Han konstaterade att utnyttjande av AMD-acceleratorer på IBM Cloud ger företagskunder skalbara, kostnadseffektiva alternativ för att uppfylla sina AI-mål, uppbackade av IBM:s engagemang för säkerhet, efterlevnad och resultatdrivna lösningar.

Samarbete ger förbättrad säkerhet och efterlevnad

Samarbetet utnyttjar IBM Clouds välkända säkerhets- och efterlevnadskapacitet, vilket säkerställer att företag, inklusive de i hårt reglerade industrier, med tillförsikt kan använda AI-infrastruktur som drivs av AMD-acceleratorer. Detta engagemang för säkerhet är en integrerad del av IBM och AMD:s strategi att stödja företags-AI-antagande i stor skala.

Med detta samarbete förser IBM och AMD företag med en banbrytande AI-infrastruktur som balanserar prestanda, skalbarhet och effektivitet. Tillägget av AMD Instinct MI300X-acceleratorer till IBM Cloud är redo att möta de växande kraven på företags AI-arbetsbelastningar, vilket ger organisationer möjlighet att låsa upp nya möjligheter i AI- och HPC-applikationer.

Tillgänglighet

IBMs molntjänster med AMD Instinct MI300X-acceleratorer förväntas vara allmänt tillgängliga under första halvåret 2025, vilket ytterligare utökar IBM:s högpresterande AI- och HPC-lösningsportfölj.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde