PEAK:AIO-tokenminnesplattformen använder KVCache-återanvändning och CXL för att leverera snabbare inferens, större kontextfönster och AI-förberedd minnesskalning.

PEAK:AIO har introducerat en innovativ lösning utformad för att förena KVCache-acceleration med GPU-minnesexpansion, med fokus på kraven från storskaliga AI-arbetsbelastningar. Den här nya plattformen tillgodoser behoven från inferens, agentsystem och modellskapande, i takt med att AI-applikationer går bortom statiska prompter till dynamiska kontextströmmar och långvariga agenter. Förändringen i AI-arbetsbelastningens komplexitet kräver en motsvarande utveckling av infrastrukturen, och PEAK:AIOs senaste erbjudande är konstruerat för att möta dessa utmaningar direkt.

Eyal Lemberger, medgrundare och chefsstrateg för AI på PEAK:AIO, understryker det kritiska behovet av att behandla tokenhistorik som minne snarare än traditionell lagring. Han påpekar att moderna AI-modeller kan kräva mer än 500 GB minne per instans, och att skalning av minne måste hålla jämna steg med framstegen inom beräkningsteknik. Lemberger noterar att i takt med att transformatormodeller växer och blir mer komplexa, är äldre metoder, som att eftermontera lagringsstackar eller överutöka NVMe, inte längre tillräckliga. Den nya 1U Token Memory Platform från PEAK:AIO är specialbyggd för minnescentrerade operationer, inte fillagring, vilket markerar en betydande avvikelse från konventionella arkitekturer.

Tokencentrerad arkitektur för skalbar AI

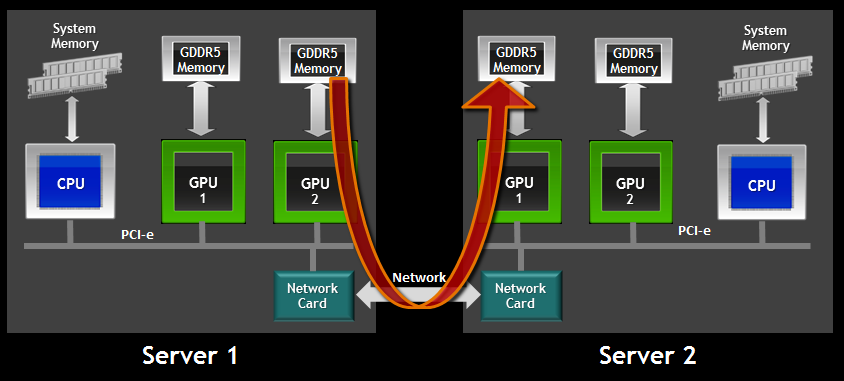

PEAK:AIO-plattformen är den första att implementera en tokencentrerad arkitektur som utnyttjar CXL-minne, Gen5 NVMe och GPUDirect RDMA för att leverera upp till 150 GB/s ihållande dataflöde med en latens på under 5 mikrosekunder.

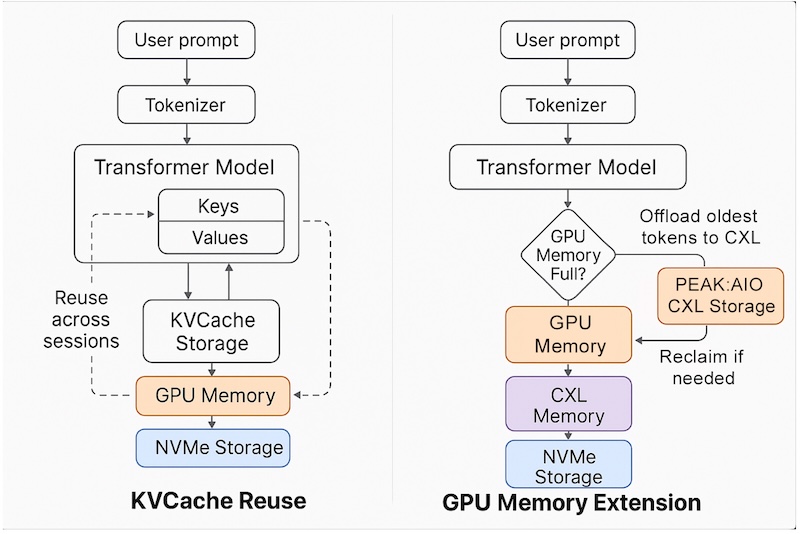

Plattformen stöder återanvändning av KVCache över sessioner, modeller och noder, vilket möjliggör effektivare minnesutnyttjande och snabbare kontextväxling. Den möjliggör också expansion av kontextfönster, vilket är avgörande för att upprätthålla längre LLM-historik och stödja mer komplexa AI-interaktioner. Genom att avlasta GPU-minne genom äkta CXL-nivåer minskar lösningen GPU-minnesmättnad, en vanlig flaskhals i storskaliga AI-distributioner. Ultralåg latens uppnås med hjälp av RDMA över NVMe-oF, vilket säkerställer att tokenminne är tillgängligt med minnesklasshastigheter.

Till skillnad från traditionella NVMe-baserade lagringslösningar är PEAK:AIOs arkitektur utformad för att fungera som en sann minnesinfrastruktur. Detta gör det möjligt för team att cachelagra tokenhistorik, uppmärksamhetskartor och strömmande data med RAM-minnets hastighet och effektivitet, snarare än att behandla dessa element som filer. Plattformen är helt i linje med NVIDIAs modeller för återanvändning och minnesåtervinning av KVCache, vilket ger sömlös integration för team som arbetar med TensorRT-LLM eller Triton. Denna plugin-kompatibilitet accelererar inferens och minskar integrationskostnader, vilket ger en betydande prestandafördel.

Lemberger betonar att medan andra leverantörer försöker anpassa filsystem för att bete sig som minne, har PEAK:AIO utvecklat en infrastruktur som i sig fungerar som minne. Denna distinktion är avgörande för modern AI, där prioriteten är snabb åtkomst i minnesklass till varje token, inte bara fillagring.

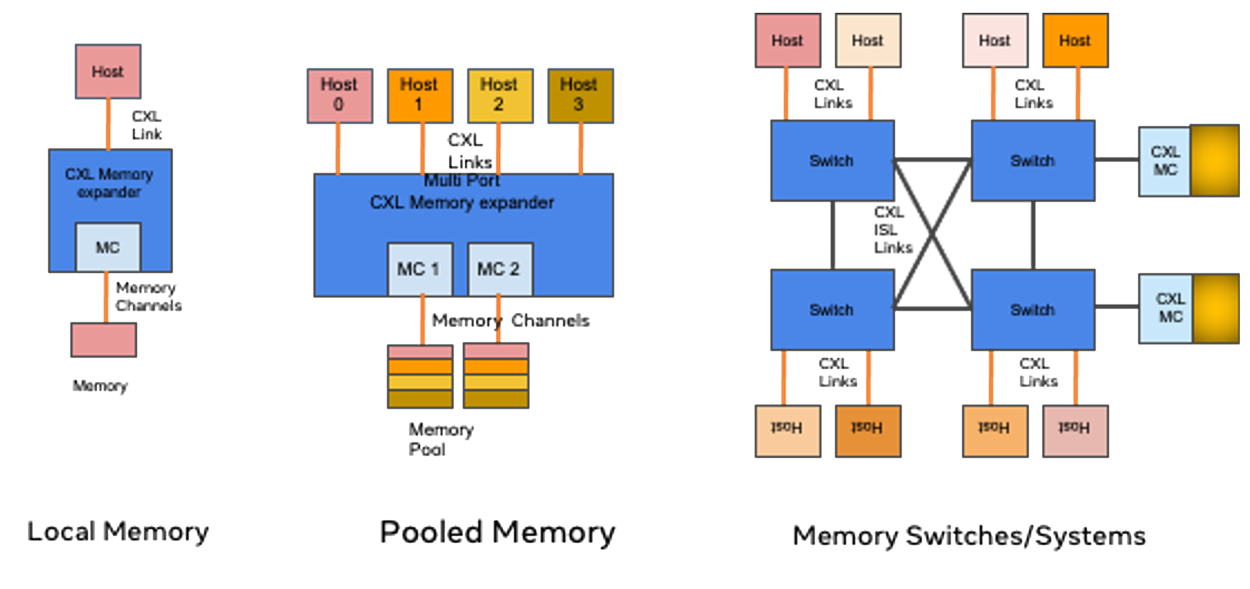

Mark Klarzynski, medgrundare och strategichef på PEAK:AIO, framhäver användningen av CXL-teknik som en viktig differentiator. Han beskriver plattformen som en sann minnesstruktur för AI, till skillnad från konkurrenter som staplar NVMe-enheter. Klarzynski noterar att denna innovation är avgörande för att leverera genuina minnesfunktioner i stor skala och stödja nästa generations AI-arbetsbelastningar.

Lösningen är helt mjukvarudefinierad och körs på standardservrar, vilket gör den tillgänglig och skalbar för olika företags- och molnmiljöer. PEAK:AIO förväntar sig att plattformen ska gå i produktion under tredje kvartalet, vilket positionerar den som en transformerande teknik för teknisk försäljning, teknikteam och chefer som vill framtidssäkra sin AI-infrastruktur.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde