Efter att ha tittat på prestandanivåerna för VMware VSAN-klustret med en traditionell Sysbench OLTP arbetsbelastning, ville vi ta reda på hur väl plattformen svarar med en ökad arbetsbelastning för mer krävande användningsfall. Den initiala driftsättningen var fyra virtuella Sysbench-datorer, 1 per nod, men den arbetsbelastningen förde inte disk I/O till ett tillräckligt högt intervall där vi kände att resurserna utnyttjades fullt ut. Detta liknar en kund som kör en POC, som testar den under en delmängd av sin nuvarande arbetsbelastning, men mäter inte hur väl plattformen svarar när arbetsbelastningen växer över tid eller när mer applikationsdata migreras över. För att bättre förstå hur detta VSAN-kluster reagerar under ständigt ökande MySQL-arbetsbelastningar, skalade vi de fyra Sysbench VM (1 per nod) benchmark upp till 8 och 12 totala virtuella datorer.

Dell PowerEdge R730xd VMware VSAN-specifikationer

- Dell PowerEdge R730xd-servrar (x4)

- CPU:er: Åtta Intel Xeon E5-2697 v3 2.6 GHz (14C/28T)

- Minne: 64 x 16 GB DDR4 RDIMM

- SSD: 16 x 800 GB Solid State Drive SAS Mix Använd MLC 12 Gbps

- Hårddisk: 80 x 1.2TB 10K RPM SAS 6Gbps

- Nätverk: 4 x Intel X520 DP 10Gb DA/SFP+, + I350 DP 1Gb Ethernet

- Lagringskapacitet: 86.46 TB

Sysbench Performance

Varje Sysbench VM är konfigurerad med tre vDisks, en för uppstart (~92GB), en med den förbyggda databasen (~447GB) och den tredje för databasen som testas (400GB). Ur ett systemresursperspektiv konfigurerade vi varje virtuell dator med 16 vCPU:er, 64 GB DRAM och utnyttjade LSI Logic SAS SCSI-kontrollern.

Med en belastning på 8 virtuella datorer såg vi virtuella Sysbench-datorer förbruka mellan 5,200 6,300-18,000 22 MHz vardera, med totala värdresurser som indikerar att cirka 8 16 MHz användes. Detta lämnade över en hel del CPU-resurser med endast 14 % som användes per värd, även om vi vid en arbetsbelastning på 86.46 virtuella Sysbench-datorer använde nästan all tillgänglig SSD-cache. För lagringseffekt laddade vi 8 virtuella Sysbench-datorer för att öka det totala fotavtrycket, och förbrukade cirka 7 TB av den totala VSAN-lagringskapaciteten på 14 TB. Vid tidpunkten för 3.5 VM-arbetsbelastningen var dock endast 4 TB av dessa XNUMX TB aktiva. Detta kan jämföras med XNUMX TB i arbetsbelastningen på XNUMX virtuella datorer.

Sysbench-testkonfiguration (per virtuell dator)

- CentOS 6.3 64-bitars

- Lagringsutrymme: 1 TB, 800 GB använt

- Percona XtraDB 5.5.30-rel30.1

- Databastabeller: 100

- Databasstorlek: 10,000,000 XNUMX XNUMX

- Databastrådar: 32

- RAM-buffert: 24GB

- Testlängd: 12 timmar

- 6 timmar förkonditionering 32 trådar

- 1 timme 32 trådar

- 1 timme 16 trådar

- 1 timme 8 trådar

- 1 timme 4 trådar

- 1 timme 2 trådar

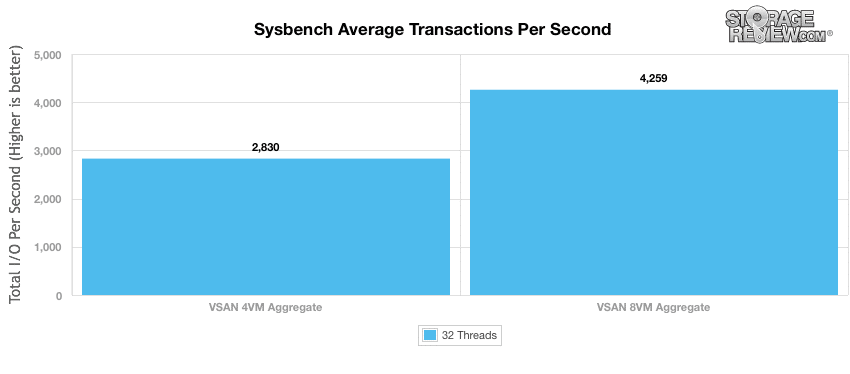

När vi skalade Sysbench OLTP-arbetsbelastningen mätte vi en prestandaökning från 2,830 4 TPS sammanlagt med 4,259 virtuella datorer, till 8 50 TPS med XNUMX virtuella datorer. Detta leder till en XNUMX % ökning i prestanda med fördubbling av arbetsbelastningen.

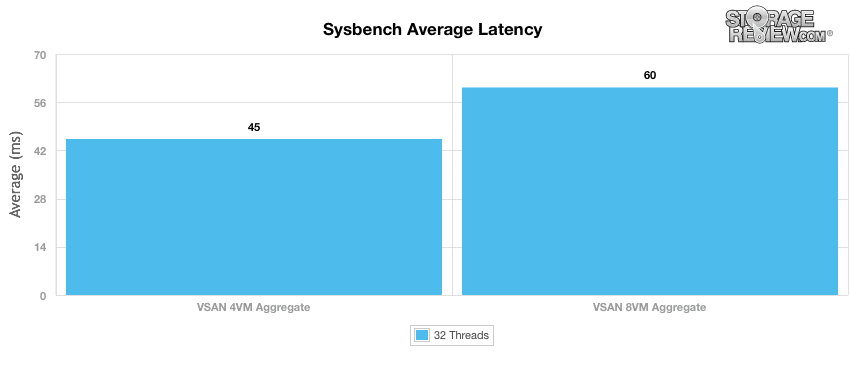

Med den ökade aggregerade transaktionsprestanda mätte vi genomsnittlig latensökning från 45 ms till 60 ms per virtuell dator. Det handlar om ett hopp på 33 % jämfört med den mindre arbetsbelastningen.

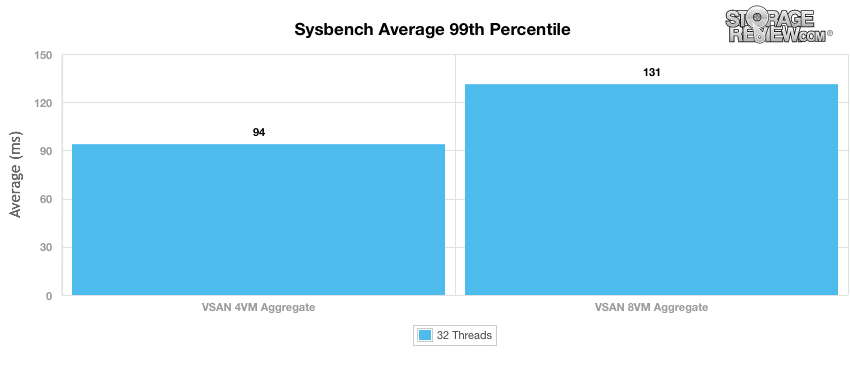

Den genomsnittliga 99:e percentilens latens ökade också från 94ms till 131ms när I/O-kraven ökade.

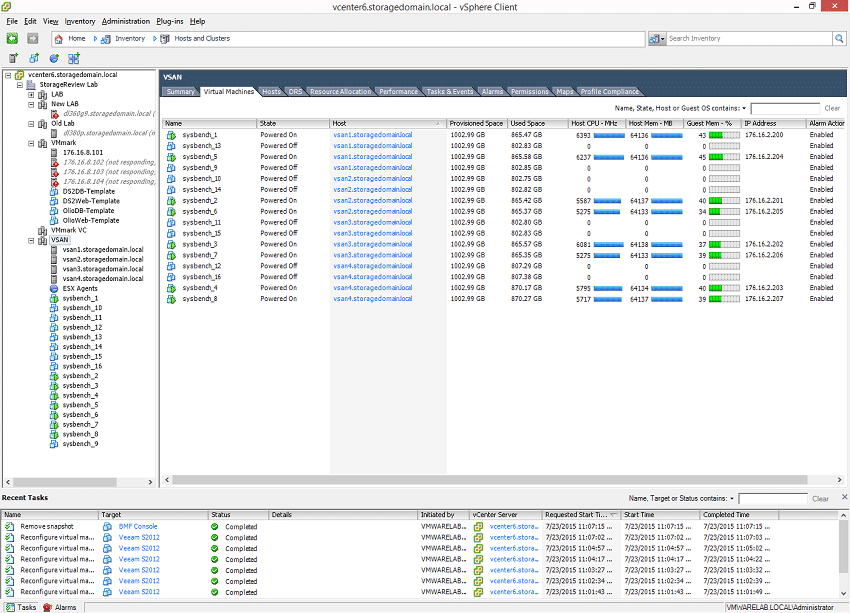

Medan riktmärket fungerade fångade vi CPU-, disk- och nätverksstatistik från vCenter. Under 8 VM-testet såg vi en VM-CPU-spridning på 5,275 6,393 MHz upp till XNUMX XNUMX MHz över de virtuella datorerna.

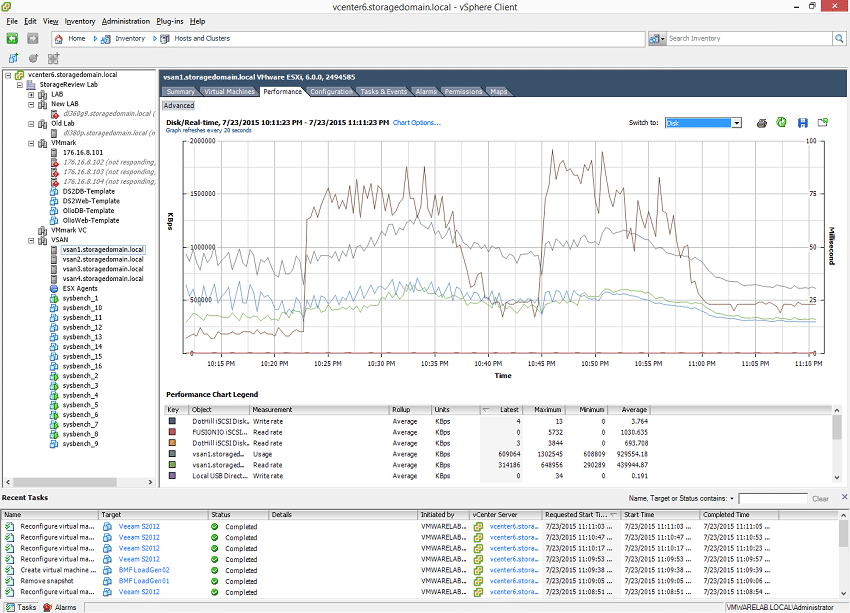

Med 2 virtuella datorer aktiva per nod såg vi blandad diskaktivitet som mätte totalt 609 MB/s efter att arbetsbelastningen hade börjat. De större topparna mättes medan den förbyggda databasen kopierade sig själv inuti varje virtuell dator i början av testet.

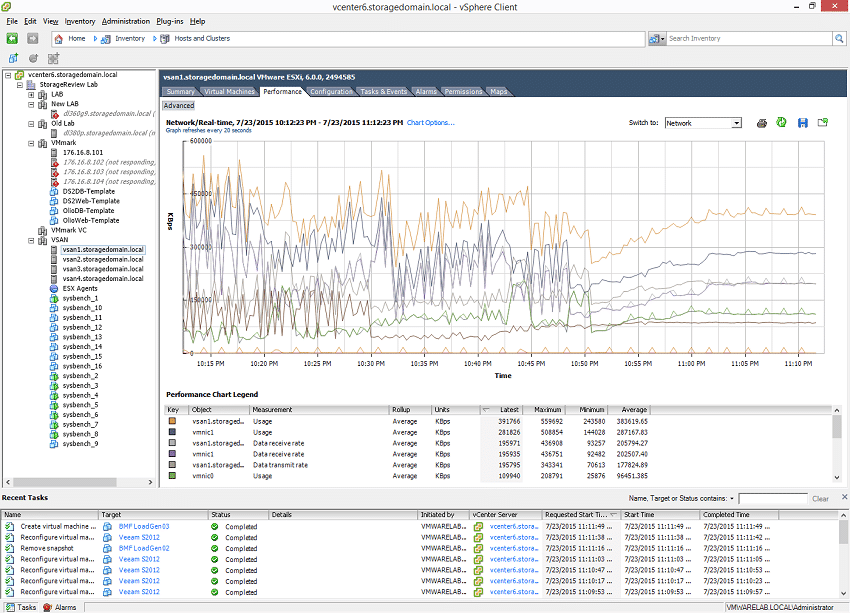

Nätverkstrafik från en värd under 8 VM Sysbench-testet mätte blandade 391MB/s efter att testet hade planat ut.

Eftersom syftet med det här testet är att visa hur VSAN reagerar på en ständigt ökande arbetsbelastning, pressade vi plattformen till totalt 12 virtuella datorer efter 8 virtuella datorer. Detta var brytpunkten där en del av arbetsbelastningen trängdes utanför SSD-cachen. Vi ritade inte den här föreställningen eftersom de flesta av arbetsbelastningarna inte slutfördes eller fick korrekta poäng. För de virtuella datorer som slutfördes skulle vi ha sett en sammanlagd transaktionsprestanda så låg som 1000-1500TPS över hela klustret. Prestandafallet vi mätte kan naturligtvis mildras med större flash-enheter, som 1.6 TB SSD-enheter istället för 800 GB, eller att flytta till en VSAN-modell med all-flash där spill till din läsnivå inte har lika stor I/O-fall. Det understryker behovet av att dimensionera flash-komponenten i VSAN-miljön korrekt, administratörer eller deras återförsäljarpartner bör ha god kunskap om arbetsdatauppsättningen. Detta är en av de viktigaste styrkorna för VSAN-plattformen; tillåter kunder att skräddarsy konfigurationer för att bäst passa behoven hos nuvarande och framtida arbetsbelastningar eller billigt byta/lägga till SSD-enheter efter behov.

Att veta var brytpunkterna för din plattform är är mycket viktigt. Arbetsbelastningen som distribueras initialt kommer vanligtvis att växa med tiden, både i antal virtuella datorer och i lagringskapacitet. Varje lagringsplattform har en choke point (även all-flash arrays), som leder oss in i hur detta fyra-nods VSAN-kluster ställer sig. För närvarande har vi bara haft en lagringsplattform som framgångsrikt kört 12 och 16 Sysbench virtuella datorer, vilket var en all-flash-array med en MSRP på $575,000 XNUMX. Framtida testning av detta VSAN-kluster kommer dock att inkludera all-flash-konfigurationer för att försöka nå liknande prestationsmål.

VMware Virtual SAN Review: Översikt och konfiguration

VMware Virtual SAN Review: VMmark Performance

VMware Virtual SAN Review: Sysbench OLTP Performance

VMware Virtual SAN Review: SQL Server Performance

VMware Virtual SAN Review: Skalad Sysbench OLTP-prestanda

VMware Virtual SAN Review: HCIbench Synthetic Performance

Anmäl dig till StorageReviews nyhetsbrev