X-IO skapade sitt namn inom SAN-lagring för företag genom att hitta ett sätt att säkerställa hårddiskar och i fallet med hybridkonfigurationer behövde SSD:er aldrig servas inom det garanterade femårsfönstret. För att hjälpa till att uppnå detta mål använder X-IO dubbla DataPacs som sätts in och låses i det helt redundanta chassit, vilket ger en "ställ in det och glöm det" lagringsstil. I mars i år lades X-IO till familjen av hårddiskar och hybridarrayer, med en ny serie av alla flash-konfigurationer och en uppdaterad tredje generationens arkitektur (G3). De ISE 800 G3-serien av alla flash-arrayer inkluderar tre modeller som sträcker sig från 6.4 TB till 51.2 TB råkapacitet. Var och en för med sig löftet om att dramatiskt minska frekvensen av servicesamtal, tillsammans med prestanda på upp till 400,000 5 IOPS, XNUMX GB/s bandbredd och en av de mer robusta QoS-motorerna.

X-IO har funnits tillräckligt länge vid det här laget för att de har många kunder som når det femåriga garantifönstret, vilket validerar, åtminstone till viss del, nyckelbudskapet om enkelhet i hanteringen. Med all-flash-konfigurationer är utmaningarna dock lite annorlunda. X-IO har mildrat farhågor kring uthållighet genom att introducera konceptet med slitageutjämning på arraynivå. Detta hanterar i huvudsak hälsan för varje SSD på systemnivå, vilket säkerställer att enheter skrivs till på ett relativt lika sätt. Slutanvändaren behöver inte oroa sig för de individuella enheterna, eftersom systemet kommer att hantera slitaget. Faktum är att X-IO inte ens exponerar enheterna genom deras GUI; användarna hanterar bara volymer som skurits ur den tillgängliga poolen.

X-IO är en av få i all flash-arrayområdet som erbjuder QoS. Inom ISE Manager kan administratörer specificera minimum, maximum och burst IOPS-kapacitet för varje LUN. Processen är några klick och reglerna tillämpas automatiskt. Detta gör att affärskritiska volymer har garanterad prestanda utan att behöva oroa sig för en bullrig granne. Dessutom stöder ISE 800-serien tunn provisionering och integration med VMware VASA, vSphere Web Client, vCOPs och OpenStack via Cinder-drivrutinen.

Den här recensionen fokuserar på ISE 860 G3, med en begränsad delmängd av data som också samlas in med 820 DataPacs i samma chassi. ISE 800 Series G3 alla flash-arrayer skickas nu, med ett listpris på $124,900 820 för ISE 320,500, $850 575,000 för ISE 860 och $XNUMX XNUMX för ISE XNUMX.

Specifikationer för X-IO Technologies ISE 800 Series G3

- Kapacitet

- ISE 820 G3

- Före RAID: 6.4TB (20x200GB SSD per DataPac)

- RAID 10 Kapacitet: 2.7TB

- RAID 5 Kapacitet: 4.3TB

- ISE 850 G3 (10×1.6TB SSD per DataPac)

- Före RAID: 25.6TB

- RAID 10 Kapacitet: 11.4TB

- RAID 5 Kapacitet: 18.3TB

- ISE 860 G3 (20×1.6TB SSD per DataPac)

- â € <Före RAID: 51.2TB

- RAID 10 Kapacitet: 22.9TB

- RAID 5 Kapacitet: 36.6TB

- ISE 820 G3

- 2.2 GHz, 6-kärnig Intel-processor, 16 GB DRAM per kontroller

- Prestanda vid full kapacitet

- Upp till 400,000 XNUMX IOPS

- Upp till 5 GB/s bandbredd

- ISE intelligenta cachningsalgoritmer kommer att optimera I/O-storlekar mellan 512B och 1MB

- Värd-anslutning

- 8 Gb Fiber Channel – 8 SFP-portar (stöder både SAN och DAS-anslutning)

- 1 GbE Management Port med Wake-on-LAN

- Funktioner

- Active-Active Synchronous Mirroring

- Tunt tillhandahållande

- QoS

- ReST Web Services API

- Effekt

- 600 watt typiskt, 700W max

- Spänning 100-240 VAC, 47-63 Hz

- Ström 6.6A vid 110V, 3.6A vid 208V

- Värmeavledning (max) 2400BTU/h

- Fysiska statistik

- 5.2" (13.2 cm) Höjd x 17.5" (44.45 cm) Bredd x 28.5" (72.8 cm) Djup

- 72 pund (32.9 kg) utan DataPacs

X-IO Technologies ISE 860 G3 Design och konstruktion

Liksom de tidigare versionerna av ISE, framhävs designen av de dubbla frontladdade DataPacs som sätts in och sedan låses på plats när enheten slås på. Alla modeller i 800-serien använder samma chassi och kontroller; differentiatorn är helt enkelt kapaciteten hos DataPacs och SSD:er som finns inuti dem. Framsidan av enheten har också två superkondensatorpaket som är designade för att hålla tillräckligt länge för att spola in-transit-skrivning till icke-flyktig lagring i händelse av ett oväntat strömavbrott. När strömmen återkopplas skrivs denna data till den primära lagringspoolen. SAS-bakplanet i 860 har förbättrats för att bättre dra nytta av IO-kapaciteten i all-flash-konfigurationen.

Baksidan av enheten har redundant strömförsörjning samt de två kontrollerna. Varje handkontroll drivs av en 2.2 GHz, 6-kärnig Intel-processor med 16 GB DRAM ombord. Förutom fyra 8Gb Fibre Channel-portar på varje kontrollenhet finns det även en hanteringsport på 1GbE, konsolport, två USB-platser och en SAS-port.

X-IO Technologies ISE 860 G3 Konfiguration och konfiguration

ISE Manager Suite integreras med Citrix, Linux, Microsoft och VMware för att skapa en miljö som gör administrationen av ISE mycket enkel. Faktum är att X-IO gillar att säga att du inte behöver vara en utbildad lagringsadministratör för att distribuera och hantera en ISE. Vi integrerade ISE Manager Suite med vårt VMware vCenter. Till vänster kan administratörer välja mellan SAN Groups, Performance Adapter och Collect Logs. Genom SAN Groups finns det flera fler flikar inklusive Server View, Storage View, Physical View, ActiveWatch View, Performance View, Logs View, CloudStack och X-Volume.

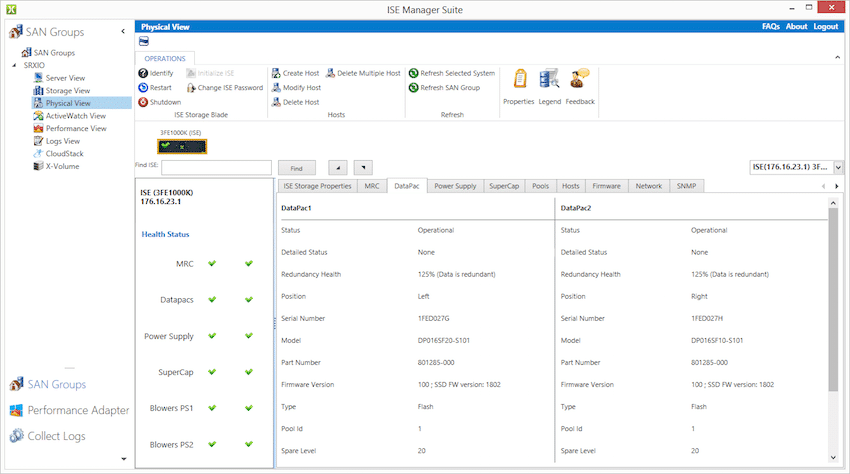

Genom Physical View kan användare kontrollera flera allmänna egenskaper hos arrayen. Att springa ner på vänster sida är en avläsning av systemets hälsa. Användare kan kontrollera DataPacs. De aspekter som kan kontrolleras inkluderar huruvida de är operativa eller inte, vilken position de befinner sig i, deras typ (blixt i detta fall) och vilken pool de tillhör.

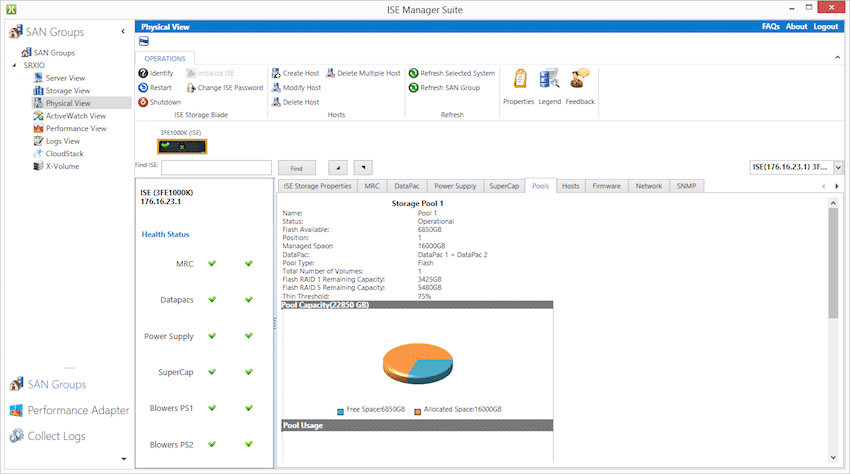

Med Physical View kan man också checka in på lagringspoolen(erna). Visar detaljer som hur mycket blixt som är tillgängligt, vilken DataPac som finns i poolen (båda i det här fallet) och mängden ledig och total kapacitet.

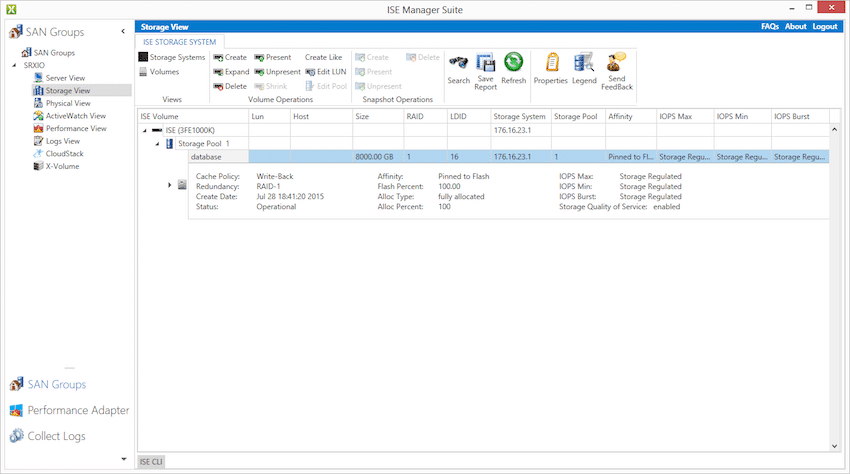

I Storage View kan användare se de olika lagringspoolerna, deras storlek, RAID-konfigurationen, var poolen är fäst och inställningarna för prestandamaximal och minimum.

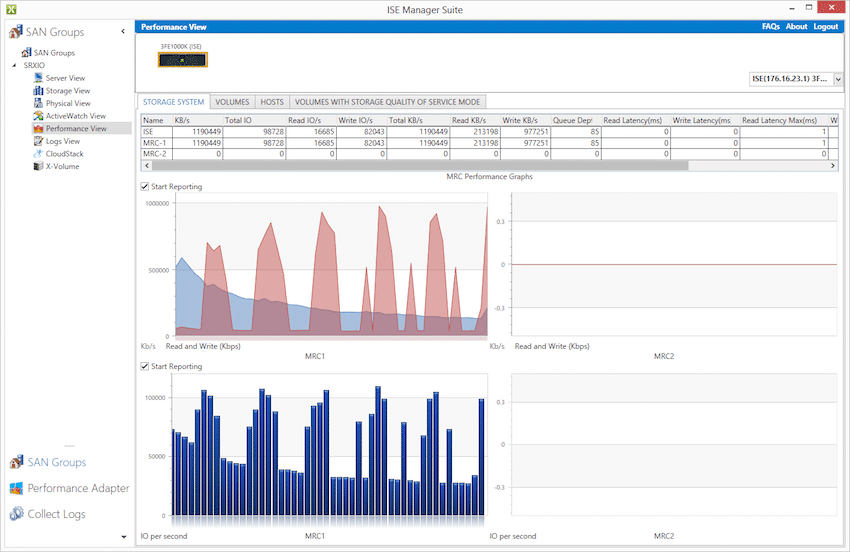

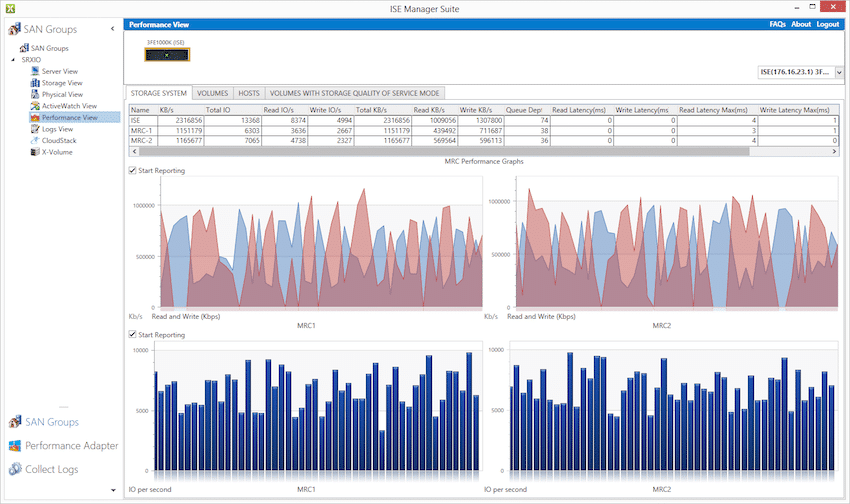

Performance View tillåter administratörer att faktiskt hålla reda på prestanda i realtid. Prestanda kan lätt spåras. Till exempel genomgående mätningar varifrån SQL-arbetsbelastningen börjar kan ses nedan. När data flyttas till värd-DRAM, avsmalnar läsningen, även om stora skrivskurar är synliga för varje loggskrivning.

I början av det virtualiserade Sysbench-testet med 16 virtuella datorer som hamrar på arrayen, kan du se den tunga läs- och skrivmixen träffa båda kontrollerna.

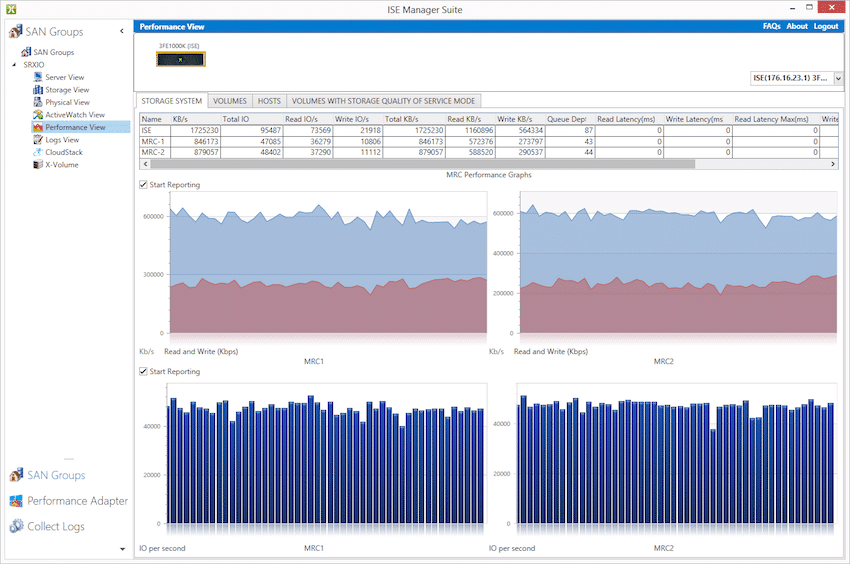

När 16VM Sysbench-testet planar ut kan du se att arrayen når ett stabilt tillstånd.

Applikationsprestandaanalys

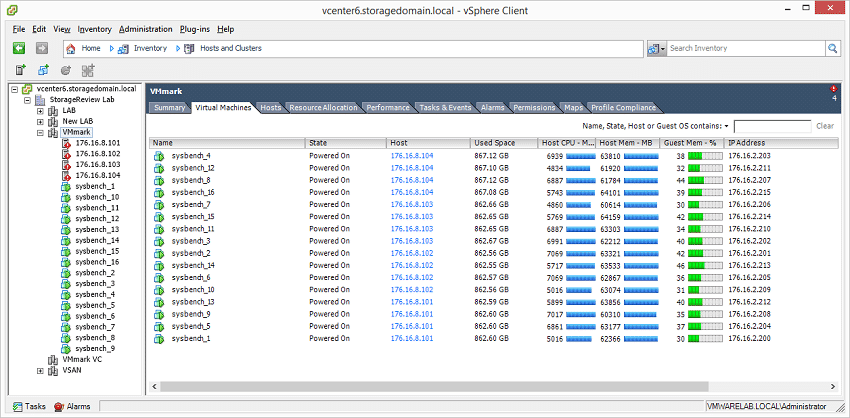

Din Sysbench OLTP benchmark körs ovanpå Percona MySQL som utnyttjar InnoDB-lagringsmotorn som fungerar i en CentOS-installation. För att anpassa våra tester av traditionellt SAN med nyare hyperkonvergerad växel har vi bytt många av våra riktmärken till en större distribuerad modell. Den primära skillnaden är att istället för att köra ett enda riktmärke på en barmetallserver, kör vi nu flera instanser av det riktmärket i en virtualiserad miljö. För det ändamålet distribuerade vi 1, 4, 8, 12 och 16 virtuella Sysbench-datorer på X-IO ISE 860, 1-4 per nod, och mätte den totala prestandan som sågs på klustret med alla i drift samtidigt. Detta test har utformats för att visa hur väl en array hanterar sig själv under normala till extrema arbetsbelastningar. Vid testets topp har vi fullt uppdrag till de fyra ESXi-värdarna som de virtuella datorerna finns på, och kopplar varje värds DRAM-användning.

Dell PowerEdge R730 Virtualized Sysbench 4-nodskluster

- Åtta Intel E5-2690 v3-processorer för 249 GHz i kluster (två per nod, 2.6 GHz, 12-kärnor, 30 MB cache)

- 1 TB RAM (256 GB per nod, 16 GB x 16 DDR4, 128 GB per CPU)

- SD-kortstart (Lexar 16GB)

- 4 x Mellanox ConnectX-3 InfiniBand Adapter (vSwitch för vMotion och VM-nätverk)

- 4 x Emulex 16GB dual-port FC HBA

- 4 x Emulex 10GbE nätverkskort med dubbla portar

- VMware ESXi vSphere 6.0 / Enterprise Plus 8-CPU

Varje Sysbench VM är konfigurerad med tre vDisks, en för start (~92GB), en med den förbyggda databasen (~447GB) och den tredje för databasen som vi ska testa (400GB). Ur ett systemresursperspektiv konfigurerade vi varje virtuell dator med 16 vCPU:er, 64 GB DRAM och utnyttjade LSI Logic SAS SCSI-kontrollern.

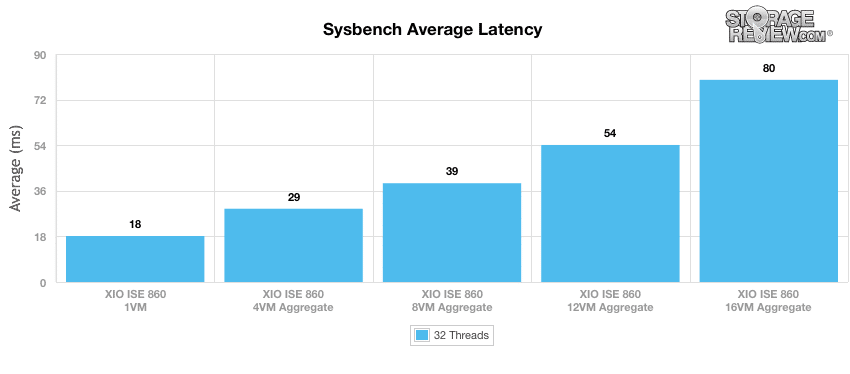

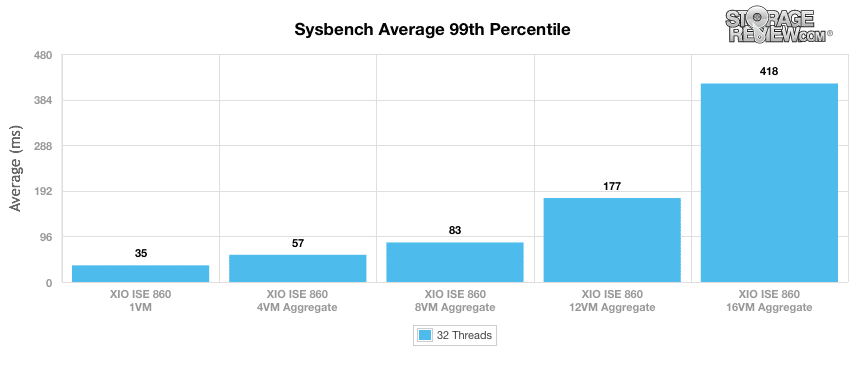

Vårt Sysbench-test mäter genomsnittlig TPS (Transactions Per Second), genomsnittlig latens, såväl som genomsnittlig 99:e percentil latens vid en toppbelastning på 32 trådar.

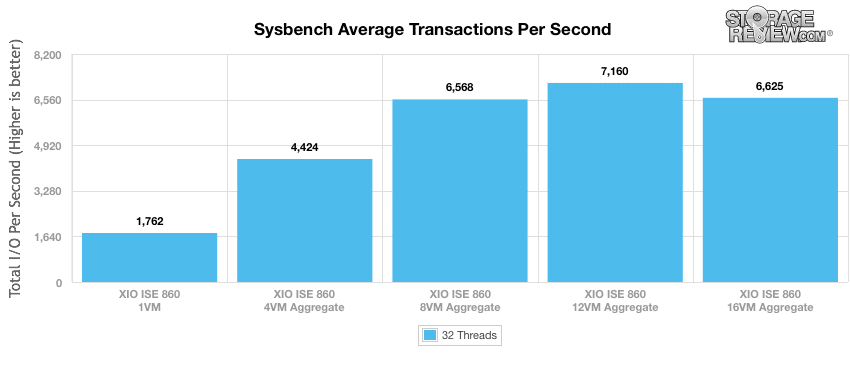

Om man tittar på genomsnittliga transaktioner per sekund publicerade XIO ISE 860 1,762 4 TPS när man använde en virtuell maskin. När vi ökade konfigurationen till 4,424 virtuella datorer såg vi en enorm förbättring av TPS till 150 4, vilket är en ökning med ungefär 8 %. Vi såg också prestandaökningar när vi gick från 38 virtuella datorer till 8 virtuella datorer (12 %) samt 9 virtuella datorer till 16 virtuella datorer (7.4 %). Men när vi ökade till 16 virtuella datorer såg vi en liten minskning av TPS med 860 %. Även när den totala prestandan sjönk till XNUMX virtuella datorer, visade sig X-IO ISE XNUMX vara ett absolut kraftpaket för att upprätthålla den prestandanivån under en otrolig belastning.

I genomsnittlig latens är det uppenbart att ju fler virtuella maskiner som läggs till XIO ISE 860, desto högre inspelad latens. När vi ändrade ISE 860:s 1 VM-konfiguration (18ms) till 4 VMs (29ms), ökade latensen med 61%. Från 4 virtuella datorer till 8 virtuella datorer såg vi en ökning med 34.5 % medan vi noterade en ökning på 38.5 % när vi gick från 8 virtuella datorer till 12 virtuella datorer. Slutligen, när vi använde 16 virtuella datorer, mätte vi en latens på 48 %. Om vi ser tillbaka på vårt ovanstående TPS-diagram, notera att när du använder 12VM, erbjöd den högsta prestanda, medan 16VM började minska TPS samt öka latensen ytterligare.

När det gäller vårt värsta fall av MySQL-latensscenario (99:e percentilens latens) såg XIO SE 860 bara en liten ökning av latensen från 1 virtuella datorer till 4 virtuella datorer och igen från 4 virtuella datorer till 8 virtuella datorer. När vi lade till 12 virtuella datorer såg vi dock en signifikant ökning på 113 % i latens samtidigt som vi registrerade en ännu större ökning när vi gick från 12 virtuella datorer till 16 virtuella datorer (136 %).

StorageReview's Microsoft SQL Server OLTP-testprotokoll använder det aktuella utkastet till Transaction Processing Performance Council's Benchmark C (TPC-C), ett riktmärke för onlinetransaktionsbearbetning som simulerar de aktiviteter som finns i komplexa applikationsmiljöer. TPC-C-riktmärket kommer närmare än syntetiska prestandariktmärken att mäta prestandastyrkorna och flaskhalsarna hos lagringsinfrastruktur i databasmiljöer.

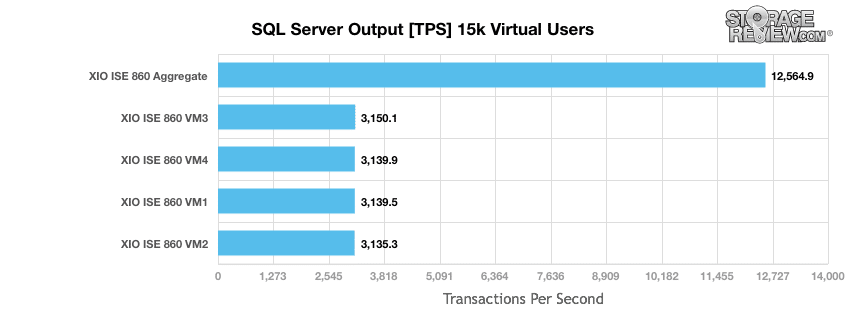

Det här testet använder SQL Server 2014 som körs på Windows Server 2012 R2 gäst-VM, vilket stressas av Dells Benchmark Factory for Databases. Medan vår traditionella användning av detta riktmärke har varit att testa stora 3,000 1,500-skaliga databaser på lokal eller delad lagring, fokuserar vi i denna iteration på att sprida ut fyra 860 4-skaliga databaser jämnt över vår X-IO ISE XNUMX för att bättre illustrera den samlade prestandan inuti ett XNUMX-nods VMware-kluster.

Andra generationens SQL Server OLTP Benchmark Factory LoadGen-utrustning

- Dell PowerEdge R730 VMware ESXi vSphere Virtual Client Hosts (2)

- Fyra Intel E5-2690 v3-processorer för 124 GHz i kluster (två per nod, 2.6 GHz, 12-kärnor, 30 MB cache)

- 512 GB RAM (256 GB per nod, 16 GB x 16 DDR4, 128 GB per CPU)

- SD-kortstart (Lexar 16GB)

- 2 x Mellanox ConnectX-3 InfiniBand Adapter (vSwitch för vMotion och VM-nätverk)

- 2 x Emulex 16GB dual-port FC HBA

- 2 x Emulex 10GbE nätverkskort med dubbla portar

- VMware ESXi vSphere 6.0 / Enterprise Plus 4-CPU

-

Dell PowerEdge R730 Virtualiserat SQL 4-nodskluster

- Åtta Intel E5-2690 v3-processorer för 249 GHz i kluster (två per nod, 2.6 GHz, 12-kärnor, 30 MB cache)

- 1 TB RAM (256 GB per nod, 16 GB x 16 DDR4, 128 GB per CPU)

- SD-kortstart (Lexar 16GB)

- 4 x Mellanox ConnectX-3 InfiniBand Adapter (vSwitch för vMotion och VM-nätverk)

- 4 x Emulex 16GB dual-port FC HBA

- 4 x Emulex 10GbE nätverkskort med dubbla portar

- VMware ESXi vSphere 6.0 / Enterprise Plus 8-CPU

Varje SQL Server VM är konfigurerad med två vDisks, en 100 GB för uppstart och en 500 GB för databasen och loggfilerna. Ur ett systemresursperspektiv konfigurerade vi varje virtuell dator med 16 vCPU:er, 64 GB DRAM och utnyttjade LSI Logic SAS SCSI-kontrollern.

X-IO ISE 860 benchmarkerade i SQL Server-test var verkligen välkvalificerad att hantera 15,000 860 virtuella användare, eftersom XIO ISE 12,564.9 stoltserade med ett sammanlagt genomsnitt på XNUMX XNUMX TPS.

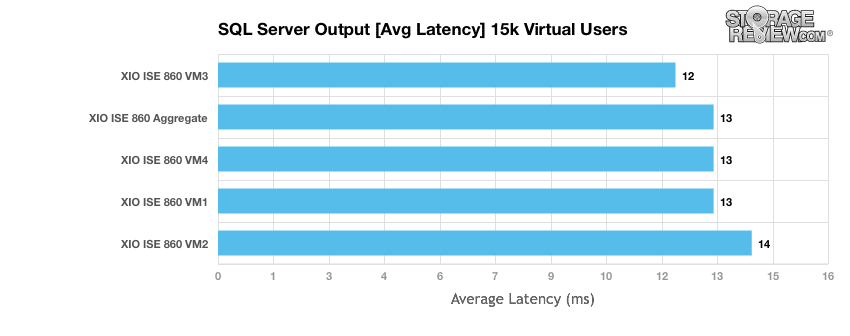

När man tittar på genomsnittlig latens med samma arbetsbelastning för virtuella användare, erbjöd X-IO ISE 860 en total fördröjning på 13 ms i genomsnitt, med en spridning på 12 till 14 ms mellan de 4 virtuella datorerna. Detta är ett annat område där konsistensen av ISE 860 mellan volymer och dess låga latensrespons hjälpte den att uppnå ledande siffror.

Syntetisk arbetsbelastningsanalys för företag

Innan du påbörjar var och en av fio syntetiska riktmärken, vårt labb förbereder systemet till ett stabilt tillstånd under en tung belastning på 16 trådar med en enastående kö på 16 per tråd. Därefter testas lagringen i fastställda intervall med flera gäng-/ködjupsprofiler för att visa prestanda under lätt och tung användning.

- Förkonditionering och primära stationära tester:

- Genomströmning (läs+skriv IOPS aggregerad)

- Genomsnittlig fördröjning (läs+skrivfördröjning i medeltal)

- Max fördröjning (maximal läs- eller skrivfördröjning)

- Latens standardavvikelse (läs+skriv standardavvikelse i genomsnitt)

Denna syntetiska analys innehåller två profiler som används i stor utsträckning i tillverkarens specifikationer och riktmärken:

- 4k – 100% Läs och 100% Skriv

- 8k – 70% Läs/30% Skriv

Tredje generationens FIO LoadGen

- HP ProLiant DL380 Gen9

- Dubbla Intel E5-2667 v3-processorer (3.2 GHz, 8-kärnor, 20 MB cache)

- 256 GB RAM (16 GB x 16 DDR4, 128 GB per CPU)

- Windows Server 2012 R2

- 400 GB Boot SSD

- 2 x Emulex 16GB dual-port FC HBA

- Brocade 6510 48-portars 16Gb Switch

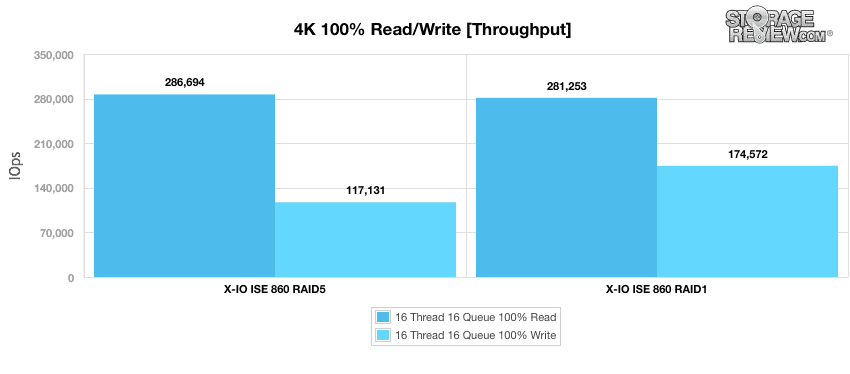

Vårt första riktmärke mäter prestandan för slumpmässiga 4k-överföringar som består av 100 % skriv- och 100 % läsaktivitet. I genomströmning registrerade X-IO ISE 860 286,694 117,131 IOPS-läsningar och 5 1 skrivningar med en RAID281,253-konfiguration. I RAID174,572 mätte den XNUMX XNUMX IOPS-läsningar med bättre skrivningar vid XNUMX XNUMX IOPS.

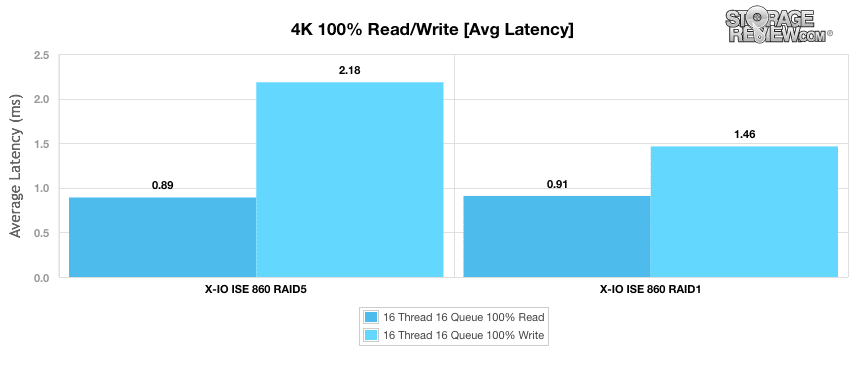

X-IO ISE 860 upplevde en genomsnittlig läslatens på bara 0.89 ms och en skrivlatens på 2.18 ms i RAID5 medan RAID1 stoltserade med 0.91 ms läsning och visade överlägsen skrivlatens igen med 1.46 ms.

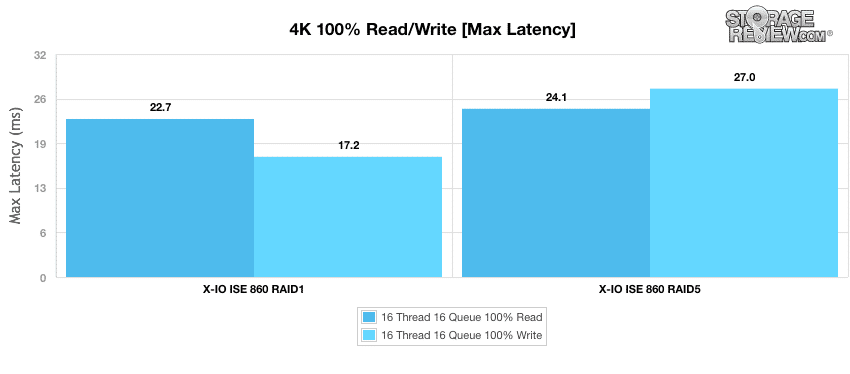

När vi flyttade till våra tester för maximal latens gav X-IO ISE 860 i RAID1 22.7 ms läsning och 17.2 ms skrivning medan RAID5-konfigurationen mätte 24.1 ms läsning och 27.0 ms skrivning.

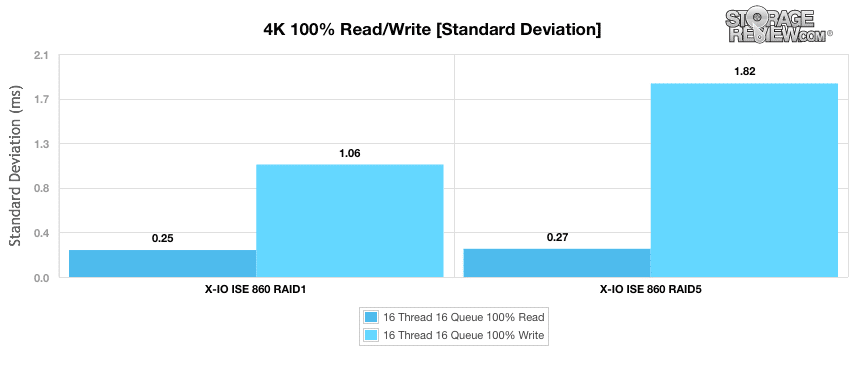

I vårt standardavvikelsetest fortsatte RAID1-konfigurationen sina fantastiska resultat, med endast 0.25 ms läsning och 1.06 ms skrivning. Även om RAID5-konfigurationen visade liknande läsningar, hade den en mycket högre latens i skrivningar (1.82 ms).

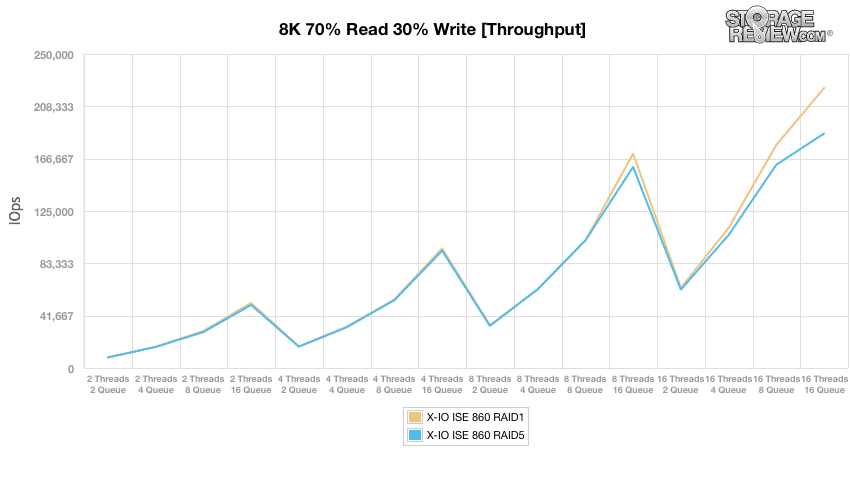

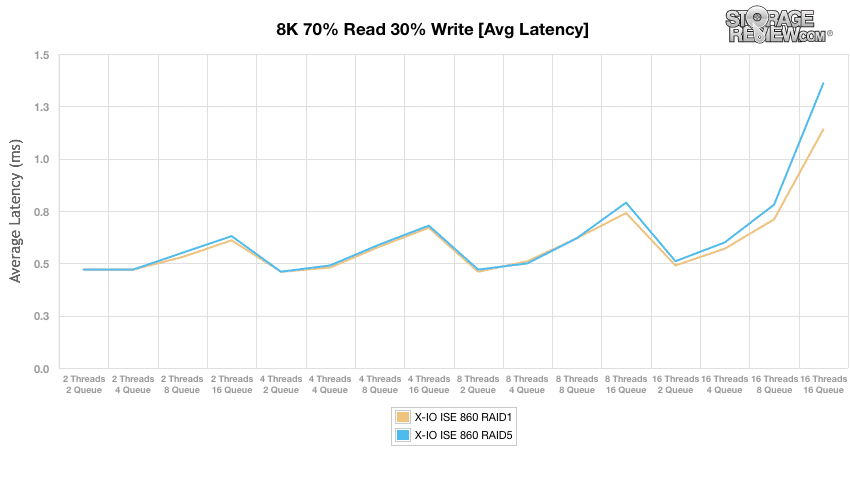

Om du flyttar till 8k 70% läs 30% slumpmässig arbetsbelastning, visar båda X-IO ISE 860-konfigurationerna praktiskt taget identiska resultat i våra trådar. RAID5-konfigurationen började blekna bort först vid 16T/8Q där den slutade med ungefär 185,000 1 IOPS. RAID230,000 visade en terminal genomgående på cirka XNUMX XNUMX IOPS.

Att titta på genomsnittlig latens berättade en liknande historia, eftersom både RAID1 och RAID5 visade liknande resultat igen, bara för att dela isär runt 8T16Q. I terminaldjupen visade RAID5 ungefär 1.4 ms i genomsnittlig latens, medan RAID1 mätte 1.2 ms.

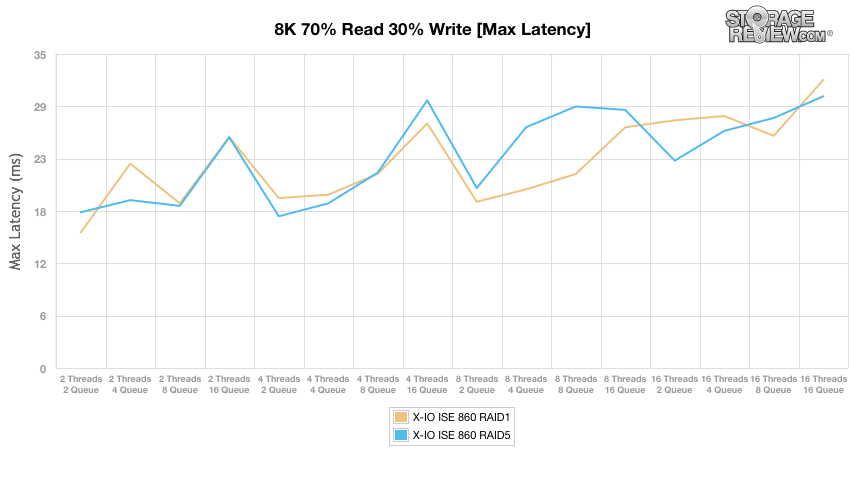

Resultaten var mycket mindre lika när man tittade på topp latensprestanda. Här startade RAID1 på en initial 16ms vid 2T2Q medan den nådde 32ms i terminalen. X-IO ISE 860 i RAID5 mätte 18ms vid 2T2Q och 30ms vid 16T16Q.

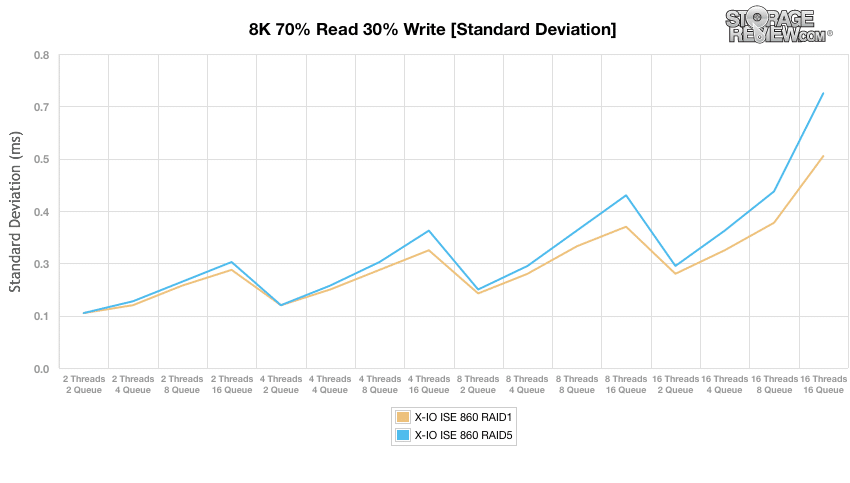

Som visas nedan var våra standardavvikelseresultat mycket lika våra genomsnittliga latensdiagram. Båda RAID-konfigurationerna startade vid 0.1 ms medan de gradvis separerades med 4T4Q-märket. I terminaltrådarna nådde RAID5-konfigurationen 0.73 ms medan RAID1 nådde 0.51 ms.

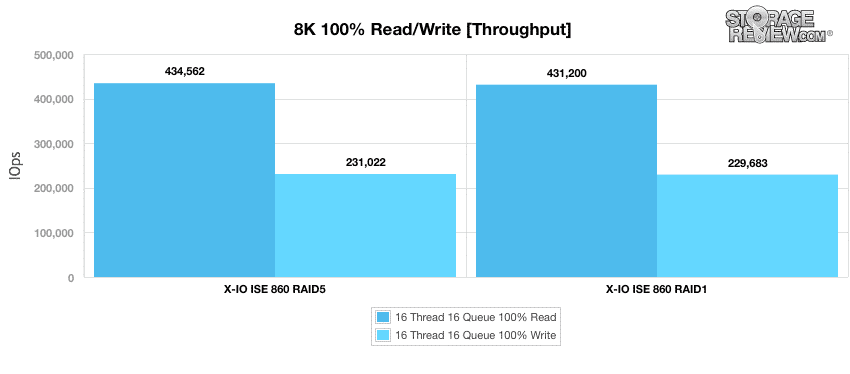

Vår nästa arbetsbelastning skiftar till ett 8K-test med små block i följd. I det här scenariot hade ISE 860 i RAID5 en liten försprång i både läs- och skrivprestanda, och mätte 434,562 231,022 IOPS-läsning och 1 431,200 IOPS-skrivning, jämfört med RAID229,683 som mätte 860 XNUMX IOPS-läsning och XNUMX XNUMX IOPS-skrivning. När det gäller maximal I/O-potential gjorde ISE XNUMX ingen besviken.

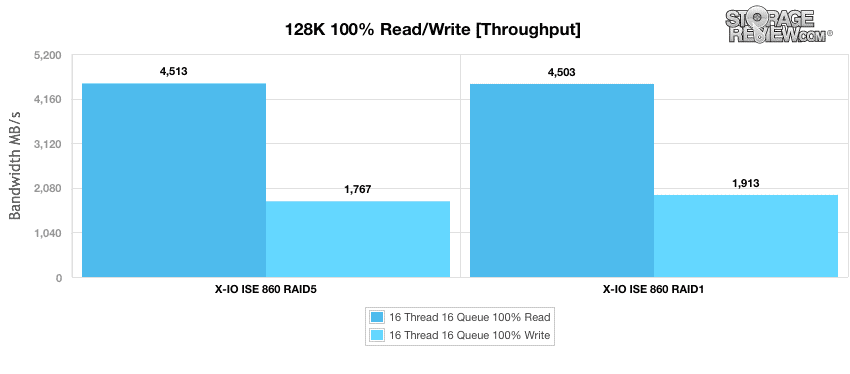

Vår sista arbetsbelastning är ett sekventiellt test med 128K stora block. I det här scenariot hade båda RAID-konfigurationerna liknande resultat: RAID5 visade 4,513 1,767 MB läsning och 1 4,503 MB/s skrivning medan RAID1,913 publicerade läsning och skrivning på 4.5 XNUMX MB/s respektive XNUMX XNUMX MB/s. Även om sekventiell prestanda inte har någon stor roll i en tung virtualiserad värld där du till slut ser mycket randomiserad trafik, var det ändå trevligt att se att arrayen hade lite muskler att trycka ut uppåt XNUMX GB/s ut. Sekventiell skrivprestanda för stora block var en aning låg, men med tanke på hur bra den presterade i våra applikationstester, kommer detta inte att påverka mycket i verkliga förhållanden.

Del 1 Sista tankar

I del 2 av recensionen kommer vi att undersöka flera andra prestationsområden. Av vad vi har sett hittills finns det gott om anledning att vara optimistisk med resten av testerna, som kommer att inkludera sådana som VMmark, DataFusion i minnesdatabasen och OpenLDAP-databastester. Tyvärr har vi lite att direkt jämföra ISE 860 med. Gen2-testmetoden och labbryggraden (Dell-servrar) som vi har implementerat för testning visar bara frukterna av framgången, med ISE 860 som det första SAN som gör det som en recension. Men när vi tittar tillbaka på liknande resultat och extrapolerar några, säger vi att XIO ISE-plattformen är redo att spela på huvudscenen med andra tungviktare, som tävlar på en mycket hög nivå om affärskritiska arbetsbelastningar. Del 2 kommer att avslöja ännu mer när vi pressar systemet till dess gränser igen genom att träna över 20 brickor i VMmark. Håll ögonen öppna för nästa avsnitt.

Kommer upp: X-IO Technologies ISE 860 G3 recension: del 2

Anmäl dig till StorageReviews nyhetsbrev