AWS、Google 和 Azure 等云计算巨头正在构建定制芯片以满足 AI 需求,提高性能、效率和控制力。

云环境目前正在经历重大转型。过去一年,包括亚马逊网络服务 (AWS)、谷歌云和微软 Azure 在内的超大规模云服务提供商大幅增加了对定制芯片的投资。进入芯片市场的人工智能公司数量也在持续增长。

芯片开发的蓬勃发展正在重塑数据中心,有望将性能、效率和差异化提升到新的高度。传统的芯片制造商为大众打造处理器和加速器,而这些新兴厂商则专注于为高要求的AI工作负载设计芯片。

芯片设计

开发定制芯片的动机源于现成的CPU和加速器无法满足超大规模云工作负载的需求。尤其是人工智能和机器学习,它们推动着更高的计算密度、更低的延迟和更高的能效要求。超大规模企业通过构建根据其基础设施和客户需求定制的芯片来应对这一挑战。越来越多的新参与者进入市场,他们推出的处理器和加速器被吹捧为业内“最快”、“最便宜”或“最好”的产品。

当然,这并不是什么新鲜事。云服务提供商多年来一直在构建定制的网络硬件、存储设备和服务器。然而,设计处理器却又是另一回事。

玩家是谁?

这份名单并非完整。目前,这些是该领域的主要参与者。我们也纳入了新的供应商,他们为以人工智能为中心的服务交付带来了独特的特色。

AWS

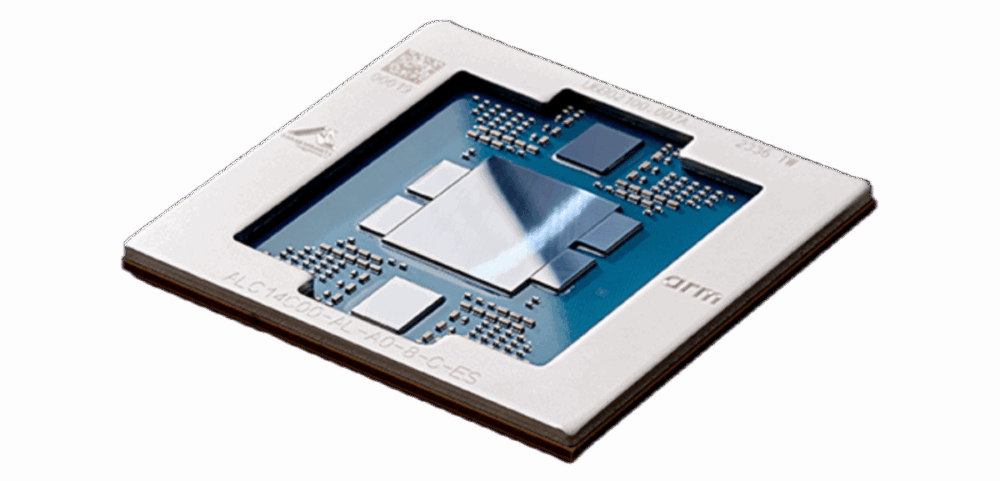

现在已经是第四代了, 亚马逊的 Graviton 系列为云端 Arm CPU 奠定了基础,与传统 x86 产品相比,其每瓦性能显著提升。AWS 还推出了定制 AI 加速器,例如 Inferentia和Trainium,针对大规模推理和训练工作负载。

据 AWS 网站称,Anthropic 表示 AWS 将成为其主要训练合作伙伴,并使用 AWS Trainium 来训练和部署其最大的基础模型。据称,亚马逊还将向 Anthropic 额外投资 4 亿美元。

与此同时,谷歌继续突破其张量处理单元 (TPU) 的极限,目前这些 TPU 正在为一些规模最大的 AI 模型提供动力。该公司最新的 TPU v5 和 铁力木 架构专为大规模并行而设计,并与 Google 的数据中心结构紧密集成。

Azure

微软也紧随其后,最近推出了定制的 AI 芯片, Azure Maia 和 Azure Cobalt针对人工智能和通用工作负载进行了优化。这些芯片目前已部署在微软的数据中心,支持从大型语言模型到核心云服务的所有内容。

CSP 并非孤例

虽然不一定是云提供商,但芯片开发市场中也存在其他参与者。这些公司也意识到了设计芯片的优势:更低的成本、更佳的性能、更佳的管理和所有权。

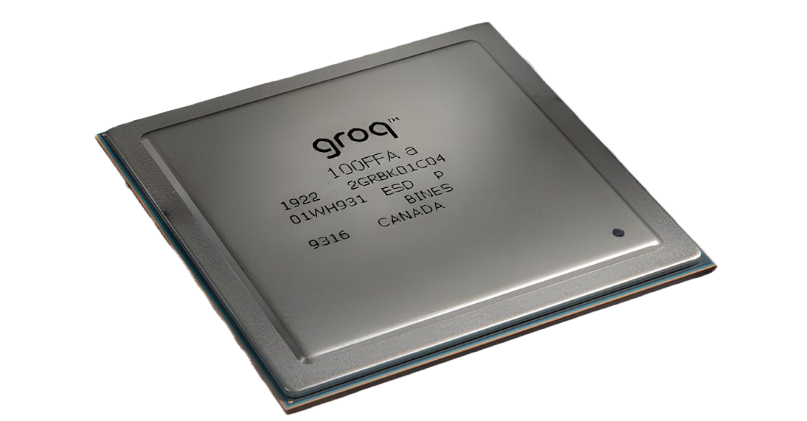

格罗克

Groq 提供了一个以定制为中心的 AI 推理平台 语言处理单元 (LPU) 以及云基础设施。它为流行的人工智能模型提供低成本的高性能。

与专为图形设计的 GPU 不同,LPU 针对 AI 推理和语言任务进行了优化。Groq 通过 GroqCloud™ 和本地解决方案(而非单独的芯片)提供 LPU。

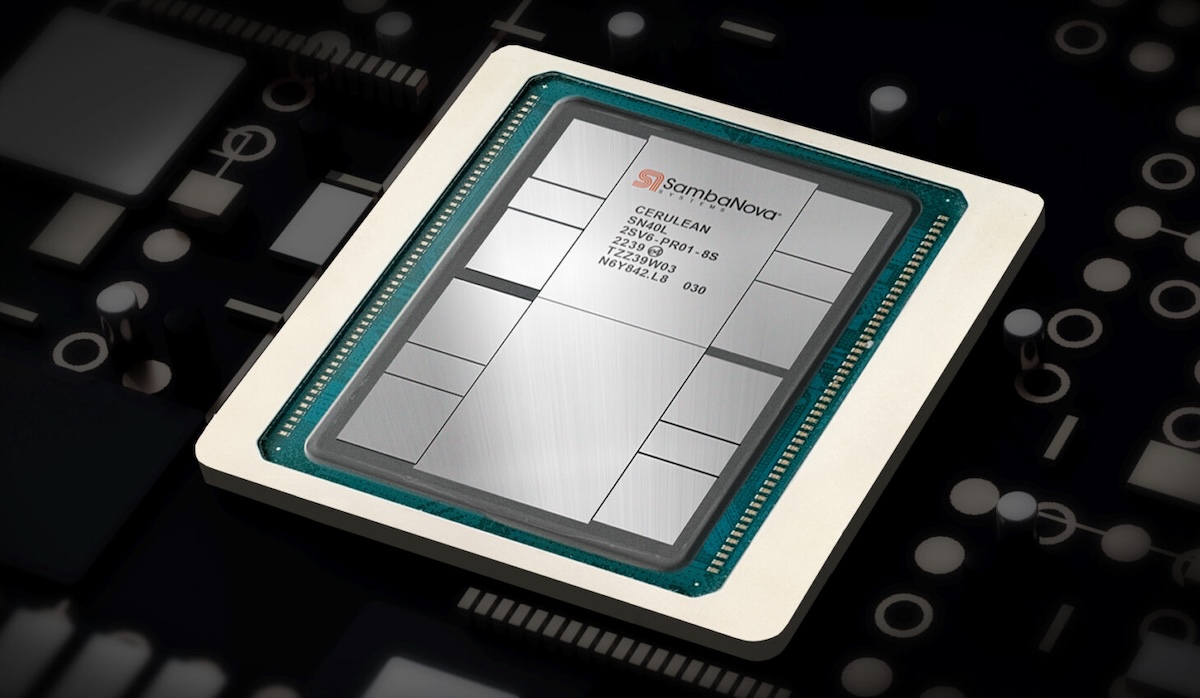

SambaNova系统

SambaNova系统 打造了专为复杂工作负载量身定制的 AI 平台。该平台以 DataScale® 系统和针对数据流计算优化的定制可重构数据流单元 (RDU) 芯片为核心。

该公司提供预先训练的基础模型和 SambaNova Suite,它结合了硬件、软件和模型,可实现快速的人工智能部署,特别是在金融和医疗保健领域。

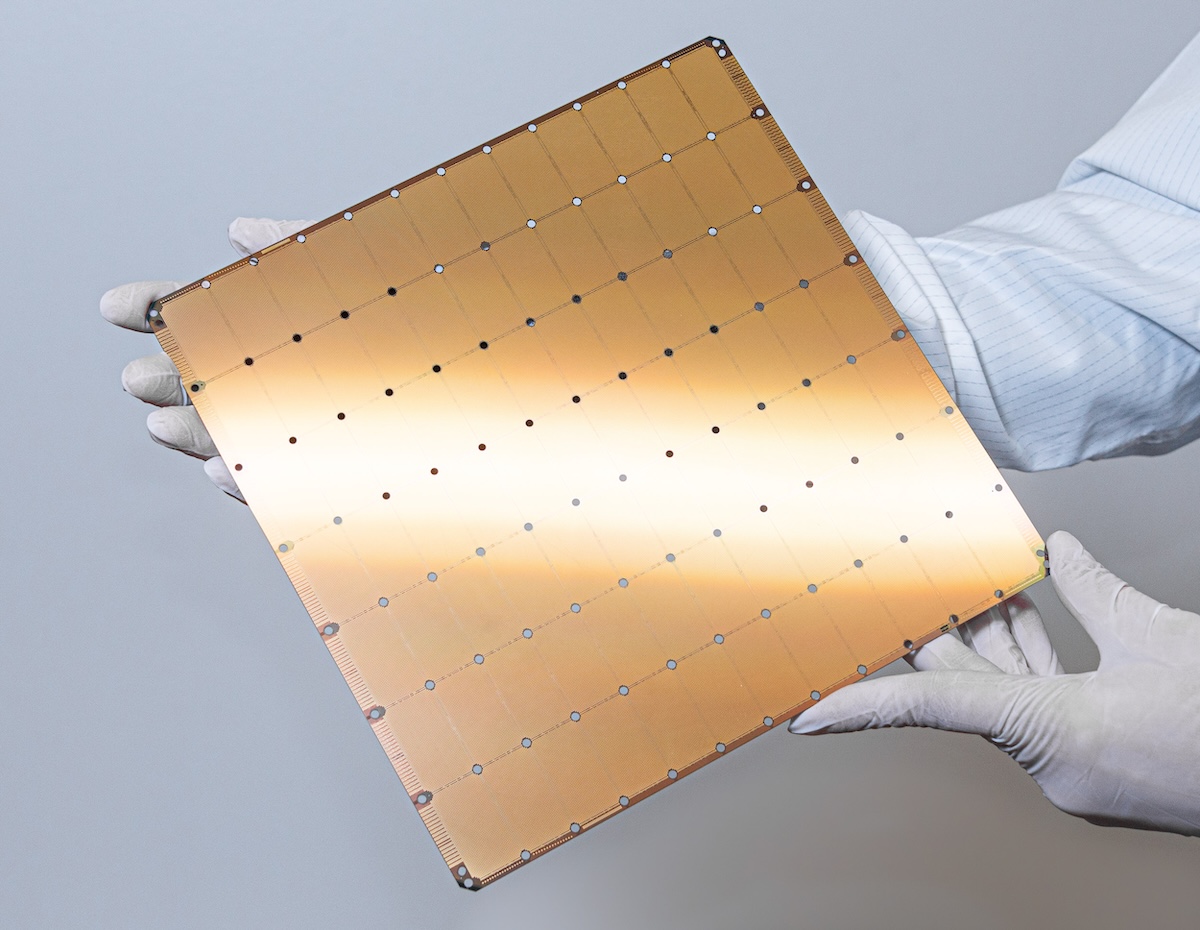

大脑

Cerebras 以其 AI 推理和训练平台而闻名,该平台的特点是 晶圆级引擎 (WSE)凭借其众多针对 AI 优化的内核和片上内存,这款大型芯片使 Cerebras 系统能够处理传统硬件难以应对的复杂模型。

医学研究和能源领域的组织将 Cerebras 系统用于内部超级计算机,而开发人员可以通过 Cerebras Cloud 访问其功能。

张量

张量 该公司正在开发先进的人工智能和高性能计算硬件,由一支专注于计算机架构和 ASIC 设计的团队领导。他们的策略类似于谷歌的 TPU,专注于开放的硬件和软件,并吸引了杰夫·贝佐斯等大佬的投资。

该公司的 Blackhole™ PCIe 板卡专为可扩展的 AI 处理而设计,配备 RISC-V 内核和 GDDR6 内存。Blackhole p100a 型号搭载 Blackhole Tensix 处理器,专为桌面工作站打造。

优势:性能、效率和控制

定制硅片为通信服务提供商 (CSP) 和其他参与者提供了强大的杠杆。供应商可以通过自主设计芯片来优化其工作负载、数据中心架构以及电源/冷却约束。这可以提高单位成本性能、提升能源效率,并能够为客户提供差异化服务。从战略上讲,拥有硅片堆栈可以减少对第三方供应商的依赖,降低供应链风险,并加快创新周期。在人工智能模型飞速发展的时代,这种敏捷性是一种竞争优势。

芯片制造并非易事。它需要深厚的工程专业知识、大量的资本投入,以及与代工厂和设计合作伙伴的密切合作。通信服务提供商 (CSP) 也在软件堆栈、编译器和开发工具方面投入巨资,以确保其定制硬件易于访问且易于使用。整个行业都感受到了这种连锁反应。英特尔、AMD 和 NVIDIA 等传统芯片制造商面临着新的竞争,而初创公司和 IP 供应商则找到了与 CSP 合作的新机会。随着供应商寻求更灵活、更可定制的架构,以 RISC-V 为代表的开源硬件运动正在蓬勃发展。

云硅的未来

创新速度丝毫没有放缓的迹象。随着人工智能、分析和边缘计算的发展,预计通信服务提供商和超大规模企业将投资大量定制芯片,同时进军新的网络、存储和安全领域。下一代云基础设施将不仅由其内部硬件构成,也由其顶层软件和服务构成。

这一进步提供了更多选择、更佳性能,以及处理企业和开发者此前认为不可能完成的工作负载的能力。对于业界而言,这标志着一个新时代的开始,最大的云服务提供商也将成为最具影响力的芯片设计者之一。

参与 StorageReview

电子报 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | TikTok | RSS订阅