WEKA 用於 AI 推理的增強記憶體可提高 GPU 效率、降低延遲和成本,同時擴展 AI 模型以適應企業工作負載。

WEKA 宣布與 NVIDIA AI 資料平台參考設計實現策略整合。它獲得了關鍵的 NVIDIA 儲存認證,以提供專門針對代理 AI 和複雜推理模型量身定制的最佳化基礎架構。除了此次發布之外,WEKA 還推出了其創新的增強記憶體網格功能和其他 NVIDIA 雲端合作夥伴 (NCP) 參考架構認證,其中包括 NVIDIA GB200 NVL72 和用於企業級 AI 工廠部署的 NVIDIA 認證系統儲存。

加速人工智慧代理

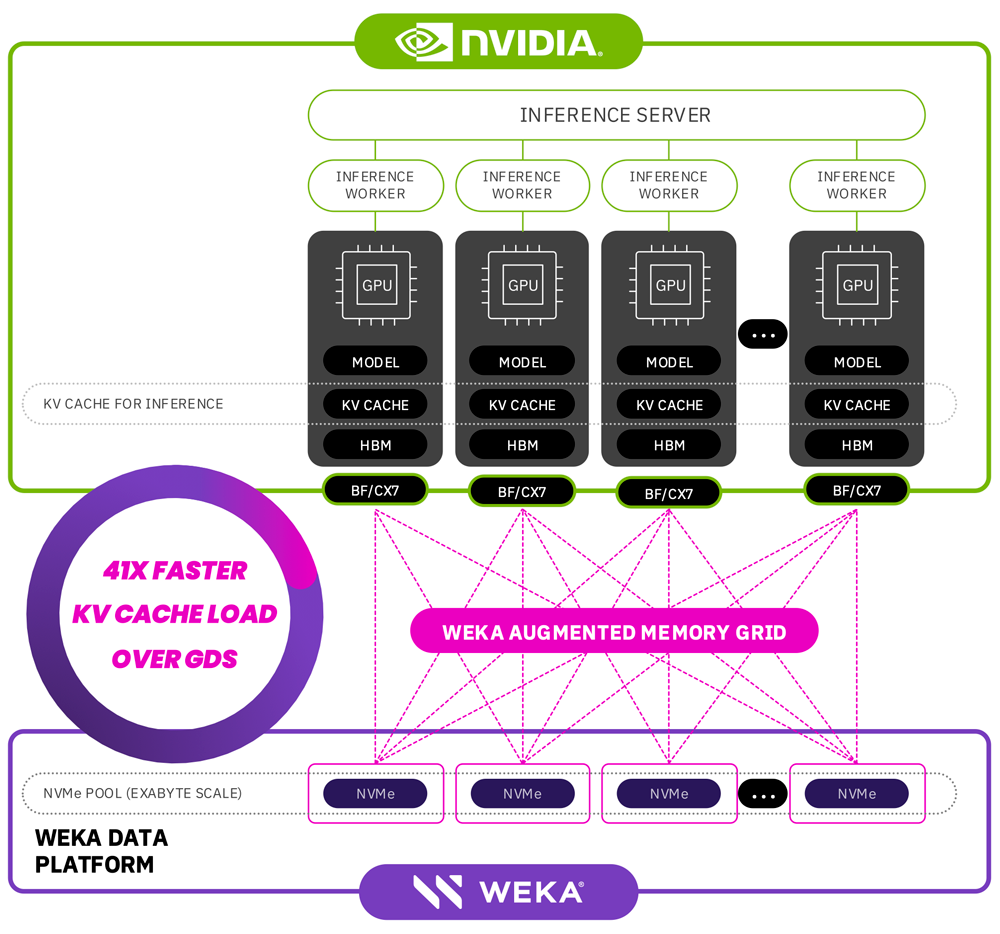

NVIDIA AI 資料平台代表了企業 AI 基礎架構的重大飛躍,無縫整合了 NVIDIA Blackwell 架構、NVIDIA BlueField DPU、Spectrum-X 網路和 NVIDIA AI Enterprise 軟體。透過將這種先進的 NVIDIA 基礎架構與 WEKA 資料平台結合,企業可以部署專為高效能 AI 推理工作負載設計的可大規模擴展的儲存基礎。

此整合解決方案直接滿足了企業 AI 日益增長的需求,為 AI 查詢代理提供了對關鍵商業智慧的無縫、加速訪問,從而顯著提高了推理性能和推理準確性。 WEKA 的資料平台確保人工智慧系統能夠快速將資料轉化為可操作的情報,從而支援下一代人工智慧模型所需的複雜推理。

WEKA 增強記憶網格

Agentic AI 模型不斷發展,可以管理更大的上下文視窗、擴展的參數數量和更大的記憶體需求。這些進步往往會突破傳統 GPU 記憶體容量的極限,從而造成 AI 推理的瓶頸。 WEKA 透過其突破性的增強內存網格解決方案解決了這些挑戰,這項創新擴展了 AI 工作負載的可用內存,提供了 PB 級增量——遠遠超出了當前單 TB 的限制。

WEKA 的增強記憶體網格透過將 WEKA 的資料平台軟體與 NVIDIA 的加速運算和網路技術相結合,顯著增強了 AI 推理能力。這種組合可以實現接近記憶體速度的訪問,延遲僅為微秒級,從而顯著提高了令牌處理性能和整體 AI 推理效率。

WEKA 增強記憶體網格的主要優點包括:

-

大幅減少延遲:在涉及 105,000 個令牌的測試中,與傳統的重新計算方法相比,WEKA 的增強記憶體網格在第一個令牌的時間方面實現了顯著的 41 倍改進。

-

優化令牌吞吐量:WEKA 的解決方案能夠有效處理跨叢集的推理工作負載,以更低的整體成本實現更高的令牌吞吐量,從而將系統範圍內每個令牌的處理成本降低高達 24%。

這些效能提升直接轉化為經濟效率的提高,使企業能夠在不損害模型能力或基礎設施效能的情況下加速人工智慧驅動的創新。

WEKApod Nitro

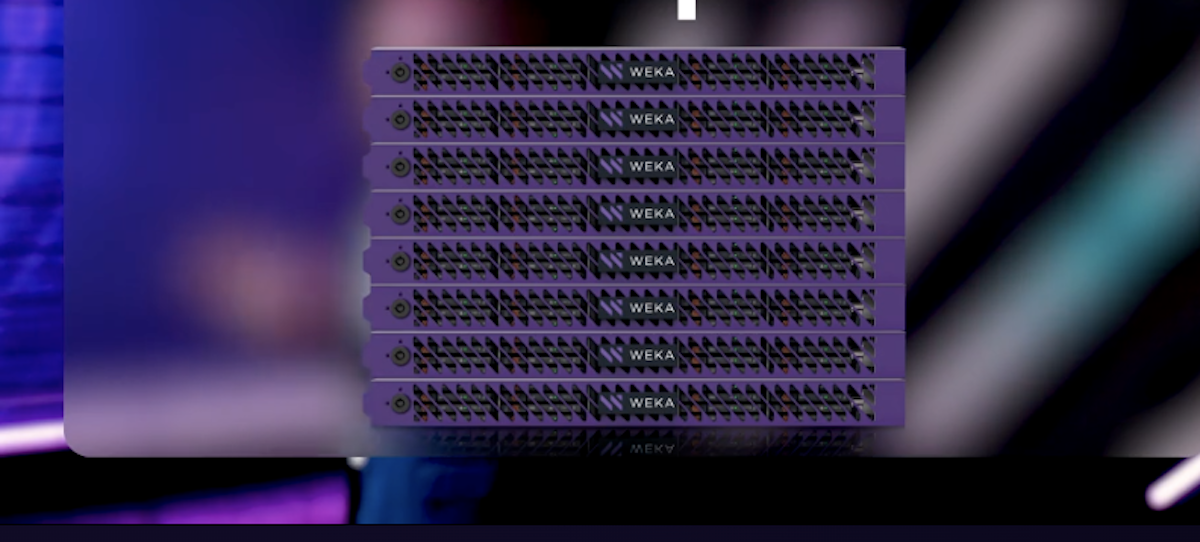

WEKApod Nitro 資料平台設備已獲得多項 NVIDIA 認證,使 WEKA 成為企業 AI 領先的高效能儲存供應商:

-

NVIDIA 雲端合作夥伴 (NCP) 認證:WEKApod Nitro 是首批獲得 NVIDIA NCP 參考架構認證的儲存解決方案之一,包括 HGX H200、B200 和 GB200 NVL72。這些設備支援大規模 GPU 叢集(1,152U 配置中最多可達 8 個 GPU),同時保持卓越的效能密度和電源效率,為服務供應商和開發人員提供支援。

-

NVIDIA 認證系統儲存指定:WEKApod Nitro 設備已獲得 NVIDIA 的新企業儲存認證,確保與 NVIDIA 企業參考架構和最佳實務相容。此項稱號證明 WEKA 資料平台能夠為要求嚴格的企業 AI 和 HPC 部署提供最佳的儲存效能、效率和可擴充性。

WEKA 首席產品長 Nilesh Patel 強調了與 NVIDIA 合作的變革潛力。 Patel 將這一進展與航空航天領域的突破進行了比較,他表示:「就像突破音障開闢了新領域一樣,WEKA 的增強內存網格打破了人工智能內存障礙,大大擴展了 GPU 內存並優化了代幣效率。這項創新從根本上改變了人工智能代幣經濟學,在不犧牲性能的情況下實現了更快的創新和更低的成本。」

NVIDIA 儲存網路技術副總裁 Rob Davis 進一步強調了這種整合的重要性:“部署代理 AI 和推理模型的企業需要前所未有的效率和可擴展性。結合 NVIDIA 和 WEKA 技術可確保 AI 代理在推理過程中以無與倫比的速度和準確性訪問和處理數據。”

庫存情況

- WEKA 針對 NVIDIA Blackwell 系統的 NCP 參考架構將於三月上市。

- WEKA 增強記憶體網格功能將於 2025 年春季向 WEKA 資料平台客戶全面開放。

參與 StorageReview

電子報 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | 的TikTok | RSS訂閱