NVIDIA는 새로운 버전의 TensorRT 추론 소프트웨어, TensorRT를 Google의 TensorFlow 프레임워크에 통합하고 음성 인식 소프트웨어인 Kaldi가 이제 GPU에 최적화되었음을 포함하여 수많은 새로운 기술과 파트너십을 발표했습니다.

VIDIA의 TensorRT4 소프트웨어는 정확한 INT8 및 FP16 네트워크 실행을 통해 다양한 애플리케이션에서 딥 러닝 추론을 가속화하여 데이터 센터 비용을 최대 70%까지 절감할 수 있음을 나타냅니다. TensorRT4는 또한 하이퍼스케일 데이터 센터, 임베디드 및 자동차 GPU 플랫폼에서 훈련된 신경망을 신속하게 최적화, 검증 및 배포하는 데 사용할 수 있습니다. NVIDIA는 또한 새로운 소프트웨어가 일반 애플리케이션용 CPU와 비교할 때 딥 러닝 추론에서 190배 이상 빠른 속도를 자랑한다고 주장합니다. 또한 NVIDIA와 Google 엔지니어는 TensorRT를 TensorFlow 1.7에 통합하여 GPU에서 딥 러닝 추론 애플리케이션을 더 쉽게 실행할 수 있도록 했습니다.

NVIDIA는 GPU에서 실행되는 더 빠른 성능을 달성하도록 Kaldi를 최적화했습니다. 이를 통해 소비자에게는 더 정확하고 유용한 가상 비서가 제공되고 데이터 센터 운영자에게는 배포 비용이 절감됩니다.

추가 파트너십 발표는 다음과 같습니다.

- Windows 10 응용 프로그램에 대한 AI 지원 - NVIDIA는 GPU 가속 도구를 구축하기 위해 IT 거대 기업과 협력하여 개발자가 Windows 응용 프로그램에 보다 지능적인 기능을 통합합니다.

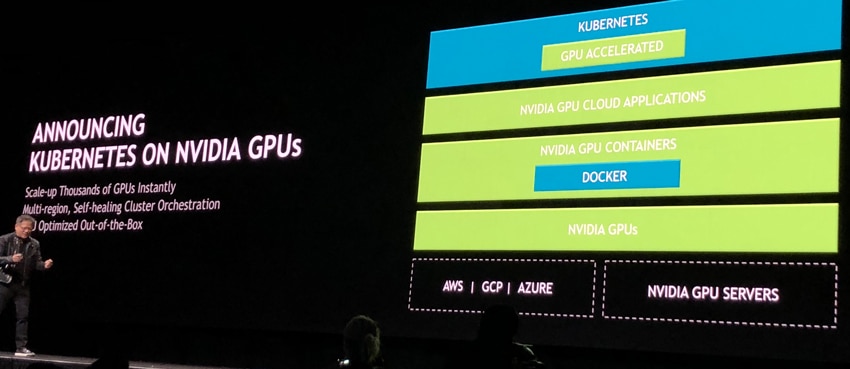

- 다중 클라우드 GPU 클러스터에서 엔터프라이즈 추론 배포를 용이하게 하는 Kubernetes용 GPU 가속.

- MathWorks는 오늘 주력 소프트웨어인 MATLAB과 TensorRT의 통합을 발표했습니다. NVIDIA는 엔지니어와 과학자가 이제 Jetson, NVIDIA Drive 및 Tesla 플랫폼용 MATLAB에서 고성능 추론 엔진을 자동으로 생성할 수 있음을 나타냅니다.

다음으로 NVIDIA는 TensorRT가 NVIDIA DRIVE 자율 주행 차량 및 NVIDIA Jetson 임베디드 플랫폼에 배포될 수 있는 반면 심층 신경망은 모든 프레임워크의 데이터 센터에 있는 NVIDIA DGX 시스템에서 훈련된 다음 실시간 추론을 위해 모든 유형의 기술에 배포될 수 있다고 지정합니다. 가장자리.

TensorRT를 사용하면 개발자가 추론 배포를 위한 성능 조정 대신 새로운 딥 러닝 기반 개발에 집중할 수 있습니다. NVIDIA는 개발자가 TensorRT를 활용하여 INTS 또는 FP16 정밀도를 통해 매우 빠른 추론을 제공할 수 있다고 덧붙입니다. 이렇게 하면 대기 시간이 줄어들어 임베디드 및 자동차 플랫폼에서 객체 감지 및 경로 계획과 같은 기능이 향상됩니다.