Arista Networks 宣布了一项突破性的技术演示,旨在创建 AI 数据中心,将计算和网络域整合到单个托管 AI 实体中。

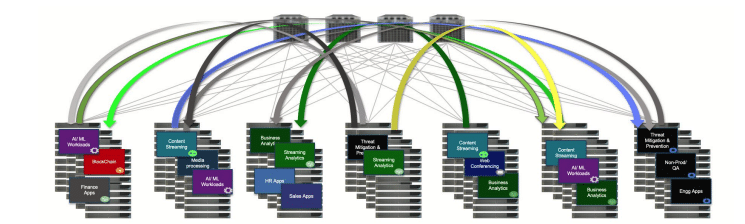

Arista Networks 宣布了一项突破性的技术演示,旨在创建 AI 数据中心,将计算和网络域整合到单个托管 AI 实体中。该计划与 NVIDIA 合作开展,旨在构建最佳的生成式 AI 网络,允许客户跨关键组件(包括网络、NIC 和服务器)统一配置、管理和监控 AI 集群,从而缩短作业完成时间。

AI集群统一管理

随着人工智能集群和大型语言模型(LLM)的不断扩展,所涉及组件的复杂性和数量也显着增加。这些组件包括 GPU、NIC、交换机、光学器件和电缆,它们必须协同工作才能形成一个全面的网络。统一控制确保托管 NIC 和 GPU 的 AI 服务器与各层的 AI 网络交换机保持同步。如果没有这种对齐,就会存在配置错误或不一致的风险,特别是在 NIC 和网络交换机之间,这可能会由于难以诊断的网络问题而严重影响作业的完成。

协调拥塞管理

大型 AI 集群需要同步拥塞管理,以防止数据包丢失和 GPU 利用率不足。协调、同步的管理和监控对于优化计算和网络资源也是必要的。 Arista 解决方案的核心是基于 EOS 的代理,可实现网络和主机之间的通信,协调配置以优化 AI 集群。

用于增强控制的远程 AI 代理

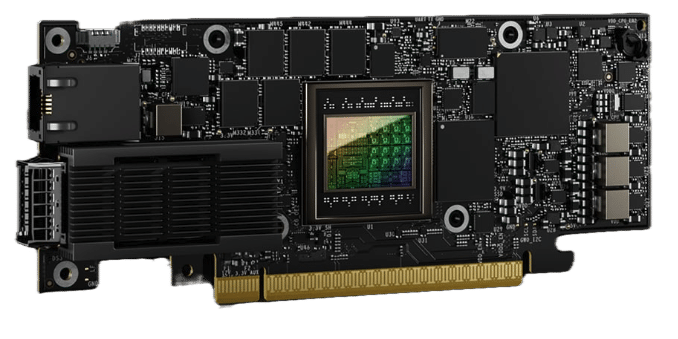

在 Arista 交换机上运行的 Arista EOS 可以通过远程 AI 代理扩展到直接连接的 NIC 和服务器。这允许跨人工智能数据中心进行单点控制和可见性,从而创建统一的解决方案。远程 AI 代理托管在 NVIDIA BlueField-3 SuperNIC 上或在服务器上运行并从 SuperNIC 收集遥测数据,允许网络交换机上的 EOS 配置、监控和调试服务器上的网络问题。这确保了端到端网络配置和服务质量 (QoS) 的一致性,使人工智能集群能够作为一个有凝聚力的解决方案进行管理和优化。

Arista Networks 首席平台官 John McCool 表示:“Arista 旨在提高已发现网络和 GPU 拓扑之间的通信效率,通过协调编排、配置、验证和监控 NVIDIA 加速计算、NVIDIA SuperNIC,缩短作业完成时间,以及 Arista 网络基础设施。”

这项新技术强调了基于 Arista EOS 的远程 AI 代理如何允许将集成的 AI 集群作为单一解决方案进行管理。通过远程 AI 代理将 EOS 功能扩展到服务器和 SuperNIC,Arista 可确保持续跟踪和报告主机和网络之间的性能问题或故障,从而实现快速隔离并将影响降至最低。基于 EOS 的网络交换机保持对准确网络拓扑的持续感知,并通过远程 AI 代理将 EOS 扩展到 SuperNIC 和服务器,增强了 AI 数据中心所有元素的端到端 QoS 的协调优化,最终缩短了作业完成时间。

Arista Networks 的下一步

Arista Networks 将于 10 月 5 日在纽约证券交易所举行的 Arista IPO 2024 周年庆典上展示 AI 代理技术,预计将于 XNUMX 年下半年开始客户试用。此次演示代表着朝着实现多供应商、可互操作的目标迈出了重要一步。生态系统,可实现人工智能网络和人工智能计算基础设施之间的无缝控制和协调,满足人工智能和法学硕士工作负载不断增长的需求。

参与 StorageReview

电子报 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | TikTok | RSS订阅