在被 NVIDIA 收购之前,Mellanox 正在研发的一款鲜为人知的产品是名为 BlueField 的数据处理单元 (DPU)。 六年前的推销与今天的推销类似,让存储(现在是加速器)直接访问网络,而无需传统的 x86 架构。 毕竟,CPU 比 PCIe 交通通道管理更适合用于应用程序。 然而,BlueField 的采用非常缓慢; 如今,很少有商业企业利用 DPU。 NVIDIA 有新的推动力来帮助改变这种状况。

在被 NVIDIA 收购之前,Mellanox 正在研发的一款鲜为人知的产品是名为 BlueField 的数据处理单元 (DPU)。 六年前的推销与今天的推销类似,让存储(现在是加速器)直接访问网络,而无需传统的 x86 架构。 毕竟,CPU 比 PCIe 交通通道管理更适合用于应用程序。 然而,BlueField 的采用非常缓慢; 如今,很少有商业企业利用 DPU。 NVIDIA 有新的推动力来帮助改变这种状况。

为什么首先使用 DPU?

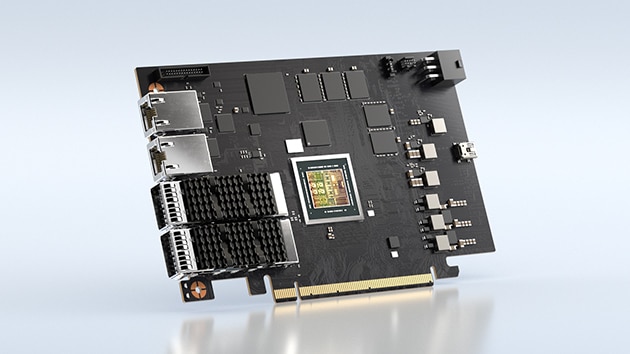

DPU 的魅力非常迷人,这就是 NVIDIA 为其成功投入巨资的原因。 与广为人知和喜爱的更传统的高速以太网 NIC 相比,DPU 只是具有更多的处理能力,使它们看起来更像是微型计算机,而不是数据移动车辆。 不过,公平地说,在存储环境中,DPU 的主要目标是快速移动数据。 只是现在,这个动作可以在 JBOF 中完成,根本不需要 x86。

VAST 数据节点中的 NVIDIA DPU

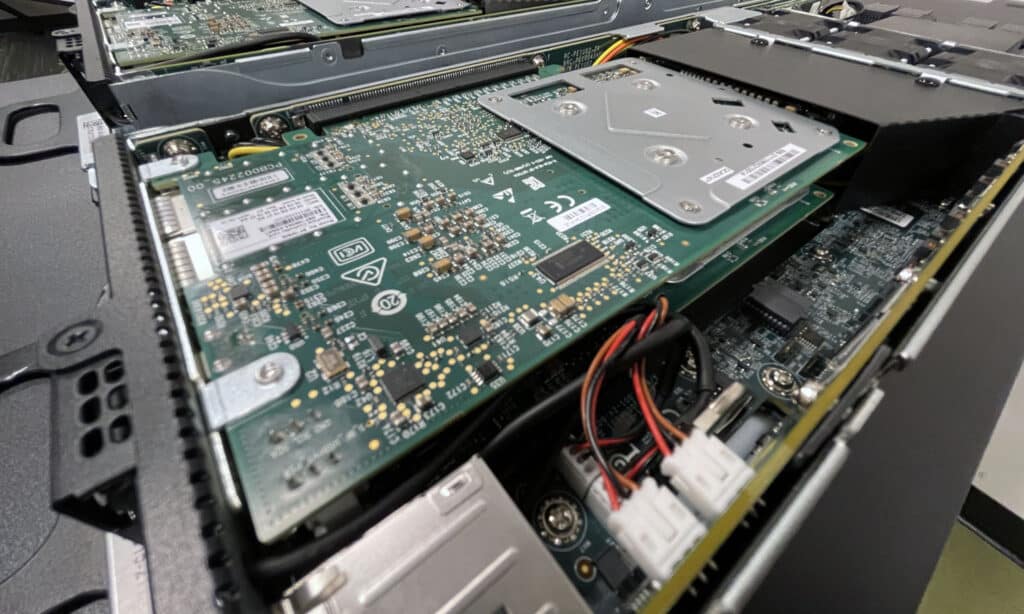

我们最近在一些案例中看到了这种情况,一个使用 NVIDIA 产品,另一个使用他们自己的 DPU。 VAST Data 正在利用 数据节点中的 NVIDIA DPU,现在是极其密集的 1U 盒子,可以共享 675TB 的原始闪存。 不过,还有其他路线; Fungible 有一个分解计划,利用它自己的 DPU。 我们有他们的 实验室中的存储阵列,他们最近还宣布了一项 GPU 努力.

可替代存储阵列——内置 DPU

如果所有这些 DPU 对话听起来都让人不知所措,那也很难怪你。 在很长一段时间内,数据的管理和移动方式都没有发生根本性的转变。 我们有一个 在 DPU 上与 NVIDIA 播客 从存储的角度来看,这是了解市场动态的入门读物。

DPU 很难

即使在六年或更长时间的工作之后,我们也只看到两个 DPU 实际运行良好的例子,并且可以说出的公司可能还不到少数甚至涉足实验室验证。 这是为什么? 从系统供应商告诉我们的情况来看,利用 BlueField 确实很困难。 有大量的软件工作要做,而且迄今为止,这些卡不是简单的即插即用产品,因此需要的重量要大得多。 再加上传统存储公司不愿意采用前沿技术以及每个 DPU 都需要不同的编码方法这一事实,我们几乎没有采用 DPU。

NVIDIA 当然认识到这一点,并且迫切需要更快的车辆将数据移动到他们的 GPU 中。 公平地说,客户也希望如此,尤其是在保持昂贵的 GPU 投资全时运行是一个价格目标的 HPC 工作负载中。 因此,NVIDIA 昨天已经努力帮助缓解这种采用痛苦。

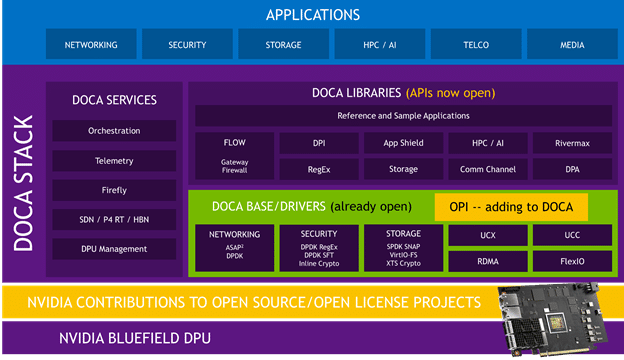

NVIDIA 已成为 Linux 基金会开放可编程基础设施 (OPI) 项目的创始成员。 从根本上说,NVIDIA 已广泛提供其 DOCA 网络软件 API。 这意味着在 DPU 上运行的繁重集成工作现在应该会更快。

“OPI 项目旨在创建一个社区驱动的、基于标准的开放生态系统,以使用 DPU 加速网络和其他数据中心基础设施任务,” 博客文章 来自英伟达。 这当然是一件好事。 以前发现 DPU 墙太高而无法跨越的组织和系统供应商现在应该可以更轻松地采用 DPU。

NVIDIA 继续分享他们打算提供的内容;

DPU 的下一步是什么?

根据我们从 VAST 和 Fungible 中看到的情况,DPU 世界非常真实,随时准备对数据中心和云产生巨大影响。 采用一直具有挑战性,因为软件集成很困难。 此外,该硬件并不是 NIC 的直接替代品。 并不是说它被定位成那样,但这不像通过交换 NIC 从 25GbE 到 200GbE。 集成 DPU 的工作绝非微不足道。

英伟达 DPU

像这样的举措应该有助于行业发展,即使只是在 NVIDIA 芯片上。 在使基础架构更快、更安全并最终更高效方面,DPU 提供了巨大的潜力。 几乎每个大型组织都致力于绿色计划,因此数据中心是开始采用与传统堆栈没有相同依赖关系的现代基础设施的好地方。

我们希望这种向开源的转变能够摆脱 DPU 的僵局,因为这项技术的可能性非常显着。

参与 StorageReview

电子报 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | Facebook | TikTok | RSS订阅